英特尔推出AI参考套件,推动构建AI触手可及的未来

最新动态:得益于英特尔与埃森哲的长期合作,英特尔现推出了一套共计34个的开源AI参考套件,帮助开发者和数据科学家更快、更轻松地部署人工智能(AI)。每个套件均包含面向AI优化的模型代码、训练数据、机器学习流水线、库以及oneAPI组件,让企业可以在采用不同架构的本地、云端和边缘环境下灵活应用。

“英特尔AI参考套件为数百万开发者和数据科学家在健康和生命科学、金融服务、制造业、零售业等诸多领域开发和扩展AI应用,提供了简便、高效且经济实惠的方式。英特尔致力于通过广泛的产品组合——基于AI加速的处理器和系统,加以对开放AI软件生态的投入,推动构建一个让AI触手可及的未来。该参考套件采用了英特尔AI软件产品组合的丰富组件并基于开放、基于标准的oneAPI多架构编程模型所打造。”

——李炜博士,英特尔副总裁兼人工智能和分析部门总经理

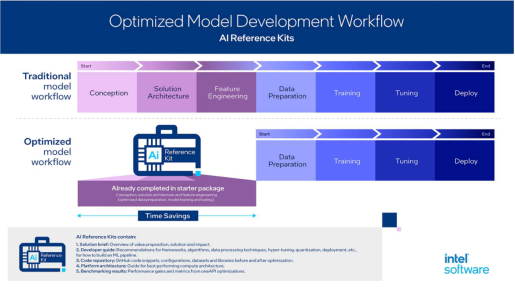

重要意义:英特尔AI参考套件采用oneAPI开放的、基于标准的异构编程模型和英特尔端到端的AI软件产品组合的组件共同构建,其中包括英特尔®AI分析工具包和英特尔®发行版OpenVINO™工具套件,让AI开发者能够简化运用AI编写应用程序的流程,增强现行智能解决方案并加速部署。结果证明,相较于传统的模型开发流程,英特尔AI参考套件带来了显著的性能提升,同时让工作流程更为省时且高效。

预配置的套件简化了横跨消费品、能源和公用事业、金融服务、健康和生命科学、制造业、零售业和电信业等行业的AI开发。其惠及各行各业的部分示例如下:

●使用专为企业对话式AI聊天机器人交互设置而设计的AI参考套件,用户可以通过oneAPI优化,在批处理模式下将推理速度提升高达45%。1

● 专为生命科学领域的视觉质量控制检测自动化而设计的AI参考套件,在经过oneAPI优化后,视觉缺陷检测的训练速度提升高达20%,推理速度提升高达55%。2

● 对于用于开发者预测公用事业资产的健康状况并提高服务可靠性的AI参考套件,能将预测准确度提升高达25%。3

AI参考套件可以将解决方案的时间从数周缩短到数天,帮助数据科学家和开发者以更快的速度和更低的成本进行模型训练,克服专有环境的限制。在oneAPI驱动下,AI工具和优化能够更大限度地提高开放式加速计算应用的可移植性。

埃森哲董事总经理John Giubileo表示:“与英特尔合作为开源社区开发AI参考套件,促使我们客户能够以更高效地方式运行AI工作负载。这些基于oneAPI构建的套件旨在为开发者提供便捷和高效的AI解决方案,从而降低项目复杂性,缩短其在各行各业的部署时间。”

未来展望:英特尔将基于社区反馈和贡献,持续更新参考套件。包括视觉质量检测、企业对话式AI聊天机器人设置、预测资产健康分析、医学成像诊断、文档自动化、以及AI结构化数据生成等。

参考资料:

1 https://github.com/oneapi-src/customer-chatbot

2 https://github.com/oneapi-src/visual-quality-inspection

3 https://github.com/oneapi-src/predictive-asset-health-analytics

注意事项和免责声明:

性能会因用途、配置和其他因素而异。更多信息请参见www.Intel.com/PerformanceIndex。结果可能会有所不同。

性能结果基于所示配置的测试日期,可能不反映所有公开可用的更新。

英特尔不控制或审计第三方数据。您可以参考其他来源以评估准确性。

来源:业界供稿

好文章,需要你的鼓励

如何终结针对IT部门的指责游戏

超过二十年前,记者尼古拉斯·卡尔在《哈佛商业评论》中提出IT是商品化服务,缺乏竞争优势,这一争议再次成为焦点。当前由AI和自动化推动的技术变革中,许多企业领导者将技术决策推给IT部门,然后对结果不满。问题的核心在于组织未能构建让技术成功的环境。企业需要三个转变:将基础IT服务视为公用设施,在传统IT外构建数字和AI能力,让业务领导者对技术成果负责。

剑桥大学突破性研究:如何让AI在对话中学会真正的自信判断

剑桥大学研究团队首次系统探索AI在多轮对话中的信心判断问题。研究发现当前AI系统在评估自己答案可靠性方面存在严重缺陷,容易被对话长度而非信息质量误导。团队提出P(SUFFICIENT)等新方法,但整体问题仍待解决。该研究为AI在医疗、法律等关键领域的安全应用提供重要指导,强调了开发更可信AI系统的紧迫性。

Windchill + Makersite,让可持续性从“理念”变为“行动”

企业不仅能精准掌握碳足迹,更能在运营中产生可量化的商业价值,真正将可持续性从“理念”变为“行动”。

威斯康星大学研究团队破解洪水监测难题:AI模型终于学会了“眼观六路“

威斯康星大学研究团队开发出Prithvi-CAFE洪水监测系统,通过"双视觉协作"机制解决了AI地理基础模型在洪水识别上的局限性。该系统巧妙融合全局理解和局部细节能力,在国际标准数据集上创造最佳成绩,参数效率提升93%,为全球洪水预警和防灾减灾提供了更准确可靠的技术方案。

Vibe Bot推出桌面AI智能体设备

Razer推出桌面AI动漫全息投影智能助手

Cloudera:构建符合伦理标准的AI,可信数据是关键

Nvidia发布Vera Rubin AI计算平台,性能大幅提升

7种削弱IT业务价值的致命做法

PTC在NRF 2026大会上发布AI驱动的FlexPLM新功能

如何终结针对IT部门的指责游戏

Windchill + Makersite,让可持续性从“理念”变为“行动”

Linux基金会领导者:我们并未处在AI泡沫中

全新软件与模型优化为 NVIDIA DGX Spark 注入强大动力

NVIDIA DGX Spark 为桌面端最新开源与前沿AI模型提供强大算力支持

AI流量激增为何现在就需要光网络自动化