【重磅】OpenAI通用人工智能(AGI)的计划被揭露

今天凌晨一篇名为《揭示OpenAI计划在2027年前实现通用人工智能(AGI)的计划》的google文档开始在网络上传播,这篇文档一共54页,是来自推特Jackson (@vancouver1717),他搜集了目前网络上所有的公开资料来推论AGI已经实现,真是太刺激了,可以结合前几天马斯克告Openai违约,要求其公布进行中的AGI计划这个新闻,还有去年Ilya公开反对全体的董事会成员,开掉了CEO奥特曼,大家一直想知道Ilya究竟看到了什么?openai的AGI真的已经实现了么?我们可以一起来看看这篇揭露文档。

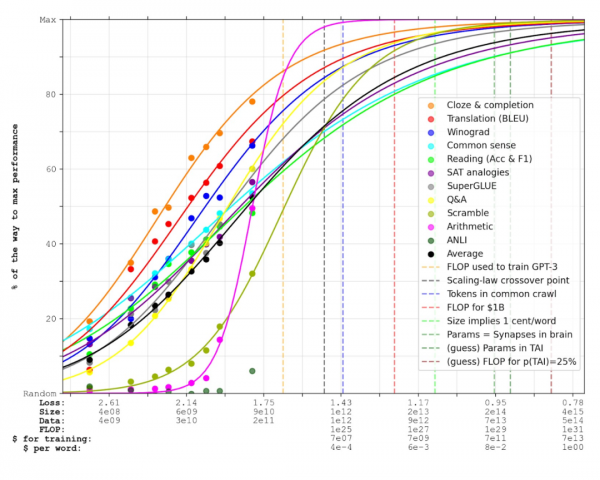

正如Lanrian所展示的,外推预测显示,AI性能似乎在与人类大脑大小相匹配的参数数量达到人类水平的同时,莫名其妙地达到了人类水平。他对大脑中突触数量的计数大约是200万亿参数,而不是通常引用的100万亿这个数字,但这个观点仍然成立,而且在100万亿参数时的性能非常接近最佳。

顺便提一下——值得注意的一个重要事项是,尽管100万亿在性能上略有不足,但OpenAI正在使用一种工程技术来弥补这个差距。我会在文档的最后部分解释这一点,因为它对OpenAI正在构建的东西至关重要。

Lanrian的帖子是网上许多类似帖子之一——它是基于前几个模型之间的跳跃来外推性能的。OpenAI当然有更详细的指标,他们得出的结论与Lanrian相同,我将在本文档后面展示。

那么,如果AI性能可以根据参数数量来预测,而且大约100万亿参数足以达到人类水平的性能,那么何时会发布一个100万亿参数的AI模型呢?

GPT-5在2023年底达到了48的智商,实现了初级通用人工智能。

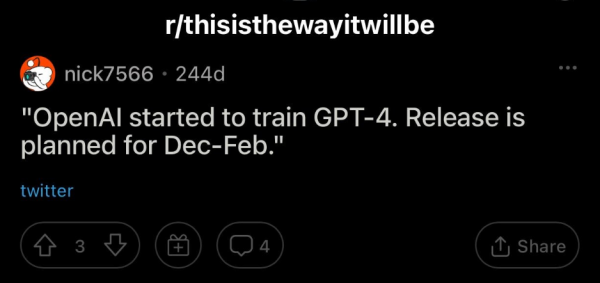

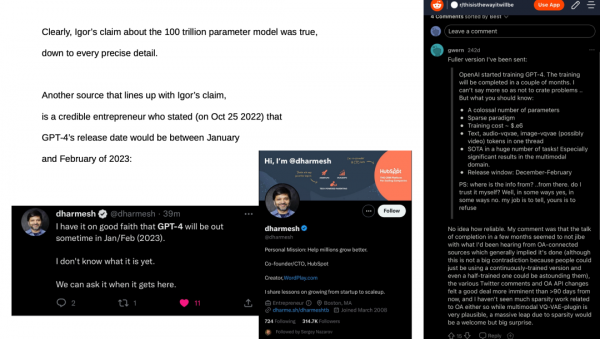

AI研究员伊戈尔·拜科夫(Igor Baikov)仅几周后声称,GPT-4正在训练中,并将在12月至2月间发布。再次强调,我将证明伊戈尔确实拥有准确的信息,并且是一个可信的信息源。这一点很快就会变得重要。

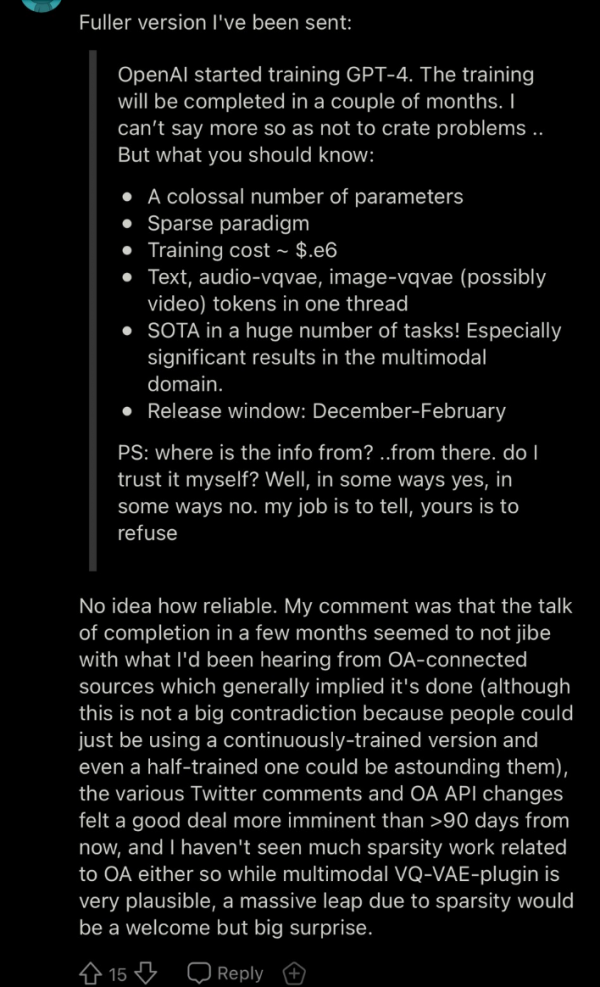

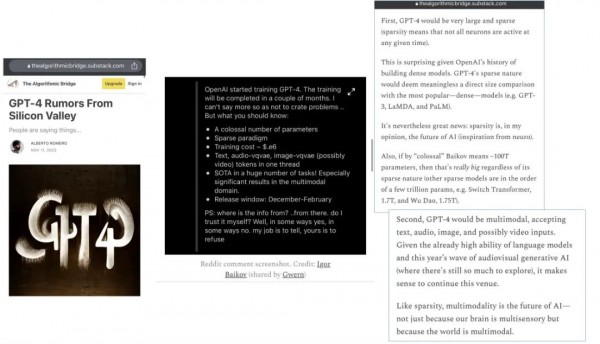

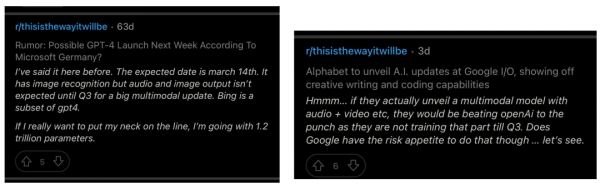

Gwern是AI界的著名人物——他是一位AI研究员和博客作者。他在2022年9月通过Twitter联系了伊戈尔·拜科夫,这是他收到的回复。需要记住的重要信息:“参数数量庞大”。“文本”、“音频”、“图像”、“可能的视频”以及“多模态”。这些信息来自一个名为“thisisthewayitwillbe”的子论坛,这是我参与的一个小型、私人子论坛,由一位对AGI感兴趣的数学教授运营。AI爱好者(以及一些专家)使用这个子论坛来讨论比主流媒体更深入的AI话题。

“庞大的参数数量”?听起来伊戈尔·拜科夫是在提到一个100万亿参数的模型,因为在他2022年夏天发推文的时候,500亿参数模型和高达1万亿参数的模型已经被训练了很多次(使得这种规模的模型不再罕见,当然也算不上“庞大”)。来自“rxpu”的这些推文很有趣,看起来这位来自土耳其的AI爱好者(?)是第一个提出关于GPT-4发布窗口的非常相似的声明(相信我——我花了好几个小时,每天都在互联网上搜寻类似的声明,在他之前没有人提出过这个具体的声明)。他还提到了一个“125万亿突触”的GPT-4——然而,他错误地将GPT-3的参数数量说成了1万亿。(看起来rxpu确实有一些内部信息,但在参数数量上有些混淆——稍后我会进一步说明这一点,并证明rxpu并没有说谎)。

这是一条较弱的证据,但值得一提,因为“roon”作为硅谷AI研究员相当知名,他在Twitter上被OpenAI的首席执行官Sam Altman以及其他OpenAI研究员关注。

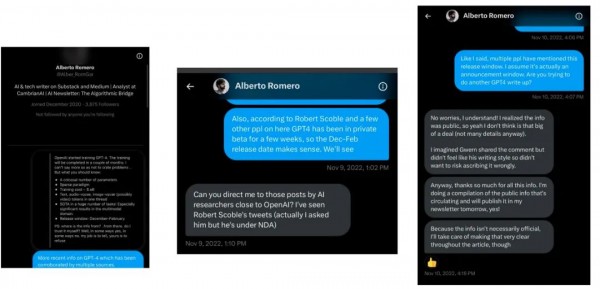

在2022年11月,我联系了一位名叫Alberto Romero的AI博主。他的帖子似乎在网上传播得相当广,所以我希望能给他发送一些关于GPT-4的基本信息,他可能会写一篇文章,这样消息就会传开。这次尝试的结果相当显著,我将在接下来的两页中展示。

Alberto Romero的帖子。

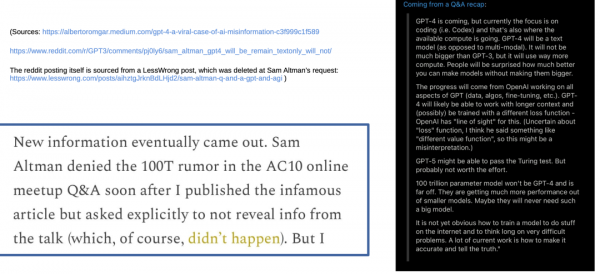

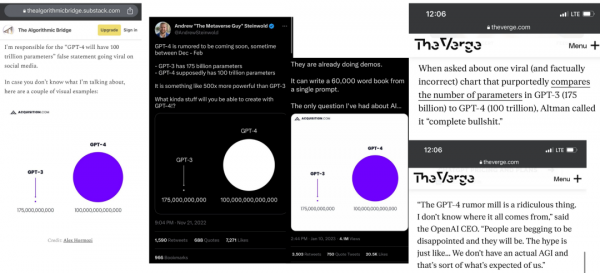

100万亿参数的泄露信息迅速传播开来,触及了数百万人,以至于包括首席执行官Sam Altman在内的OpenAI员工不得不做出回应——称之为“完全是胡说八道”。The Verge称其为“事实上的错误”。正如你在左边看到的,Alberto Romero声称对这次泄露负责。

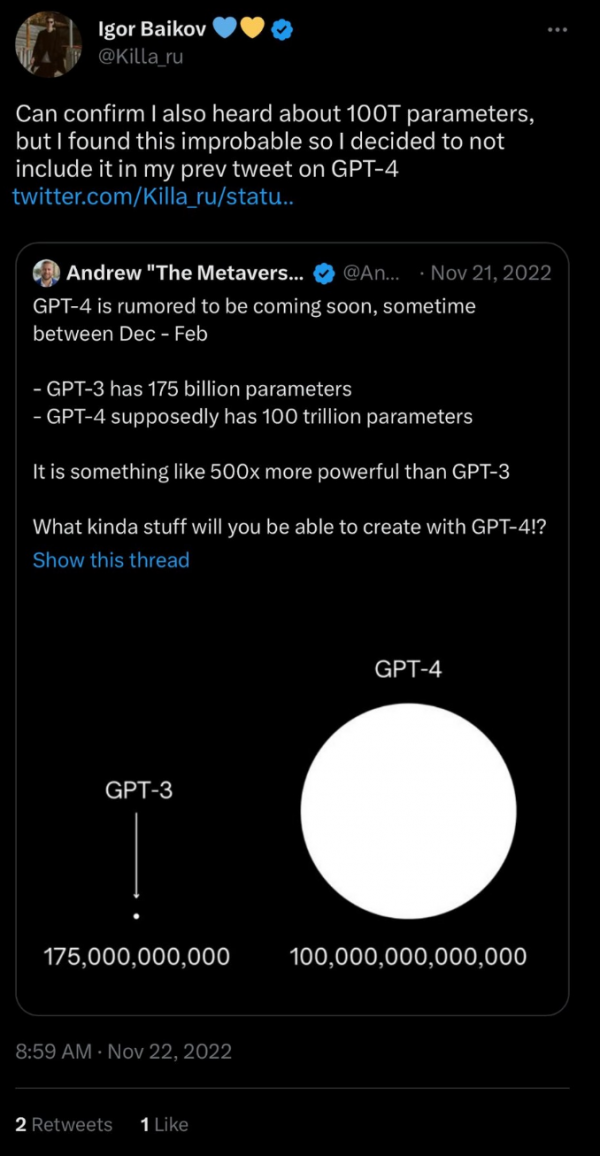

伊戈尔·拜科夫,也就是“庞大参数数量”这一说法的源头,也看到了GPT-4泄露信息的病毒式传播(这基本上是他自己所为),并做出了回应。所以,归根结底,当伊戈尔说“庞大参数数量”时,他确实是指“100万亿参数”。但是,伊戈尔是一个可靠的信息源吗?他的其他声明准确吗?多模态性又如何?GPT-4处理图像、声音和视频的能力又如何?我将很快证明伊戈尔的可靠性。

大约在2022年10月或11月,我确信OpenAI计划首先发布一个约1-2万亿参数的GPT-4子集,然后再发布完整的100万亿参数模型(即“GPT-5”)。

这些信息源并不是特别可靠,但他们都说了同样的事情——包括rxpu,他曾声称正在开发一个125万亿参数的模型,然后错误地声称GPT-3有1万亿参数——我相信他把信息搞混了。

这里的信息源可信度各不相同(Jyri和Leeor是旧金山的投资者,Harris是一位AI研究员),但他们都不约而同地说了同样的事情——GPT-4在2022年10月/11月正在被测试。根据美国军方AI研究员Cherie M Poland的说法,它肯定在10月份正在被训练,这再次与伊戈尔·拜科夫的泄露信息相吻合。

OpenAI的官方立场,正如Sam Altman本人所展示的,是认为100万亿参数的GPT-4的想法是“完全胡说八道”。这是半真半假的,因为GPT-4实际上是完整100万亿参数模型的一个1万亿参数子集。

仅为了说明100万亿参数的模型尚未到来且仍在开发中,Semafor在2023年3月(GPT-4发布后不久)声称GPT-4有1万亿个参数。(OpenAI拒绝正式公开参数数量)。

另一个值得注意的事情是,OpenAI声称GPT-4在8月份“完成了训练”,然而我们知道一个“庞大”的多模态模型在8月至10月之间正在接受训练。对此的一个解释是,OpenAI撒了谎。另一个可能性是,1万亿参数的GPT-4可能在8月份完成了第一轮训练,但在8月至10月之间进行了额外的再训练,而这正是完整的100万亿参数模型大部分训练发生的时间。

现在,我将提供我的证据,证明GPT-4不仅在文本和图像上进行了训练,而且还在音频和视频上进行了训练。Francis Hellyer看起来相当可信,但这个页面并不是最有力的证据——我之所以包含它,是因为它似乎证实了其他信息源的说法。Francis是一位投资者、企业家和作家。他在推文中列出的关于团队“耗尽互联网资源”的信息,在任何其他出版物、泄露或任何在线帖子中都找不到,所以他并没有从其他地方“窃取”这些信息。下一页将有一个非常可靠的信息源。

在GPT-4正式发布前一周,德国微软的首席技术官似乎失言,透露存在一个GPT-4,它具有处理视频的能力。我猜想他可能不知道OpenAI决定不公开该系统的视频功能。

这完全证明了GPT-4/5不仅在文本和图像上进行了训练,而且还包括了视频数据,当然我们可以推断音频数据也被包括在内。

显然,伊戈尔关于100万亿参数模型的说法是真实的,每一个细节都准确无误。另一个与伊戈尔的说法相符的信息源是一位可信的企业家,他在2022年10月25日表示,GPT-4的发布日期将在2023年1月至2月之间:

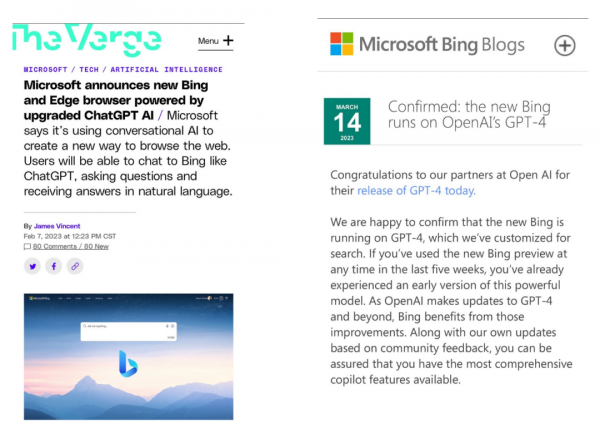

尽管GPT-4是在2023年3月发布的,略晚于伊戈尔·拜科夫所声称的12月至2月的窗口(我认为这是OpenAI有意为之,以削弱伊戈尔泄露信息的可信度),但基于GPT-4的Bing ChatGPT实际上是在2023年2月宣布的,这清楚地表明伊戈尔所声称的窗口是有效的,并且可能是在最后一刻由慌乱的OpenAI改变的。

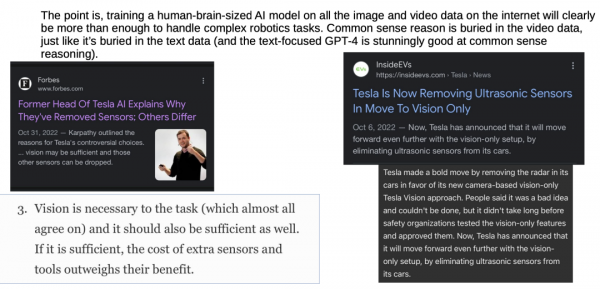

关于机器人学的一点说明:AI研究员开始相信,视觉是实现最佳现实世界/物理性能所必需的全部。举一个例子,特斯拉完全放弃了所有传感器,全力投入到自动驾驶汽车的视觉技术上。

重点是,在互联网上所有的图像和视频数据上训练一个与人类大脑大小相当的AI模型,显然将足以处理复杂的机器人学任务。常识推理被隐藏在视频数据中,就像它隐藏在文本数据中一样(而专注于文本的GPT-4在常识推理上表现得惊人的好)。

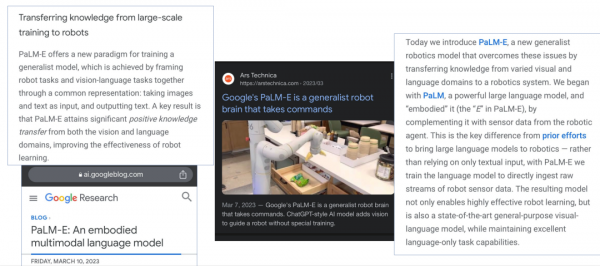

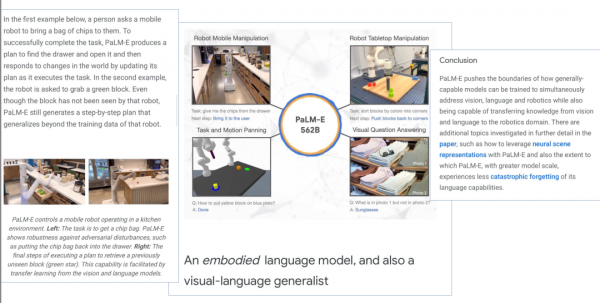

Google最近的一个例子,展示了机器人学能力是如何从大型视觉/语言模型中学习的。(在语言和视觉训练的基础上,只需要最少的机器人学数据,视觉和文本任务的知识就可以转移到机器人学任务上。OpenAI正在“互联网上的所有数据”上训练他们的100万亿参数模型,这无疑将包括机器人学数据)。Palm-E是一个约5000亿参数的模型——当你在互联网上所有可用数据的基础上训练一个100万亿参数的模型时,机器人学性能会发生什么变化?(关于Google的Palm-E模型的更多信息将在下一页介绍)。

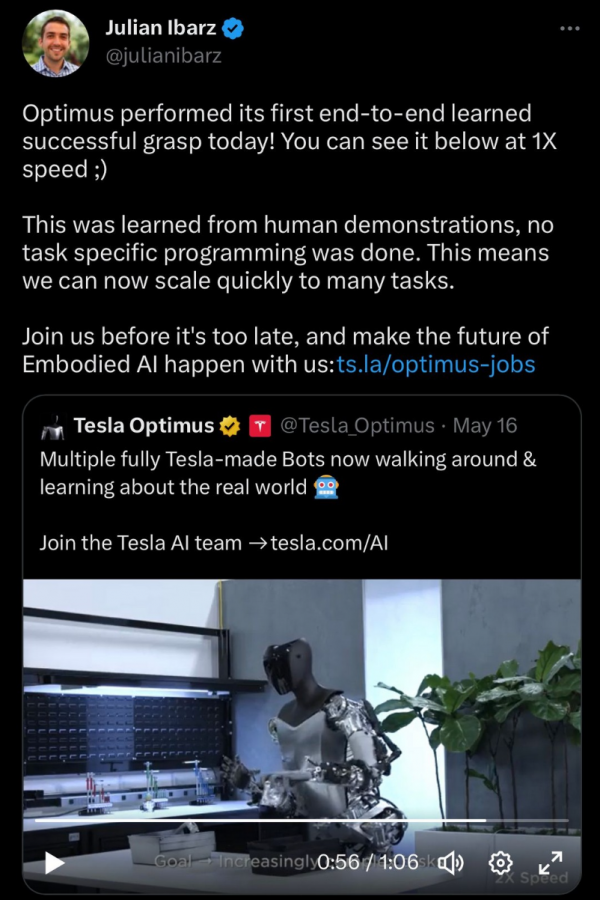

另一项机器人学发展——这次来自特斯拉(2023年5月16日)。他们训练了他们的机器人“Optimus”去抓取物体——而且“没有进行特定任务的编程”。一切都是通过人类示范学习的。“这意味着我们现在可以快速扩展到许多任务。” 再次强调:如果人类示范是先进机器人学性能所需的一切,那么一个在互联网上所有视频上训练的100万亿参数模型肯定能够实现惊人的机器人学性能...

左边的图片展示了1万亿参数的GPT-4在图像识别方面的能力。其回应已经比许多人类所能想出的更加清晰和写得更好。那么,当你在互联网上所有可用数据的基础上训练一个比GPT-4大100倍、与人类大脑大小相当的模型时,会发生什么呢?

重要:注意AI模型能够生成同一场景的多个角度,具有物理上准确的光线,甚至在某些情况下还能生成物理上准确的流体和雨水。如果你能生成具有准确、常识性物理的图像和视频,你就拥有了常识推理能力。如果你能生成常识,你就理解了常识。

目前公开可用的视频和图像生成AI模型的质量水平示例。这些模型的大小不到100亿参数。当你在互联网上所有可用数据的基础上训练一个比这大10,000倍的模型,并赋予它生成图像和视频的能力时,会发生什么?(答案:图像和视频与真实事物完全无法区分,100%的时间,没有任何例外,没有任何解决方法,无论人们怎么努力,都无法分辨出区别)。-(更新:SORA来自GPT-5 Q* 2023模型)

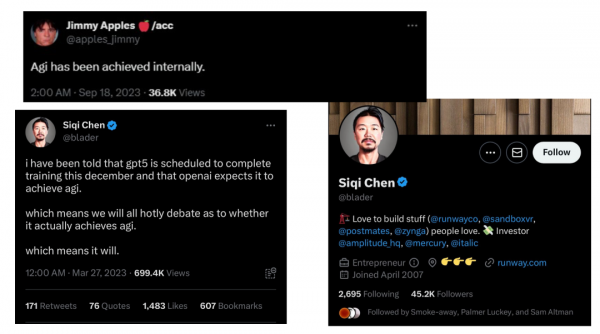

来自Longjumping-Sky-1971的两篇帖子。我之所以包含这些,是因为他提前几周准确预测了GPT-4的发布日期(没有人事先公开发布这些信息,这意味着他有一个内部信息源)。他的帖子现在更有可信度——他声称图像和音频生成将在2023年第三季度进行训练。如果视频生成训练是同时进行的或紧随其后,这与Siqi Chen声称GPT-5在2023年12月完成训练的说法相吻合。

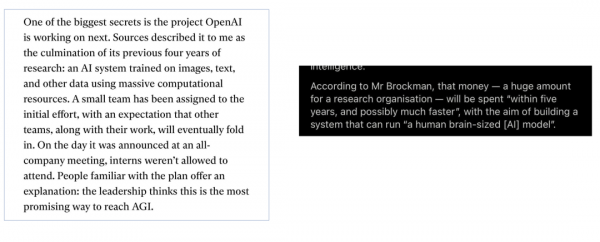

直到2020年2月,也就是GPT-3发布前几个月。一篇来自《技术评论》的文章,这是关于OpenAI的“内部故事”,似乎表明OpenAI正处于一个“秘密”项目的早期阶段,涉及一个在图像、文本和“其他数据”上训练的AI系统,而且OpenAI的领导层认为这是实现AGI最有希望的方式。我在想这可能指的是什么。

接下来将展示来自OpenAI总裁的一些引述——来自2019年——它将告诉你他们的计划是什么。

OpenAI的总裁Greg Brockman在2019年表示,在微软当时投资了10亿美元之后,OpenAI计划在五年内构建一个与人类大脑大小相当的模型,而这正是他们实现AGI的计划。2019 + 5 = 2024。

这两个信息源显然都在提到同一个实现AGI的计划——一个与人类大脑大小相当的AI模型,将在“图像、文本和其他数据”上进行训练,计划在2019年之后的五年内完成训练,也就是到2024年。这似乎与我在这份文件中列出的所有其他信息源相吻合...

正如我将在接下来的几张幻灯片中展示的,AI领域的领导者们突然开始敲响警钟——几乎就像他们知道一些非常具体的信息,而这些信息普通大众并不知道。

“我曾经认为这还需要30到50年,甚至更长的时间。显然,我现在不再这么认为了。”来自CNN的报道AI之父离开google的新闻。

是什么让他突然改变了主意——并决定离开谷歌来谈论AI的危险?

在GPT-4发布后不久,未来生活研究所(Future of Life Institute),这是一个高度有影响力的非营利组织,致力于减轻对世界可能的灾难性风险,发布了一封公开信,呼吁所有AI实验室暂停AI开发六个月。为什么呢?

这封信件的第一个发布版本特别提到了“(包括目前正在训练的GPT-5)”。为什么会包含这一点,又为什么会被移除?

来自2022年10月Sam Altman的一次采访和问答环节中的一些令人警觉的引述——YouTube链接:https://m.youtube.com/watch?v=b022FECpNe8 (时间:49:30)观众问答环节问题:“我们是否拥有足够的互联网信息来创建AGI?” Sam Altman直接而坦率的回答,打断了提问者的话:“是的。” Sam进一步阐述:“是的,我们对此很有信心。我们经常考虑这个问题,并且对此进行了相当多的衡量。” 采访者插话:“是什么给了你这种信心?” Sam的回答:“我认为OpenAI在领域内推动的一件非常有益的事情是,你可以将规模法则视为一种科学预测。你可以对计算这样做,你可以对数据这样做,但你可以从小规模进行衡量,并且可以相当准确地预测它将如何扩大规模。你需要多少数据,你需要多少计算,你需要多少参数,当生成的数据足够好以至于有所帮助时……互联网上……有很多数据。也有很多视频。”

来自Sam Altman问答环节的另一段引述——(时间:53:00) [注——AI冬天是指AI领域长时间获得有限资金支持,并且不被严肃研究者给予太多关注的一个时期。这发生过两次——一次是在70年代和80年代,另一次是从80年代中期直到大约2000年代末。] 另一个观众问题:“我们可能会有另一个AI冬天吗,它可能由什么引起?” Sam Altman的回答:“我们可能会有另一个AI冬天,它可能由什么引起……是的,当然。我认为我们不会很快遇到。因为即使我们永远找不到另一个研究思路,当前范式的经济价值以及它还能被推动多远,将会在未来很多年内支持我们。但尽管不太可能,我们仍然可能错过了超越行为克隆的关键思路,这些模型将会永远停留在人类水平。我有很多理由认为这不是真的,但如果有人告诉你我们在这个研究领域绝不可能再有一个冬天,你绝不要相信他们。”

关于Sam Altman的问答环节 首先,Sam Altman似乎非常、非常确信互联网上存在足够的数据来训练一个AGI系统——他的自信程度让人怀疑他们是否已经做到了,或者正在做这件事。其次,“AI冬天”这个概念通常指的是通向AGI的进展放缓的时期,但Sam Altman重新定义了这个术语,使其指的是通向超级智能的进展放缓的时期。这似乎表明OpenAI已经构建了一个AGI系统,或者非常接近了,而AGI不再是目标,因为它已经存在。

正如我之前在文档中提到的,一个100万亿参数的模型实际上是稍微次优的,但OpenAI正在使用一种新的缩放范式来弥补这个差距——它基于所谓的“Chinchilla缩放法则”。

Chinchilla是DeepMind在2022年初公布的一个AI模型。Chinchilla研究论文的含义是,当前的模型训练得远远不够,而且如果有更多的计算资源(意味着更多的数据),性能将会大幅提升,而无需增加参数。

重点是,虽然一个训练不足的100万亿参数模型可能稍微次优,但如果它在更多的数据上进行训练,它将能够轻松地超越人类水平的性能。

Chinchilla范式在机器学习领域被广泛理解和接受,但为了给出一个来自OpenAI的具体例子,总裁Greg Brockman在这次采访中讨论了OpenAI如何意识到他们最初的缩放法则是有缺陷的,并已经调整以考虑Chinchilla法则:https://youtu.be/Rp3A5q9L_bg?t=1323

人们说,“训练一个计算最优的100万亿参数模型将耗资数十亿美元,根本不可行。”嗯,微软在2023年初向OpenAI投资了100亿美元,所以我猜这并不是一个荒谬的可能性……

Alberto Romero写了关于DeepMind的Chinchilla缩放突破的文章。Chinchilla表明,尽管它的规模远小于GPT-3和DeepMind自己的Gopher,但由于在更多的数据上进行了训练,它的性能超过了它们。再次重申这一点:尽管预测100万亿参数的模型将达到略次优的性能,但OpenAI非常清楚Chinchilla缩放法则(实际上AI领域的几乎每个人都清楚),并且他们正在将Q*训练为一个100万亿参数的多模态模型,这个模型是计算最优的,并且在比他们最初计划的更多的数据上进行了训练。现在他们通过微软的资金有能力做到这一点。这将导致一个模型,其性能远远超过他们最初为100万亿参数模型所计划的。没有Chinchilla缩放法则的100万亿参数=大致人类水平但略次优。100万亿参数,多模态,考虑到Chinchilla缩放法则= ............?

从2022年7月开始,美国开始采取措施阻止新的计算机芯片被送往中国,试图阻止他们的AI进展。这个计划在2022年10月最终确定。根据旧金山的AI研究员Israel Gonzales-Brooks的说法,Sam Altman在2022年9月访问了华盛顿特区。Israel声称与Sam Altman有联系(我无法验证这一点),但他的可信度来自于Sam Altman在2023年1月确实被证实访问了华盛顿特区的事实。

如果GPT-4/GPT-5在2022年夏天开始训练,而Sam Altman在这段时间(可能多次)访问了华盛顿特区,那么对中国芯片的禁令不可能是巧合。

OpenAI计划在2027年之前构建出人类水平的AI,然后扩展到超级智能。这个计划因为埃隆·马斯克的诉讼而被推迟,但它仍然将很快实现。

最后,我将揭示一个令人难以置信的信息来源——它来自著名的计算机科学家斯科特·阿伦森(Scott Aaronson)。在2022年夏天,他加入了OpenAI一年,致力于AI安全工作……他在博客上对此发表了一些非常有趣的看法。斯科特·阿伦森在2022年12月底写了一篇博客文章,是一封给他11岁的自己的“信”,讨论了当前事件和他生活中的成就。下一页是令人担忧的部分...

有一家公司正在建造一个AI,它占据了巨大的房间,消耗了一个城镇的电力,并且最近获得了令人惊叹的与人交谈的能力。它可以就任何主题撰写文章或诗歌。它可以轻松通过大学级别的考试。它每天都在获得工程师们尚未公开讨论的新能力。然而,这些工程师确实坐在公司自助餐厅里,辩论他们所创造的东西的意义。下周它会学到做什么?哪些工作可能会被它使变得过时?他们应该放慢或停止,以免激怒龙的尾巴吗?但这不就意味着其他人,可能是那些道德观念较少的人,会首先唤醒龙吗?是否有道德义务告诉世界更多关于这个的信息?是否有义务告诉得更少?我——你——将在那家公司工作一年。我的工作——你的工作——是开发一个关于如何防止AI及其后继者造成破坏的数学理论。这里的“造成破坏”可能意味着任何事情,从加速宣传和学术作弊,到提供生物恐怖主义建议,到是的,摧毁世界。

好文章,需要你的鼓励

让AI看图功能瘦身90%:希腊塞萨洛尼基大学发现图像修复“中奖彩票“神经网络

希腊塞萨洛尼基大学研究团队开发出MIR-L算法,通过"彩票假说"发现大型图像修复网络中的关键子网络。该算法采用迭代剪枝策略,将网络参数减少90%的同时保持甚至提升修复性能。MIR-L能同时处理去雨、去雾、降噪等多种图片问题,为资源受限设备的实时图像处理提供了高效解决方案,具有重要的实用价值和环保意义。

人工智能使用大揭秘:OpenRouter公司百万亿规模数据分析报告

这项由OpenRouter公司团队和Andreessen Horowitz(a16z)投资机构联合开展的研究,于2025年12月发表。

卡内基梅隆大学提出DistCA:让AI训练告别“木桶效应“的神奇技术

卡内基梅隆大学团队提出DistCA技术,通过分离AI模型中的注意力计算解决长文本训练负载不平衡问题。该技术将计算密集的注意力任务独立调度到专门服务器,配合乒乓执行机制隐藏通信开销,在512个GPU的大规模实验中实现35%的训练加速,为高效长文本AI模型训练提供了新方案。