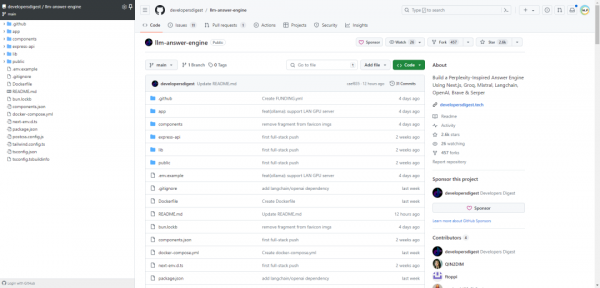

llm-answer-engine:一个Perplexity风格的回答引擎项目

llm-answer-engine是一个使用Next.js、Groq、Mixtral、Langchain、OpenAI、Brave和Serper构建的Perplexity风格的回答引擎项目。如下所示:

-

项目旨在创建一个高级回答引擎,能够有效返回基于用户查询的来源、答案、图像、视频和后续问题。

-

使用Next.js构建服务器端渲染和静态Web应用程序。

-

利用Tailwind CSS框架快速构建自定义用户界面。

-

包含Groq和Mixtral技术,用于处理和理解用户查询。

-

Langchain.JS库重点关注文本操作,如文本分割和嵌入。

-

使用Brave Search提供隐私保护的搜索引擎,获取相关内容和图像。

-

Serper API用于根据用户查询获取相关的视频和图像结果。

-

OpenAI Embeddings用于创建文本块的向量表示。

-

提供了安装和设置运行服务器的详细指南,包括获取API密钥和安装依赖。

-

遵循MIT许可证。

参考文献:

[1] https://www.developersdigest.tech/

[2] https://github.com/developersdigest/llm-answer-engine

来源:NLP工程化

好文章,需要你的鼓励

SanDisk重塑经典SSD品牌:WD Black和Blue正式更名为Optimus系列

西部数据闪存业务分拆后,SanDisk宣布将停用广受欢迎的WD Black和Blue品牌,推出全新的SanDisk Optimus系列NVMe产品线。WD Blue驱动器将更名为SanDisk Optimus,而高端WD Black驱动器将分别更名为Optimus GX和GX Pro。尽管品牌变更,底层硬件和供应链保持不变。然而受全球内存短缺影响,预计2026年第一季度客户端SSD价格可能上涨超过40%。

上海AI实验室研究者想出妙招:让AI像优秀学生一样高效思考,告别“想太多“毛病

上海AI实验室开发RePro训练方法,通过将AI推理过程类比为优化问题,教会AI避免过度思考。该方法通过评估推理步骤的进步幅度和稳定性,显著提升了模型在数学、科学和编程任务上的表现,准确率提升5-6个百分点,同时大幅减少无效推理,为高效AI系统发展提供新思路。

福特汽车准备在车载系统中引入AI智能助手

福特汽车在2026年消费电子展上宣布将在车辆中引入AI助手技术。该AI助手最初将在福特和林肯智能手机应用中推出,从2027年开始成为新车型的原生功能。福特希望通过AI技术实现车辆个性化体验,提供基于位置、行为和车辆能力的智能服务。同时,福特将采用软件定义车辆架构,推出自研的高性能计算中心,提升信息娱乐、驾驶辅助等功能。

MIT团队让机器人终于不再“卡顿“:一种让机器人像人一样流畅反应的突破性技术

MIT团队开发的VLASH技术首次解决了机器人动作断续、反应迟缓的根本问题。通过"未来状态感知"让机器人边执行边思考,实现了最高2.03倍的速度提升和17.4倍的反应延迟改善,成功展示了机器人打乒乓球等高难度任务,为机器人在动态环境中的应用开辟了新可能性。