MiniCPM-Llama3-V 2.5实现了GPT-4V级的多模态能力

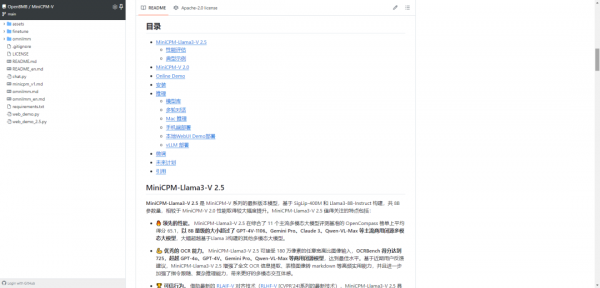

MiniCPM-V是面向图文理解的端侧多模态大模型系列。该系列模型接受图像和文本输入,并提供高质量的文本输出。自2024年2月以来,我们共发布了4个版本模型,旨在实现领先的性能和高效的部署,目前该系列最值得关注的模型包括:

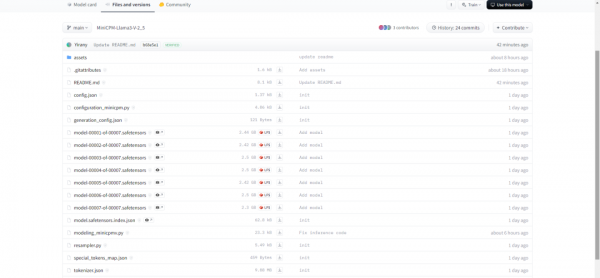

(1)MiniCPM-Llama3-V 2.5:MiniCPM-V系列的最新、性能最佳模型。总参数量8B,多模态综合性能超越 GPT-4V-1106、Gemini Pro、Claude 3、Qwen-VL-Max 等商用闭源模型,OCR 能力及指令跟随能力进一步提升,并支持超过30种语言的多模态交互。通过系统使用模型量化、CPU、NPU、编译优化等高效推理技术,MiniCPM-Llama3-V 2.5 可以实现高效的终端设备部署。

(2)MiniCPM-V 2.0:MiniCPM-V系列的最轻量级模型。总参数量2B,多模态综合性能超越 Yi-VL 34B、CogVLM-Chat 17B、Qwen-VL-Chat 10B 等更大参数规模的模型,可接受 180 万像素的任意长宽比图像输入,实现了和 Gemini Pro 相近的场景文字识别能力以及和 GPT-4V 相匹的低幻觉率。

参考文献:

[1] https://github.com/OpenBMB/MiniCPM-V

[2] MiniCPM 系列开源地址:https://github.com/OpenBMB/MiniCPM

[3] Hugging Face 下载地址:https://huggingface.co/openbmb/MiniCPM-Llama3-V-2_5

[4] MiniCPM-V 2.0: 具备领先OCR和理解能力的高效端侧多模态大模型:https://openbmb.vercel.app/minicpm-v-2

好文章,需要你的鼓励

谷歌智能体开发套件架构深度解析:从核心组件到实践应用

谷歌Agent Development Kit(ADK)革新了AI应用开发模式,采用事件驱动的运行时架构,将代理、工具和持久化状态整合为统一应用。ADK以Runner为核心,通过事件循环处理用户请求、模型调用和外部工具执行。执行逻辑层管理LLM调用和工具回调,服务层提供会话、文件存储等持久化能力。这种架构支持多步推理、实时反馈和状态管理,为构建超越简单聊天界面的生产级AI应用提供了完整框架。

上海AI实验室让机器人“睁眼看世界“:用视觉身份提示技术让机械臂学会多角度观察

上海AI实验室联合团队开发RoboVIP系统,通过视觉身份提示技术解决机器人训练数据稀缺问题。该系统能生成多视角、时间连贯的机器人操作视频,利用夹爪状态信号精确识别交互物体,构建百万级视觉身份数据库。实验显示,RoboVIP显著提升机器人在复杂环境中的操作成功率,为机器人智能化发展提供重要技术突破。

iOS 18新增游戏应用正式上线,专为iPhone游戏体验而生

苹果在iOS 26中推出全新游戏应用,为iPhone、iPad和Mac用户提供个性化的游戏中心。该应用包含五个主要版块:主页展示最近游戏和推荐内容,Arcade专区提供超过200款无广告游戏,好友功能显示Game Center动态并支持游戏挑战,资料库可浏览已安装游戏并提供筛选选项,搜索功能支持按类别浏览。iOS 26.2版本还增加了游戏手柄导航支持,为游戏玩家提供更便捷的操作体验。

英伟达团队突破AI训练瓶颈:让机器人同时学会多种技能不再“顾此失彼“

英伟达研究团队提出GDPO方法,解决AI多目标训练中的"奖励信号坍缩"问题。该方法通过分别评估各技能再综合考量,避免了传统GRPO方法简单相加导致的信息丢失。在工具调用、数学推理、代码编程三大场景测试中,GDPO均显著优于传统方法,准确率提升最高达6.3%,且训练过程更稳定。该技术已开源并支持主流AI框架。