Figma也开始卷AI了,设计师又要完蛋了?

作为一个曾经干了快10年的老设计狗,现在听到最多的就是:

设计师要完蛋啦~

今天是视觉完蛋了,明天是原画完蛋了,后天是平面完蛋了。

反正听那意思,管你是个啥,但凡粘个设计两字,在AI时代,那你就都得完蛋。

不过在这反反复复听了一年多的完蛋的历史中,啥设计分支职业都听到要完蛋了,唯独有一个分支,却很少听到有朋友跟我说。

那个职业,叫UI设计师。

嗯,恰好就是我的职业。至于UI这玩意具体是设计啥的,我贴个百度百科的截图吧。

注意这句话:

就怎么说呢,大家开心就好。

狭义的UI设计,就是画你我手上的各种APP、网页等等的视觉界面的;至于广义的UI设计,就是得会UI、交互、用研、产品,最好还能手撸个前端代码,别问为啥广义的UI要会这么多,问就是时代变了。

然后昨天,好几个UI朋友跑来疯狂的跟我说:

卧槽,UI设计完球了。

我说你慌个球,什么情况,淡定的说。

“你去看一眼Figma”

于是我就去看了一下Figma的更新。

淦。

Figma在UI设计界是啥地位呢,大概就等于平面设计的PS、大雄的哆啦A梦、金融人的冰美式,简单的说,就是没他干不了活的程度。曾经还有个Sketch能跟他掰掰手腕,现在已经不知道飞哪去了。

现在,憋了一整年,Figma终于把他们的AI给憋出来了。

在没AI之前,UI设计们是怎么干活的呢?

用一个词描述就是工匠,每一个按钮,每一条线,每一个图标,都需要设计师亲自动手去画,活脱脱一个数字时代的打铁匠人。

大一点的UED团队,会有一个设计规范和组件库的东西,在画一些界面的时候,直接挨个拖组件,在画布上搭乐高。

在视觉、插画这些工种被AI武装了一年丢失了50%的兄弟的情况下,Figma终于带着他们的AI来了,要来武装我们的UI设计兄弟了。

难怪我的朋友们说,UI设计要完蛋了。行业完不完我不知道,但是时代的一粒灰,落在个人头上就是一座山,谁也不知道自己是不是那被丢失了50%的兄弟中的一员。

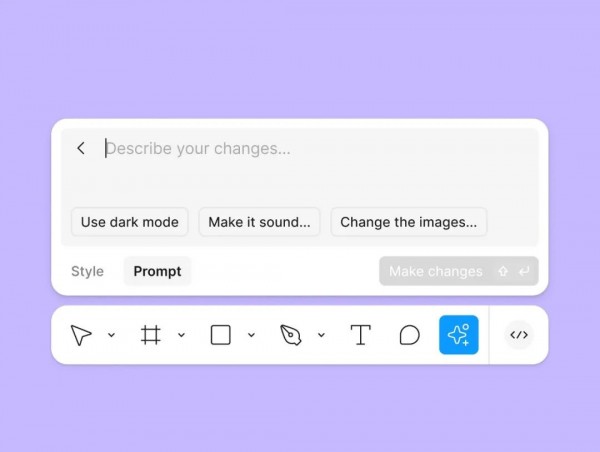

Figma的AI这次最拿得出手的功能,可能就是用一句话生成UI界面。

生成好以后,是带有图层的,设计师都懂这意味着什么,你可以进行后续的二次编辑和修改了!同时你也可以再选中某些特定元素,再用嘴,进行一些修改。

正儿八经的实现了很多老板们梦寐以求的,用嘴做设计。

除了用嘴生成UI设计稿,Figma AI还给你造了一个视觉搜索。

以前我经常拿着一个界面问同事:这你画的不?同事瞄了几眼,说:是啊。

我说你把源文件发我下,他说行,你等我一会,我找找。

然后就是a long long ago,半小时以后,终于给我发了个链接,哥们欣喜的喊着,找到了找到了。感觉他不是从仓库里淘出来了源文件,是从屎山里掏出了一公斤重的大金砖。

现在好了,找到那个设计的截图,往Figma里一丢,嘭!它立马就能帮你找到那个文件。

虽然看着有点像淘宝“找同款”。。。

除了这两个,Figma AI还整了几个花里胡哨的小功能:

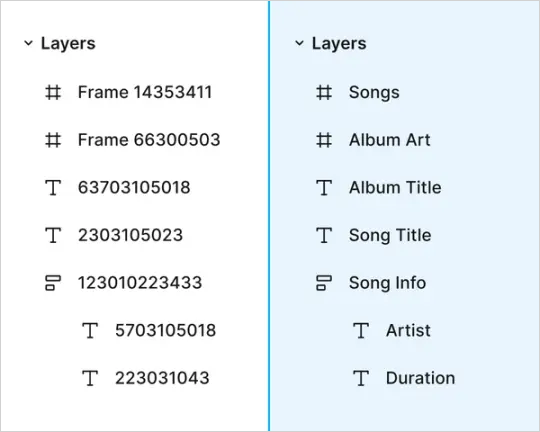

自动命名图层:还记得那些命名混乱的图层吗?

以前设计师们纠结得要死,要不要给每个破图层都起个名字,起了吧累死人,不起吧找起来跟瞎子摸象似的。

“图层1”、“图层2”...简直就像是给多胞胎起名叫熊大、熊二、熊三一样。

现在好了,Figma AI直接给这些图层用AI结合上下文和图层内容,自动起个像样的名字,让你的设计文件不再像个名字大杂烩。

以上这些,就是Figma AI的所有内容了。

你没听错,没了。

只能说,如果Figma早发布半年,甚至是早三个月,没准都能引起一场轰动。

从去年6月的Config大会上,宣布收购Jordan Singer的Diagram团队开始表明全力进军AI。经过一年时间整出来的这些功能,说实话,我觉得有点敷衍了事。

并不是不实用,只是,没有任何想象力和惊喜可言,都是所有人都能预期到的存在,就是四处缝,要是都能做得特别牛逼也行,就正式版一发布怕做成个四不像。

Figma找到了自己的AI创新之路吗?我觉得还远没有,现在感觉还是在被动防御。

那架势就是你们都做了我不能不做啊,然后捣鼓半天,终于掏出个玩意,到处给大家看,说,你看你看,我真的有,还挺大的,赶紧来试试啊。

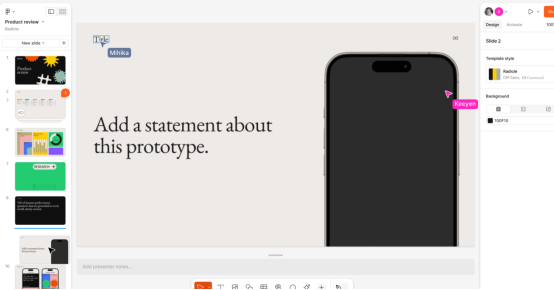

但是我们又不得不承认,他们也确实在努力拓展自己的版图。这次除了AI,还搞出来个Figma Slides,Slide如果不熟悉,那他还有个中文名,叫PPT。

Figma的首席产品官Yuhki Yamashita说,用户们一直想在Figma里搞PPT,去年一年,用户们硬是在Figma里整出了将近350万个PPT。

现在,我们看不下去了,我们直接给你们整了个标准的PPT制作流程。从设计到演示,你都不用离开Figma这个地方了。

说没有冲击,那是不可能的,因为Figma+AI这玩意儿一出来,UI设计的下限,现在被远远拉高了。

同时对设计师的专业素养和创意脑洞的要求又拉高了一个档次。

好文章,需要你的鼓励

奥运级别的努力:首席信息官为2026年AI颠覆做准备

AI颠覆预计将在2026年持续,推动企业适应不断演进的技术并扩大规模。国际奥委会、Moderna和Sportradar的领导者在纽约路透社峰会上分享了他们的AI策略。讨论焦点包括自建AI与购买第三方资源的选择,AI在内部流程优化和外部产品开发中的应用,以及小型模型在日常应用中的潜力。专家建议,企业应将AI建设融入企业文化,以创新而非成本节约为驱动力。

字节跳动发布GAR:让AI能像人类一样精准理解图像任何区域的突破性技术

字节跳动等机构联合发布GAR技术,让AI能同时理解图像的全局和局部信息,实现对多个区域间复杂关系的准确分析。该技术通过RoI对齐特征重放方法,在保持全局视野的同时提取精确细节,在多项测试中表现出色,甚至在某些指标上超越了体积更大的模型,为AI视觉理解能力带来重要突破。

Spotify推出AI播放列表功能让用户掌控推荐算法

Spotify在新西兰测试推出AI提示播放列表功能,用户可通过文字描述需求让AI根据指令和听歌历史生成个性化播放列表。该功能允许用户设置定期刷新,相当于创建可控制算法的每周发现播放列表。这是Spotify赋予用户更多控制权努力的一部分,此前其AI DJ功能也增加了语音提示选项,反映了各平台让用户更好控制算法推荐的趋势。

Inclusion AI推出万亿参数思维模型Ring-1T:首个开源的超大规模推理引擎如何重塑AI思考边界

Inclusion AI团队推出首个开源万亿参数思维模型Ring-1T,通过IcePop、C3PO++和ASystem三项核心技术突破,解决了超大规模强化学习训练的稳定性和效率难题。该模型在AIME-2025获得93.4分,IMO-2025达到银牌水平,CodeForces获得2088分,展现出卓越的数学推理和编程能力,为AI推理能力发展树立了新的里程碑。