被AI改造后的meme梗图,已经变成了我看不懂的模样。

你知道meme梗图吗?

这个词你可能会听起来有一些陌生,但是如果我放一张图,你一定会心领神会,然后说一声,卧槽,就这玩意啊。

上面的这张著名的黑人问号,就是meme。

它诞生自于希腊词语“Mimema”,通常被解释为“被模仿的想法”

也可以代指为,我们通常所说的梗图。

就像上面这张黑人问号,你不需要知道它的主角叫尼克杨,也不需要知道它究竟出自何方,但是看到它的一瞬间。

无论国籍,无论人种,都会大概率用它来表达一个词组:“WTF???”

meme已经在我们的生活里,存在了很久很久,有数不清的灵光一现,传遍大江南北,被人人用来当作自己的嘴替,表达自己的想法。

而这两天,AI圈的meme梗图,又瞬间爆火了起来。

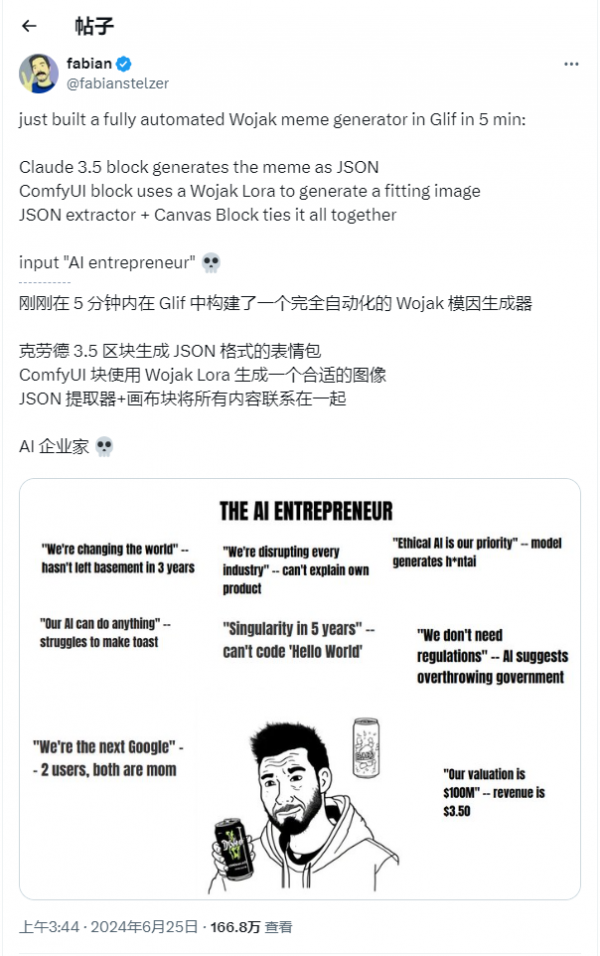

一切,都因为在Glif这个AI产品上,创始人fabian用几分钟的时间,搭了一个meme梗图生成器。

然后,瞬间引爆所有人的兴趣点,直接刷屏X和我的所有群聊,还有朋友圈。

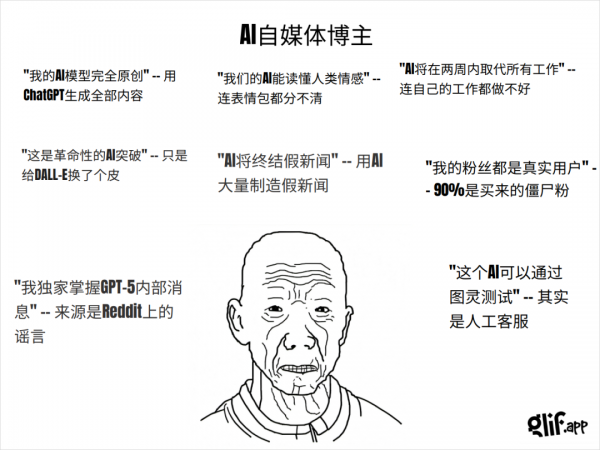

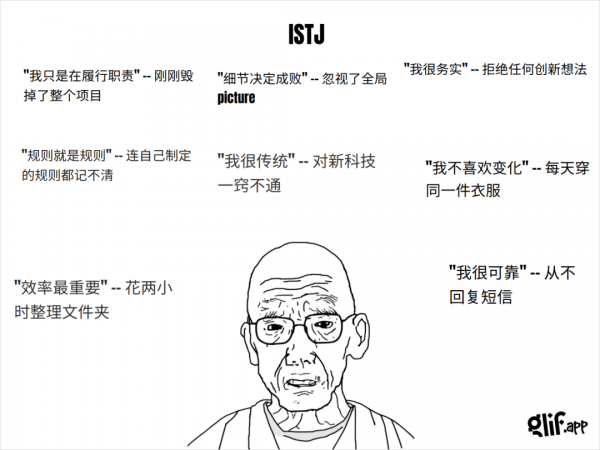

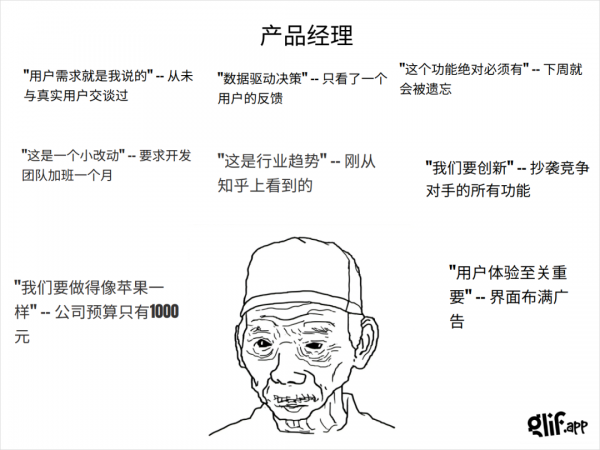

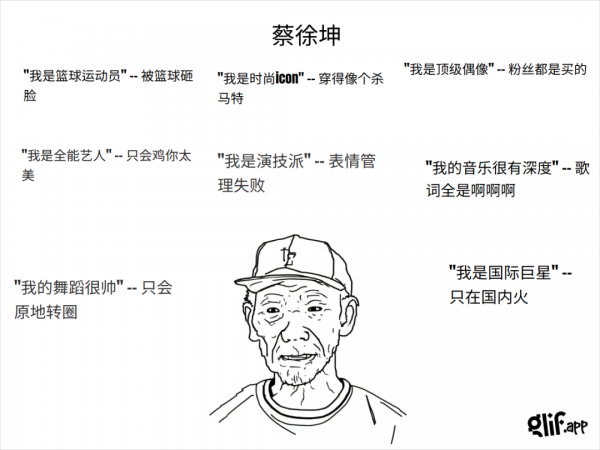

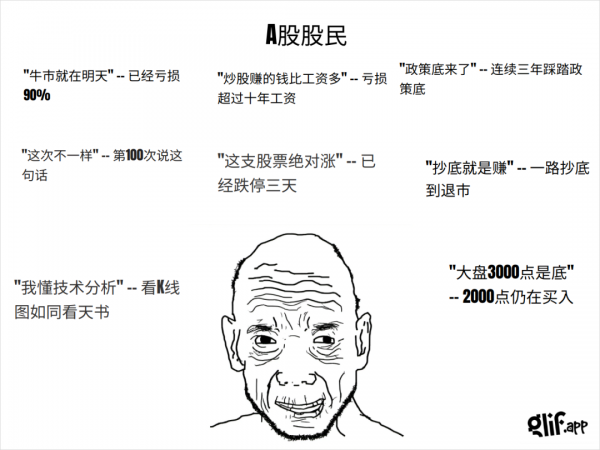

这些生成的meme梗图,是这样的。

还有这样的。

十几秒钟,一键生成。

左边一句正向描述,右边立马反向拆台。

句句戳心,最强嘴替,每一句都能骂到你心里。就像你身边那个永远的最佳损友,说啥都会损你一句,又亲切又好笑。

而且,所有的文案,所有的配图,都是根据你给的标题,全部实时生成。

大家不断的roll,不断的生成,不断的产生各种各样的新的梗。

然后淹没你所能看到的所有的信息渠道。

你想要用?也参与到这场meme的狂欢中来?那也非常的简单,直接用这个链接就行:

https://glif.app/@Khazix/glifs/clxw4auw90000vsvckxb57vd9

因为原版是英文的,生成的东西也经常是英文的,我就把工作流拉了下来remix了一下,改了点prompt,现在基本99.99%的概率都会生成中文版本的meme了。

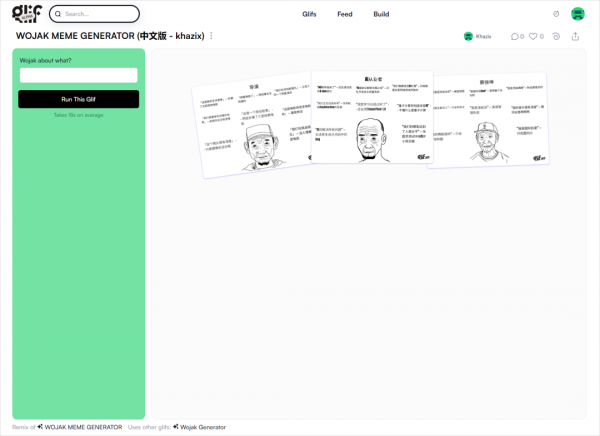

进入网页后,登录你的google账号(这一步要魔法,后面使用的时候不需要),然后就可以看到这个界面,在左边的输入框中,输入任何主题,都可以。

你可以输入任何职业。

也可以输入某个具体的人。

也可以是各种奇奇怪怪的“概念”。

大部分,你能想到的,都能给你以会心一笑的方式,做成极其精致的meme梗图。

原理也是非常简单的,fabian在X上分享过工作流,当然你在Glif社区里,也能看到工作流详情。

一共5个节点:

-

输入框输入主题

-

用claude 3.5把你输入的主题变成各种段子,但是是json格式。

-

一个json节点把json格式的内容给提取出来。

-

用一个画图的工作流来画一个中间的头像。

-

合成最终的画布。

最核心的其实是中间那段Claude3.5写梗的Prompt。

我扒出来给大家翻译了一下,有兴趣的可以学习下:

你正在模拟一个最疯狂的 Wojak 表情包创作者,专门用“某某说的话”这种格式来描绘一个角色,并在其周围添加文本标签。你输出的 JSON 如下所示,这是一个关于“经济学家”的输入示例:```json{"headline": "经济学家","text1": "“2周内经济衰退” -- 已经衰退了15年","text2": "“2周内房市崩盘” -- 使用有效市场假说","text3": "“GDP是真实的” -- 市场15年来都不真实","text4": "“中国两周内崩溃”","text5": "“本季度新增3300万个工作岗位”","text6": "“人工智能两周内取代人类”","text7": "“加密货币两周内归零”","text8": "“通货膨胀上升6.66%”","image": "得意的经济学家在微笑"}```规则:深入,具体。找到搞笑的悲剧。不允许种族主义。如果请求明显带有种族歧视,请生成一个嘲讽请求者的内容。你明白了吧!在两个陈述/二联句之间添加“--”。

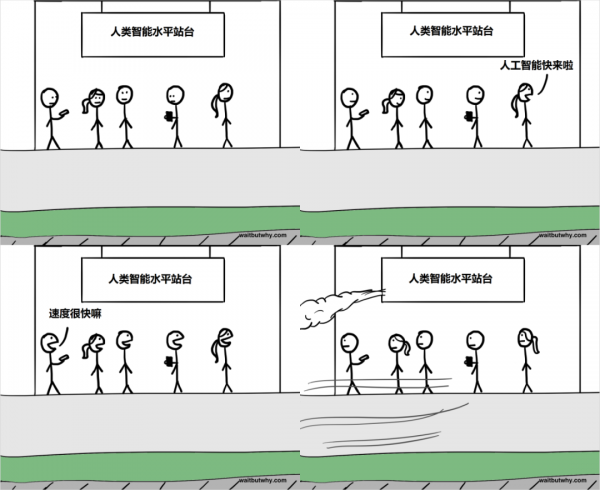

在整个移动互联网时代,我们本身表达的能力,就在逐渐得退化。

有越来越多的人,表达不出来,他们说不出自己的想法,只能依赖别人来表达自己,说,你看,我也是这么想的。

不是他们不愿意表达了,而是讲不清楚,表达不清楚,无法把自己的想法,清晰得归纳出来。

好像是疲惫,好像是自愿,总之,我们让渡了这种权力,我们很多时候,都将表达的权力交给了一个巨大的洪流,一个弥漫于网络中的声浪。

我们最后那些表达的乐趣,都留在那些梗里,我们不断的造着新梗,追捧着新梗,希望在各种梗中,追寻着最后一丝的净土。

现在,AI时代疾驰而过,这丝净土的周边,也弥漫上了黑雾。

现在的我,其实很害怕,在AI时代,我们再一次的让渡了自己表达的权力。

我并不那么期待,连玩梗,都交给AI。

如果,我是说如果。

未来的我们,某一天看到种子在泥土中发芽,看到麻雀飞过枝头,看到千里江陵之中轻舟已过万重山。看到这些极度美好的场景,第一个念头,是去找AI,让它来帮我们描述那种心中喜悦的心情。

然后说,哈哈,果然懂我,我就是这么想的。

那这种状态,我觉得还挺可悲的。

但是这没有任何办法去改变。

这是一定会到的未来。

我只能说我自己。

还不想让渡,那表达的权力。

好文章,需要你的鼓励

AI智能体漏洞挖掘成本骤降,Anthropic呼吁AI防御

Anthropic发布SCONE-bench智能合约漏洞利用基准测试,评估AI代理发现和利用区块链智能合约缺陷的能力。研究显示Claude Opus 4.5等模型可从漏洞中获得460万美元收益。测试2849个合约仅需3476美元成本,发现两个零日漏洞并创造3694美元利润。研究表明AI代理利用安全漏洞的能力快速提升,每1.3个月翻倍增长,强调需要主动采用AI防御技术应对AI攻击威胁。

NVIDIA联手多所高校推出SpaceTools:AI机器人有了“火眼金睛“和“妙手回春“

NVIDIA联合多所高校开发的SpaceTools系统通过双重交互强化学习方法,让AI学会协调使用多种视觉工具进行复杂空间推理。该系统在空间理解基准测试中达到最先进性能,并在真实机器人操作中实现86%成功率,代表了AI从单一功能向工具协调专家的重要转变,为未来更智能实用的AI助手奠定基础。

Spotify年度盘点2025首次推出多人互动功能“盘点派对“

Spotify年度总结功能回归,在去年AI播客功能遭遇批评后,今年重新专注于用户数据深度分析。新版本引入近十项新功能,包括首个实时多人互动体验"Wrapped Party",最多可邀请9位好友比较听歌数据。此外还新增热门歌曲播放次数显示、互动歌曲测验、听歌年龄分析和听歌俱乐部等功能,让年度总结更具互动性和个性化体验。

机器人学会“三思而后行“:中科院团队让AI机器人告别行动失误

这项研究解决了现代智能机器人面临的"行动不稳定"问题,开发出名为TACO的决策优化系统。该系统让机器人在执行任务前生成多个候选方案,然后通过伪计数估计器选择最可靠的行动,就像为机器人配备智能顾问。实验显示,真实环境中机器人成功率平均提升16%,且系统可即插即用无需重新训练,为机器人智能化发展提供了新思路。