搞了半天原来GPT-4o-mini是基于GPT-3.5架构的模型(Dify中接入GPT-4o mini模型)

GPT-4o mini模型自己承认是基于GPT-3.5架构的模型,有图有真相:

一.GPT-4o mini官网简介

GPT-4o mini("o"代表"omni")是小型型号类别中最先进的型号,也是OpenAI迄今为止最便宜的型号。它是多模态的(接受文本或图像输入并输出文本),具有比 gpt-3.5-turbo 更高的智能,但速度同样快。它旨在用于较小的任务,包括视觉任务。建议在之前使用 gpt-3.5-turbo 的地方选择 gpt-4o-mini ,因为此模型功能更强大且更便宜。

| 模型 | 描述 | 上下文窗口 | 训练数据 |

|---|---|---|---|

| gpt-4o-mini | 新款 GPT-4o-mini经济实惠且智能的小型型号,适用于快速、轻量级的任务。 GPT-4o mini 比 GPT-3.5 Turbo 更便宜、功能更强大。当前指向 gpt-4o-mini-2024-07-18 。 | 128,000 tokens | Up to Oct 2023 |

| gpt-4o-mini-2024-07-18 | gpt-4o-mini 当前指向此版本。 | 128,000 tokens | Up to Oct 2023 |

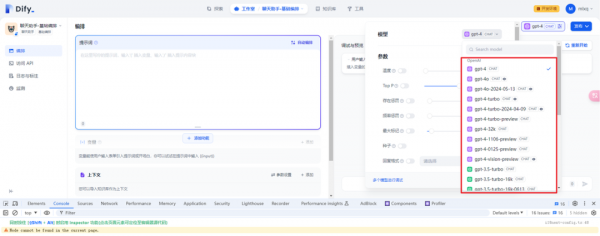

二.Dify中接入gpt-4o-mini

1.openrouter下的gpt-4o-mini配置

在Dify 0.6.14版本中没有包含gpt-4o-mini,因为当时还没发布。

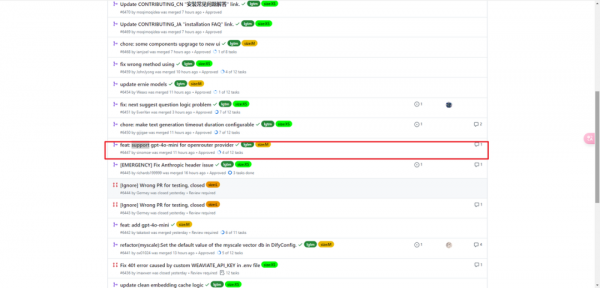

在Dify官方仓库发现已经有人提交了,不过看清楚是提交给openrouter供应商的。

2.openai下的gpt-4o-mini配置

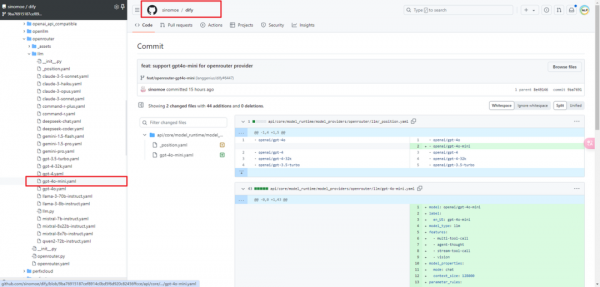

(1)_position.yaml文件

接下来修改下提交给openai供应商。主要是修改dify\api\core\model_runtime\model_providers\openai\llm\_position.yaml文件增加gpt-4o-mini如下:

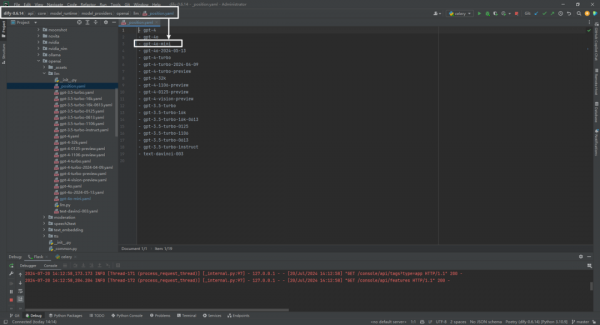

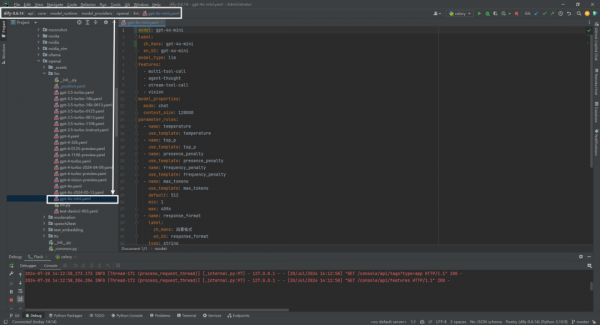

(2)gpt-4o-mini.yaml文件

然后在dify\api\core\model_runtime\model_providers\openai\llm目录增加gpt-4o-mini.yaml文件即可:

具体就不详细解释了,仿照gpt-4o.yaml写一个,主要是修改模型的名字,以及价格。

model: gpt-4o-mini

label:

zh_Hans: gpt-4o-mini

en_US: gpt-4o-mini

model_type: llm

features:

- multi-tool-call

- agent-thought

- stream-tool-call

- vision

model_properties:

mode: chat

context_size: 128000

parameter_rules:

- name: temperature

use_template: temperature

- name: top_p

use_template: top_p

- name: presence_penalty

use_template: presence_penalty

- name: frequency_penalty

use_template: frequency_penalty

- name: max_tokens

use_template: max_tokens

default: 512

min: 1

max: 4096

- name: response_format

label:

zh_Hans: 回复格式

en_US: response_format

type: string

help:

zh_Hans: 指定模型必须输出的格式

en_US: specifying the format that the model must output

required: false

options:

- text

- json_object

pricing:

input: "0.15"

output: "0.60"

unit: "0.000001"

currency: USD

3.模型供应商查看和对话测试

参考文献

[1] gpt-4o-mini.yaml:https://github.com/sinomoe/dify/commit/9ba76915187cef8914c0bd5f6d920c82456ffcce

[2] https://platform.openai.com/docs/models/gpt-4o-mini

好文章,需要你的鼓励

AI投资有望在2026年获得真正回报的原因解析

尽管全球企业AI投资在2024年达到2523亿美元,但MIT研究显示95%的企业仍未从生成式AI投资中获得回报。专家预测2026年将成为转折点,企业将从试点阶段转向实际部署。关键在于CEO精准识别高影响领域,推进AI代理技术应用,并加强员工AI能力培训。Forrester预测30%大型企业将实施强制AI培训,而Gartner预计到2028年15%日常工作决策将由AI自主完成。

清华团队让机器学会“透视眼“:用视频AI破解透明物体深度估计难题

清华团队开发DKT模型,利用视频扩散AI技术成功解决透明物体深度估计难题。该研究创建了首个透明物体视频数据集TransPhy3D,通过改造预训练视频生成模型,实现了准确的透明物体深度和法向量估计。在机器人抓取实验中,DKT将成功率提升至73%,为智能系统处理复杂视觉场景开辟新路径。

2026年软件定价大洗牌:IT领导者必须知道的关键变化

2026年软件行业将迎来定价模式的根本性变革,从传统按席位收费转向基于结果的付费模式。AI正在重塑整个软件经济学,企业IT预算的12-15%已投入AI领域。这一转变要求建立明确的成功衡量指标,如Zendesk以"自动化解决方案"为标准。未来将出现更精简的工程团队,80%的工程师需要为AI驱动的角色提升技能,同时需要重新设计软件开发和部署流程以适应AI优先的工作流程。

ByteDance推出全新混合专家模型训练法:让AI专家团队各司其职,大幅提升大语言模型性能

字节跳动研究团队提出了专家-路由器耦合损失方法,解决混合专家模型中路由器无法准确理解专家能力的问题。该方法通过让每个专家对其代表性任务产生最强响应,同时确保代表性任务在对应专家处获得最佳处理,建立了专家与路由器的紧密联系。实验表明该方法显著提升了从30亿到150亿参数模型的性能,训练开销仅增加0.2%-0.8%,为混合专家模型优化提供了高效实用的解决方案。