开源框架Ollama支持访问外部工具

开源框架Ollama,那个让你轻松在本地运行LLM的平台,现在增加了工具支持。换句话说,在Ollama的v0.3版本中,LLM可以访问各种工具,比如search API、网页浏览、代码解释器、计算器等外部功能。通过这些工具,Llama-3.1-405B模型能够更好地与Agentic AI系统结合,让系统功能更加丰富。

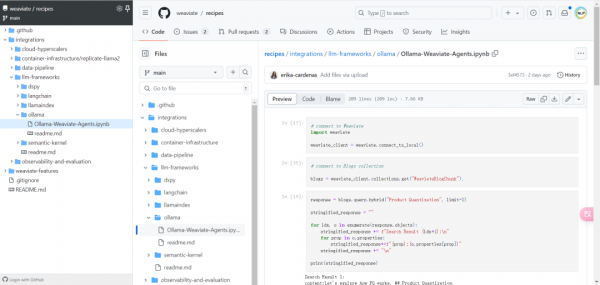

如果你想了解具体的操作方法,可以参考这个构建search Agent代码示例[3]。

参考文献:

[1] https://github.com/ollama/ollama

[2] https://ollama.com/

[3] https://github.com/weaviate/recipes/blob/main/integrations/llm-frameworks/ollama/Ollama-Weaviate-Agents.ipynb

好文章,需要你的鼓励

高带宽闪存面临工程难题,商业化还需数年时间

高带宽闪存技术承诺提供超大容量,但面临极其复杂的工程挑战。该技术将多层NAND芯片堆叠,每层由数百个3D NAND单元层组成,可创造前所未有的存储容量。相比昂贵的HBM内存,HBF使用更便宜但速度较慢的闪存为GPU提供更多存储空间。技术复杂性体现在互连布线的困难,12层HBF堆叠将包含2866个存储层。由于需要英伟达等GPU厂商深度参与和行业标准制定,预计HBF距离商用还需两年以上时间。

世界模拟新引擎:阿里巴巴达摩院发布Inferix,让AI像导演一样制作超长视频

阿里巴巴达摩院联合浙江大学、香港科技大学发布Inferix,这是专为世界模拟打造的下一代推理引擎。它采用块扩散技术,像搭积木般分段生成视频,既保证高质量又支持任意长度,克服了传统方法的局限。配套LV-Bench评测基准包含1000个长视频样本,建立了分钟级视频生成的评估标准,为游戏、教育、娱乐等领域的内容创作带来革命性突破。

戴尔Q3季度AI服务器收入破纪录,存储业务表现不佳

戴尔第三季度营收270亿美元,同比增长11%,创历史新高,主要受AI服务器需求爆发式增长推动。AI服务器订单达123亿美元,全年订单总额300亿美元。基础设施解决方案集团营收141亿美元,增长24%,其中服务器和网络业务表现强劲。存储业务营收39.8亿美元,同比下降1%,但全闪存阵列产品实现双位数增长。公司预计第四季度营收315亿美元,全年AI服务器出货量约250亿美元。

Luma AI推出终端速度匹配:一步生成高质量图像的革命性突破

Luma AI推出的终端速度匹配(TVM)是一种革命性的图像生成技术,能够在单次计算中生成高质量图像,突破了传统方法需要数十步采样的限制。该技术通过关注生成路径的"终点"而非"起点",实现了从噪声到图像的直接跳跃,在保证数学理论基础的同时大幅提升了生成效率,为实时AI应用开辟了新路径。