苹果的Camera Control,不止AI入口,要做人机“共生”

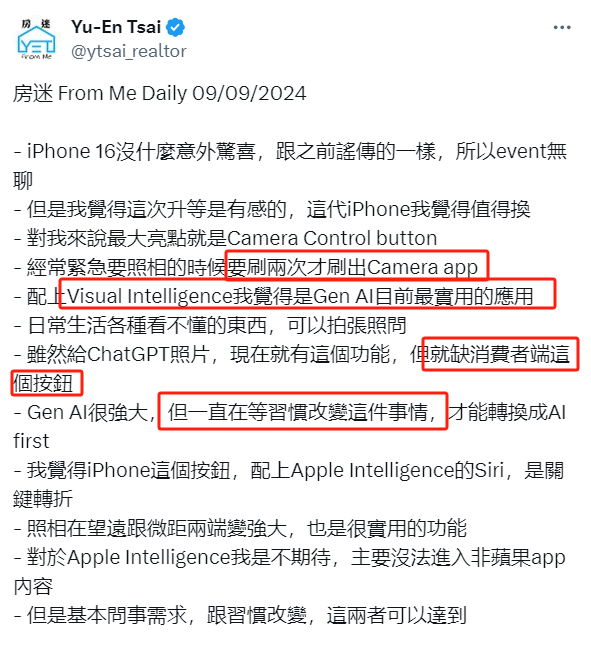

早起快速刷了一下苹果的发布会,发现大多数人的评论是:还好没看。其实一开始刷了一些资讯后,我也这么觉得,但是再仔细点一看,发现有些评论认为Camera Control是最重要的创新,但还没有一篇文章,完整的单独针对Camera Control,去好好的写一下思考,是的,翻遍了全网我都没找到,干脆自己快速码一篇。

我看到很有意思的一个讽刺贴是这样:

-May I take a picture of your dog?

-Sure.

-Siri, what kind of dog is this?

推特上有100万的阅读,对应的评论区还有一张图:

那这篇文章我会换个角度,经常尝试多从几个维度抛砖引玉:

-

Camera Control不是简单的按键 -

Visual intelligence整合后炸裂 -

和之前失败的TouchBar会不一样么? -

这些能力开放给第三方,加上App intent会怎样?

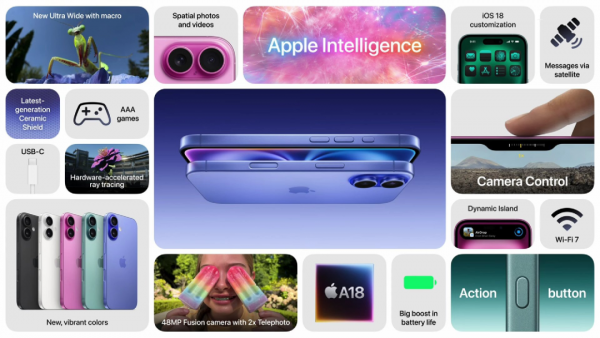

01 硬件设计

在上图中的C位,可以很明显的看到两个新iPhone里下面那台,在靠近左侧边框的位置有一个凹槽,这就是Camera Control的新按键,对于这个按键,其实拥有诸多的能力:

功能:

单击:打开相机应用或在已打开相机应用的情况下拍照。

点击并按住:开始录制视频。

轻按:这项功能将于2024年秋季晚些时候推出,可以锁定对焦和曝光在特定主体上。

双轻按:调出最小化相机预览菜单,用于选择不同的控制选项,如曝光或景深。

沿表面滑动:调节参数如缩放、曝光或景深。

设计和技术:相机控制按钮采用电容和压力感应技术,对基于触摸的手势反应灵敏。它被描述为一个触摸敏感按钮,甚至是一个微型触控板,允许进行各种交互,而不仅仅是按压。

也就是说,它的硬件设计是非常深度的,不是一个简单的按键。我们可以看一下:

这个按键的位置设计的还蛮好的,仿照的是数码单反相机上使用快门按钮的体验,它给人带来的惊喜可以看下面这个博主的评测:

02 整合Visual intelligence

这个按钮,更深层次是为了和视觉智能完成整合,达到人机“共生”。即:让手机摄像头最快捷的达到“所见即所得”,并让用户形成惯性。

发布会上苹果专门描述了Visual intelligence和Camera Control的整合,包含了这么几个场景:

进一步,苹果会开放这两个能力,给到第三方应用去做创新,再结合未来放到端侧的多个模型,还是非常值得期待的:

03 会和TouchBar一样失败么?

也有人拿它和TouchBar来对比,认为Camera Control失败的风险很大,这个点也挺有意思的,值得研究一下。

首先看TouchBar是什么:

Touch Bar 最早出现在 2016 年 10 月发布的第四代 Macbook Pro 上,全称 Multi-Touch Bar,中文名为“触控栏”。你可以理解为这是一块长条形的 OLED 屏幕, 除了固定的功能按键,还能自定义相关按键:

Touch Bar,是苹果历史上比较失败的设计,从出现到退场,仅仅 7 年。

失败的原因,事后来看,就是价值不大,那么小一块屏幕,能显示的内容有限,对应能适配的应用也更多只能是显示按钮,另外就是还需要用户改变自己的操作习惯,同时这些操作大部分又可以用键盘和鼠标代替。

我买的MBP是2015年的版本,恰好早了一代,当时看到2016款的TouchBar时还挺羡慕,但仔细想了想,就觉得意义不大,后面也没再关注了,没想到去年把它下掉了。

OK,说了这么多,其实总结来看,黄叔对于Camera Control是偏向于乐观的,因为相机拍照是个高频刚需场景,一个实体按键(入口)能大幅提高通向这个场景的使用概率,再叠加Visual intelligence,进一步的使用Camera Control去交互,这一点很厉害。

所以,单纯把Camera Control当成通向相机的入口,只是第一层,而把它作为通向视觉智能的入口,才是更深一层!

04 未来构想

对于未来,黄叔感觉最重要的还是用户习惯+AI的融合,在X上看到这条推觉得说的不错:

使用物理实体按键启动相机作为视觉多模态入口,一旦用户习惯之后,AI的整合会更加丝滑的嵌入到具体的场景里。

我们不要老指望着AGI,难道AGI没来之前就没法做AI落地了么?苹果在用户理解和场景结合,以及端云整个AI策略的思考上,非常值得我们关注。

结合之前发布会苹果说的“ App Intents”,以及“ Apple as they layer AI on top of the entire OS.”,对于明年AI在手机的落地,我比较乐观。

在新的硬件形态成熟之前,手机仍然会是用户的AI中心设备,以苹果对于生态的整合能力,以及较强的AI落地能力,厚积薄发是我形容它的一个关键词。

我也和一些AI从业者交流,部分朋友是非常兴奋的,更多信息就不放出来了,很期待和大家的更多私下交流呀!

好文章,需要你的鼓励

让AI记住房间每个角落:悉尼大学团队如何让视频生成拥有“空间记忆“

悉尼大学和微软研究院联合团队开发出名为Spatia的创新视频生成系统,通过维护3D点云"空间记忆"解决了AI视频生成中的长期一致性难题。该系统采用动静分离机制,将静态场景保存为持久记忆,同时生成动态内容,支持精确相机控制和交互式3D编辑,在多项基准测试中表现优异。

西班牙病毒如何将谷歌带到马拉加

33年后,贝尔纳多·金特罗决定寻找改变他人生的那个人——创造马拉加病毒的匿名程序员。这个相对无害的病毒激发了金特罗对网络安全的热情,促使他创立了VirusTotal公司,该公司于2012年被谷歌收购。这次收购将谷歌的欧洲网络安全中心带到了马拉加,使这座西班牙城市转变为科技中心。通过深入研究病毒代码和媒体寻人,金特罗最终发现病毒创造者是已故的安东尼奥·恩里克·阿斯托尔加。

马里兰大学突破性发现:AI推理过程终于有了“身体检查“——ThinkARM框架揭开大型语言模型思维奥秘

马里兰大学研究团队开发ThinkARM框架,首次系统分析AI推理过程。通过将思维分解为八种模式,发现AI存在三阶段推理节律,推理型与传统AI思维模式差异显著。研究揭示探索模式与正确性关联,不同效率优化方法对思维结构影响各异。这为AI系统诊断、改进提供新工具。