微信公众号悄悄上线AI音色克隆,微信的一小步,却是AI的一大步。

AI音频的东西,在收到一些身边亲近人的语音的时候会产生一些警惕,但是我们家里的老人呢?他们很多人对现在的AI并不是很了解,一旦AI音色克隆放开,很容易就是骗子拿着你4、5秒的音频去发给你的爷爷奶奶舅舅舅妈,骗取他们的信任。

可能你会发现,你听到的不再是那个永远跟其他人一样,相同的男声。

此时,微信可能会用我的声音,来为你朗读出这篇文章。

之所以,我一直在说可能,是因为我虽然在后台设置好了,但是只有这篇新发的文章,我才能知道,我的声音到底有没有生效。

不过,再怎么说,这都是微信的一小步,却是AI的一大步,真的。

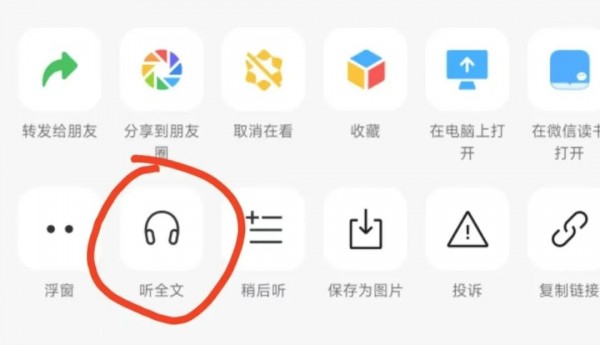

意外的发现公众号版本又更新了,更新到了2.29.1,当然版本号无所谓,重要的是,这个设置里面的新功能:朗读音色。

以前是绝对没有这个功能的,作为一个几乎以公众号为生的我,对公众号后台的一点点变动,都会非常的敏感。

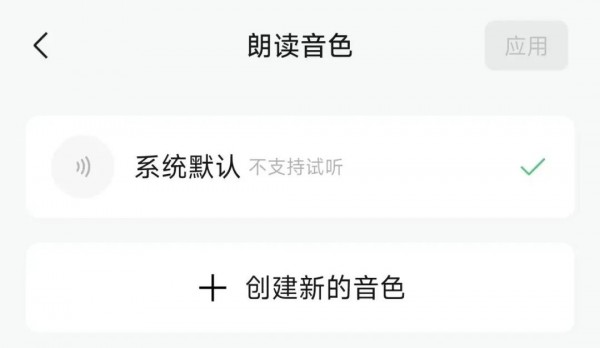

点开以后,会有一个系统默认的音色,你可以,创建自己的音色。

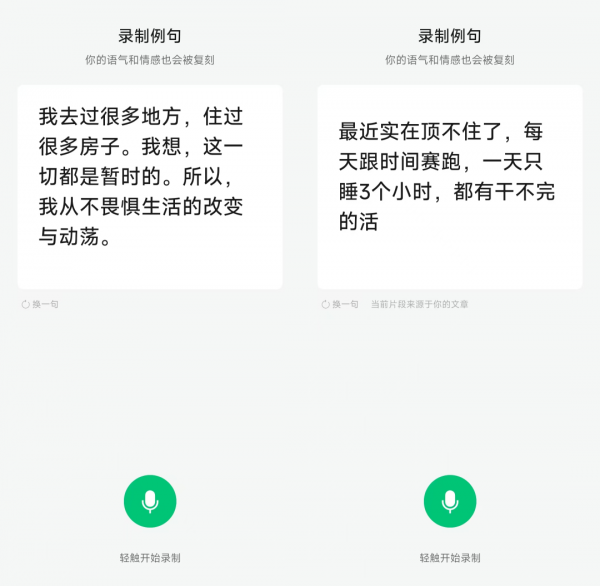

点击创建新的音色,就会进入到一个新页面,会让你现场朗读一句话。

甚至会从你的实际文章中,抽取一些片段,来让你读,非常的有意思。

这里我正好也解释一下,为啥现在微信、豆包、kimi等等产品,在做AI音色克隆的时候,都要让你现场读一段文本,再用这段音频去做音色克隆,而不是让你随便上传一段音频呢?

前段时间三只羊AI音频事件,还有AI雷军国庆节在微博上骂了7天等等,我想大家应该都能感受到,AI克隆音色这玩意一旦放开,会有多少跟诈骗相关的风险。

一旦放开,可以随便上传一段音频,最开心的不是你我他,而是骗子。

看我号的读者,应该尚且知道AI音频的东西,在收到一些身边亲近人的语音的时候会产生一些警惕,但是我们家里的老人呢?他们很多人对现在的AI并不是很了解,一旦AI音色克隆放开,很容易就是骗子拿着你4、5秒的音频去发给你的爷爷奶奶舅舅舅妈,骗取他们的信任。

且万一有一些人,如果真的石乐志,克隆一些官员的声音,那...后果基本不敢设想。

所以,现在基本清一色都是这种方式,让你用实时录制的方式,念出文本上的随机的话,还不能念错。

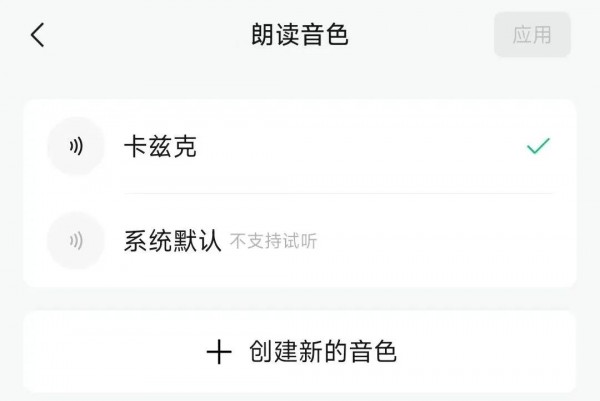

在你读完这段话后,就会嘟嘟嘟的进入克隆的步骤,速度很快,大概十几秒就能完全搞定。

音色基本很完美,跟我声音一样,情绪是TTS的老问题了,不说了,整体质听感上,是还算OK的。

我测试了一下,老的文章还是不会变的,可能只有新的文章,才能支持我的音色。

所以只有这篇发出来,我才能知道,我的音色,来听全文,到底是个什么感觉,以及,到底会不会用我的音色。。。

其实,我脑子里幻想过,公众号到底会怎么接入AI,来帮这个可能是最大的长图文平台赋能。

想过AI创作,想过AI起标题,想过AI搜索,想过AI总结,但是没想到的是,来的第一个,居然是AI音色克隆。

不过其实细想想,也合理。

公众号这个载体,我一直调侃说,我可能是最后给公众号送终的那一批人。

短视频俯瞰众生,短图文在侧不断侵蚀羽翼,身后还有播客虎视眈眈。

长图文,变的越来越像一个日落西山的老人,守着自己的一亩三分地,尽可能的给大家种出最好的果实。

而公众号,作为长图文领域无与伦比的王者,非常坦率的讲,一直有一个在我看来很大的问题,过往很难解决,就是IP化很难。

短视频为什么做一个人的IP,比公众号简单很多?是因为内容载体。

在公众号上,你看到的永远是冷冰冰的文字,即使作者把这段话,写的登峰造极,写的舌灿莲花,你能看到的也依然是文字,是神交。

而短视频呢?你看到的不是文字,是一个具象化的人,你知道他长什么样,哦这个人有点长的有点潦草头发看着总是好久不洗,哦还有一个人带着眼镜总是说话的时候张不开嘴。

而那些内容,更是他亲口念出来的,你看到所有的文字,不是冷冰冰的文字,而是他在读,你听到的除了信息,还有情绪,还有他的笑与泪。

这就是为啥,在短视频上做IP,要比公众号,简单的多。

而这一次更新,我觉得很有趣的一点是,微信公众号这一次的更新,他们把声音,给补上了。

在过往,我们用文字表达思想,用图片传递视觉,现在又多了一个维度,可以用我们自己的的声音来传递情感。

声音终于成为了我们这群做图文内容的人的有机组成部分,而不在只是,机械的朗读。

我乐意看到微信的每一次变化,特别是跟AI有关的更新。

AI,很多时候就像空气一样,只有当你感受不到它,觉得他是我们生活中理所应当的一部分,这时候,AI就算是真正的成功进入每个你我一样的普通人的生活中了。

微信,作为可能是我们国内,最大的超级APP,没有什么,比他跟AI的结合,影响范围更广了。

以后的某一天,可能所有的公众号,都有了自己的专属声音。

0赞

0赞好文章,需要你的鼓励

推荐文章

推荐文章

人工智能让影像生产方式被重塑,也让教育找到了新的路径。

北京大学团队开发的DragMesh系统通过简单拖拽操作实现3D物体的物理真实交互。该系统采用分工合作架构,结合语义理解、几何预测和动画生成三个模块,在保证运动精度的同时将计算开销降至现有方法的五分之一。系统支持实时交互,无需重新训练即可处理新物体,为虚拟现实和游戏开发提供了高效解决方案。

AI硬件的竞争才刚刚开始,华硕Ascent GX10这样将专业级算力带入桌面级设备的尝试,或许正在改写个人AI开发的游戏规则。

达尔豪斯大学研究团队系统性批判了当前AI多智能体模拟的静态框架局限,提出以"动态场景演化、智能体-环境共同演化、生成式智能体架构"为核心的开放式模拟范式。该研究突破传统任务导向模式,强调AI智能体应具备自主探索、社会学习和环境重塑能力,为政策制定、教育创新和社会治理提供前所未有的模拟工具。