Harbor:一站式管理本地AI环境

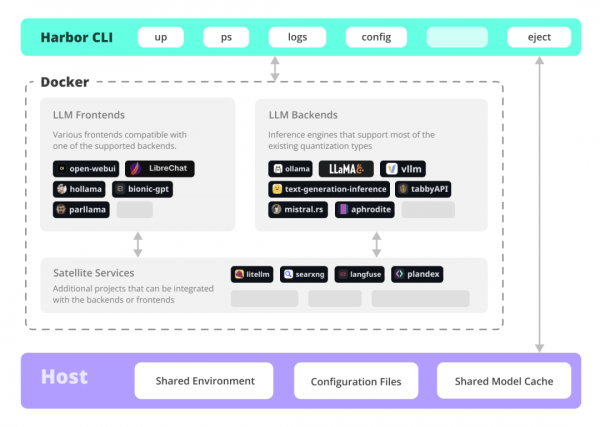

只需一行命令,就能运行包括LLM后端、API、前端在内的所有AI服务。Harbor是一个容器化的LLM工具集,它通过CLI命令行工具和配套应用,让管理AI服务变得轻而易举。

为什么选择Harbor?

- 极致便利:告别繁琐配置,一键启动所有服务

- 统一工作流:集中管理各类AI组件,告别切换之苦

- 灵活扩展:既可作为实验环境快速上手,也能根据需求定制专属配置

丰富的生态系统

- 用户界面

从轻量级的Open WebUI到功能完整的ComfyUI、LibreChat等,满足不同场景需求 - 核心引擎

集成Ollama、llama.cpp、vLLM等主流LLM引擎,性能与易用性兼具 - 配套工具

提供从性能测试(Harbor Bench)到搜索引擎(SearXNG),再到工作流自动化(n8n)的全方位支持

核心特性

- 简洁CLI:通过命令行轻松管理整个LLM技术栈

- 便捷工具:内置模型管理、配置调试、URL管理等常用功能

- 即插即用:服务间预配置协同,开箱即用

- 资源共享:统一管理缓存资源,提升使用效率

- 配置灵活:支持多场景配置文件切换

- 平滑迁移:可随时通过“harbor eject”导出独立配置

对于熟悉Docker和Linux的开发者来说,Harbor或许不是必需品。但如果你想快速搭建一个功能完整的本地LLM环境,Harbor无疑是最佳选择——它不仅提供了完整的基础设施,更打造了一个可持续发展的生态系统。

参考文献:

[1] GitHub:https://github.com/av/harbor

好文章,需要你的鼓励

埃森哲投资Profitmind,押注AI智能体变革零售业

埃森哲投资AI零售平台Profitmind,该平台通过智能代理自动化定价决策、库存管理和规划。研究显示AI驱动了2025年假日购物季20%的消费,约2620亿美元。部署AI代理的企业假日销售同比增长6.2%,而未部署的仅增长3.9%。Profitmind实时监控竞争对手价格和营销策略,并可创建生成式引擎优化产品文案。

上海AI实验室让机器人“睁眼看世界“:用视觉身份提示技术让机械臂学会多角度观察

上海AI实验室联合团队开发RoboVIP系统,通过视觉身份提示技术解决机器人训练数据稀缺问题。该系统能生成多视角、时间连贯的机器人操作视频,利用夹爪状态信号精确识别交互物体,构建百万级视觉身份数据库。实验显示,RoboVIP显著提升机器人在复杂环境中的操作成功率,为机器人智能化发展提供重要技术突破。

CES 2026:日立与英伟达、谷歌云、Nozomi Networks达成合作协议

日立公司在CES 2026技术展上宣布了重新定义人工智能未来的"里程碑式"战略,将AI直接应用于关键物理基础设施。该公司与英伟达、谷歌云建立重要合作伙伴关系,并扩展其数字资产管理平台HMAX,旨在将AI引入社会基础设施,变革能源、交通和工业基础设施领域。日立强调其独特地位,能够将AI集成到直接影响社会的系统中,解决可持续发展、安全和效率方面的紧迫挑战。

英伟达团队突破AI训练瓶颈:让机器人同时学会多种技能不再“顾此失彼“

英伟达研究团队提出GDPO方法,解决AI多目标训练中的"奖励信号坍缩"问题。该方法通过分别评估各技能再综合考量,避免了传统GRPO方法简单相加导致的信息丢失。在工具调用、数学推理、代码编程三大场景测试中,GDPO均显著优于传统方法,准确率提升最高达6.3%,且训练过程更稳定。该技术已开源并支持主流AI框架。