2024深度洞察:AI服务器与AI PC的风云变幻

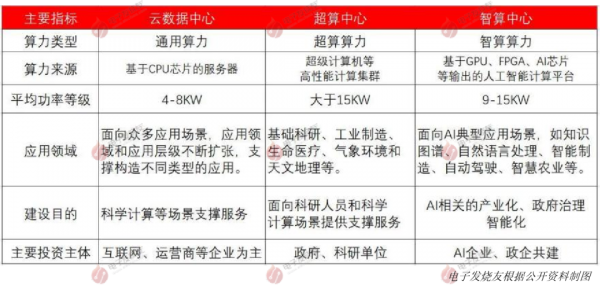

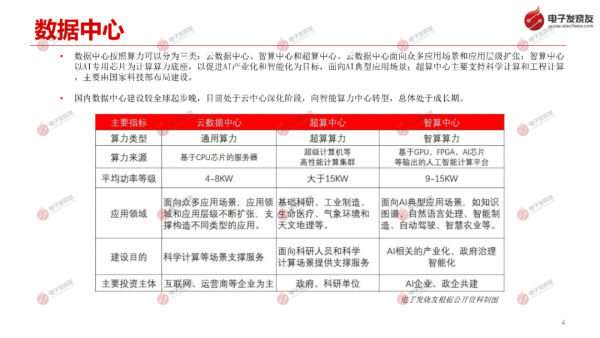

数据中心按照算力可以分为三类:云数据中心、智算中心和超算中心。云数据中心面向众多应用场景和应用层级扩张;智算中心 以AI专用芯片为计算算力底座,以促进AI产业化和智能化为目标,面向AI典型应用场景;超算中心主要支持科学计算和工程计算 ,主要由国家科技部布局建设。

国内数据中心建设较全球起步晚,目前处于云中心深化阶段,向智能算力中心转型,总体处于成长期。

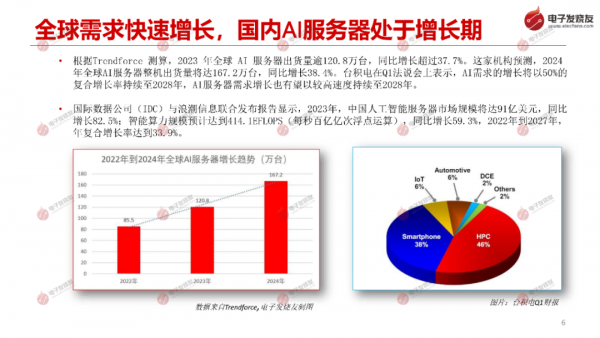

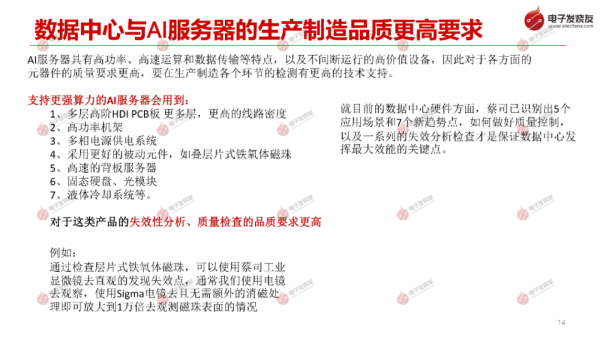

根据Trendforce 测算, 2023 年全球 AI 服务器出货量逾120.8万台,同比增长超过37.7%。这家机构预测, 2024 年全球AI服务器整机出货量将达167.2万台,同比增长38.4%。台积电在Q1法说会上表示,AI需求的增长将以50%的 复合增长率持续至2028年,AI服务器需求增长也有望以较高速度持续至2028年。

2023年,中国人工智能服务器市场规模将达91亿美元, 同比 增长82.5%;智能算力规模预计达到414.1EFLOPS (每秒百亿亿次浮点运算),同比增长59.3%,2022年到2027年, 年复合增长率达到33.9%。

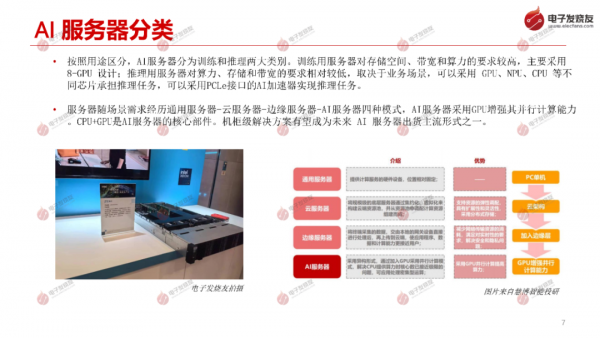

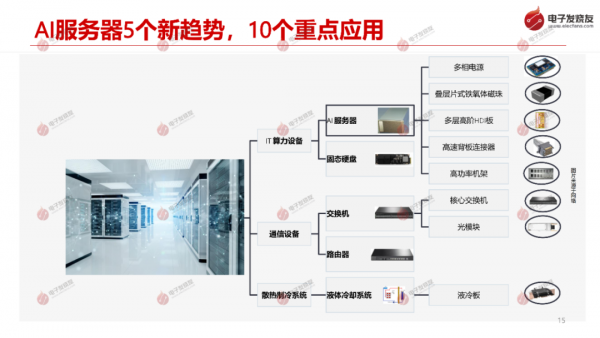

按照用途区分, AI服务器分为训练和推理两大类别。训练用服务器对存储空间、带宽和算力的要求较高, 主要采用8-GPU 设计;推理用服务器对算力、存储和带宽的要求相对较低,取决于业务场景, 可以采用 GPU、NPU、CPU 等不 同芯片承担推理任务,可以采用PCLe接口的AI加速器实现推理任务。

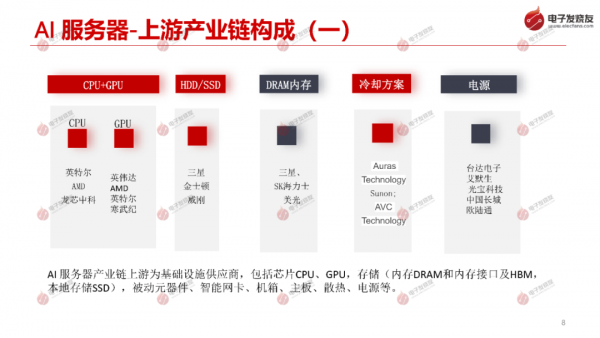

服务器随场景需求经历通用服务器-云服务器-边缘服务器-AI服务器四种模式,AI服务器采用GPU增强其并行计算能力。CPU+GPU是AI服务器的核心部件。机柜级解决方案有望成为未来 AI 服务器出货主流形式之一。

好文章,需要你的鼓励

WordPress实验性AI开发工具Telex已投入实际应用

WordPress实验性AI开发工具Telex在9月发布几个月后已投入实际使用。在"State of the Word"年度活动中,WordPress联合创始人展示了Telex的多个应用案例,包括创建价格比较工具、价格计算器和实时营业时间显示等功能。该工具能够生成Gutenberg模块,让开发者在几秒内完成过去需要数千美元定制开发的功能。同时WordPress还推出了Abilities API等AI架构开发。

突破性AI助手:Skywork-R1V4让机器像侦探一样“看图说话“还能上网搜证据

昆仑万维Skywork AI团队开发的Skywork-R1V4是一款突破性的多模态AI助手,能够像侦探一样主动分析图像、上网搜索信息并将两种能力无缝结合。该系统仅通过3万个高质量样本的监督学习就实现了卓越性能,在多项测试中超越了更大规模的商业模型,证明了精妙设计比单纯扩大规模更重要,为AI助手的实用化发展指明了高效路径。

英国NCSC与BT联手阻止10亿次网络威胁攻击

英国国家网络安全中心与BT合作推出的Share and Defend服务成功拦截了近十亿次早期网络攻击和用户访问危险网站的尝试。该服务整合多方威胁情报数据,通过互联网服务商的DNS平台实时过滤恶意网站,大规模阻断钓鱼和虚假购物网站。目前已有TalkTalk、沃达丰等多家合作伙伴加入,政府计划在2026年1月发布国家网络行动计划以进一步提升英国网络安全防护能力。

香港科大最新突破:让AI看图像重建3D世界的速度飞起来了

香港科技大学研究团队开发出FlashVGGT技术,通过创新的"压缩代表"策略和分块递归推理机制,将3D重建速度提升10倍以上,能处理超过3000张图像的超长序列。该技术在保持重建质量的同时显著降低计算复杂度,为VR游戏、建筑测量、自动驾驶等领域提供更实用的3D重建解决方案。