北航联合美团提出LLaVA-ST!细粒度时空多模态理解的MLLM!

论文名:LLaVA-ST:AMultimodalLarge Language Model for Fine-Grained Spatial-Temporal Understanding

论文链接:https://arxiv.org/pdf/2501.08282

开源代码:https://github.com/appletea233/LLaVA-ST

导读

多模态大型语言模型(MLLMs)最近在多模态理解方面取得了显著进展,展示了强大的视觉理解能力。除了生成关于视觉内容的纯语言响应外,一些MLLMs还承担了更复杂的挑战——特别是理解和输出事件或视觉实体的坐标,例如时间视频定位(TVG)和指代表达理解(REC)。在本文中,我们将需要基于语言输入处理视觉坐标的任务称为细粒度多模态理解。对于这些任务,当前的MLLMs主要集中在两个方面:有的模型擅长图像中物体的空间定位,但在细粒度时间理解任务上表现不佳;有的模型专门擅长像TVG这样的细粒度时间理解,但无法确定物体的边界框。现有的MLLMs无法统一实现空间、时间和交错的细粒度多模态理解任务。

简介

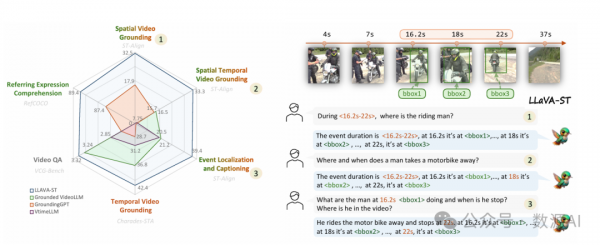

我们提出了LLaVA-ST,一种用于细粒度时空多模态理解的MLLM。在LLaVA-ST中,我们提出了语言对齐的位置嵌入,将文本坐标特殊标记嵌入到视觉空间中,简化了细粒度时空对应关系的对齐。此外,我们设计了时空打包器,将时间和空间分辨率的特征压缩解耦为两个独立的点到区域注意力处理流。此外,我们提出了ST-Align数据集,包含个训练样本,用于细粒度时空多模态理解。通过ST-align,我们提出了一个渐进式训练管道,通过从粗到细的顺序阶段对齐视觉和文本特征。此外,我们引入了ST-Align基准来评估时空交错的细粒度理解任务,包括时空视频定位(STVG)、事件定位和描述(ELC)以及空间视频定位(SVG)。LLaVA-ST在需要细粒度时间、空间或时空交错多模态理解的11个基准上取得了出色的表现。

方法与模型

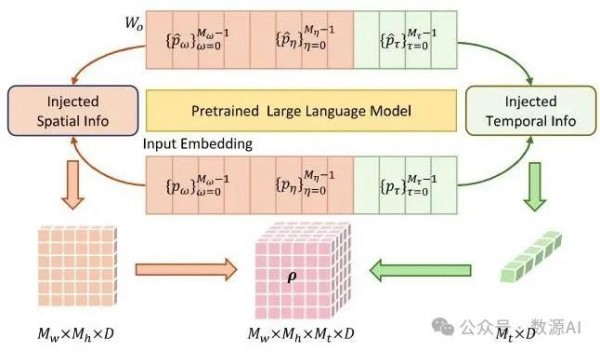

1. 概述

我们的LLaVA-ST的整体架构如图2所示,其中视频和图像都可以被处理。对于由帧组成的视频,我们以等间隔采样帧。对于图像输入,设置为1。

视觉编码器 然后依次从每个采样帧中提取特征。这些特征使用多层感知器(MLP)映射到文本空间:

其中 、 和 表示空间分辨率 的输出。随后,我们使用语言对齐位置嵌入(LAPE)将语言坐标特征 叠加到 中:

对于图像输入,生成的 可以直接展平并输入到大型语言模型中进行处理。对于视频,我们利用时空打包器(STP)分别沿时间和空间维度压缩特征:

然后 和 被展平并输入到大型语言模型 [57] 中。大型语言模型将利用视觉特征和语言嵌入以统一的方式处理细粒度的多模态理解任务。我们在 § 和 § 中详细阐述了LAPE和STP模块。

2. 语言对齐位置嵌入

为了避免对数字文本进行标记化的低效性,我们通过引入坐标的特殊标记来扩展大型语言模型的词汇表。这些特殊标记被合并到大型语言模型的输入文本嵌入和输出层中。然后,我们将空间标记嵌入到视觉特征中作为位置嵌入,如图3所示。

图3. LAPE的详细信息。LAPE利用与坐标相关的输入文本嵌入和输出层矩阵中的特征作为视觉位置嵌入。

特殊标记的定义。具体来说,我们将时间维度均匀地划分为 个段,得到 个锚点。时间戳 由最接近其时间位置的第 个锚点表示,并编码为 。这导致沿时间轴有 个特殊标记。类似地,我们将视频的宽度 和高度 分别划分为 和 个相等的部分,从而在空间维度上获得 个特殊标记。对于空间坐标 (w, h),它们对应的特殊标记是 。

特殊标记的输入/输出。为了将这些特殊标记直接整合到大型语言模型中,我们扩展了大型语言模型中的原始输入文本嵌入,使得每个特殊标记都被编码为单独的单词嵌入。 和 的文本输入嵌入分别表示为 和 。同样地,我们还扩展了大型语言模型最后一层的参数矩阵,以支持坐标特殊标记。大型语言模型的输出层为:

其中 是参数, 是语言的词汇量, 是文本特征, 是预测的下一个单词的概率。因此,在此过程中,模型基本上计算了 与 的行向量之间的余弦相似度。当余弦相似度高时,模型输出该特定单词的概率相应增加。因此, 中的行向量也可以作为相应单词的有效表示。设 、 和 分别表示 中对应于 和 的行向量。

视觉位置嵌入。以前的方法 [58, 61] 主要隐式地训练特殊标记。然而,当涉及到细粒度的空间和时间理解时,由于坐标组合的扩大,训练映射到相应空间或时间坐标的特定标记是具有挑战性的。通过将特殊标记用作视觉特征的位置嵌入,文本坐标表示与视觉坐标对齐的难度显著降低。 和 在微调中随机初始化,因此两者都需要与视觉特征的坐标对齐。我们同时使用 和 来构建位置嵌入:

其中 和 表示 中位置 的向量。由于 的形状与 的形状不同,我们采用线性插值对 进行下采样以匹配 的形状,得到 。由于图像输入不需要考虑时间关系,我们仅对 进行下采样以构建 ,作为 的位置嵌入。此外,下采样过程促进了大型语言模型内特殊标记嵌入之间的信息传递,从而促进了收敛。

3. 时空打包器

在 STP 中,我们通过两步过程压缩视频特征。第一步,我们降低 的空间分辨率以获得 ,从而减少后续过程的计算负担。第二步,我们分别沿 的空间和时间维度进行压缩,分别获得 和 。

在第一步中,我们沿空间维度将 分割为 个补丁,并将它们调整为一系列区域特征 。然后,我们在 的每个补丁内执行平均池化,以获得点特征序列 。为了将 注入 的详细信息,我们将 作为查询,并将 中相应的 区域特征作为键和值来执行注意力机制,从而获得分辨率降低的特征 。我们将上述过程表示为:

与通过池化直接降低空间分辨率相比,点对区域注意力机制更好地保留了细粒度信息,从而增强了模型定位时空坐标的能力。在第二步中,我们采用与第一阶段类似的压缩方法,分别沿时间和空间维度压缩特征。对于沿空间维度的压缩,我们应用:

其中 。对于时间维度,我们沿时间维度将 分割为 个补丁,并采用与 中相同的池化和注意力策略。此过程产生时间维度降低的特征 :

其中 。大型语言模型将把扁平化的 和 作为输入。

ST-Align 和训练策略

在本节中,我们介绍了 ST-Align,这是一个为时空细粒度多模态理解设计的 MLLM 训练数据集,并详细介绍了基于 ST-Align 的 LLaVA-ST 的具体渐进训练策略。

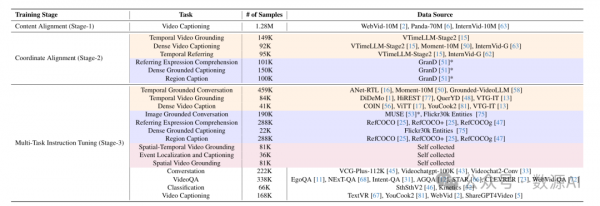

1. ST-Align

为了训练 LLaVA-ST,我们提出了 ST-Align,它包含大约 430 万个训练样本,如表 1 所示。为了解决当前涉及时空交错细粒度多模态理解的数据不足问题,我们使用 GPT-4-turbo 来修订和增强 VidSTG [80] 的文本注释,使其适用于以下三个任务:i) 时空视频定位 (STVG):根据事件描述定位视频中事件主题的时空管。ii) 事件定位和描述 (ELC):给定事件主题的起始位置和边界框,定位事件的结束位置并提供事件的描述。iii) 空间视频定位 (SVG):基于事件持续时间和文本描述,定位事件主题的轨迹。此外,我们为每个任务提供了 2,000 个验证样本,以评估 MLLM 的细粒度时空理解能力。

2. 训练策略

为了提高训练过程的稳定性并改善模型的最终性能,我们根据数据质量和视觉-文本对齐的粒度将训练数据分为三个阶段。如表1所示,这些阶段包括:内容对齐、坐标对齐和多任务指令微调。

S1. 内容对齐。我们在此阶段利用视频字幕数据 [2, 6, 62] 初步实现 STP 模块输出中的视觉与语言内容对齐。在此过程中,我们固定大型语言模型的参数,仅训练 STP 内的参数。由于缺乏细粒度的多模态理解数据,我们将 设置为 0 以最小化干扰。STP 的学习率为 。

S2. 坐标对齐。在训练的第二阶段,我们利用需要细粒度视觉理解的任务,使模型能够在视觉和文本空间之间对齐时空坐标。在此阶段,数据主要由通过自动生成方法构建的细粒度多模态理解数据集组成。对于涉及细粒度空间理解的任务,我们基于 GranD [51] 数据集引入了三种任务——REC、DGC 和 RC——来训练空间位置嵌入的对齐,总共生成 个数据样本。同时,对于视频中的时间细粒度理解,我们引入了三种任务——TVG [15]、DVC [15, 50, 63] 和 TR [15, 62]——以沿时间维度对齐坐标,总共生成 个数据样本。在此阶段,我们对 STP 应用 的学习率,并使用 LoRA [14] 以相同的学习率训练大型语言模型的主网络。

S3. 多任务指令微调。在第三阶段,我们引入了 39 个高质量标注数据集,以赋予模型视觉问答和细粒度多模态理解的通用能力。我们结合了空间和时间细粒度理解任务以及文本响应任务,如 REC、TVG 和视频问答,如表 1 所示。此外,我们还结合了涉及时空交错细粒度理解的数据,即 STVG、ELC 和 SVG。我们在阶段 2 模型的基础上添加了新的 LoRA 参数,同时采用与阶段 2 相同的训练策略。

实验与结果

1. 实现细节

我们使用 SigLIP-400M [78] 作为 ,分辨率为 384。预训练模型为 Llava-onevision 7B [28]。 为 100。 为 为 3, 为 为 100。 为 27, 为 27。训练批次大小在阶段 1 为 384,阶段 2 和阶段 3 为 192。我们在 ST-Align 上训练了 1 个 epoch。LoRA [14] 的 和 分别为 128 和 256。我们使用 48 个 A100 在 72 小时内训练了 LLaVA-ST。我们使用 AdamW [39] 作为优化器,采用余弦学习率衰减和预热期。

2. 主要比较

在以下部分中,我们对 LLaVA-ST 进行了全面的实验分析。LLaVA-ST 在 12 个不同多模态理解能力的基准测试中表现出色。需要注意的是,我们在不同基准测试中的所有测试结果都是通过修改提示词使用同一模型获得的。

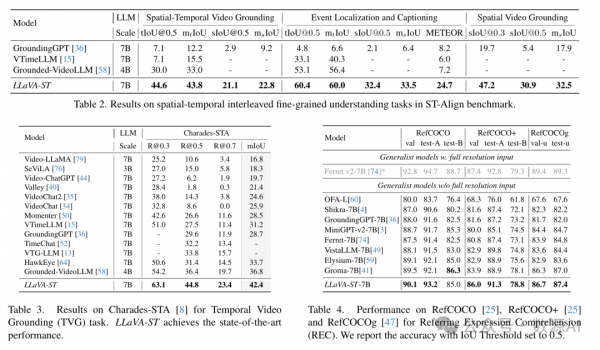

时空交错任务。与之前的MLLMs不同,LLaVA-ST可以端到端处理时空交错任务。基于ST-Align基准(如§中详述),我们在STVG、ELC和SVG三个任务上评估LLaVA-ST。我们基于GroundingGPT [36]构建了相应的基线,采用两阶段方法来完成这些任务。此外,我们在ST-Align基准上评估了Grounded-VideoLLM [58]和VTimeLLM [15],重点关注与时间定位和语言生成相关的指标。LLaVA- 在这些任务上相比之前的方法表现出显著的改进。在STVG任务中,它在 IoU上达到了43.8,比Grounded-VideoLLM [58]高出10.8,并在上达到了22.8,比GroundingGPT [36]高出13.6。在ELC任务中,改进了,并且METEOR比其他模型的最佳表现分别提高了27.3、19.7和18.7。具体来说,在SVG任务中,它比GroundingGPT [36]提高了 14.6。LLaVA-ST对时空交错细粒度理解任务的端到端处理能力在推理速度和准确性方面提供了显著优势。

时间视频定位(TVG)。如表3所示,我们在Charades-STA [8]基准上验证了LLaVA-ST的TVG能力。在TVG任务中,目标是根据语言描述定位视频中事件的开始和结束时间戳。LLaVA-ST优于之前的MLLMs,Grounded-VideoLLM [58],在mIoU上提高了6.9。这一结果表明MLLM具有强大的时间定位能力。

指代表达理解(REC)。我们在标准REC数据集上评估了LLaVA-ST的细粒度空间理解能力,即RefCOCO [25]、RefCOCO+ [25]和RefCOCOg [47]。与之前没有全分辨率图像输入的最先进模型Groma-7B [41]相比,LLaVA-ST在相同模型大小下实现了更高的准确性。值得注意的是,在Ref-COCO+ [25]数据集上,LLaVA-ST在验证集上提高了2.1%,在测试集A上提高了2.4%。这表明LLaVA-ST具有强大的细粒度空间理解能力。此外,它还表明LLM可以同时处理两种不同结构的视觉特征,和。

开放式视频问答。LLaVA-ST在开放式视频问答任务中取得了令人满意的结果,该任务要求模型根据视频内容生成开放式回答。具体来说,它在VCG-Bench [44]数据集上获得了最高的平均分3.32,并在MSVD-QA [69]和MSRVTT-QA [69]基准上表现出色。这些发现表明,LLaVA- 对各种细粒度多模态理解任务的支持并不影响其在通用多模态问答任务中的表现。

多选视频问答。我们还使用MVBench [35]验证了LLaVA-ST在多选视频问答中的表现。与之前的方法相比,LLaVA- 达到了当前最佳的平均分,比之前的模型提高了4.8分。LLaVA-ST相比之前的方法表现出显著的改进。此外,在需要高时空细节信息描述的任务中,如AA(动作反义词)、OE(对象存在)和MA(移动属性),LLaVA-ST相比之前的MLLMs取得了显著改进。

总结

在本文中,我们提出了LLaVA-ST,一个能够同时处理时间和空间维度的细粒度多模态理解任务的模型。在模型架构方面,我们引入了LAPE,它将文本空间中的坐标特殊标记显式嵌入到视觉特征中作为位置嵌入。此外,我们提出了STP,它采用点对区域注意力机制分别压缩时间和空间分辨率。为了帮助未来的MLLMs提高其在细粒度多模态理解中的能力,我们提出了一个名为ST-Align的数据集,并提出了一种渐进式训练策略,依次学习内容对齐、坐标对齐和多任务能力。实验结果表明,LLaVA-ST在多个基准测试中表现出强大的细粒度理解能力。此外,消融实验证实了我们模型中每个模块的有效性,并展示了在提出的ST-Align方法中引入细粒度时空交错数据的优势。

好文章,需要你的鼓励

让AI记住房间每个角落:悉尼大学团队如何让视频生成拥有“空间记忆“

悉尼大学和微软研究院联合团队开发出名为Spatia的创新视频生成系统,通过维护3D点云"空间记忆"解决了AI视频生成中的长期一致性难题。该系统采用动静分离机制,将静态场景保存为持久记忆,同时生成动态内容,支持精确相机控制和交互式3D编辑,在多项基准测试中表现优异。

西班牙病毒如何将谷歌带到马拉加

33年后,贝尔纳多·金特罗决定寻找改变他人生的那个人——创造马拉加病毒的匿名程序员。这个相对无害的病毒激发了金特罗对网络安全的热情,促使他创立了VirusTotal公司,该公司于2012年被谷歌收购。这次收购将谷歌的欧洲网络安全中心带到了马拉加,使这座西班牙城市转变为科技中心。通过深入研究病毒代码和媒体寻人,金特罗最终发现病毒创造者是已故的安东尼奥·恩里克·阿斯托尔加。

马里兰大学突破性发现:AI推理过程终于有了“身体检查“——ThinkARM框架揭开大型语言模型思维奥秘

马里兰大学研究团队开发ThinkARM框架,首次系统分析AI推理过程。通过将思维分解为八种模式,发现AI存在三阶段推理节律,推理型与传统AI思维模式差异显著。研究揭示探索模式与正确性关联,不同效率优化方法对思维结构影响各异。这为AI系统诊断、改进提供新工具。