Mistral AI开源120亿参数的Mistral NeMo,Mistral 7B模型的继任者!免费开源!中文能力大幅增强!

本文原文来自DataLearnerAI官方网站:

https://www.datalearner.com/blog/1051721328234545

在人工智能领域,Mistral与NVIDIA的合作带来了一个引人注目的新型大模型——Mistral NeMo。这个拥有120亿参数的模型不仅性能卓越,还为AI的普及和应用创新铺平了道路。MistralAI官方博客介绍说该模型是此前开源的Mistral 7B模型的继承者,因此未来可能7B不会再继续演进了!

Mistral NeMo另一个最大的特点是大幅提高了多语言能力,特别是中文的支持大幅提高。虽然此前Mistral AI开源了很多模型,但是中文表现都很一般。而Mistral NeMo则在中文水平大幅提升。

-

Mistral NeMo简介

-

Mistral NeMo的评测结果

-

Mistral NeMo多语言支持包含中文!

-

Mistral NeMo技术简介

-

Mistral NeMo兼容此前的Mistral 7B模型

-

Mistral NeMo是完全开源的模型

Mistral NeMo简介

Mistral NeMo最令人瞩目的特点之一是其超长的上下文窗口,能够处理高达128k tokens的输入文本,这使得模型在理解复杂场景和长文本处理上具有显著优势,为多轮对话提供了更广阔的应用空间。

在同等规模的模型中,Mistral NeMo在推理能力、世界知识的掌握以及编程准确性方面都达到了顶尖水平,这使其在解决复杂问题和生成高质量代码等多种应用场景中表现出色。

Mistral NeMo的评测结果

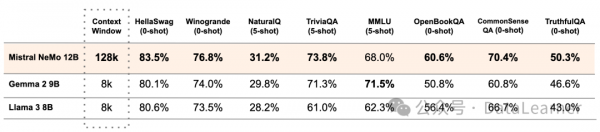

下图是Mistral NeMo与其它模型评测结果的对比:

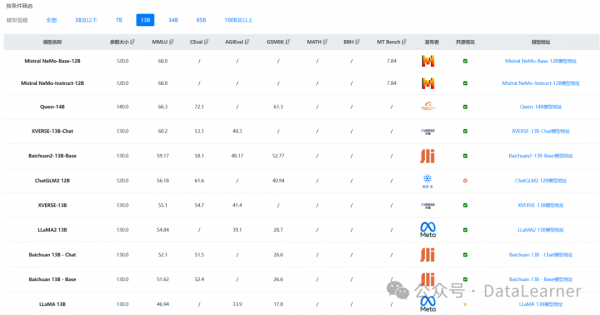

从上面可以看到,尽管综合理解能力(MMLU)上Mistral NeMo模型表现一般,但是在数学推理任务上表现很亮眼!

根据DataLearnerAI收集的大模型评测结果,新开源的Mistral NeMo模型在130亿参数规模的模型上评测非常优秀,MMLU评测得分第一。

鉴于此前MistralAI开源的模型的良好口碑,这样的成绩下Mistral NeMo的能力非常值得期待。

Mistral NeMo多语言支持包含中文!

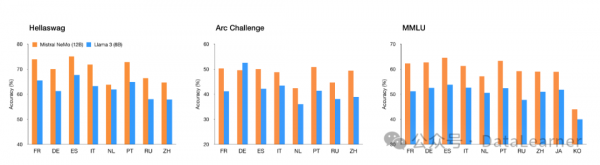

此前MistralAI开源的Mixtral MoE以及Mixtral 7B都是不支持中文,或者中文非常弱。此次官方宣称对中文的支持说明这方面能力已经达到一定水平了。下图是Mistral NeMo在多语言上的评测结果,显著超过了Llama3-8B。

Mistral NeMo技术简介

尽管没有很详细的描述,但是官方还是透露了一些技术细节,Mistral NeMo采用了基于Tiktoken开发的新分词器Tekken,在多种自然语言和源代码的处理上表现卓越,其文本压缩效率比传统分词器高出约30%,显著提升了模型的效率和性能。

Mistral NeMo在遵循精确指令、推理、处理多轮对话和生成代码等方面都表现出显著进步,不仅能理解用户需求,还能更准确地完成各种复杂任务。

Mistral NeMo兼容此前的Mistral 7B模型

为了降低企业和开发者的门槛,Mistral采用了标准架构,可以轻松替代任何使用Mistral 7B的系统。模型权重已在HuggingFace上公开,并配有推理和微调工具,而NVIDIA则将其作为NIM推理微服务容器提供,进一步简化了部署和使用过程。

Mistral NeMo是完全开源的模型

Mistral选择开源友好策略,通过Apache 2.0许可证发布模型的预训练和指令微调检查点,极大推动了学术界和产业界对该模型的采用与创新。

Mistral NeMo模型的开源地址参考DataLearnerAI的模型信息卡:https://www.datalearner.com/ai-models/pretrained-models/Mistral-NeMo-Base-12B

来源:DataLearner

好文章,需要你的鼓励

2025年企业网络安全指南:构建数字时代防护体系

随着数字化时代的到来,网络安全威胁呈指数级增长。勒索软件、AI驱动的网络攻击和物联网设备漏洞成为主要威胁。企业需要建立全面的风险管理策略,包括风险评估、安全措施实施和持续监控。新兴技术如人工智能、区块链和量子计算为网络安全带来新机遇。组织应重视员工培训、供应链安全、数据治理和事件响应能力建设。

滑铁卢大学研究团队突破性发明:让AI像真正的学者一样写论文和找文献

滑铁卢大学研究团队开发出ScholarCopilot,一个革命性的AI学术写作助手。该系统突破传统"先检索后生成"模式,实现写作过程中的动态文献检索和精确引用。基于50万篇arXiv论文训练,引用准确率达40.1%,大幅超越现有方法。在人类专家评估中,引用质量获100%好评,整体表现优于ChatGPT。这项创新为AI辅助学术写作开辟新道路。

AWS Bedrock负责人Atul Deo:更便宜AI与新型智能体的未来之路

AWS Amazon Bedrock负责人Atul Deo正致力于让人工智能软件变得更便宜和更智能。他在12月re:Invent大会前只有六个月时间来证明这一目标的可行性。Deo表示AI领域发展速度前所未有,模型每几周就会改进,但客户只有在经济效益合理时才会部署。为此,AWS推出了提示缓存、智能路由、批处理模式等功能来降低推理成本,同时开发能执行多步骤任务的自主代理软件,将AI应用从聊天机器人转向实际业务流程自动化。

哥伦比亚大学发布革命性AI检索技术:用“异构图“重新定义智能问答系统

哥伦比亚大学研究团队发布NodeRAG技术,通过异构图结构革新智能问答系统。该方法将文档信息分解为7种节点类型,采用双重搜索机制,在多个权威测试中准确率达89.5%,检索效率提升50%以上,为智能信息检索技术带来重大突破。