成本大降, OpenAI小型模型GPT-4o mini

GPT-4o mini输入价格为15美分/百万Tokens,输出价格为60美分/百万Tokens。而曾被视为OpenAI内部最轻量级且高性价比的GPT-3.5 Turbo,其输入价格为50美分/百万Tokens,输出价格为150美分/百万Tokens。

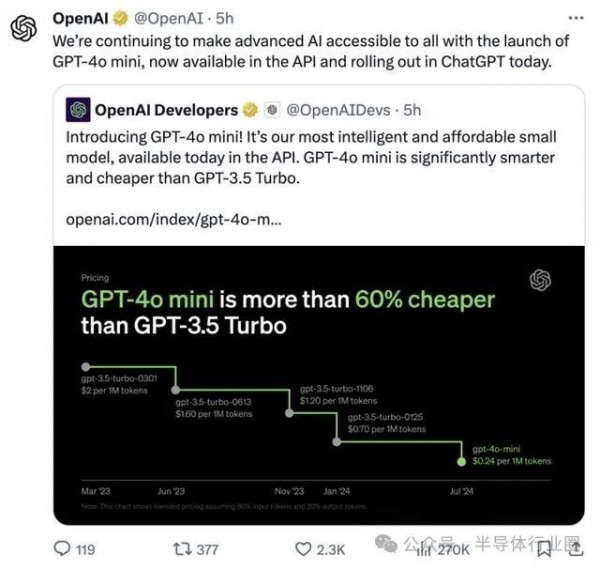

7月19日消息, OpenAI宣布推出GPT-4o mini模型,并称其为最智能、最实惠的模型,其性能和价格均已赶超GPT-3.5 Turbo。

作为直观对比,GPT-4o mini输入价格为15美分/百万Tokens,输出价格为60美分/百万Tokens。而曾被视为OpenAI内部最轻量级且高性价比的GPT-3.5 Turbo,其输入价格为50美分/百万Tokens,输出价格为150美分/百万Tokens。

最新的“GPT-4o mini”比GPT-4o便宜了96%~97%,比起GPT-3.5 Turbo也要便宜60%~70%。正因如此,随着GPT-4o mini上架,GPT-3.5 Turbo的历史使命到此结束。OpenAI还表示,GPT-4o mini是首个使用其全新安全策略“指令层级”的AI模型。

此前,一些没有足够资金的开发者可能对GPT高昂的价格望而却步,转而选择更便宜的模型,例如谷歌的 Gemini 1.5 Flash 或 Anthropic 的 Claude 3 Haiku来构建应用程序。而现在,OpenAI 也正式进入了轻量级模型的市场。

性能方面,目前GPT-4o Mini支持文本和视觉输入,未来将扩展至音视频。它拥有128K上下文窗口,每次请求最多可输出16K标记,知识库更新至2023年10月。而且由于与GPT-4o共享改进的分词器,使其处理非英语文本的成本效益更高。

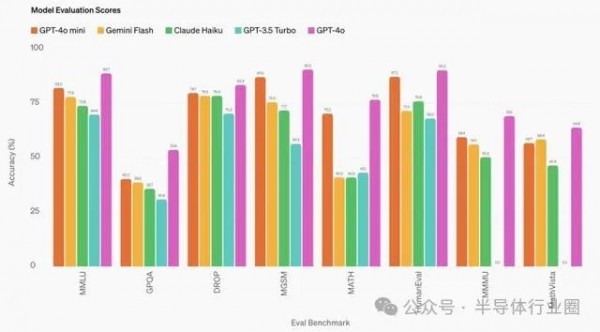

根据OpenAI官方介绍,GPT-4o mini在学术测试中表现优异,超越了GPT-3.5 Turbo等小型模型。它在文本智能、多模态推理和语言支持方面水平与GPT-4o相当。在函数调用方面表现突出,有助于开发者创建能与外部系统交互的应用。此外还显著提升了长上下文处理能力,优于GPT-3.5 Turbo。

GPT-4o mini的高性能来源于GPT-4o,这是OpenAI目前最快、最强大的旗舰大模型。OpenAI在5月的一次直播活动中发布了GPT-4o,“o”代表omni(全能的),寓意了该模型对多模态的注重。彼时,团队表示GPT-4o对音频、视频和文本等多模态理解与生成功能进行了改进,能够以更高的速度和质量处理50种不同的语言。

目前,GPT-4o mini API接口已开放,支持文本和视觉,未来还将融入文本、图像、视频和音频的输入和输出。它将于当地时间周四向ChatGPT的免费用户、ChatGPT Plus和团队订阅者开放,ChatGPT企业用户将于下周开放。

0赞

0赞好文章,需要你的鼓励

推荐文章

推荐文章

国际能源署发布的2025年世界能源展望报告显示,全球AI竞赛推动创纪录的石油、天然气、煤炭和核能消耗,加剧地缘政治紧张局势和气候危机。数据中心用电量预计到2035年将增长三倍,全球数据中心投资预计2025年达5800亿美元,超过全球石油供应投资的5400亿美元。报告呼吁采取新方法实现2050年净零排放目标。

维吉尼亚理工学院研究团队对58个大语言模型在单细胞生物学领域的应用进行了全面调查,将模型分为基础、文本桥接、空间多模态、表观遗传和智能代理五大类,涵盖细胞注释、轨迹预测、药物反应等八项核心任务。研究基于40多个公开数据集,建立了包含生物学理解、可解释性等十个维度的评估体系,为这个快速发展的交叉领域提供了首个系统性分析框架。

AMD首席执行官苏姿丰在纽约金融分析师日活动中表示,公司已准备好迎接AI浪潮并获得传统企业计算市场更多份额。AMD预计未来3-5年数据中心AI收入复合年增长率将超过80%,服务器CPU收入份额超过50%。公司2025年预期收入约340亿美元,其中数据中心业务160亿美元。MI400系列GPU采用2纳米工艺,Helios机架系统将提供强劲算力支持。

西湖大学王欢教授团队联合国际研究机构,针对AI推理模型内存消耗过大的问题,开发了RLKV技术框架。该技术通过强化学习识别推理模型中的关键"推理头",实现20-50%的内存缩减同时保持推理性能。研究发现推理头与检索头功能不同,前者负责维持逻辑连贯性。实验验证了技术在多个数学推理和编程任务中的有效性,为推理模型的大规模应用提供了现实可行的解决方案。