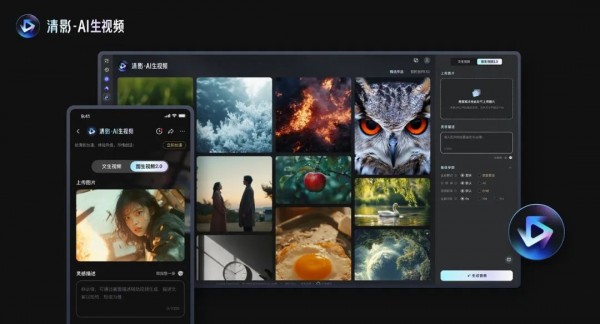

智谱AI上线4K60帧"新清影",还要直接开源,我觉得他们疯了。

就在刚刚,智谱宣布全新迭代的AI视频模型“新清影”,正式上线。

10s、4k、60帧,还能自带生成挺匹配的AI音效。

视频模型已经上线智谱清言上,人人可用。音效模型这个月也即将上线。

这个点,其实还好,就是线上模型迭代升级了一版而已。

但是最牛逼的是,他们直接宣布,把这个“新清影”背后的底层模型,也就是CogVideoX v1.5,直接开源了。。。

我觉得他们疯了,真的。

上上周发类似GPT4o那种端到端的语音对话模型也是,直接发布即开源。

真的,智谱给我整不会了。

周二才夸过腾讯混元,开源了他们参数最大的MoE模型混元Large和AI 3D模型Hunyuan3D-1.0。

现在智谱直接接力,直接开源了他们内部效果最好的AI视频模型。

还是那句话,对于每一个愿意开源,让社会、让开源社区,百尺竿头更进一步的公司。我都永远报以最崇高的敬意,和最大的善意。

CogVideoX v1.5我也第一时间去测试了一下。

开源地址在此:https://github.com/thudm/cogvideo

普通用户也可以去智谱清影上玩。

我放一些我自己跑的case吧。

非常坦率的讲,智谱的新清影,跟上一代比,已经进步巨大了。

不管是审美、还是动作幅度、还是物理规律、还是稳定程度。

真的,上一代的人物变形变得我到现在都还记忆犹新。

但是如果你要把他跟业界最好的比,比如你跟豆包PixelDance比分镜比运镜,那肯定还是差了一定距离的。

毕竟这一版的新清影,在版本号上,还是一个折中的阶段,也就是CogVideoX v1.5,而且他们进步速度还是飞快的。

当时8月也是第一个把生视频全面公开让c端来玩的,说实话也勇气可嘉。

而且我问了一下内部人,参数量更大更新更强的模型正在训练,如果等过两个月CogVideoX v2.0阶段,可能又会来一波进化的飞跃。

当然,不管怎么样,智谱敢把新清影发布即开源,就凭这点,我赞智谱一声勇士。

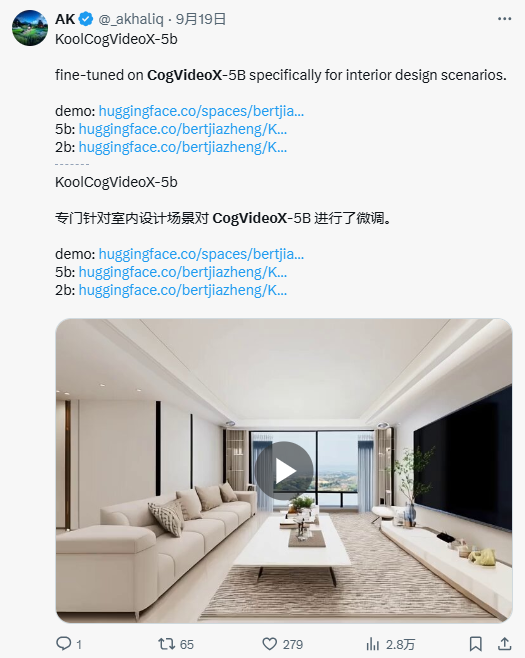

上一次他们开源CogVideoX,直接给开源社区贡献了一波大力。

一群老外直接玩的飞起。

比如微调一个自己的视频模型。

比如微调一个室内设计的专属视频模型。

等等等等。

AI绘图的开源生态已经被玩出花了,但是AI视频的生态,确实还是非常的贫瘠,不管是配套插件,还是微调方式,还是模型数量等等,都还远远处于起步阶段。

希望这一波新清影CogVideoX v1.5的开源,能让AI视频的开源社区和生态,继续沸腾一次。

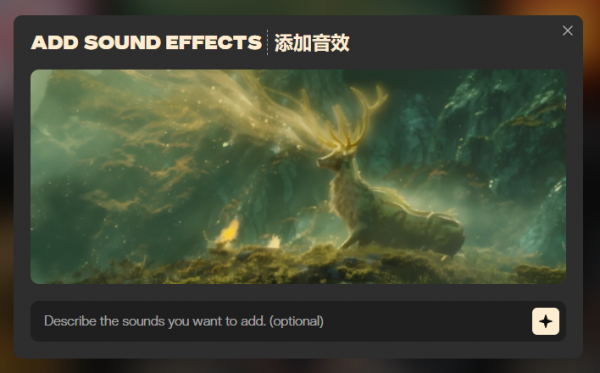

除了CogVideoX v1.5的开源之外,还有另一个东西我觉得非常值得说,虽然它还没有上线,但是在这次的demo里一窥了真容。

就是智谱的AI音效模型。

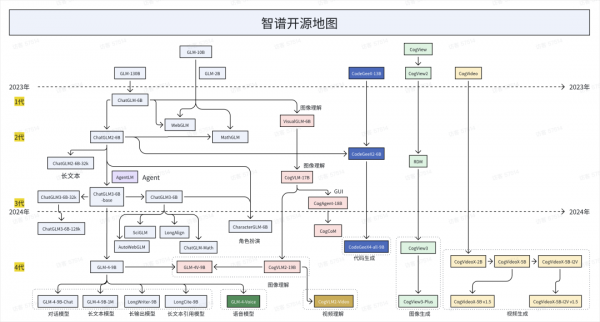

智谱可能是我知道的,唯一一个,什么模态都做的,关键,每个模特居然做的都还不错。

我真的,尊称一声模型法王。

给你们数一下。

好文章,需要你的鼓励

让AI记住房间每个角落:悉尼大学团队如何让视频生成拥有“空间记忆“

悉尼大学和微软研究院联合团队开发出名为Spatia的创新视频生成系统,通过维护3D点云"空间记忆"解决了AI视频生成中的长期一致性难题。该系统采用动静分离机制,将静态场景保存为持久记忆,同时生成动态内容,支持精确相机控制和交互式3D编辑,在多项基准测试中表现优异。

西班牙病毒如何将谷歌带到马拉加

33年后,贝尔纳多·金特罗决定寻找改变他人生的那个人——创造马拉加病毒的匿名程序员。这个相对无害的病毒激发了金特罗对网络安全的热情,促使他创立了VirusTotal公司,该公司于2012年被谷歌收购。这次收购将谷歌的欧洲网络安全中心带到了马拉加,使这座西班牙城市转变为科技中心。通过深入研究病毒代码和媒体寻人,金特罗最终发现病毒创造者是已故的安东尼奥·恩里克·阿斯托尔加。

马里兰大学突破性发现:AI推理过程终于有了“身体检查“——ThinkARM框架揭开大型语言模型思维奥秘

马里兰大学研究团队开发ThinkARM框架,首次系统分析AI推理过程。通过将思维分解为八种模式,发现AI存在三阶段推理节律,推理型与传统AI思维模式差异显著。研究揭示探索模式与正确性关联,不同效率优化方法对思维结构影响各异。这为AI系统诊断、改进提供新工具。