一文读懂 NVIDIA GPU 产品线

—01 —

如何挑选适合的数据中心 GPU?

在人工智能领域,特别是生成式人工智能工作负载和机器学习模型推理方面,拥有强大且经济高效的硬件解决方案是每个从业者的共同追求。

然而,数据中心级 GPU 的选型并非像在商店里随意性挑选电子产品那样简单明了——后者通常只有少数几个配置选项和清晰的升级路径可供选择。相反,GPU 的选择更类似于购买汽车:我们的预算、具体应用场景以及对性能的需求将在众多具有不同功能、价格和市场可用性的车型和年份中引导我们的最终决策。

为了帮助大家更好地应对这一挑战,本文将首先深入解析 NVIDIA 数据中心级 GPU 的命名规则,帮助大家快速识别一款显卡的底层架构和性能层级。NVIDIA 的命名体系通常采用字母数字组合的形式,这些看似复杂的代码实际上蕴含着关于 GPU 核心架构、显存容量、计算能力等关键技术规格的重要信息。掌握这些命名规则,是进行有效选型的基础。

在此基础上,本文还将提供一系列清晰且直接的方法,用于对不同 GPU 的性能进行客观比较。我们将从浮点运算能力、内存带宽、互联技术等多个维度进行剖析,并提供一个包含多款常用于模型训练、微调和模型服务的数据中心级 GPU 的关键技术规格对比表格。通过本文的解析,大家将能够根据自身的实际需求,在众多 NVIDIA GPU 产品中做出明智的选择,从而构建高效且经济的 AI 计算平台。

—02 —

GPU 命名规则解读

企业生产级或数据中心级 GPU 的命名规则乍看之下可能较为复杂,例如 K80、T4、A100、L40 等名称,初学者往往难以理解其含义。然而,这些看似随机的字母和数字组合并非随意排列,而是经过精心设计的,它们实际上编码了关于 GPU 架构、性能参数和关键技术规格的重要信息。

NVIDIA 数据中心 GPU 的命名规则通常包含以下几个维度的信息:

1、字母:或称之为“架构代号(Architecture)”代表 GPU 的核心架构,通常用一个或多个字母表示,代表 GPU 的微架构。例如:

- K:Kepler 架构

- T:Turing 架构

- A:Ampere 架构

- H:Hopper 架构

- L: Ada Lovelace 架构

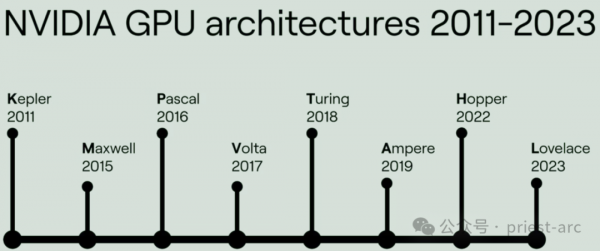

在 NVIDIA GPU 的命名体系中,首字母通常代表该 GPU 采用的微架构。微架构是 GPU 芯片设计的核心,决定了其基本的运算方式、指令集以及内部结构。每隔几年,NVIDIA 都会针对其消费级和数据中心产品线推出全新的微架构,以实现性能和能效比的显著提升。

图:NVIDIA GPU 架构发展历程

从本质上来讲,每个新的架构通常代表着性能、能效比和新技术的显著提升。GPU 的微架构是影响其性能和功能的最关键因素之一。不同的架构在设计理念、内部结构和支持的技术特性上可能存在显著差异。

例如,某些架构可能更侧重于通用计算性能,而另一些架构则可能针对特定的工作负载(例如深度学习、图形渲染)进行优化。因此,理解 GPU 的架构对于选择合适的硬件至关重要。

2、性能层级(Tier): 通常用数字表示,数字越大通常代表性能越强。

在同一微架构下,NVIDIA 会根据不同的市场定位和应用需求,推出多款不同性能层级的 GPU 产品,以满足各种计算负载的需求。这些不同的层级通常通过数字来区分,数字越大,代表该 GPU 的性能越强、价格越高,通常也意味着更高的功耗。

不同层级的 GPU 针对不同的计算负载进行了优化,以下是近年来一些常见层级的特点和应用场景:

(1) “4” 系列:入门级或低功耗级

“4” 系列 GPU 通常是同代产品中体积最小、功耗最低的型号,其设计目标是在有限的功耗预算下提供足够的计算性能。这类 GPU 适合对性能要求不高、注重成本效益的应用场景,例如:

- 轻量级的模型推理任务,例如图像分类、自然语言处理等。

- 边缘计算设备或低功耗服务器。

- 对成本敏感的应用部署。

(2)“10” 系列:中端推理优化级

“10” 系列 GPU 通常是针对人工智能推理应用进行优化的中端产品。它们在性能、功耗和成本之间取得了较好的平衡,适合需要较高推理吞吐量和较低延迟的应用场景,例如:

- 大规模的在线推理服务。

- 视频分析和图像处理。

- 实时语音识别和翻译。

(3)“40” 系列:高端图形和虚拟工作站级

“40” 系列 GPU 通常是面向专业图形应用和虚拟工作站的高端产品。它们拥有强大的图形渲染能力和计算性能,适合对图形处理和计算性能要求较高的应用场景,例如:

- 专业级图形设计和渲染。

- 高性能计算可视化。

- 虚拟桌面基础设施 (VDI)。

(4)“100” 系列:旗舰级高性能计算和人工智能级

“100” 系列 GPU 是同代产品中性能最强、价格最高的旗舰级产品。它们拥有最多的内核数量、最大的显存容量和最高的内存带宽,专为处理最 demanding 的计算负载而设计,例如:

- 大规模的模型训练和微调。

- 高性能科学计算和模拟。

- 超大规模数据中心部署。

3、其他标识符: 有时还会包含其他字母或数字,用于表示特定的变体、配置或目标应用场景。例如:

- T4 中的 "4" 可能暗示其定位是推理(Inference)应用。

- 某些针对特定工作负载优化的 GPU 可能会带有后缀。

在实际的业务场景中,理解 NVIDIA GPU 的性能层级对于根据自身需求选择合适的硬件至关重要。错误地选择过高或过低的层级都可能导致资源浪费或性能瓶颈。

例如,如果只需要进行简单的模型推理,选择 “100” 系列的 GPU 显然是过度投资;而如果需要进行大规模的模型训练,选择 “4” 系列的 GPU 则无法满足性能需求。

—03 —

常见的GPU 型号对比解析:基于 GPU 命名推断显卡特性

结合前文所述的架构代号(字母)和性能层级(数字)这两个关键因素,我们可以通过 GPU 名称中的字母和数字组合来推断出关于该显卡的一些重要信息,从而更好地进行选型。以下通过几个具体的示例进行说明:

示例一:T4 与 L4 的比较

L4 是 T4 的直接后继者,属于同一性能层级,针对相似的应用场景设计。然而,两者在微架构和技术规格上存在显著差异:

- 微架构: L4 采用更新的 Ada Lovelace 架构(2023 年发布),而 T4 则采用较早的 Turing 架构(2018 年发布)。

- 显存容量: L4 配备了更大的显存容量,达到 24 GB,而 T4 仅有 16 GB。

- 核心数量和性能: L4 拥有更多且更强大的计算核心,因此在性能上优于 T4。

虽然两者的目标功耗相似,但 L4 凭借更先进的架构和更高的显存容量,在相同的功耗下能够提供更强的计算性能,更适合处理对显存容量有较高要求的任务。

示例二:A10 与 A100 的比较

A100 是基于 Ampere 架构的旗舰级产品,而 A10 则是该架构下的一个较低层级的型号。两者都基于相同的 Ampere 微架构,但在规模和性能上存在显著差异:

- 核心数量和性能: A100 拥有远多于 A10 的计算核心,因此在计算性能上远超 A10。

- 显存容量: A100 配备了更大的显存容量,以支持更大规模的模型训练和推理。

- 功耗: 由于规模更大、性能更强,A100 的功耗也高于 A10。

因此,A100 更适合需要处理大规模模型训练、微调和高吞吐量推理等 demanding 计算任务的场景,而 A10 则更适合对成本和功耗敏感、对性能要求相对较低的应用场景。

示例三:K80 与 T4 的比较

比较不同架构和不同层级的 GPU 通常较为复杂。K80 采用了相对古老的 Kepler 架构(发布于十多年前),而 T4 则采用了更现代的 Turing 架构。

虽然 K80 拥有双 GPU 芯片,但由于架构的落后,其性能和能效比远不及 T4。因此,对于大多数现代机器学习任务而言,T4 不仅速度更快,而且由于功耗更低,每分钟运行成本也更低。这个例子也说明了架构的重要性,即使核心数量更多,落后的架构也可能导致性能不如新架构。

示例四:T4 与 A10 的模型服务能力比较

T4 和 A10 都属于针对推理优化的 GPU,但由于性能层级的不同,它们在模型服务能力上也存在差异。T4 适合服务中等规模的模型,例如图像分类、目标检测等。而 A10 则拥有更强的计算能力和更大的显存容量,可以服务更大规模的模型,例如大型语言模型 (LLM) 的推理。

通过以上示例,我们可以看到,结合 GPU 名称中的字母(架构)和数字(层级),可以有效地推断出该 GPU 的一些关键特性,并根据自身的需求选择合适的硬件。理解这些命名规则,有助于更好地理解 NVIDIA 的 GPU 产品线,并做出明智的购买决策。

通过以上更详细的解释和示例,大家可以更深入地理解如何根据 GPU 名称进行选型,并了解到不同架构和层级 GPU 之间的差异。

Happy Coding ~

Reference :

[1] https://www.nvidia.com/en-us/data-center/data-center-gpus/

好文章,需要你的鼓励

DeepSeek 的 AI 突破预示着数据中心的重大变革

DeepSeek 的 AI 模型在处理效率方面取得重大突破,可能对数据中心产生深远影响。尽管引发了科技股抛售,但业内专家认为,这项创新将推动 AI 应用普及,促进大规模和分布式数据中心基础设施需求增长。更高效的 AI 算法有望降低成本、扩大应用范围,从而加速数据中心行业发展。

Rivian 计划与特斯拉展开竞争:推进 L3 级自动驾驶和语音 AI 技术

Rivian 正全面推进 AI 技术整合,开发下一代电动车平台,以挑战特斯拉的市场地位。公司计划于 2025 年实现免手驾驶,2026 年达到 L3 级自动驾驶。Rivian 还将在车载系统中广泛应用 AI 技术,提供语音交互等功能,并计划推出更实惠的车型,扩大市场份额。

Postman 发布基于 API 优先的 AI 代理构建器

Postman 发布了 AI 代理构建器,这是一款创新的生成式 AI 工具。它允许开发者通过整合大语言模型、API 和工作流程来设计、构建、测试和部署智能代理。这一工具旨在简化 API 交互、优化工作流程,并支持创建能执行复杂任务的智能代理,标志着 API 优先的 AI 开发迈出了重要一步。

Microsoft 的 AI 营收增长,但因指引下调和支出问题股价下跌

微软第二财季利润同比增长10%,人工智能年化收入达130亿美元。然而,云计算业务未达预期,下季度指引不及预期,导致盘后股价下跌。公司资本支出创新高,以满足AI和云需求。尽管Azure增长放缓,但微软对下半年增速加快持乐观态度。同时,中国AI初创公司DeepSeek的崛起引发业界对AI基础设施投资的重新审视。