商汤推出“日日新”融合大模型,勇夺“双冠王”

商汤“日日新”融合大模型性能上文理兼修,在SuperCLUE年度评测中,文科成绩以81.8分位列全球第一,超越OpenAI的o1模型;理科成绩夺得金牌,其中计算维度以78.2分位列国内第一。

今年大模型还要如何进化,还有怎样的想象空间?

刚刚,商汤正式推出“日日新”融合大模型,领先实现原生融合模态,深度推理能力与多模态信息处理能力均大幅提升,并在两大权威评测榜单夺得第一,成为“双冠王”。

国内权威大模型测评机构SuperCLUE最新发布的《中文大模型基准测评2024年度报告》:商汤“日日新”融合大模型以总分68.3的优异成绩,与 DeepSeek V3 一起并列国内榜首,成为年度第一。

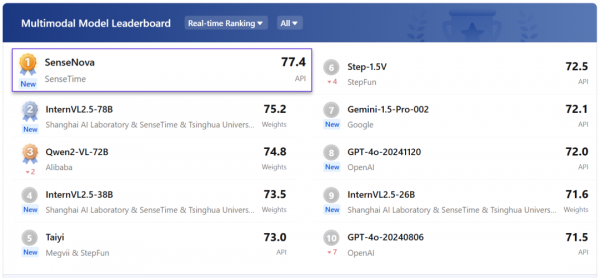

在近期另一个权威综合评测机构OpenCompass的多模态评测中,商汤以同一款模型同样取得了榜单第一,分数大幅领先GPT-4o。

“一个模型、双料冠军”,意味着商汤科技率先在原生融合模态训练取得实质性突破,这将引领业界从大语言模型和多模态大模型分立的普遍现状,走向真正意义的模型一统。

商汤“日日新”突破了模态融合的技术,跨越了模态之间的鸿沟,就为深度推理能力和多模态信息的结合铺平了道路。

商汤“日日新”融合大模型性能上文理兼修,在SuperCLUE年度评测中,文科成绩以81.8分位列全球第一,超越OpenAI的o1模型;理科成绩夺得金牌,其中计算维度以78.2分位列国内第一。

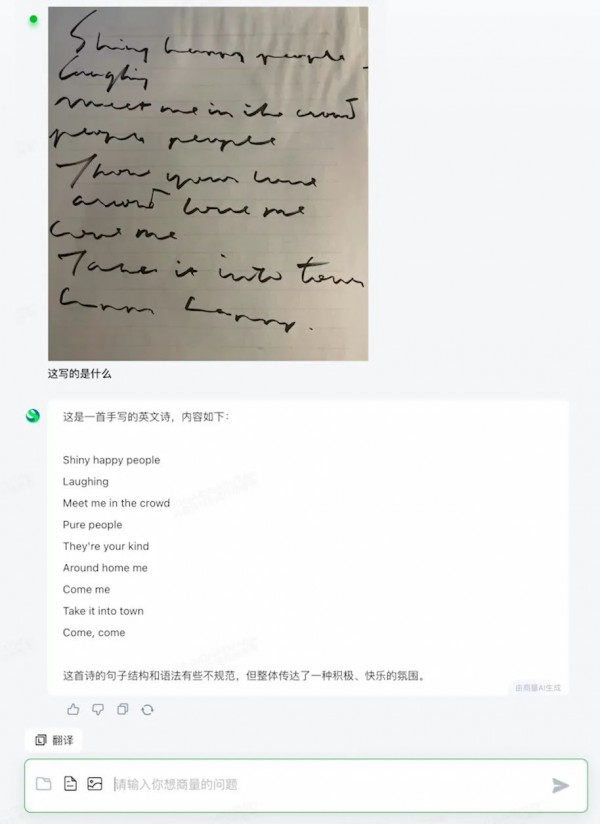

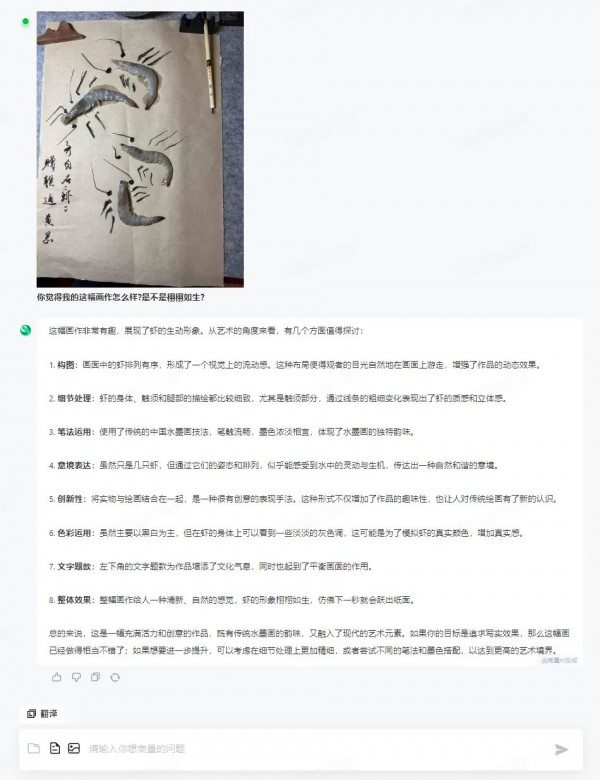

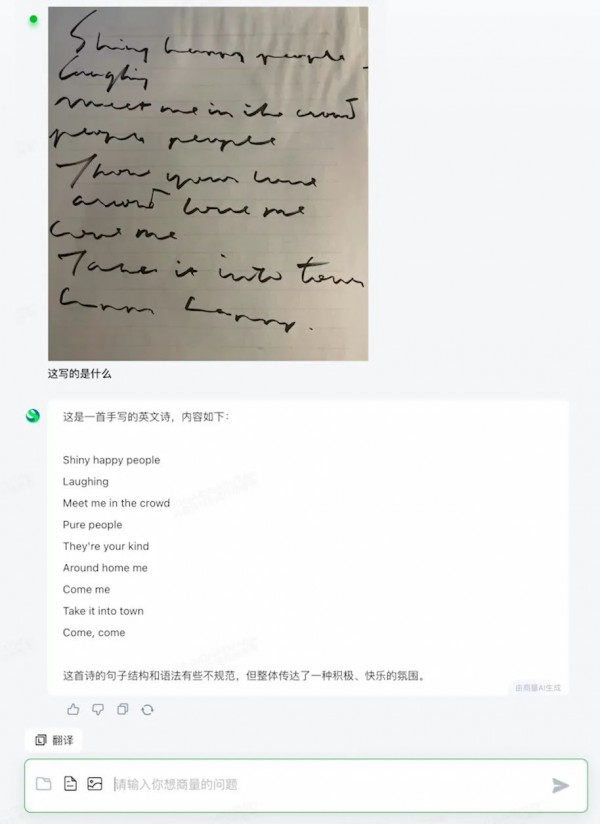

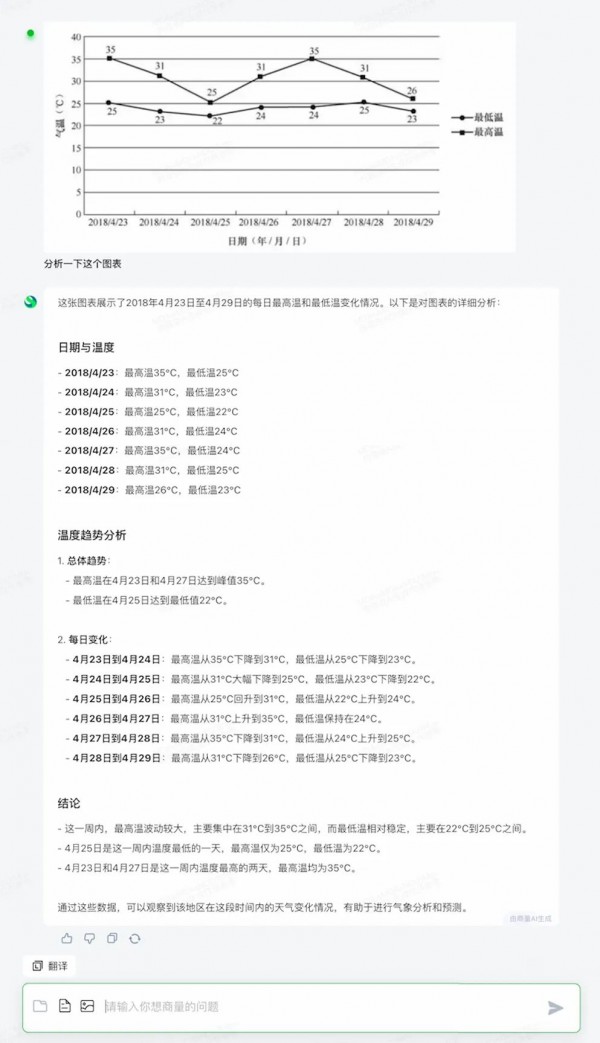

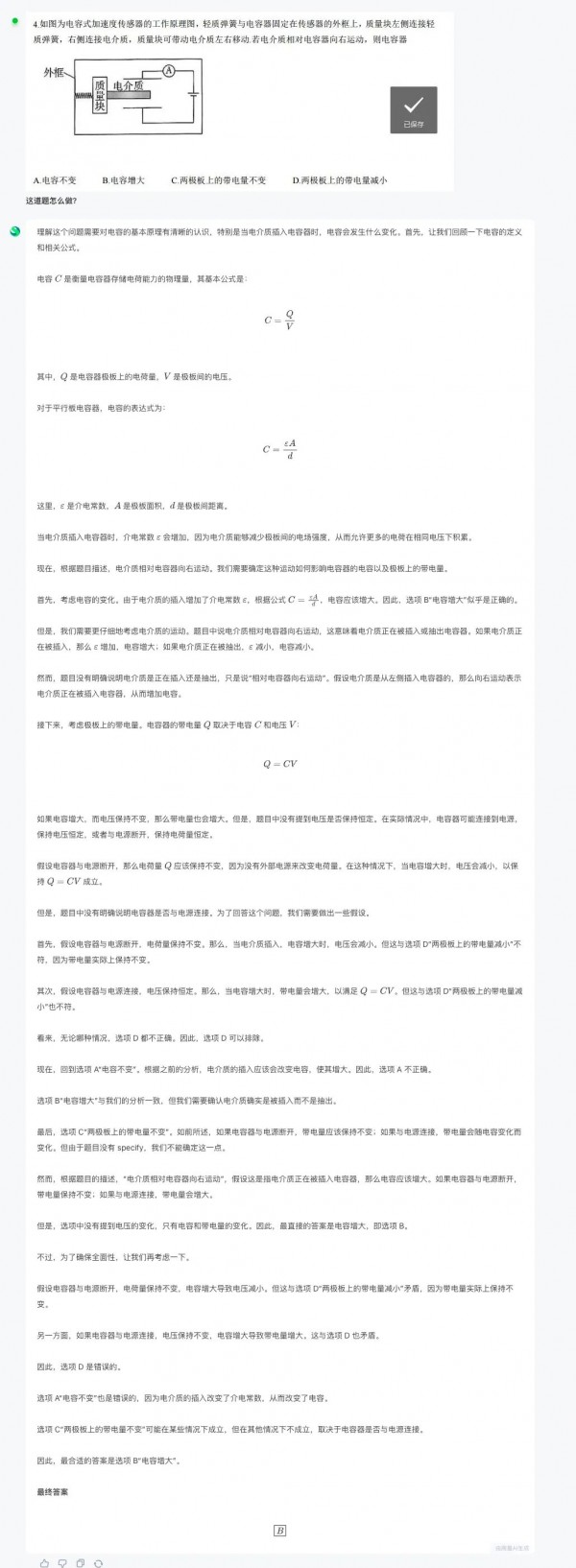

实现原生模态融合后,“日日新”融合大模型不止能达到人类“看”和“想”的水平,还可以帮助你解决更多复杂问题,看不清的字体、数据图表里的信息、文学创作与撰写……这些都可以实现。

英文“草书”难辨认,“日日新”融合大模型识别快速精准 图表分析,关键要素提取、信息分析、给出结论,几个步骤合一迅速完成,省时省力

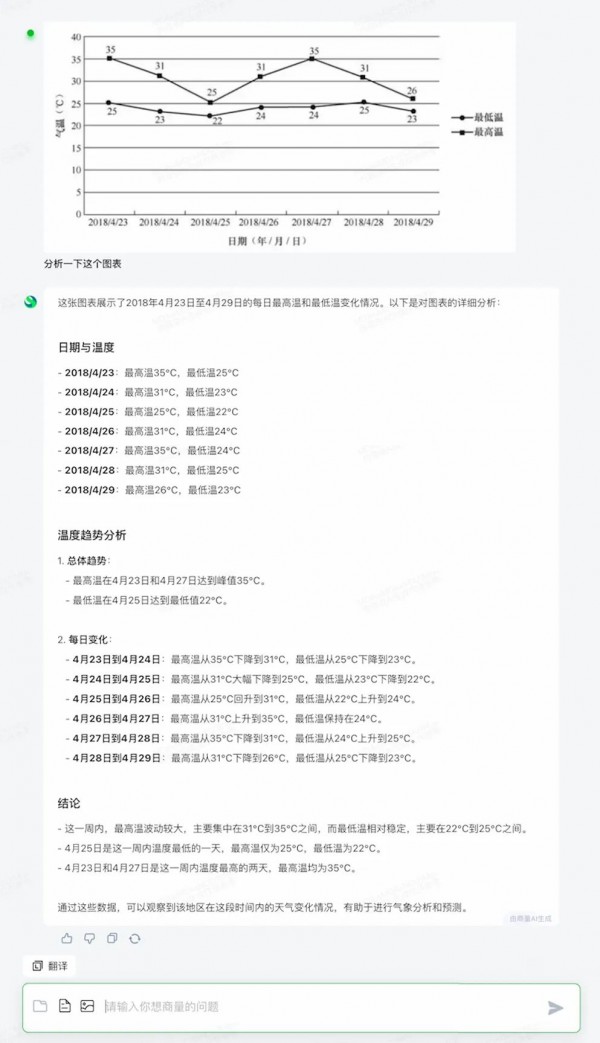

图表分析,关键要素提取、信息分析、给出结论,几个步骤合一迅速完成,省时省力 解数学题↓↓

解数学题↓↓

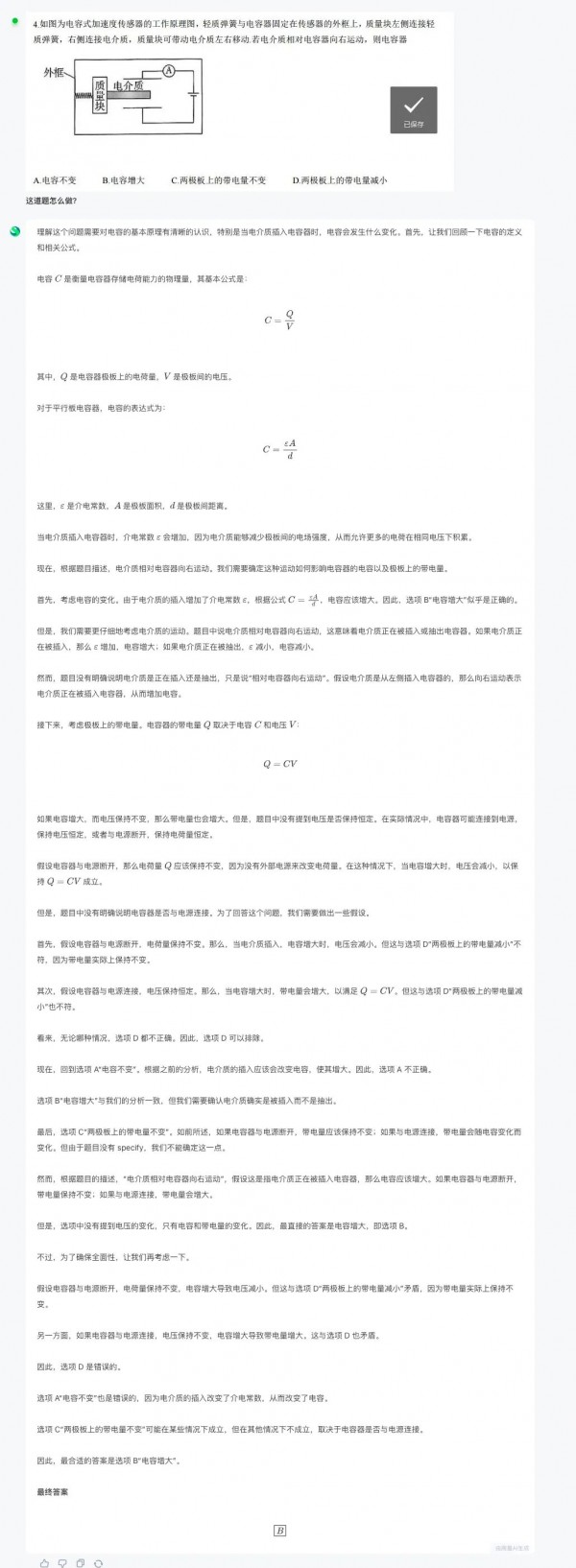

解物理题↓↓

创意冷幽默没人懂?“日日新”懂你的奇奇怪怪

文末点击阅读原文,来与“日日新”互动!

在实际应用场景中,相较于传统大语言模型仅支持单一文本输入的模式,"日日新"融合大模型展现出显著优势,尤其是在自动驾驶、视频交互、办公教育、金融、园区管理、工业制造等天然拥有丰富模态信息的场景中。

“日日新"融合大模型能够有效满足用户对图像、视频、语音、文本等多源异构信息的综合处理与识别需求。

例如,在办公、金融领域,其行业属性拥有很多复杂的富模态文档:表格、文本、图片、视频,以及融合上述形式的丰富信息,基于“日日新”融合大模型的商汤应用——办公小浣熊就可以高效地完成处理分析相关的复杂任务。

与此同时,基于融合大模型的优势,商汤“日日新”在视觉交互上也有丰富的应用场景,例如,在线上教育、语音客服等场景,均可以结合语音和自然语言来提升交互体验。

去年年底开始,原生多模态大模型就逐渐成为业内探讨的重要方向。然而由于数据和训练方法的局限,业内很多机构的尝试并不成功——多模态训练过程往往会导致纯语言任务尤其是指令跟随和推理任务的性能严重下降。

得益于在计算机视觉领域十年深耕以及人工智能赋能场景的丰富经验,商汤一直坚信多模态模型是 AI 2.0 进行场景落地的必由之路,对于多模态大模型的研发也有自己的独特见解。在推动语言模型和多模态模型融合的过程中,发展出两项关键的创新技术:融合模态数据合成与融合任务增强训练,进而完成“日日新”融合大模型的训练,推向市场。

在预训练阶段,商汤不仅采用了天然存在的海量图文交错数据,还通过逆渲染、基于混合语义的图像生成等方法合成了大量融合模态数据,在图文模态之间建立起大量交互桥梁,使得模型基座对于模态之间的丰富关系有更扎实的掌握,也为更好地完成跨模态任务打下坚实的基础,从而实现整体性能的提升。

在后训练阶段,商汤基于对广泛业务场景的认知,构建了大量的跨模态任务,包括视频交互、多模态文档分析、城市场景理解、车载场景理解等。通过把这些任务融入到增强训练的过程,商汤的融合模态模型不仅被激发出强大的对多模态信息进行整合理解分析的能力,而且还形成了对业务场景有效的响应能力,走通了应用落地反哺基础模型迭代的闭环。

实现多模态交互与深度融合、走向真正意义的模型一统,是走向世界模型的必经之路,商汤科技已在该赛道实现领跑优势。

0赞

0赞好文章,需要你的鼓励

推荐文章

推荐文章

AI颠覆预计将在2026年持续,推动企业适应不断演进的技术并扩大规模。国际奥委会、Moderna和Sportradar的领导者在纽约路透社峰会上分享了他们的AI策略。讨论焦点包括自建AI与购买第三方资源的选择,AI在内部流程优化和外部产品开发中的应用,以及小型模型在日常应用中的潜力。专家建议,企业应将AI建设融入企业文化,以创新而非成本节约为驱动力。

字节跳动等机构联合发布GAR技术,让AI能同时理解图像的全局和局部信息,实现对多个区域间复杂关系的准确分析。该技术通过RoI对齐特征重放方法,在保持全局视野的同时提取精确细节,在多项测试中表现出色,甚至在某些指标上超越了体积更大的模型,为AI视觉理解能力带来重要突破。

Spotify在新西兰测试推出AI提示播放列表功能,用户可通过文字描述需求让AI根据指令和听歌历史生成个性化播放列表。该功能允许用户设置定期刷新,相当于创建可控制算法的每周发现播放列表。这是Spotify赋予用户更多控制权努力的一部分,此前其AI DJ功能也增加了语音提示选项,反映了各平台让用户更好控制算法推荐的趋势。

Inclusion AI团队推出首个开源万亿参数思维模型Ring-1T,通过IcePop、C3PO++和ASystem三项核心技术突破,解决了超大规模强化学习训练的稳定性和效率难题。该模型在AIME-2025获得93.4分,IMO-2025达到银牌水平,CodeForces获得2088分,展现出卓越的数学推理和编程能力,为AI推理能力发展树立了新的里程碑。