该需要多少 NVIDIA CUDA Cores ?

那么,究竟需要多少 CUDA 核心才能满足我们的需求 ...

—01 —

如何正确理解 NVIDIA CUDA Cores ?

作为 NVIDIA GPU 的核心组成部分,CUDA 核心(CUDA Cores)是理解现代 GPU 架构和其强大计算能力的关键,也是众多用户和开发者对 GPU 技术最常提出的疑问之一。要理解 CUDA 核心,首先需要了解 CUDA 本身。

众所周知,CUDA(Compute Unified Device Architecture,统一计算设备架构)是 NVIDIA 推出的一项革命性技术,作为一个并行计算平台和编程模型,旨在充分利用图形处理器(GPU)的强大并行计算能力,将其应用于传统上由中央处理器(CPU)执行的通用计算(General-Purpose Computing on GPUs,简称 GPGPU)。

CUDA 的出现,打破了 GPU 仅用于图形渲染的传统认知,将其应用领域拓展到了科学计算、人工智能、深度学习、金融分析、医学影像等众多计算密集型领域。

作为 GPU 中实际执行计算任务的基本单元,CUDA 核心被设计成高度并行,尤其擅长处理浮点运算、整数运算以及其他计算密集型任务。每个 CUDA 核心可以并发执行多个线程(通常以线程束或 Warp 的形式组织),在每个时钟周期内并行处理多条指令。这种大规模的并行执行能力是 CUDA 实现高性能计算的关键所在,也是 GPU 在深度学习等领域表现出远超 CPU 性能的重要原因。

到底需要多少 NVIDIA CUDA Cores ?

1、入门级任务(约 896 CUDA 核心)

对于日常办公、网页浏览、文档处理、轻量级照片编辑以及观看高清视频等入门级任务,对 GPU 的计算需求相对较低。像 NVIDIA GeForce GTX 1650 这样的入门级显卡,配备约 896 个 CUDA 核心,足以胜任这些任务。

此类的优势在于功耗低、发热量小,性价比高,非常适合对图形性能要求不高的用户。例如,使用 Microsoft Office 套件、浏览网页、观看 YouTube 视频、进行简单的图片裁剪和调整等操作,GTX 1650 都能流畅运行。

2、游戏需求(3,584 – 4,864+ CUDA 核心)

游戏玩家对 GPU 的性能要求较高,CUDA 核心的数量直接影响游戏的流畅度和画面质量。根据不同的游戏需求,可以选择不同数量的 CUDA 核心:

- 休闲游戏 (3,584 CUDA 核心左右): 对于主流的 1080p 分辨率游戏,以及对画面要求不高的休闲游戏,拥有 3,584 个 CUDA 核心的 NVIDIA GeForce RTX 3060 是一个不错的选择。

- 此类能够在保证流畅游戏体验的同时,兼顾成本效益。例如,《英雄联盟》、《守望先锋》、《CS:GO》等游戏,RTX 3060 都能在中高画质下流畅运行。

- 高端游戏与光线追踪 (4,864+ CUDA 核心): 如果追求更高的分辨率(1440p 或 4K),或者想体验光线追踪等高级图形特效,则需要选择拥有更多 CUDA 核心的显卡。

例如,NVIDIA GeForce RTX 3060 Ti 拥有 4,864 个 CUDA 核心,能够在高画质和高分辨率下流畅运行 demanding 的 3A 大作,并提供更逼真的光影效果。例如,《赛博朋克 2077》、《Control》、《古墓丽影:暗影》等支持光线追踪的游戏,在 RTX 3060 Ti 上能获得更佳的视觉体验。

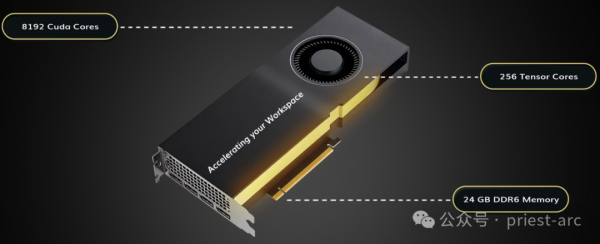

3、内容创作(8,704+ CUDA 核心)

视频编辑、3D 建模、图形设计、动画渲染等内容创作工作对 GPU 的计算能力要求极高。更多的 CUDA 核心能够显著加速渲染速度,提高工作效率。

- 视频编辑: 使用 Adobe Premiere Pro、DaVinci Resolve 等专业视频编辑软件进行 4K 甚至 8K 视频编辑时,大量的 CUDA 核心可以加速视频编码、解码、特效处理等过程,缩短渲染时间。

- 3D 建模与渲染: 使用 Blender、Maya、3ds Max 等 3D 软件进行建模和渲染时,CUDA 核心能够加速光线追踪、物理模拟等计算,提高渲染效率。

- 图形设计: 使用 Photoshop、Illustrator 等图形设计软件进行高分辨率图像处理和复杂特效渲染时,CUDA 核心也能提供显著的加速效果。

例如,NVIDIA GeForce RTX 3080 拥有 8,704 个 CUDA 核心,能够满足大多数专业内容创作的需求。对于需要处理极其复杂的项目或追求极致效率的专业人士,则可以考虑拥有更多 CUDA 核心的高端设备。

4、机器学习与人工智能(10,572 – 16,384+ CUDA 核心)

深度学习模型的训练和推理,以及大规模数据集的处理,是典型的计算密集型任务,需要强大的并行计算能力。CUDA 核心的数量直接影响着模型训练的速度和效率。

- 模型训练: 在训练大型神经网络模型时,更多的 CUDA 核心能够并行处理更多的数据,从而显著缩短训练时间。

- 推理: 在模型部署后,CUDA 核心能够加速模型的推理速度,提高 AI 应用的响应速度。

例如,NVIDIA GeForce RTX 3090 Ti 拥有 10,752 个 CUDA 核心,NVIDIA GeForce RTX 4090 拥有 16,384 个 CUDA 核心,这类高端设备是进行深度学习研究和开发的首选。

5、科学模拟(16,384+ CUDA 核心)

针对物理、化学、生物、工程等领域的科学模拟,通常需要进行大规模的数值计算和模拟,对计算能力的要求非常高。拥有高核心数的 GPU,例如 NVIDIA RTX 4090,能够大幅缩短计算时间,使研究人员能够进行更复杂、更精确的模拟分析,从而推动科学研究的进步。

6、专业图形与可视化(9,728+ CUDA 核心)

而对于建筑设计、工业设计、电影特效、虚拟现实等专业图形和可视化应用,需要进行高精度的 3D 渲染和复杂的视觉效果处理。此类场景需要更为专业的NVIDIA RTX 4080 拥有 9,728 个 CUDA 核心,能够为这些 Demanding 任务提供卓越的性能,确保流畅和高质量的视觉输出。

那么,选择 CUDA Cores 时需要考虑哪些关键因素 ?

1、面向未来的投资(Future-Proofing)

随着计算技术不断发展,软件和硬件的需求也在逐年增长。例如,图形设计、机器学习等领域的工具通常会随着更新迭代而需要更高的计算性能。为避免频繁更换硬件,建议选择具备一定前瞻性的显卡,即使当前需求不高,也可以为未来的高性能任务提供保障。

2、 系统平衡(Balanced System Design)

CUDA 核心数量并非唯一决定系统性能的因素,GPU 的整体表现需要与其他硬件组件相辅相成。如果 CPU、内存、存储等无法与 GPU 匹配,会导致性能瓶颈,影响实际体验。具体如下所示:

- CPU 性能

- 高性能 GPU 需要足够强大的 CPU 来处理数据。如果 CPU 性能不足,将导致 GPU 无法完全发挥其计算能力。例如,搭配 RTX 4090 的 CPU 应至少达到 Intel i9 或 AMD Ryzen 9 的级别。

- 内存需求

- 显卡的 CUDA 核心需要足够的内存支持,尤其是在运行大规模数据集(如机器学习)时,建议搭配高带宽、高容量的内存(如 32GB 或以上)。

- 存储性能

- 大型 3D 渲染或科学模拟需要快速加载数据,固态硬盘(NVMe SSD)可显著减少 I/O 瓶颈。

3、功耗与散热(Power Consumption and Cooling)

更高数量的 CUDA 核心通常意味着更高的功耗和热量。这不仅需要更强大的电源支持,还需要高效的散热解决方案以保证系统的稳定运行。具体可参考如下:

- 功耗预算

- 通常,如配备 16,384 CUDA 核心的 RTX 4090 其功耗可能达到 450W 或更高,这要求配备 850W 或以上的电源,且电源需具有高效的电流分配能力。

- 散热能力

- 此外,高端 GPU 的发热量较大,需要采用高效的风冷或水冷系统,以防止出现降频或过热关机问题。机箱的散热设计(如风道优化)同样不可忽视。

4、性价比与预算控制(Performance-to-Cost Ratio)

虽然高 CUDA 核心数量可以提供更强的性能,但这些显卡的成本也更高。需要根据预算合理分配资金,选择在性能和成本之间取得平衡的显卡。通常而言,在实际的场景中,针对特定的业务需求,我们可以采用如下:

- 入门级

- NVIDIA GTX 1650(性价比高,适合轻量级任务)

- 中端主流

- NVIDIA RTX 3060(适合大多数游戏玩家和轻度内容创作者)

- 高端旗舰

- NVIDIA RTX 4090(适合需要顶级性能的专业用户)

5、软件优化与兼容性(Software Optimization and Compatibility)

不同软件对 GPU 的利用率和性能优化程度可能不同,因此在选择 CUDA 核心数量时,还需要确认目标显卡是否支持所使用的软件。具体涉及如下:

- CUDA 支持

- 检查显卡是否支持所需的 CUDA 工具包版本,以及是否与目标应用程序兼容。

- 驱动程序更新

- 高性能显卡需要稳定且频繁更新的驱动程序,以确保最佳性能和兼容性。

- 开发需求

- 如果大家从事 AI、科学计算等开发工作,需要确保显卡支持主流框架(如 TensorFlow、PyTorch)。

因此,总体来说,选择 CUDA 核心时,需综合考虑未来需求、系统平衡、功耗散热、应用场景、性价比以及软件兼容性。一个经过深思熟虑的选择可以不仅满足当前需求,还能为未来的使用提供保障。在高性能计算领域,找到最适合的显卡将帮助您在效率、预算和性能之间取得理想平衡。

好文章,需要你的鼓励

人工智能落地“最后一公里”,戴尔工作站助力AI应用提速

英特尔携手戴尔以及零克云,通过打造“工作站-AI PC-云端”的协同生态,大幅缩短AI部署流程,助力企业快速实现从想法验证到规模化落地。

意大利ISTI研究院推出Patch-ioner:一个神奇的零样本图像描述框架,让电脑像人一样描述任何图像区域

意大利ISTI研究院推出Patch-ioner零样本图像描述框架,突破传统局限实现任意区域精确描述。系统将图像拆分为小块,通过智能组合生成从单块到整图的统一描述,无需区域标注数据。创新引入轨迹描述任务,用户可用鼠标画线获得对应区域描述。在四大评测任务中全面超越现有方法,为人机交互开辟新模式。

阿联酋MBZUAI发布PAN世界模型,AI仿真技术迎来突破

阿联酋阿布扎比人工智能大学发布全新PAN世界模型,超越传统大语言模型局限。该模型具备通用性、交互性和长期一致性,能深度理解几何和物理规律,通过"物理推理"学习真实世界材料行为。PAN采用生成潜在预测架构,可模拟数千个因果一致步骤,支持分支操作模拟多种可能未来。预计12月初公开发布,有望为机器人、自动驾驶等领域提供低成本合成数据生成。

MIT团队重磅发现:不配对的多模态数据也能让AI变得更聪明

MIT研究团队发现,AI系统无需严格配对的多模态数据也能显著提升性能。他们开发的UML框架通过参数共享让AI从图像、文本、音频等不同类型数据中学习,即使这些数据间没有直接对应关系。实验显示这种方法在图像分类、音频识别等任务上都超越了单模态系统,并能自发发展出跨模态理解能力,为未来AI应用开辟了新路径。