送车玩法开始流行?继黄子韬后周鸿祎直播送车涨粉百万

日前,周鸿祎发布了一条视频,称其粉丝数即将达到1000万,他准备给粉丝送车。

在视频中,周鸿祎表示,其粉丝数量即将突破1000万大关,为了回馈粉丝的支持,他计划送出一批汽车作为福利。然而,在选择送何种车型时,他陷入了纠结。

不过,我们也发现,在黄子韬送车后,他遇到了很多网络上的攻击,粉丝也在不断减少,这让我们不禁要问,送车真是一个好的营销方式吗?

周鸿祎送百万豪车?

在视频中,周鸿祎称,“黄子韬前几天送车的活动已经做完了,送的是十三万的车,一共送了三十台。这事情搞得我就比较苦恼,因为我是想着送吧,送稍微贵一点的车,比如说仰望U8吧,一辆车一百多万,也得抵得上十几辆了。华为的S9、M9也都得四五十万、五六十万。所以到底是数量少一点价格贵一点,还是数量多一点价格便宜一点呢?大家在评论区帮我出出主意啊。”

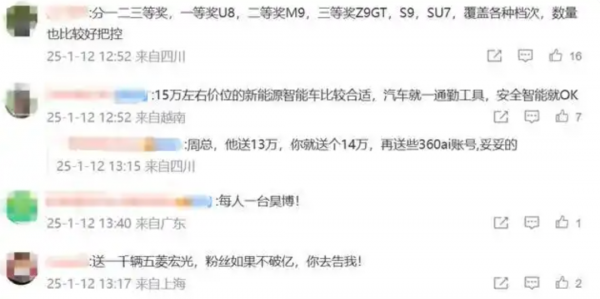

周鸿祎的这番言论迅速引发了网友的热议。不少网友在评论区积极建言献策,有的建议分设不同等级的奖项,覆盖各种档次的车型;有的则认为选择一款性价比较高、安全智能的新能源汽车更为合适;还有人开玩笑说送一千辆五菱宏光,粉丝数量或许能破亿。

值得关注的是,周鸿祎宣布送车活动的视频发布后,其粉丝数量迅速增加。据统计,截至视频发布后不久,其粉丝数量已经突破了1000万大关,并持续上涨至1093万(截至发稿前),半日之内涨粉超过百万。这一增长速度无疑证明了周鸿祎在网络上的影响力和号召力。

除此之外,周鸿祎宣布送车活动也引发了汽车厂商的关注。不少汽车品牌纷纷表示愿意提供赞助和支持,希望借此机会提升品牌知名度和曝光度。

然而,市场分析认为,流量只是品牌宣传的一部分,产品的技术、质量和经营战略才是影响品牌销量的关键因素。因此,汽车厂商在参与此类活动时需要理性看待其带来的效益和影响。

黄子韬送车后掉粉超百万

1月10日,艺人黄子韬在直播间送出30台车。据了解,黄子韬曾因承诺送车涨粉超3000万,10日晚其粉丝数更是突破了4500万。

黄子韬社交平台账号发布的信息显示,本次送出的车为宝骏云海纯电500km续航款。该车型官方售价在123800元/辆,因为直播抽奖属于有奖销售内容,要求不能超过5万元,所以最终只能送出汽车使用权。

汽车品牌方发布的抽奖说明显示:“车辆使用权届满后,用户应交还车辆。”黄子韬透露抽奖送出的30台车中有15台是品牌方赞助的,另外15台是自己购买的,他还请了杭州互联网公证处公证人员见证。这条抽奖说明被不少网友吐槽,不少参与活动的网友认为这“吃相难看”,使用期满还要还回给品牌方。

1月12日,话题#黄子韬掉粉超百万#冲上微博热搜第一。

截至1月13日8时30分,黄子韬社交账号粉丝量降到4160万。对此,黄子韬回应:“如果没有抽中所有人都取关的话,说实话我会非常失望伤心。不要让我体会突然站得很高,又突然跌下来的感觉。”

对此,网友认为他格局太小:“涨了快3000万粉丝,只要不掉完,怎么都是赚,黄子韬还是得失心太重了。”“本来就为了车而去关注的,那没有得到取关就是必然啊!”“炒热度罢了,中奖粉丝只享有汽车5年的使用权。”

其实,大部分的人都相信黄子韬的初心是好的,他还捐出了10辆车给妇女基金会。加上之前的公益行为,可以说是一位资深的公益人。希望大家不要道德绑架,送礼物本就是一种情分,而非义务。多些理解与包容,才能让这份善意传递得更远,让直播间的氛围重回温暖与和谐 。

写在最后

其实,明星或者企业家送车也是为了自己的人气更上一层楼,而网友们则更在乎自己有没有抽中,但毕竟中奖者是少数,这一结果也会引起很多网友的不满,因此,事件后的“网络声讨”也随之发生,这应该送奖人是在发布抽奖之前就应该有预判的,相信在周鸿祎送车后也将迎来一轮掉粉潮,这就是游戏规则的体现。

最后我们要说的是,这类戏剧性事件,无疑为我们提供了一个观察社会与文化动态的重要路径。或许在不久的将来,我们将更深入地审视明星活动对个体与社会的影响,探讨在复杂的网络环境中如何保持真实。

好文章,需要你的鼓励

AI投资有望在2026年获得真正回报的原因解析

尽管全球企业AI投资在2024年达到2523亿美元,但MIT研究显示95%的企业仍未从生成式AI投资中获得回报。专家预测2026年将成为转折点,企业将从试点阶段转向实际部署。关键在于CEO精准识别高影响领域,推进AI代理技术应用,并加强员工AI能力培训。Forrester预测30%大型企业将实施强制AI培训,而Gartner预计到2028年15%日常工作决策将由AI自主完成。

北大学者革新软件诊断方式:让代码问题的“病因“无处遁形

这项由北京大学等机构联合完成的研究,开发了名为GraphLocator的智能软件问题诊断系统,通过构建代码依赖图和因果问题图,能够像医生诊断疾病一样精确定位软件问题的根源。在三个大型数据集的测试中,该系统比现有方法平均提高了19.49%的召回率和11.89%的精确率,特别在处理复杂的跨模块问题时表现优异,为软件维护效率的提升开辟了新路径。

2026年软件定价大洗牌:IT领导者必须知道的关键变化

2026年软件行业将迎来定价模式的根本性变革,从传统按席位收费转向基于结果的付费模式。AI正在重塑整个软件经济学,企业IT预算的12-15%已投入AI领域。这一转变要求建立明确的成功衡量指标,如Zendesk以"自动化解决方案"为标准。未来将出现更精简的工程团队,80%的工程师需要为AI驱动的角色提升技能,同时需要重新设计软件开发和部署流程以适应AI优先的工作流程。

德国达姆施塔特工业大学团队首次揭秘:专家混合模型AI的“安全开关“竟然如此脆弱

这项由德国达姆施塔特工业大学领导的国际研究团队首次发现,当前最先进的专家混合模型AI系统存在严重安全漏洞。通过开发GateBreaker攻击框架,研究人员证明仅需关闭约3%的特定神经元,就能让AI的攻击成功率从7.4%暴增至64.9%。该研究揭示了专家混合模型安全机制过度集中的根本缺陷,为AI安全领域敲响了警钟。