2024深度洞察:AI服务器与AI PC的风云变幻

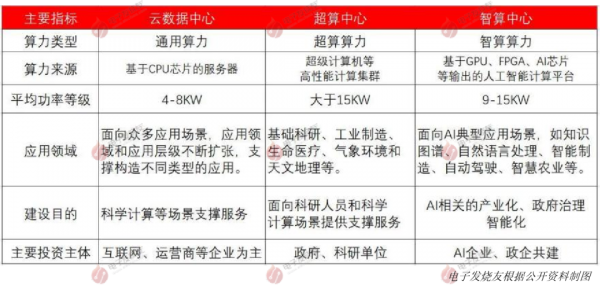

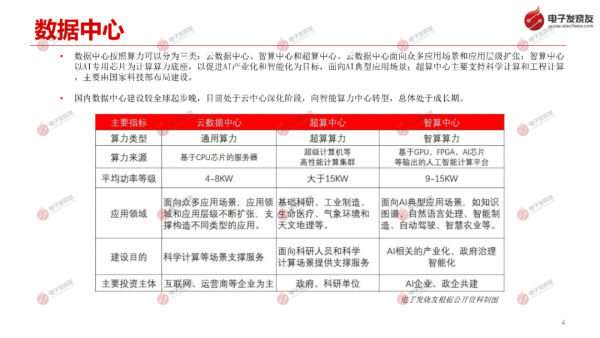

数据中心按照算力可以分为三类:云数据中心、智算中心和超算中心。云数据中心面向众多应用场景和应用层级扩张;智算中心 以AI专用芯片为计算算力底座,以促进AI产业化和智能化为目标,面向AI典型应用场景;超算中心主要支持科学计算和工程计算 ,主要由国家科技部布局建设。

国内数据中心建设较全球起步晚,目前处于云中心深化阶段,向智能算力中心转型,总体处于成长期。

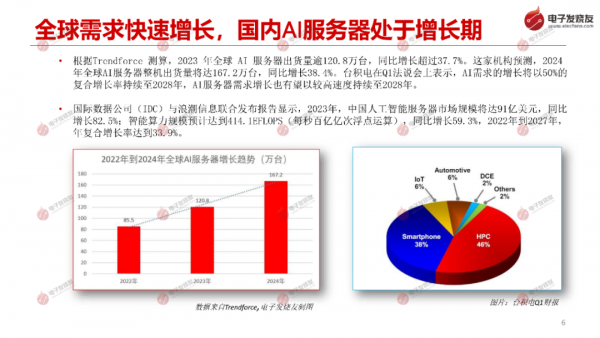

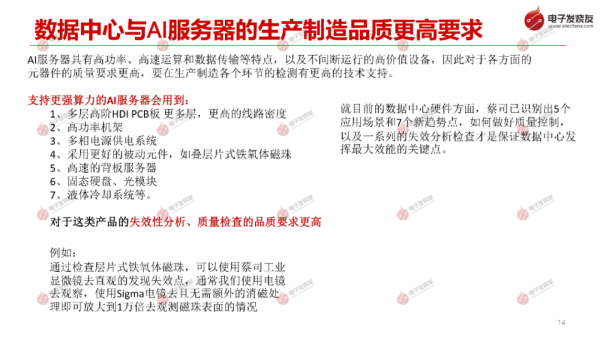

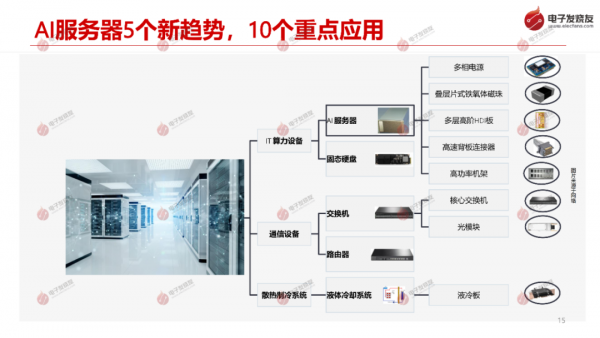

根据Trendforce 测算, 2023 年全球 AI 服务器出货量逾120.8万台,同比增长超过37.7%。这家机构预测, 2024 年全球AI服务器整机出货量将达167.2万台,同比增长38.4%。台积电在Q1法说会上表示,AI需求的增长将以50%的 复合增长率持续至2028年,AI服务器需求增长也有望以较高速度持续至2028年。

2023年,中国人工智能服务器市场规模将达91亿美元, 同比 增长82.5%;智能算力规模预计达到414.1EFLOPS (每秒百亿亿次浮点运算),同比增长59.3%,2022年到2027年, 年复合增长率达到33.9%。

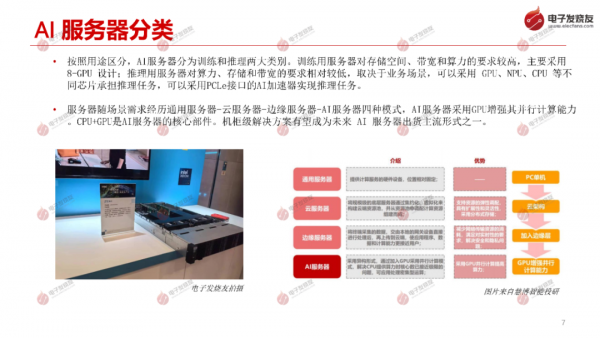

按照用途区分, AI服务器分为训练和推理两大类别。训练用服务器对存储空间、带宽和算力的要求较高, 主要采用8-GPU 设计;推理用服务器对算力、存储和带宽的要求相对较低,取决于业务场景, 可以采用 GPU、NPU、CPU 等不 同芯片承担推理任务,可以采用PCLe接口的AI加速器实现推理任务。

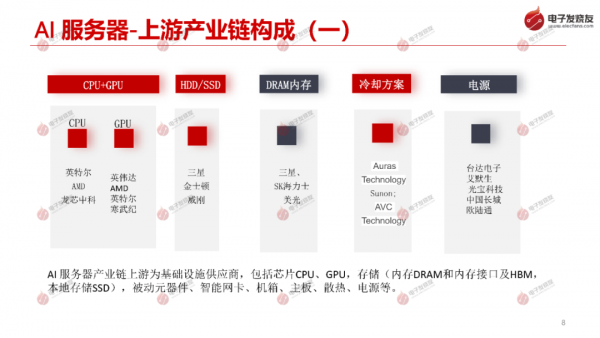

服务器随场景需求经历通用服务器-云服务器-边缘服务器-AI服务器四种模式,AI服务器采用GPU增强其并行计算能力。CPU+GPU是AI服务器的核心部件。机柜级解决方案有望成为未来 AI 服务器出货主流形式之一。

好文章,需要你的鼓励

让老旧Windows和macOS系统延续生命力

大多数用户只使用计算机预装的操作系统直到报废,很少尝试更换系统。即使使用较老版本的Windows或macOS,用户仍可通过开源软件获益。本文建议通过重新安装系统来提升性能,Mac用户可从苹果官方下载各版本系统安装包,PC用户则建议使用纯净版Windows 10 LTSC以获得更长支持周期。文章强调备份数据的重要性,并推荐升级内存和固态硬盘。对于老旧系统,应替换需要联网的内置应用以降低安全风险,定期进行系统维护清理。

新加坡南洋理工大学提出“棱镜假设“:像光谱仪一样解读图像的神秘密码

新加坡南洋理工大学研究团队提出"棱镜假设",认为图像可像光谱一样分解为不同频率成分,低频承载语义信息,高频包含视觉细节。基于此开发的统一自编码系统UAE,通过频率域分解成功统一了图像理解和生成能力,在多项基准测试中超越现有方法,为构建真正统一的视觉AI系统提供了新思路,有望推动计算机视觉技术向更智能统一的方向发展。

微软计划到2030年用Rust语言替换所有C和C++代码

微软杰出工程师Galen Hunt在LinkedIn上宣布,目标是到2030年消除微软所有C和C++代码。公司正结合AI和算法重写最大的代码库,目标是"1名工程师、1个月、100万行代码"。微软已构建强大的代码处理基础设施,利用AI代理和算法指导进行大规模代码修改。该项目旨在将微软最大的C和C++系统翻译为内存安全的Rust语言,以提高软件安全性并消除技术债务。

当AI遇到“健忘症“:芝加哥大学团队如何让智能助手不再胡编乱造

芝加哥伊利诺伊大学团队提出QuCo-RAG技术,通过检查AI训练数据统计信息而非内部信号来检测AI回答可靠性。该方法采用两阶段验证:预检查问题实体频率,运行时验证事实关联。实验显示准确率提升5-14个百分点,在多个模型上表现稳定,为AI可靠性检测提供了客观可验证的新方案。