新华三推出AI数据平台解决方案,加速推理驱动智算时代

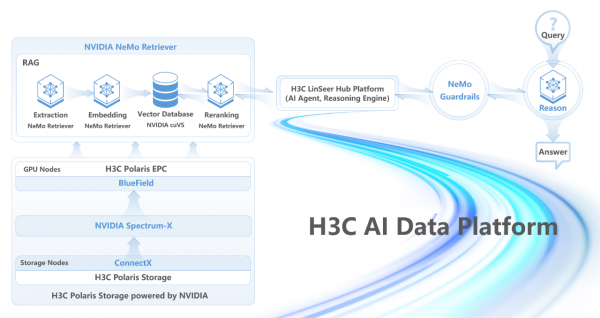

近日,紫光股份旗下新华三集团(以下简称“新华三”)宣布推出基于 NVIDIA AI 数据平台参考设计的技术集成方案,打造更智能、更灵活、更安全的大模型数据处理能力,为AI推理场景注入新能力和强劲动能。

当前,在大模型实时交互场景中,用户对AI服务的响应速度要求极高;同时,如果AI推理没有基于新的或更新过的内容,就会造成生成内容与事实不符、逻辑错误等情况,严重影响其可靠性和实用性。新华三新推出的 AI 数据平台解决方案,打通“算力”和“存力”之间的效率鸿沟,实现从底层硬件到上层 AI应用的数据流通加速,大幅提升AI推理的实时性、相关性与准确度,不仅优化了大模型的整体运行效率,也显著改善了真实场景中使用大模型时的响应速度与使用体验。

H3C AI数据平台解决方案:软硬协同 推理加速

AI数据平台解决方案整合了新华三与NVIDIA的领先技术,打造存算网技术深度集成的智能数据平台,并通过上层软件平台协同优化,为AI基础设施注入强劲动能,显著提升AI大模型的推理能力。

存算网深度集成,打通推理性能瓶颈

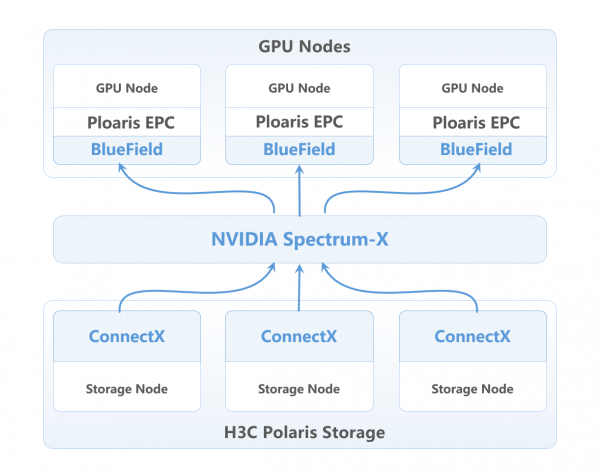

AI数据平台解决方案集成了NVIDIA Spectrum-X AI以太网网络平台,包括Spectrum以太网交换机、NVIDIA BlueField-3 DPU 数据处理器及NVIDIA ConnectX SuperNIC,将普通以太网的带宽利用率从50-60%提升至97%以上,有效应对瞬时流量高峰,保障存储与计算节点间的高速互连。BlueField-3 DPU可与H3C Polaris X20000存储系统完美适配,支持NVMe over Fabrics、NVIDIA GPU-Direct Storage(GDS)等技术,实现存储卸载和加速,涵盖数据冗余、完整性校验、解压缩和重复数据删除等功能,进一步提升存储性能并降低功耗。

新华三Polaris X20000系列专为AI智算场景设计,采用全新自研存储引擎,面向AI/HPC场景下的海量数据处理需求提供极致性能,单节点实现120GB/s带宽和200万IOPS,集群性能近线性增长,满足AI大模型训练中海量小文件高并发和百TB级带宽需求;并将块、文件、对象与HDFS协议集成于统一存储平台,从数据采集、模型训练到分发全流程实现数据零迁移。同时,系统大幅提升可靠性,毫秒级故障上报与秒级切换确保训练任务不中断,计划内/外升级扩容对上层应用无感,为企业提供稳定、高效的存储支持。

软件平台协同优化 加速智算推理引擎

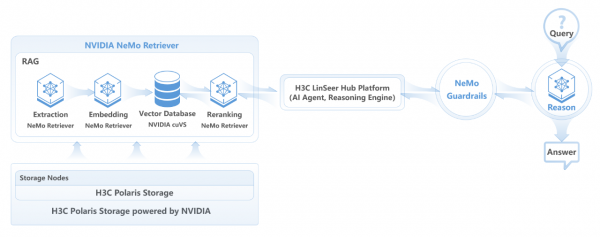

在 AI-Q NVIDIA Blueprint 的支持下,代理式系统可以连接到新华三Polaris X20000高性能数据存储平台上,AI-Q 使用NVIDIA NeMo Retriever 加速数据提取和检索,NVIDIA NeMo Retriever 是用于处理海量结构化、半结构化及非结构化数据(如文本、PDF、图像、视频等)的软件。如此,可显著加速RAG(检索增强生成)应用的响应速度。

同时 NVIDIA NeMo Guardrails 可确保推理问答交互的安全性、准确性和主题相关性。新华三自主研发的灵犀使能平台(LinSeer Hub)则作为上层管理平台,提供了AI智能体和推理引擎的功能。

通过上述组件的深度整合,AI 数据平台解决方案显著提升大模型的推理性能与Token处理速度,为企业提供实时数据洞察能力,助力业务场景的智能化升级。

数据驱动 加速推理 引领智算未来

随着AI大模型的快速发展,数据已成为AI生产力的核心要素,与此同时,企业核心生产数据80%存储于外置专业存储,新华三作为存储领域的领先厂商,以Polaris X20000系列的卓越性能和灵活性,提升了AI 数据平台的能力。NVIDIA则通过硬件加速和软件能力,释放Polaris存储硬件的潜力,帮助新华三实现从“数据仓库”到“智能数据平台”的转型,形成完整的AI数据闭环。并结合存储厂商成熟的数据管理能力,构建高效AI基础设施。

作为数字化及AI解决方案提供者,新华三拥有深厚的市场积累和广泛的行业覆盖,服务于金融、电信、政务、医疗、教育、制造等多个领域。新华三此次推出的AI 数据平台解决方案,是新华三“算力╳联接”技术战略的持续深化。未来,新华三将持续携手生态伙伴,推动AI数据平台的技术革新与产业落地,助力百行百业实现高效、智能、可信的AI转型。

好文章,需要你的鼓励

SanDisk重塑经典SSD品牌:WD Black和Blue正式更名为Optimus系列

西部数据闪存业务分拆后,SanDisk宣布将停用广受欢迎的WD Black和Blue品牌,推出全新的SanDisk Optimus系列NVMe产品线。WD Blue驱动器将更名为SanDisk Optimus,而高端WD Black驱动器将分别更名为Optimus GX和GX Pro。尽管品牌变更,底层硬件和供应链保持不变。然而受全球内存短缺影响,预计2026年第一季度客户端SSD价格可能上涨超过40%。

上海AI实验室研究者想出妙招:让AI像优秀学生一样高效思考,告别“想太多“毛病

上海AI实验室开发RePro训练方法,通过将AI推理过程类比为优化问题,教会AI避免过度思考。该方法通过评估推理步骤的进步幅度和稳定性,显著提升了模型在数学、科学和编程任务上的表现,准确率提升5-6个百分点,同时大幅减少无效推理,为高效AI系统发展提供新思路。

福特汽车准备在车载系统中引入AI智能助手

福特汽车在2026年消费电子展上宣布将在车辆中引入AI助手技术。该AI助手最初将在福特和林肯智能手机应用中推出,从2027年开始成为新车型的原生功能。福特希望通过AI技术实现车辆个性化体验,提供基于位置、行为和车辆能力的智能服务。同时,福特将采用软件定义车辆架构,推出自研的高性能计算中心,提升信息娱乐、驾驶辅助等功能。

MIT团队让机器人终于不再“卡顿“:一种让机器人像人一样流畅反应的突破性技术

MIT团队开发的VLASH技术首次解决了机器人动作断续、反应迟缓的根本问题。通过"未来状态感知"让机器人边执行边思考,实现了最高2.03倍的速度提升和17.4倍的反应延迟改善,成功展示了机器人打乒乓球等高难度任务,为机器人在动态环境中的应用开辟了新可能性。

智能体驱动全球创新浪潮,微软携手前沿伙伴迈进消费电子新未来

达索系统在CES 2026上展示AI驱动的医疗创新, 重塑精准、可预测与个性化医疗

Arm 发布 20 项技术预测:洞见 2026 年及未来发

美光推出全球首款面向客户端计算的 PCIe 5.0 QLC SSD

SanDisk重塑经典SSD品牌:WD Black和Blue正式更名为Optimus系列

福特汽车准备在车载系统中引入AI智能助手

ChatGPT推出健康模式:结合医疗数据提供个性化建议

福特推出AI数字助理及新一代BlueCruise自动驾驶技术

联想Legion Pro可卷曲概念机展现移动大屏游戏新体验

印度和新加坡在智能体AI采用方面超越全球同行

华硕CES 2026新品:更小巧的ProArt GoPro笔记本和升级版Zenbook Duo

n8n警告CVSS满分漏洞影响自托管和云版本