AMD全栈战略浮出水面:开源很好,所以我们要造GPU、ROCm和AI机架全生态 原创

作者|周雅

在AI圈子里,大家或许听到过这样的话术,“AI创新既是一场马拉松,也是一场短跑”,此时此刻我在AMD Advancing AI这场关乎未来AI计算格局的会上,脑中多次浮现出这句话。

太平洋时间2025年6月12日早晨,圣何塞的麦克内里会议中心就开始排长龙,据说今年注册的观众严重超标。身前身后的全球媒体同行,几乎都在议论近期某个模型或某个AI公司的进展,AI的热度像是6月份的天气。我于是又刷了一下AMD的最新财报,在2025年第一季度,AMD的数据中心业务营收37亿美元,同比增长57%。对应到全球AI版图,AMD的话语权逐渐变重。

镜头拉回到随后的会议现场,AMD董事会主席及首席执行官Lisa Su博士走上舞台,也就意味着这场技术大会的正式开始了。

概述这场发布,AMD主要做了五件事:展示AI加速器“Instinct MI350系列”的遥遥领先;用开源软件平台“ROCm 7”普惠AI开发者;发布支持以太网联盟(UEC)的网卡Polara 400;以及带来一个彩蛋作为压轴——AI机架“Helios”。

听完整场,不难看出AMD的战略方向,从“卖芯片”转向“不止卖芯片,还卖系统”,左手端到端解决方案,右手开放生态,来重塑AI基础设施的竞争格局。

Helios:我们不止卖芯片,还卖端到端解决方案

尽管NVIDIA在GPU的强势有目共睹,但AMD也并不想做一个长期追赶者。

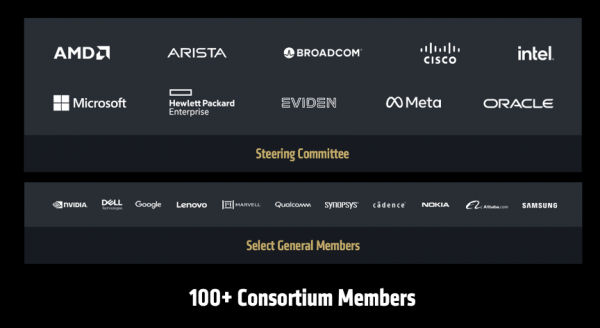

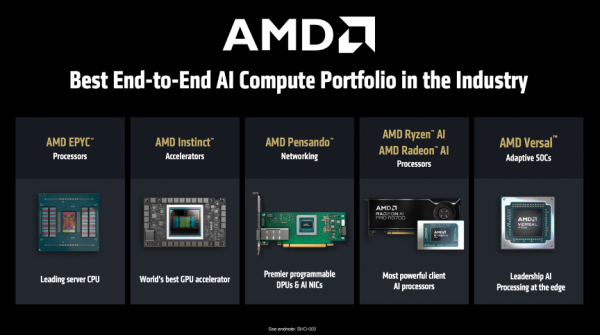

我们知道,NVIDIA 一直是靠着硬件GPU+软件生态CUDA +网络技术NVLink,建了一个严丝合缝的AI生态。而AMD 另辟蹊径,用组合拳CPU+GPU+DPU+开源软件栈,武装成一个端到端的AI 基础设施。

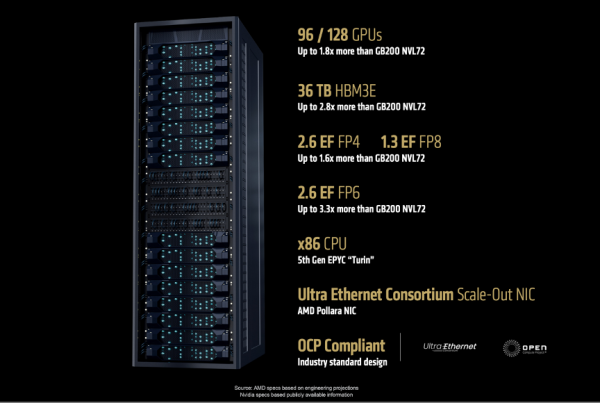

于是,AMD正式官宣AI机架方案「Helios」,将于2026年正式问世。

「Helios」 是一个集大成者,AMD会把全家桶都打包装进去,包括下一代 AMD GPU Instinct MI400 系列 、采用 Zen 6 架构的AMD CPU EPYC 「Venice」、AMD DPU Pensando 「Vulcano」、以及AMD开源软件栈ROCm。

此处稍作解释AI机架方案。在过去,像谷歌、Meta 这样的大公司要自己成为“攒机员”,他们从 AMD 或其他芯片厂商那里买来GPU/CPU 等核心部件,然后自己设计服务器、机柜、散热系统和网络连接,再进行漫长的软件调试,才能让成千上万个 GPU 协同工作,可想而知,这个过程耗时耗力耗钱。

你可以把「Helios」 理解成一台为你组装好、调试好、开箱即用的“超级计算引擎”,它的外观形态是一个机架,里面有最强大的GPU,还预装了最匹配的 CPU、最高效的网卡、专门设计的散热和供电系统,且所有软件都经过深度优化,而不是让你自己去买一堆零件(CPU、显卡、主板、网卡等)回来自己攒机,说白了,就是为了解决超大规模客户在构建 AI 集群时面临的最大痛点——降低总拥有成本(Total Cost of Ownership,TCO)和缩短产品上市时间(Time-to-Market,TTM)。

“Helios是业界首次将机架作为统一系统设计,它将在大规模训练和分布式推理领域占据领先地位,这将彻底改变行业格局。”Lisa Su博士说道,“Helios的优势不止于强大算力,在内存容量、内存带宽和互联速度方面都遥遥领先。”

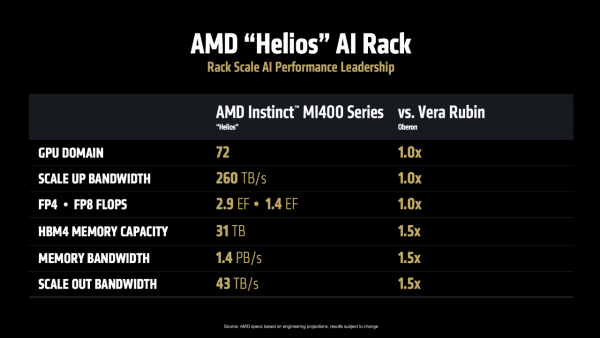

AMD直面竞争也颇有底气。官方称,Helios可容纳72块MI400系列,总带宽260TB/s,FP4 2.9 EFlops、FP8 1.4 EFlops。此外,Helios的HBM4内存容量31 TB、总带宽1.4 PB/s、横向扩展带宽43 TB/s,对标NVIDIA Oberon都要高出一半。

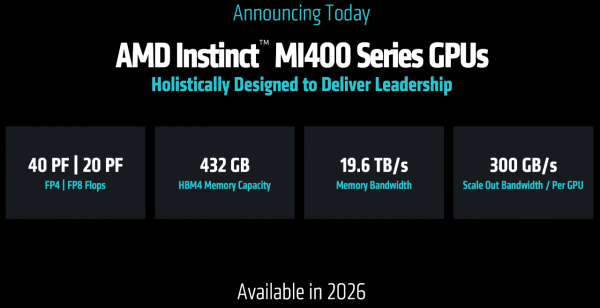

而驱动 Helios 的核心,正是 Instinct MI400,这款加速器正在开发中,其规格堪称恐怖,当屏幕上出现它的性能参数时,现场掌声雷动:

FP4 算力达到 40 PF,FP8 算力达到 20 PF,单 GPU 显存高达 432GB,HBM 内存带宽达到19.6 TB/s,单 GPU 对外互联带宽达到300 GB/s,可实现跨机架和集群的互联。简单来说,它能够让不同机柜和计算群组之间进行超高速数据交换,就像给所有计算单元之间铺设了信息高速公路,使得数据能够快速、大量地在不同设备间流通,避免堵塞或延迟。

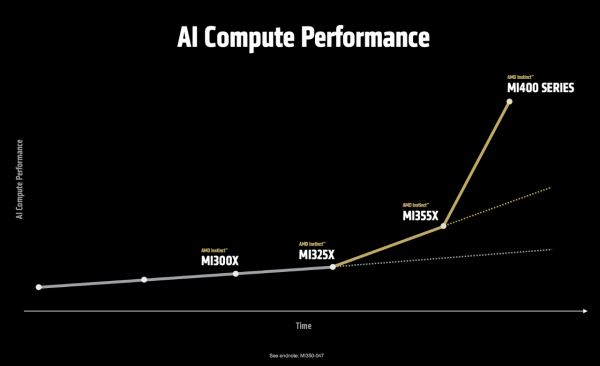

看下图这条陡峭的曲线。从 MI300 到 MI350,性能提升了约 3-4 倍;而从 MI350 到 MI400,AMD希望让它跑出一骑绝尘的姿态。Lisa Su博士在展示性能曲线时说道:“MI400系列在处理最前沿的模型时,性能预计可提升至目前的10倍,这使它成为业界性能最强劲的AI加速器。”

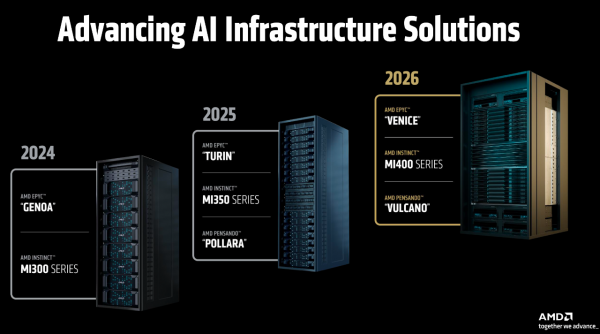

从路线图上看,Helios将于2026年发布,而 AMD 依然放出了“三年规划”:2026年,Helios将基于AMD EPYC “Venice”、AMD Instinct “MI400系列”、AMD Pensando “Vulcano”;2027年,“下一代AI机架”将基于EPYC “Verano”、Instinct “MI500系列”、Pensando “Vulcano”。

诚然,这是 AMD 战略上的一次重大升级,意味着这家公司正从一个纯粹的芯片供应商,向系统级解决方案提供商转型。

说到这里,AMD特意请来OpenAI助阵,两家公司都强调了AI计算能力有多重要。OpenAI联合创始人兼首席执行官Sam Altman坦言:“当我们开始使用推理模型,这些模型需要很长的运算时间。这种模型会自主运行,对问题进行分析,然后给出更优解,有时甚至能直接写出一整套完整的代码。但这就要求模型必须运行得更快,还得能处理很长的文字。为了做到这些,我们需要超级多的计算资源、存储空间和CPU。”

也就是说,推理模型和AI代理正在驱动下一波应用浪潮,这对算力的需求是无止境的。

Instinct MI350:绝非单一指标,性能、内存、成本全要照顾到

除了让人眼前一亮的Helios,Lisa Su还揭开了本场第一位硬件主角——AMD Instinct MI350 系列!

AMD董事会主席及首席执行官Lisa Su博士手持MI350系列

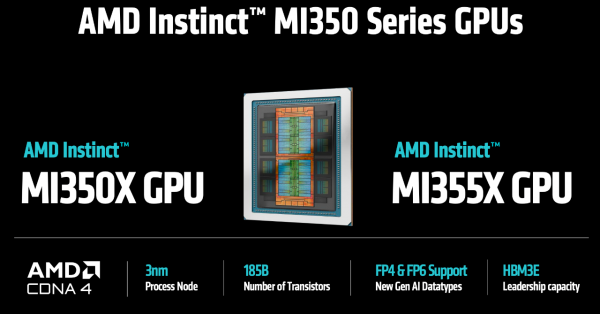

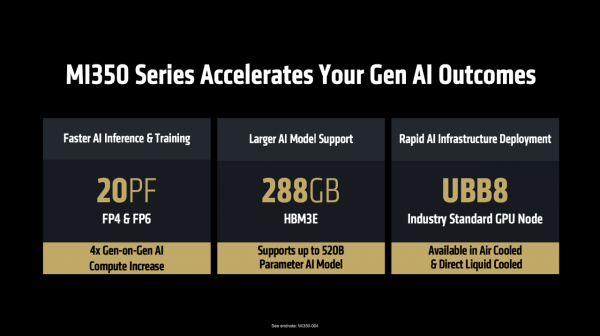

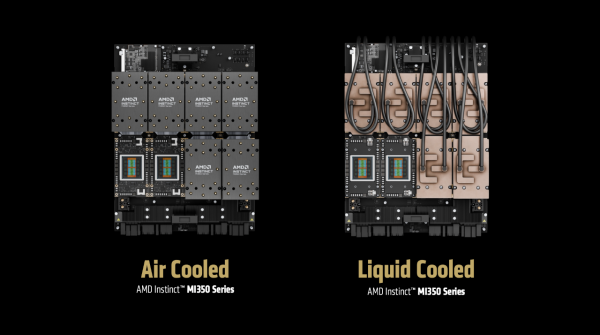

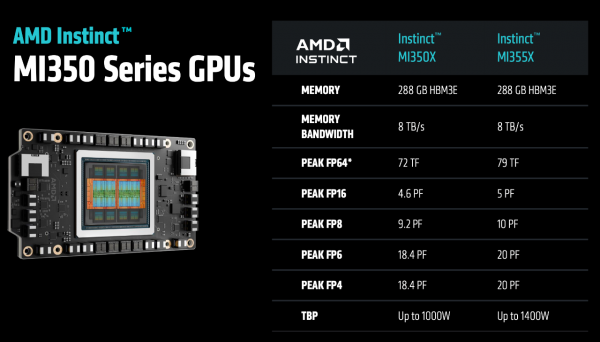

具体来看,MI350系列采用CDNA 4 GPU架构,3纳米,它的特点是:1、更快的AI训练和推理:AI算力较上代提升4倍,在FP4精度下可达20PF,同时在FP6精度下可提升训练和推理的速度;2、支持更大的大模型:由于每个模块都配备了288GB HBM3E高性能内存,所以单个GPU就能运行5200亿参数的模型,可想而知,这就有利于降低大模型推理的成本;3、支持快速部署AI基础设施:该系列基于行业标准的UBB8平台,支持“风冷”和“液冷”两种散热方案。

当然,为了适应多样化的数据中心环境,MI350 系列推出了两款型号:MI355X 和 MI350X。两者共享一样的计算架构和内存规格,但在功耗和散热方案上却不一样:MI355X 追求极致性能,功耗较高,主要面向最高效的液冷散热环境;而 MI350X 则更注重能效,功耗较低,支持风冷和液冷两种散热方式,这种灵活性让它能够“在现有基础设施上快速部署和应用”。

提到数据中心的散热方式,此处有必要插入AMD副总裁兼数据中心加速业务总经理 Andrew Dieckmann的观点。他在前一天的媒体沟通会上指出:“2025年是液冷技术的重要里程碑”——目前所有在建的数据中心、以及前期规划中的数据中心项目,基本都将采用液冷方案,这是因为它能带来更低的TCO,长远来看更具经济效益,这是AMD前进的方向;同时,风冷市场需求依然强劲,尤其是在企业内部部署场景中,AMD也会推出相应的产品线。

继续说回 MI350 系列的性能,俗话讲“是骡子是马拉出来溜溜”,「性能」一直都是衡量 AI 加速器的标尺,AMD此次也摆出了MI350 系列与其他产品的直接对标,不仅对标自家产品,还对标友商NVIDIA的产品。

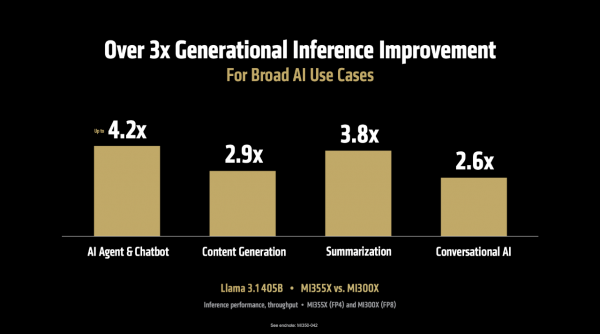

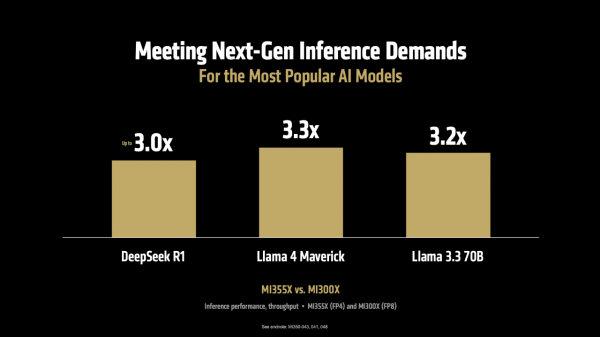

首先,在推理性能方面。MI355X 对比上一代 MI300X,在运行 Llama 3.1 405B(4050亿参数)这样的大模型时,推理吞吐量最高提升可达 4.2 倍,在AI Agent、内容生成、文本摘要、聊天对话等多种场景中,整体性能也提升了3-4倍。而且,这一优势并不仅限于特定模型,在 DeepSeek R1、Llama 3.3 70B、Llama 4 Maverick等多个典型模型上,吞吐量均实现了超过 3 倍的性能提升。

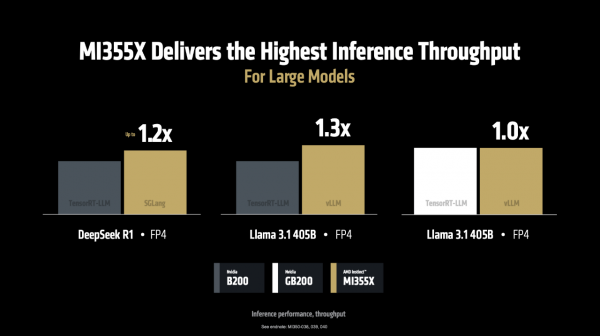

当运行 DeepSeek R1和 Llama 3.1 405B 模型时,在使用 SGLang、vLLM 等流行的开源推理框架时,MI355X的性能比使用专有框架(TensorRT-LLM)的NVIDIA B200 更胜一筹。如下图,MI355 相比 B200 分别在SGLang、vLLM上每秒处理的 token 数量高出1.2倍、1.3 倍,在vLLM上每秒处理的 token 与 NVIDIA GB200持平。

更重要的是,这种性能优势直接转化为成本优势:“每美元能处理40%的token”,这意味着客户不仅能获得更快的推理速度,还能大幅降低服务成本,这对于以 token 计费的 AI 应用来说是致命的诱惑。

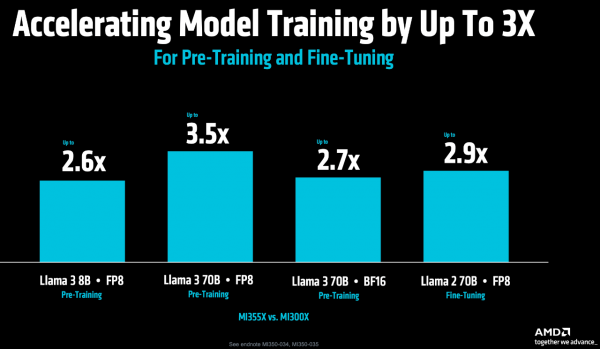

其次,在更关键的模型训练方面。MI355X 对比 MI300X,在Llama 3 70B预训练的吞吐量提升 3.5 倍,在Llama 2 70B模型微调方面的性能提升 2.9 倍,这就有利于缩短从开发到部署的周期。

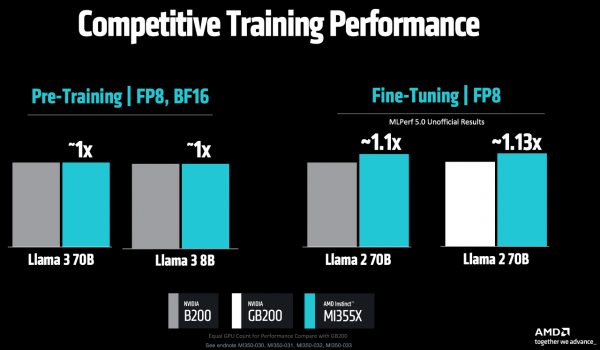

在Llama 3 70B/8B的预训练任务中,MI355X 对比 NVIDIA B200,两者性能旗鼓相当;而在最新的MLPerf V5.0基准测试中,MI355X 在Llama 2 70B模型微调方面的性能,对比B200和GB200分别快1.1倍、1.13倍。

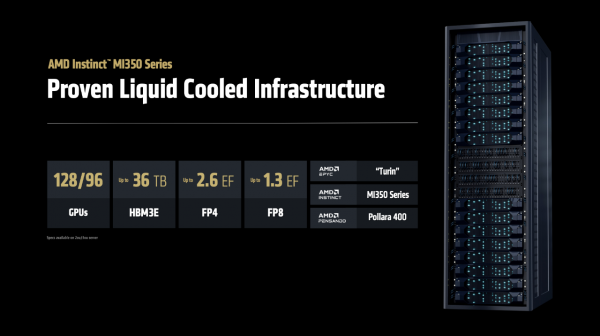

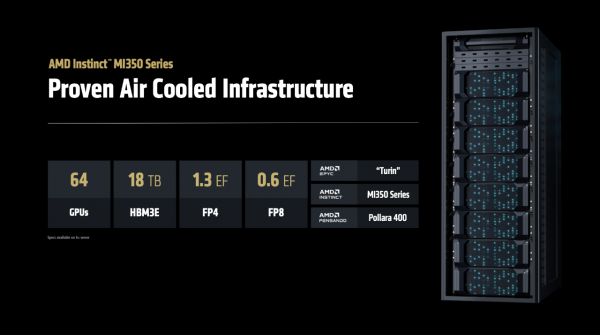

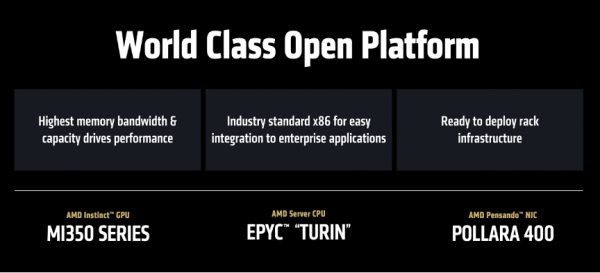

基于MI350系列,各家OEM厂商推出了采用AMD技术的AI机架方案,整合了EPYC CPU、Instinct GPU和Pensando DPU,全部整合为一体化解决方案。在大规模部署环境中,单个液冷机架最多可容纳96个GPU,甚至可扩展至128个GPU,配备2.6 ExaFLOPS FP4算力和36TB HBM3e高速内存。而在风冷散热系统的部署方案中,MI350系列机架单柜可支持64个GPU,兼容传统数据中心的部署环境。

“这样的灵活性和多样化选择是客户真正需要的,他们希望用最少的工作量和最小的干扰,实现数据中心快速部署,这正是MI350能够实现的功能。”Lisa Su博士强调。

据悉,MI350系列已于本月初开始量产出货,首批合作伙伴也将按期发布服务器产品,并在第三季度推出公有云服务。AMD指出,下图的名单是MI350系列的合作伙伴,但这不是全部,还会陆续更新。

ROCm 7:只有硬件是不够的,软件生态是开发者构建AI的画笔

如果说硬件是 AI 计算的“肌肉”,那么软件生态就是它的“神经系统”。“硬件性能固然出色,但真正释放其全部潜力的关键在于软件。”Lisa Su博士将话题转向了AMD的软件生态——ROCm。

说到软件生态,AMD有ROCm,NVIDIA有CUDA,但是大家往往不会把两者相提并论,为什么?

对于这个犀利问题,AMD人工智能事业部企业副总裁 Ramine Roane是这样回答的:

“我们开发了HIP语言,它和CUDA有90%相似,可以说是一个亲兄弟。我们甚至提供了叫HIPify的转换工具,只需几行代码就能把CUDA程序转成HIP格式。

但其实现在更重要的趋势是,开发者已经不需要直接接触底层编程了。你可以直接用PyTorch、Jax或者从Hugging Face下载模型,这些在我们平台上的使用体验,跟在英伟达平台上完全一样。

对于那些确实需要写底层代码的高级开发者,除了用HIP之外,现在业界有个更好的趋势——使用Triton这样的通用编译器。这是OpenAI开发的工具,微软、Meta都在用,它接收Python风格的代码,然后自动为不同硬件平台生成最优代码。简单到什么程度?我们比赛中有个16岁的高中生,仅靠编写简单的Python代码就进入了前20名。

行业正在从硬件专用语言转向通用语言,因为只要性能达标,大家都更愿意用一种代码运行在任何硬件上,而不是被特定平台绑定。”

弦外之音就是在说,CUDA的护城河其实没有想象中那么深不可破,每当有新的GPU架构出现时,无论是NVIDIA自己的还是竞争对手的,所有人都必须重新优化底层代码,相当于回到同一起跑线。而开源生态的优势在于集众人之力,速度更快,创新更活跃,AMD正是借助这一点来撼动NVIDIA的市场主导地位。

好,让我们回到现场。

AMD人工智能事业部高级副总裁Vamsi Boppana用一句话概括ROCm的愿景——打造开放共享的、可扩展的软件平台,让AI创新惠及全球每一个人。

目前,已有超180万个Hugging Face模型可在ROCm上开箱即用。过去一年来,AMD加强了对JAX的支持,借助MaxText等程序库,JAX在训练项目中的应用日益广泛。更重要的是,AMD将软件更新频率从季度缩短至每两周一次,确保能够为最新的模型和框架提供“Day 0”支持。

但是AI 一直在工作,所以AMD也不能懈怠,于是正式发布——ROCm 7,重点优化了推理性能,目标是提升易用性和性能。其预览版将于 6 月 12 日向公众开放,正式版将于 8 月发布。

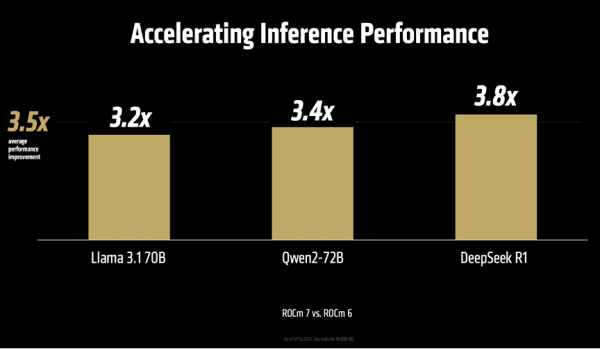

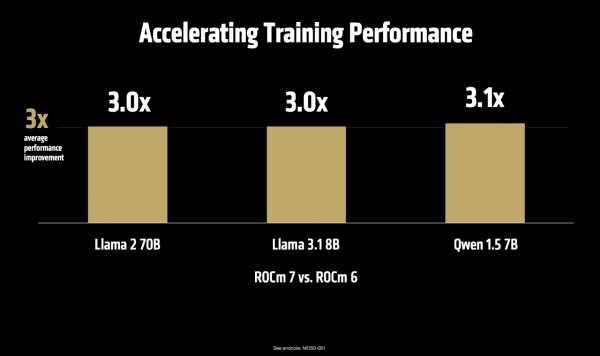

“我们全面更新了AI推理的技术架构。从VLLM和SGLang这些基础框架的升级,到提升服务性能、支持更高级的数据类型,再到开发高性能的核心程序,以及实现Flash Attention v3这样的前沿算法。我们让开发过程变得更简单,用类似Python的方式来整合各种核心功能。我们还大幅改进了系统内部的通信方式,这让ROCm 7的推理性能比上一代ROCm 6提升了3.5倍、训练性能提升了3倍。”Vamsi Boppana指出。

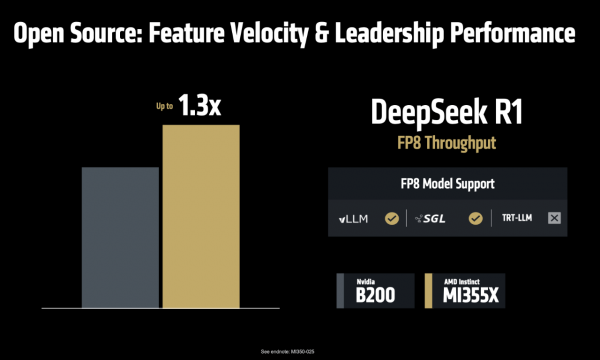

说到这里还不忘强调开源的好处,顺便硬刚一下友商。Vamsi Boppana说,“在AI推理服务的领域,我们越来越发现,开源的解决方案在功能更新速度和性能表现上都已超过不公开源代码的方案。比如VLLM和SGLang这样的开源框架,它们的代码更新速度非常快,已经领先实现了FP8这种优化功能,比那些闭源产品早很多。我们与这些开源社区密切合作,在DeepSeek FP8的测试中,MI355X系列比NVIDIA B200最多提高了1.3倍。这就是开放合作的力量,让我们能够快速行动,创造更多可能性。”

为了让开发者能够真正接触并使用 AMD 的技术,AMD 推出了一系列重磅举措:

首先,上线 AMD 开发者云平台(AMD Developer Cloud)。开发者只需一个GitHub或邮箱账户,即可轻松访问云端的Instinct GPU资源。Vamsi Boppana在现场宣布,“所有参加本次峰会的开发者,都将获得 25 小时的GPU免费使用券。”

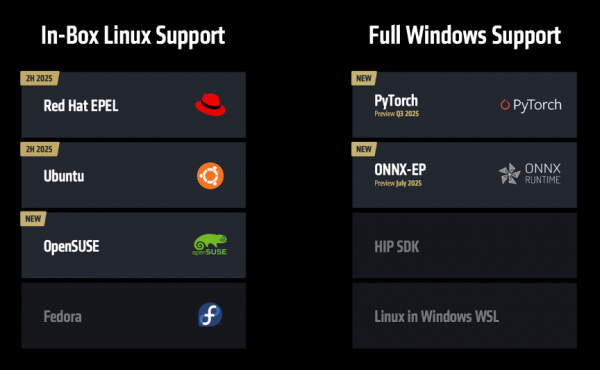

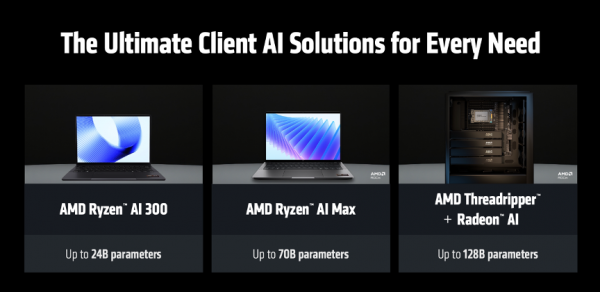

其次,全面支持 ROCm on Client。这曾是 AMD 的一个“痛点”,现在,ROCm将不再局限于云端和数据中心,而是将全面支持锐龙笔记本和工作站平台,并且首次正式支持 Windows 系统,这意味着开发者可以在自己的本地设备上,使用统一的软件环境进行AI开发和调试。同时,AMD 还将与红帽、Ubuntu、OpenSUSE 等主流 Linux 发行商合作,提供“inbox”支持,即 ROCm 将被预装在系统发行版中,免去用户繁琐的安装过程。

这意味着,开发者可以在自己的笔记本上运行 240 亿参数的模型,在 Threadripper 工作站上甚至可以运行 1280 亿参数的模型,这为本地化 AI 应用的开发和调试提供了前所未有的便利。

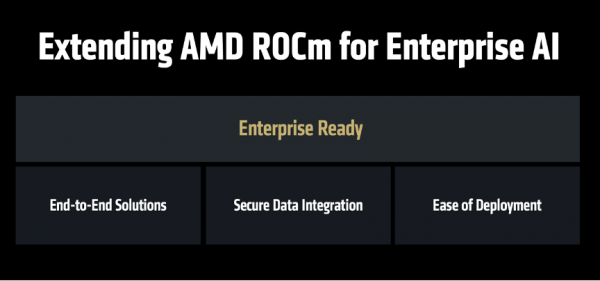

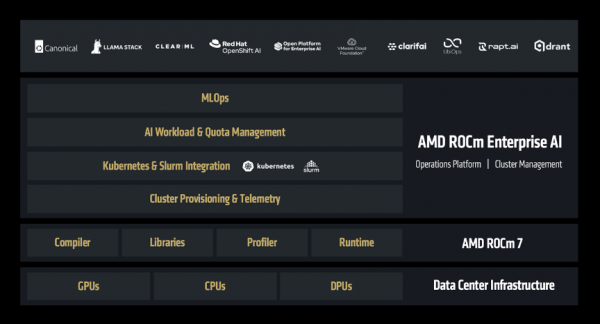

而且,AMD不只是希望ROCm惠及开发者,也希望ROCm惠及企业的开发者,于是正式推出——ROCm企业版。

ROCm企业版是一套完整的技术方案,涵盖了从集群管理到MLOps的各个环节,支持预训练、推理部署、以及端到端应用程序的开发。

网络成为新战场,除了看适用度,还要谈开放性

接下来,AMD数据中心解决方案事业部执行副总裁兼总经理Forrest Norrod登场,重点讲了AMD在网络技术方面的战略布局,同样强调了“开放”。

AMD方面指出,AI 模型规模每三年增长千倍,训练数据量每八个月翻一番,这种需求的增长速度已经远超硬件技术本身的发展,唯一的出路是通过创新的分布式系统架构,将成千上万的 GPU 连接成一个协同工作的整体——在这背后,网络正是实现这一切的基石。

当前,AI 网络市场主要有两种技术路线:专有的 InfiniBand 和开放的以太网。从AMD的角度,认为InfiniBand 缺乏扩展性;而以太网虽然具备扩展性,却并非为 AI 网络而设计。

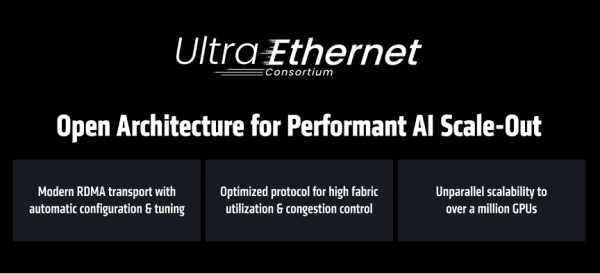

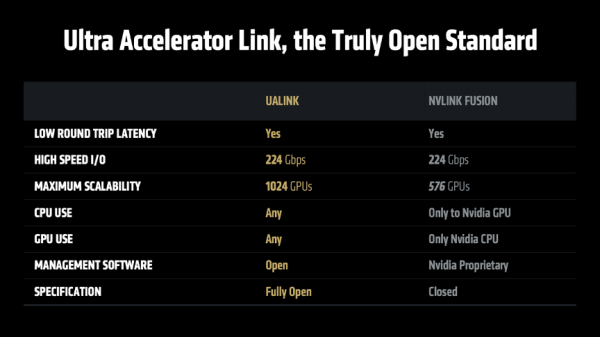

为了解决这一难题,AMD 提出了一个全面的、基于开放标准的网络创新战略,涵盖了从后端到前端、从横向扩展到纵向扩展的各个层面,那就是 Ultra Ethernet Consortium (UEC)。这是一个由 AMD、Arista、Broadcom、思科、Meta 等百余家行业巨头共同推动的开放标准,就是为了打造专为 AI 优化的下一代以太网。

同时,AMD 推出 Polara 400 AI 网卡,是业界首款支持 UEC 技术的解决方案。它不仅支持传统的 RoCEv2 RDMA 协议,还能通过软件升级,启用 UEC RDMA 功能。

此外,AMD 为 Helios 机架系统设计下一代互联芯片 Ultra Accelerator Link,这是一种新型存取架构,专为大规模AI系统设计,具有低延迟、高带宽等特性。它采用以太网物理接口层,可集成各类标准部件,降低成本并确保互连稳定性。

组合拳背后有底层逻辑:AMD的三大战略支柱

AMD此次打出了一套逻辑严密、环环相扣的组合拳,而回头再看Lisa Su博士在开场时讲的信息,就更好理解了。

Lisa Su博士的开场白直击当前AI的发展脉搏——“AI技术的创新速度之快,在我的职业生涯中都是绝无仅有的,2025年AI发展速度更是一路飙升,进入一个全新篇章,其标志就是「代理式AI(Agentic AI)」的崛起。”

在Lisa Su博士看来,代理式AI就像是一种全新的“数字员工”,与以前只会做单一任务的AI不同,这些代理式AI能够24小时不间断工作、不断学习和分析海量数据,并且可以直接与公司各种系统互动,自己做决定和完成工作。她随后说道:“我们正在引入数十亿个代理式AI,它们可以帮助我们工作。”

这种范式转移,对计算设备提出了三大新要求:

第一,要超强的GPU计算能力。这些AI要实时分析数据、进行深度思考,就像人脑需要更多内存空间存储和处理信息一样。

第二,要强大的CPU处理器。因为这些AI助手在工作时不仅要思考,还要同时处理各种日常任务,比如查询数据库、与其他系统沟通等,这些都需要传统计算力支持。

第三,要安全高效的网络连接。所有这些计算部件必须通过快速、安全、稳定的网络连接在一起,才能形成完整的工作系统。

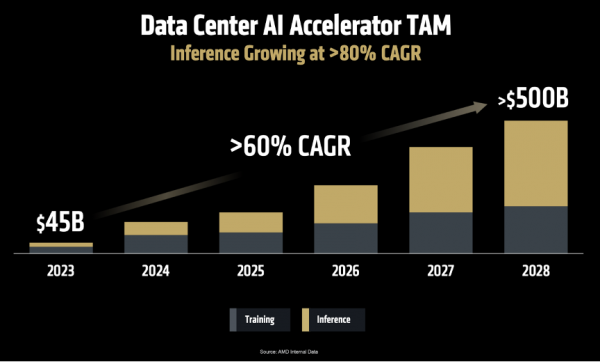

面对如此巨大的变革,市场机遇也随之而来。Lisa Su博士重申了AMD在去年做出的预测:

第一,到2028年,数据中心AI加速器的市场规模将增长至5000亿美元,年增长率超过60%;

第二,AI推理能力将成为AI的核心动力。“AMD预计AI推理市场的年增长率将超过80%,未来将成为AI计算领域最大的增长引擎。而高性能GPU,凭借其出色的灵活性和强大的编程能力,将在这个市场占主导地位。”

面对广阔的市场和复杂的需求,Lisa Su博士指出,AMD有三大核心战略,这构成了其在AI时代竞争的基石:

第一,提供最多元化的计算引擎产品线。AMD认识到AI并非“一种方案通吃”,不同的应用场景需要不同的计算方案。因此,AMD提供了业内最完整的端到端计算解决方案,涵盖CPU、GPU、DPU、网卡、FPGA和自适应芯片等各类处理器,确保“无论在任何场景部署AI,无论你需要多大的算力,AMD都能满足你的需求。”

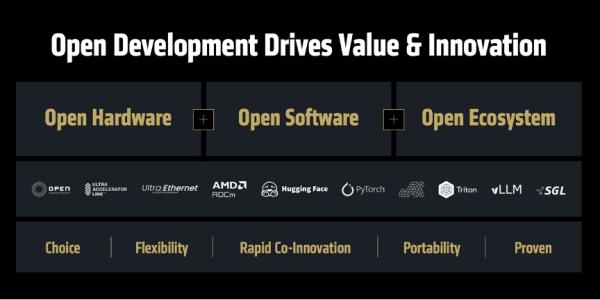

第二,构建以开发者为中心的开放生态系统。Lisa Su博士在演讲中反复强调“开放”的重要性。“回顾历史可以发现,许多重大技术突破最初都是采用封闭模式的,但行业发展历程反复证明,开放才是创新腾飞的关键。”她以Linux超越Unix、Android的成功为例,论证了开放生态如何促进良性竞争、加速创新并最终让用户获益。因此,AMD全面支持各大主流框架,将ROCm软件生态开源,并积极主导和参与UEC、UAL等开放行业标准,都是在“凝聚行业力量,让每个人都能参与AI创新”。

第三,提供端到端解决方案。随着AI系统日趋复杂,客户要的不再只是单颗芯片,而是经过整合优化的全栈解决方案。为此,AMD近年来通过自身发展和战略并购(如收购ZT、Nod.ai、Silo.ai、Lamini等公司),不断增强其在机架级设计、软件和编译器等领域的技术实力,从而为客户提供“开箱即用”的AI平台。“过去一年间,AMD已完成超25项战略投资,有效拓展了合作伙伴网络,并为未来AI软硬件领域的创新企业提供支持。”Lisa Su博士指出。

清晰的战略打底,AMD 势如破竹:“全球十大 AI 公司中,已有七家正在大规模部署 AMD Instinct GPU。” 这份客户名单包括了微软、Meta、X.AI、Cohere、Reliance Jio 等科技巨头,以及众多充满活力的 AI 初创公司,似乎 AMD 的 AI 加速器已经成功渗透到全球最顶级的 AI 研发和生产环境中。

在传统的超级计算(HPC)领域,AMD 依然强势。在最新发布的全球超算 TOP500 榜单中,排名第一的“Frontier”和第二的“Aurora”超级计算机,其核心计算引擎均由 AMD 提供。同时,Instinct 平台获得了所有主流服务器 OEM 和 ODM 厂商的支持,并在 Azure、Oracle 等公有云以及很多新兴云服务商中上线,生态系统日益成熟。

如果用一个词概述这场发布,那一定是“开放”,从Lisa Su 博士到现场站台的每一位合作伙伴,都在反复强调开放标准和开源社区的重要性。这不仅是一种技术理念,更是一种高明的商业策略。面对NVIDIA凭借CUDA构建的坚固护城河,AMD选择的不是正面攻城,而是联合所有“城外力量”,另辟蹊径,建立一个新的、更开放的生态联盟。

峰会的最后,Lisa Su返场做总结,她说,“人工智能的未来不该局限于单一企业或封闭生态,这需要整个行业携手合作,共同开创。未来将由我们共同打造,每个人都贡献智慧,集思广益,通过协同创新,开创美好明天。”因为,“AI Everywhere,for Everyone(AI无处不在,惠及每个人)”

好文章,需要你的鼓励

SanDisk重塑经典SSD品牌:WD Black和Blue正式更名为Optimus系列

西部数据闪存业务分拆后,SanDisk宣布将停用广受欢迎的WD Black和Blue品牌,推出全新的SanDisk Optimus系列NVMe产品线。WD Blue驱动器将更名为SanDisk Optimus,而高端WD Black驱动器将分别更名为Optimus GX和GX Pro。尽管品牌变更,底层硬件和供应链保持不变。然而受全球内存短缺影响,预计2026年第一季度客户端SSD价格可能上涨超过40%。

上海AI实验室研究者想出妙招:让AI像优秀学生一样高效思考,告别“想太多“毛病

上海AI实验室开发RePro训练方法,通过将AI推理过程类比为优化问题,教会AI避免过度思考。该方法通过评估推理步骤的进步幅度和稳定性,显著提升了模型在数学、科学和编程任务上的表现,准确率提升5-6个百分点,同时大幅减少无效推理,为高效AI系统发展提供新思路。

福特汽车准备在车载系统中引入AI智能助手

福特汽车在2026年消费电子展上宣布将在车辆中引入AI助手技术。该AI助手最初将在福特和林肯智能手机应用中推出,从2027年开始成为新车型的原生功能。福特希望通过AI技术实现车辆个性化体验,提供基于位置、行为和车辆能力的智能服务。同时,福特将采用软件定义车辆架构,推出自研的高性能计算中心,提升信息娱乐、驾驶辅助等功能。

MIT团队让机器人终于不再“卡顿“:一种让机器人像人一样流畅反应的突破性技术

MIT团队开发的VLASH技术首次解决了机器人动作断续、反应迟缓的根本问题。通过"未来状态感知"让机器人边执行边思考,实现了最高2.03倍的速度提升和17.4倍的反应延迟改善,成功展示了机器人打乒乓球等高难度任务,为机器人在动态环境中的应用开辟了新可能性。

智能体驱动全球创新浪潮,微软携手前沿伙伴迈进消费电子新未来

达索系统在CES 2026上展示AI驱动的医疗创新, 重塑精准、可预测与个性化医疗

Arm 发布 20 项技术预测:洞见 2026 年及未来发

美光推出全球首款面向客户端计算的 PCIe 5.0 QLC SSD

SanDisk重塑经典SSD品牌:WD Black和Blue正式更名为Optimus系列

福特汽车准备在车载系统中引入AI智能助手

ChatGPT推出健康模式:结合医疗数据提供个性化建议

福特推出AI数字助理及新一代BlueCruise自动驾驶技术

联想Legion Pro可卷曲概念机展现移动大屏游戏新体验

印度和新加坡在智能体AI采用方面超越全球同行

华硕CES 2026新品:更小巧的ProArt GoPro笔记本和升级版Zenbook Duo

n8n警告CVSS满分漏洞影响自托管和云版本