昇思MindSpore安全技术助力OCR云服务通过国际最高水平安全认证

近日,昇思MindSpore支撑华为OCR云服务正式通过独立机构的AI C4审计认证,安全目标100%达成。这标志着昇思MindSpore的安全能力达到了业界领先水平,能够满足业界最高水平的AI云服务审计要求。此前,在德国,华为基于业务用例的试点项目向德国联邦信息安全办公室(BSI) 提供建议,支持其发布了AI云服务合规标准目录(AI C4),这是业界首个面向AI云服务的安全标准。

伴随着人工智能不断发展,在极大提升人们生产生活品质的同时,AI具有的技术特性如通用目的性、算法黑箱性以及数据依赖性等,在社会、企业、个人等维度引发了不小的风险与挑战,仅凭C5标准还不足以完全应对。为此,德国联邦信息安全局制定了一项特定于AI云服务的审计标准AI C4(AI Cloud Service Compliance Criteria Catalogue)——该标准设定了安全的基线水平,可通过独立审计机构对于AI云服务在其生命周期内的安全性进行可靠评估。

OCR服务是利用光学设备对图像进行捕获并完成文字识别的过程,可兼顾达成人力节约与效率提升的双目标。但痛点就在于,当攻击者对待识别的文字做出肉眼不易察觉的修改时,将会导致实施算法的模型无法对该修改做出正确的识别或处理,造成OCR服务对文字的识别准确率下降,但使用人员却很难看到这问题背后的真因。

昇思MindSpore从开源AI框架的角度出发,围绕AI全生命周期,构建出以下重点技术能力:

①模型安全

通过鲁棒性评测、对抗测评、对抗训练、模型加密等,实现模型保护;

②隐私保护

构建了隐私评估、差分隐私训练、联邦学习等技术,保障数据隐私;

③可解释性

通过原创语义级可解释技术、可解释方法工具集等,提高模型的可解释性,增强用户理解度,让用户更信任并有效地使用模型。

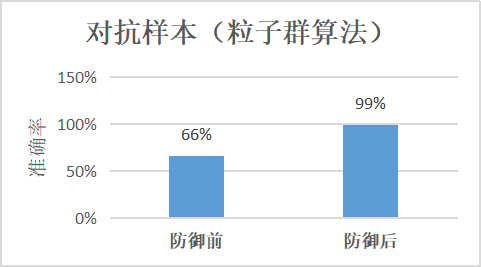

本次认证中,华为技术团队使用了昇思MindSpore模型安全评测工具MindSpore Armour对OCR服务进行安全性测评。从中发现,目前大多数OCR服务的算法模型均存在识别自然扰动和防御样本对抗能力差的问题,如文本框检测模型在校验噪声、PGD、PSO(粒子群)等攻击算法下的准确率小于66%。华为技术团队针对这些问题对模型开发进行指导,通过对抗样本检测、数据增强训练等技术,使模型对恶意样本的识别准确率达到 95+%,提高了模型及OCR服务的鲁棒性,达成了AI C4标准对AI云服务安全和鲁棒性的要求。

除助力华为OCR云服务通过AI C4认证外,昇思MindSpore率先出击,携手法荷多方权威评估和认证机构,在2021年完成了AI框架领域的认证标准制定,并于今年4月获得荷兰NSCIB颁发的CC EAL2+认证证书,填补了AI框架领域在安全标准上的空白,成为全球首个获得CC认证的AI框架,实现从0到1的突破。

此外,昇思MindSpore经过云计算开源产业联盟(OSCAR)评估,荣获全国首批《可信开源社区评估体系》认证。

在智能时代的浪潮中,昇思MindSpore致力于实现可信AI的最高要求,从安全技术和安全治理上不断提升AI安全水平。未来,昇思MindSpore仍将持续创新,与行业客户共同应对人工智能领域安全的风险与挑战,为客户提供更安全更可信的应用及服务。

来源:业界供稿

好文章,需要你的鼓励

埃森哲投资Profitmind,押注AI智能体变革零售业

埃森哲投资AI零售平台Profitmind,该平台通过智能代理自动化定价决策、库存管理和规划。研究显示AI驱动了2025年假日购物季20%的消费,约2620亿美元。部署AI代理的企业假日销售同比增长6.2%,而未部署的仅增长3.9%。Profitmind实时监控竞争对手价格和营销策略,并可创建生成式引擎优化产品文案。

上海AI实验室让机器人“睁眼看世界“:用视觉身份提示技术让机械臂学会多角度观察

上海AI实验室联合团队开发RoboVIP系统,通过视觉身份提示技术解决机器人训练数据稀缺问题。该系统能生成多视角、时间连贯的机器人操作视频,利用夹爪状态信号精确识别交互物体,构建百万级视觉身份数据库。实验显示,RoboVIP显著提升机器人在复杂环境中的操作成功率,为机器人智能化发展提供重要技术突破。

CES 2026:日立与英伟达、谷歌云、Nozomi Networks达成合作协议

日立公司在CES 2026技术展上宣布了重新定义人工智能未来的"里程碑式"战略,将AI直接应用于关键物理基础设施。该公司与英伟达、谷歌云建立重要合作伙伴关系,并扩展其数字资产管理平台HMAX,旨在将AI引入社会基础设施,变革能源、交通和工业基础设施领域。日立强调其独特地位,能够将AI集成到直接影响社会的系统中,解决可持续发展、安全和效率方面的紧迫挑战。

英伟达团队突破AI训练瓶颈:让机器人同时学会多种技能不再“顾此失彼“

英伟达研究团队提出GDPO方法,解决AI多目标训练中的"奖励信号坍缩"问题。该方法通过分别评估各技能再综合考量,避免了传统GRPO方法简单相加导致的信息丢失。在工具调用、数学推理、代码编程三大场景测试中,GDPO均显著优于传统方法,准确率提升最高达6.3%,且训练过程更稳定。该技术已开源并支持主流AI框架。

OpenAI与软银联手投资10亿美元,助力星门项目能源伙伴发展

Uber联合Lucid和Nuro发布全新自动驾驶出租车

始于Token,不止于Token

埃森哲投资Profitmind,押注AI智能体变革零售业

CES 2026:日立与英伟达、谷歌云、Nozomi Networks达成合作协议

2026年科技行业多元化发展前景与挑战预测

智能体AI推动云安全策略根本性变革

Salesforce推出AI能力框架助力企业数字化转型

大众汽车牵手高通打造智能网联座舱体验

Ruby 4.0.0发布:引入ZJIT编译器和Ruby Box隔离技术

Meta签约三家核能公司为AI数据中心提供6.6吉瓦电力

大多数开发者不信任AI生成代码却不检查

昇思MindSpore 2.3全新发布 | 昇思人工智能框架峰会2024圆满举办

中国光谷·多模态人工智能大会暨多模态人工智能产业联合体第三次全体会议圆满召开

Nature子刊发表!基于昇思MindSpore打造的AI+科学计算新成果PeRCNN面世

WAIC2023最高荣誉SAIL奖揭晓!昇思MindSpore使能大模型、AI4S打造流体仿真重器

人工智能框架生态峰会2023·昇思MindSpore科学智能专题论坛顺利举办

人工智能框架生态峰会MindSpore TechDay成功举办,一起昇思,无尽创新

人工智能框架生态峰会2023顺利举办,助力产教融合,使能千百行业

人工智能框架生态峰会2023丨软通动力成为昇思MindSpore开源社区理事会首批成员单位

基于昇思AI框架的全模态大模型“紫东.太初2.0”正式发布

昇思MindSpore与产学界共同探索大模型&科学智能原生创新