Omdia《中国人工智能框架市场调研报告》: 预训练大模型、AI for Science等成为产业焦点

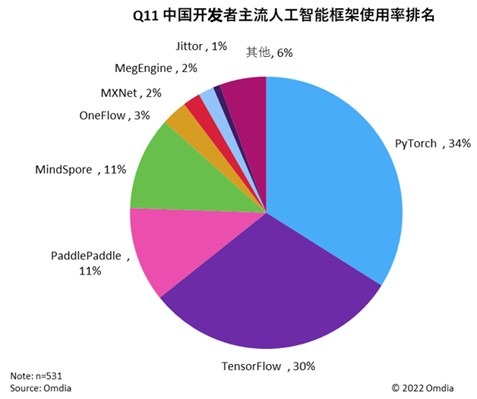

行业研究机构Omdia(Informa tech集团旗下)发布《中国人工智能框架市场调研报告》,指出中国AI框架市场竞争格局与创新趋势。Omdia调研发现,PyTorch、TensorFlow与MindSpore在知名度与市场份额上处于第一梯队。

人工智能随着技术的发展逐渐出现在大众眼前,作为新兴产业,市场规模不断扩大,应用场景也随着人工智能技术的成熟而扩展。从科研创新到产业应用落地,预训练大模型、AI for Science、负责任的AI等已成为全球学术界、产业界的焦点。AI框架是模型算法开发的核心,是支撑人工产业繁荣发展的基础,因此Omdia深入研究了AI框架的发展与产业趋势。

时下,以ChatGPT为代表的大模型获得的瞩目已经超越学术界、产业界,成为所有人的关注的创新成果,而大模型需要有强大的AI框架技术支撑。报告指出预训练大模型的三大趋势:第一,大模型参数量继续呈指数增长态势,“大模型”正走向“超大模型”;第二, 大模型正从单模态走向多模态、多任务融合; 第三,人工智能框架对大模型的训练有关键性的技术支撑作用。

在支持超大规模模型训练开发方面,全球领先的人工智能框架TensorFlow和PyTorch仍然占据领导地位;同时,开发者认为在中国本土人工智能框架中昇思MindSpore已占据优势地位,原生支持大模型,并孵化出了一系列创新大模型。

Omdia通过与专家深度访谈,发现TensorFlow由于有了JAX这一新生框架的融入,给业界带来更多期待;PyTorch则是依托第三方并行算法库补充了大模型支持能力;在中国本土市场上, 百度飞桨和昇思MindSpore由于有独特的中国本土语言和数据优势,更能在支持本土预训练大模型方面取得成功。

在以ChatGPT为代表的AIGC火爆的背后, 也出现了“造假”等AI伦理道德问题,人工智能开发者和机构越来越关注“负责任的人工智能”。 Omdia在对开发者的调研中发现,在所有主流人工智能框架中,TensorFlow 与MindSpore 对“负责任的人工智能”提供的支持能力最好,分别是第一与第二名。

同时,《中国人工智能框架市场调研报告》指出,“负责任的人工智能”既是一套道德准则, 又是一套技术体系。“负责任的人工智能”是以安全、可靠和合乎道德的方式开发、评估、部署和规模化人工智能系统的方法。人工智能框架引入众多的技术手段和可信AI功能模块,帮助开发者打造可信AI,帮助开发者和机构解决人工智能的安全隐私等合规性问题, 实现人工智能的可持续发展。

在科研创新领域,“AI for Science”也是人工智能行业的前沿热点,人工智能与科学的深度融合正在推动科研范式的创新,给科研领域带来了新的发展机遇。Omdia的分析师认为,与大模型类似,“AI for Science”是AI创新发展的新的重要方向,而人工智能框架对“AI for Science”的发展起着关键的技术支撑作用。“AI for Science”的发展对人工智能框架提出了更高的要求,调研发现,中国的人工智能开发者认为昇思MindSpore是最适合做 “AI for Science”项目的国产人工智能框架, 其对“AI for Science”的支持能力甚至超过了PyTorch,并有赶超TensorFlow的趋势。

人工智能框架作为AI创新的重要基础,将助力行业加速智能化转型升级。更多人工智能框架调研发现,请查看《中国人工智能框架市场调研报告》。Omdia报告链接:

https://omdia.tech.informa.com/commissioned-research/articles/china-ai-frameworks-market-report-2023

好文章,需要你的鼓励

让AI记住房间每个角落:悉尼大学团队如何让视频生成拥有“空间记忆“

悉尼大学和微软研究院联合团队开发出名为Spatia的创新视频生成系统,通过维护3D点云"空间记忆"解决了AI视频生成中的长期一致性难题。该系统采用动静分离机制,将静态场景保存为持久记忆,同时生成动态内容,支持精确相机控制和交互式3D编辑,在多项基准测试中表现优异。

西班牙病毒如何将谷歌带到马拉加

33年后,贝尔纳多·金特罗决定寻找改变他人生的那个人——创造马拉加病毒的匿名程序员。这个相对无害的病毒激发了金特罗对网络安全的热情,促使他创立了VirusTotal公司,该公司于2012年被谷歌收购。这次收购将谷歌的欧洲网络安全中心带到了马拉加,使这座西班牙城市转变为科技中心。通过深入研究病毒代码和媒体寻人,金特罗最终发现病毒创造者是已故的安东尼奥·恩里克·阿斯托尔加。

马里兰大学突破性发现:AI推理过程终于有了“身体检查“——ThinkARM框架揭开大型语言模型思维奥秘

马里兰大学研究团队开发ThinkARM框架,首次系统分析AI推理过程。通过将思维分解为八种模式,发现AI存在三阶段推理节律,推理型与传统AI思维模式差异显著。研究揭示探索模式与正确性关联,不同效率优化方法对思维结构影响各异。这为AI系统诊断、改进提供新工具。

全国首批10城菁彩Vivid影厅启幕,《山河故人》重映见证影像新纪元

工业和信息化部人形机器人与具身智能标准化技术委员会成立大会暨第一次全体委员会议召开

生命科学计算测试专委会正式成立,BioProfile框架引领行业标准建设

超智算完成北京核心智算中心资产收购,加速构筑“3+X”全国算力网络新格局

走出“参数崇拜”:联想用“一体多端”重塑“人的尺度”

从“单点突破”到“一体多端”:拆解天禧AI 3.5进化背后三年的进化哲学

openGauss Summit 2025在京召开,加速行业智能化变革,共建繁荣数据库生态

2025联想天禧AI生态伙伴大会:天禧AI一体多端,与开发者共建个人AI生态

西班牙病毒如何将谷歌带到马拉加

LangChain核心库曝出严重漏洞,AI智能体机密信息面临泄露风险

Mill如何与亚马逊和全食超市达成合作协议

TechCrunch创业大赛中的9家顶尖生物技术初创公司

DeepSeek之后,中国人形机器人以“群体智能”再次掀起技术浪潮

QwQ-32B模型成本地部署福音,通义App可第一时间体验

入局智驾的印奇,看到了怎样的未来?

成本打到6万以下,手把手教你用4路锐炫显卡+至强W跑DeepSeek

千里科技亮相吉利AI智能科技发布会,共启“AI+车”新纪元

天翼云CPU实例部署DeepSeek-R1模型最佳实践

京东云与宝德计算战略签约,共绘分布式存储与智算新未来

全球AI顶会AAAI 2025 在美开幕,产学研联手的“中国队”表现亮眼

蚂蚁数科提出创新跨域微调框架ScaleOT入选全球AI顶会AAAI 2025

国产软件再破记录!阿里云PolarDB数据库登顶TPC-C双榜第一