AIGC行业深度:发展情况、商业模式、产业链深度梳理

自 2023 年以来,全球对 AIGC 产业的关注越来越广泛。随着 AI2.0 时代的到来,AIGC 不仅仅是将 AI 能力融入到现有应用中那么简单,更是迎来了未来产业范式的再塑造。AI 正在跳跃式地加速渗透到各行 各业,并推动了一场新的生产力和创造力革命。随着 AIGC 产业的发展,AI 产业链各环节参与者的角色、 功能和产品服务将不断调整。未来 AIGC 产业的前景也会更加广阔。

在本文中,我们将以 AIGC 为主题,分析目前行业发展的情况,梳理相关驱动政策,探究 AIGC 产业的 商业模式。接下来,我们将对 AIGC 的产业链进行梳理,针对重点可关注环节进行详细讲解,介绍相关 公司。最后,根据以上内容分析行业未来发展趋势。

AIGC(AI-Generated Content)本质上是一种内容生产方式,即人工智能自动生产内容,是基于深度学 习技术,输入数据后由人工智能通过寻找规律并适当泛化从而生成内容的一种方式。过往的内容创作生 态主要经历了 PGC、UGC 到 AIUGC 的几个阶段,但始终难以平衡创作效率、创作成本及内容质量三者 之间的关系,而 AIGC 可以实现专业创作者和个体自由地发挥创意,降低内容生产的门槛,带来大量内 容供给。

中国 AIGC 产业市场规模

根据第 50 次《中国互联网络发展状况统计报告》,截至 2022 年 6 月,中国互联网普及率已高达 74.4%。在网民规模持续提升、网络接入环境日益多元、企业数字化进程不断加速的宏观环境下,AIGC 技术作为新型内容生产方式,有望渗透人类生产生活,为千行百业带来颠覆变革,开辟人类生产交互新 纪元。艾瑞咨询预测,2023 年中国 AIGC 产业规模约为 143 亿元,随后进入大模型生态培育期,持续 打造与完善底层算力基建、大模型商店平台等新型基础设施,以此孕育成熟技术与产品形态的对外输出。 2028 年,中国 AIGC 产业规模预计将达到 7202 亿元,中国 AIGC 产业生态日益稳固,完成重点领域、 关键场景的技术价值兑现,逐步建立完善模型即服务产业生态,2030 年中国 AIGC 产业规模有望突破 万亿元,达到 11441 亿元。

多模态已成趋势

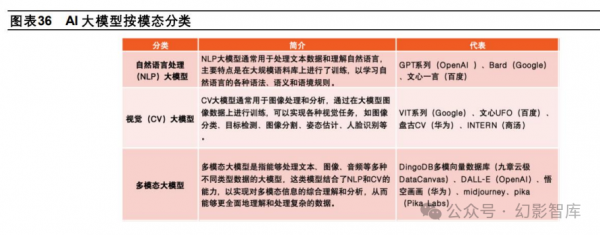

按模态划分,大模型可分为自然语言处理(NLP)大模型,视觉(CV)大模型、多模态大模型等。按 应用场景划分,大模型可分为通用大模型和行业大模型。通用大模型是指可在不进行微调或少量微调的 情况下完成多场景任务的大模型,具有强大的泛化能力,ChatGPT、华为盘古大模型以及最新发布的 Gemini 都是通用大模型。行业大模型则利用行业知识对大模型进行微调,以满足在金融、汽车、传媒 等不同领域的需求,如金融领域的 BloombergGPT、汽车领域的毫末 DriveGPT、法律领域的 LawGPT_zh 等。

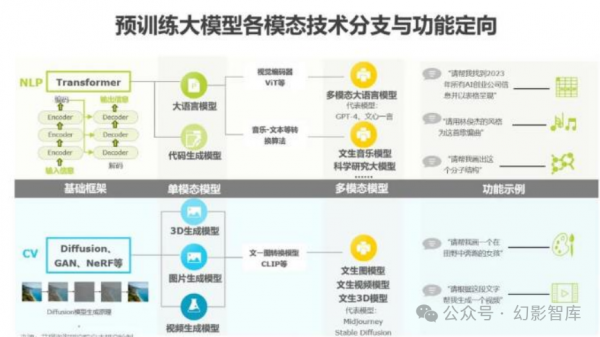

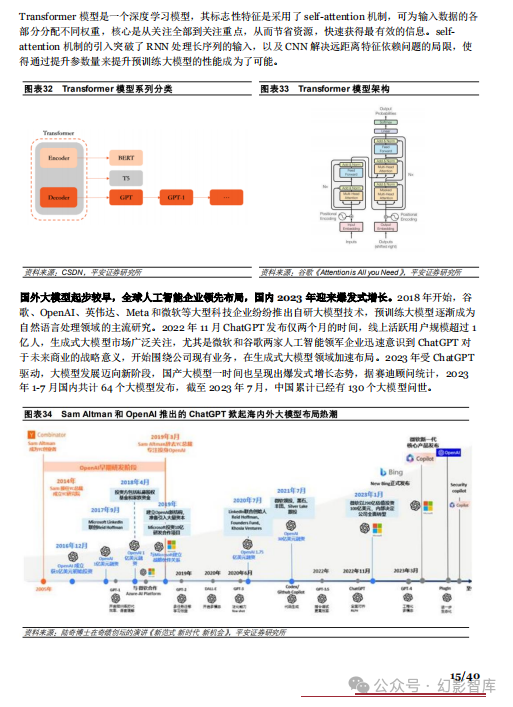

预训练大模型按照模态可以分为文本、图像、视频、代码、音乐生成等多种,但从底层架构上都分属两 类。Transformer 是一种编解码模型框架,适用于处理文本、代码这类强连续性生成任务;Diffusion、 GAN、NeRF 等框架善于处理图像生成类任务。叠加文-图转换技术可以形成文生图模型。由单模态模型 在实际训练时融合其他模态技术,可形成多模态、跨模态大模型,如 GPT-4、文心一言、Midjourney 等,由于多模态模型可接受文本、图像等不同输入输出形式,对应用场景能够更广泛适配,着力发展多 模态模型成为产研两界共同趋势。

产业链分析

AIGC 产业可分为三层,其中模型层和应用层值得关注。AIGC 现有产业链由数据供给、模型开发与定 制、应用与分发构成。目前来看,模型层为关键因素之一;其次,应用层发展空间巨大。上游数据供给 由收集大量原始数据对其进行预处理,以便提供给模型训练,投资确定性强。在中游,使用注释数据开 发和训练 AI 模型以生成内容,在垂直细分领域进行二次开发,来适应定制化需求;下游协助用户使用 模型和算法生成内容,例如:文本、图像、视频等。基于不同的价值创造逻辑,将生成的内容分发到各 种渠道。

好文章,需要你的鼓励

“今年DeepSeek、Gemini分别触响红色警报”:奥特曼首次详解OpenAI千亿AI算力投资背后的商业逻辑

2025年12月18日,OpenAI CEO山姆·奥特曼(Sam Altman)做客Big Technology Podcast,与主持人Alex Kantrowitz进行了一场长达近一小时的深度对话。

从一百万个视频编辑样本到AI剪辑师:蚂蚁集团如何让机器学会按照你的话改视频

这项由蚂蚁集团、香港科技大学等机构研究者完成的工作提出了Ditto框架,通过创新的数据生成管道解决了视频编辑领域的数据稀缺问题。研究团队生成了包含一百万个高质量视频编辑样本的Ditto-1M数据集,并基于此训练了Editto模型。该模型在多项评估中显著超越现有方法,实现了更精准的指令遵循和更好的时间一致性,为指令驱动的视频编辑树立了新的技术标杆。

图灵机的极限在哪里?DeepMind掌门人的终极追问与AGI路线图

2025年12月17日,Google DeepMind播客发布了本季收官之作。数学家Hannah Fry与公司联合创始人兼CEO Demis Hassabis进行了年度深度对话。

当AI学会了想象:阿里和中科院如何让视频生成模型突破创意的边界

这项由阿里巴巴和中科院联合完成的研究提出了ImagerySearch,一种创新的视频生成方法,能够帮助AI生成更好的创意和想象力十足的视频。研究团队还创建了LDT-Bench,首个专门评估AI在处理奇异场景能力的基准。实验表明,ImagerySearch在处理创意场景时相比现有方法有显著提升,为AI创意内容生成开辟了新的方向。