Open-Sora Plan项目:旨在重现 OpenAI 的视频生成模型Sora

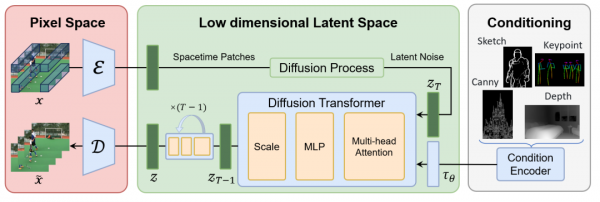

国内一个由北大和Rabbitpre AI发起的Open-Sora Plan的项目,旨在重现 OpenAI 的视频生成模型Sora。技术框架,如下所示:

Video VQ-VAE,这将视频压缩成潜在的时间和空间维度。

Denoising Diffusion Transformer。

Condition Encoder(条件编码器),这支持多个条件输入。

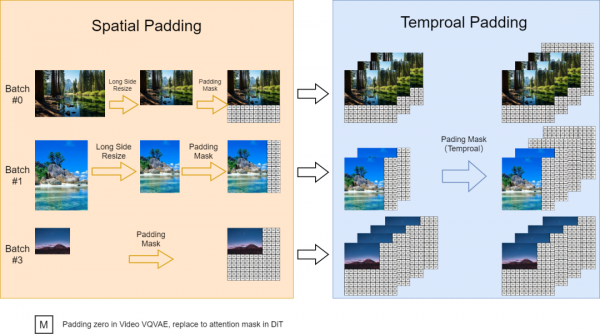

支持可变长宽比、可变分辨率和可变时长,如下所示:

可变长宽比,实现了并行批量训练的动态掩蔽策略,同时参考FIT保持灵活的纵横比。具体来说,调整高分辨率视频的大小,使其最长边为 256 像素,保持宽高比,然后在右侧和底部填充零,以实现一致的 256x256 分辨率。这有助于 videovae 批量编码视频,并方便扩散模型使用自己的注意力掩模对批量潜伏进行去噪。

可变分辨率,在推理过程中,使用位置插值来启用可变分辨率采样,尽管是在固定的 256x256 分辨率上进行训练。将可变分辨率噪声潜伏的位置索引从 [0, seq_length-1] 缩小到 [0, 255],以使它们与预训练范围对齐。这种调整使得基于注意力的扩散模型能够处理更高分辨率的序列。

可变时长,在VideoGPT中使用视频 VQ-VAE将视频压缩为潜在视频,从而实现多持续时间生成。将空间位置插值扩展到时空版本,以处理可变持续时间的视频。

参考文献:

[1] 项目地址:https://pku-yuangroup.github.io/Open-Sora-Plan/

[2] 代码:https://github.com/PKU-YuanGroup/Open-Sora-Plan

来源:NLP工程化

好文章,需要你的鼓励

OpenAI收购高管教练AI工具Convogo团队

OpenAI宣布收购商业软件平台Convogo的团队,该平台帮助高管教练、顾问和人力资源团队自动化领导力评估和反馈报告。OpenAI仅收购团队而非技术,三位联合创始人将加入OpenAI从事AI云服务工作。Convogo产品将停止运营。这是OpenAI一年内的第九次收购,主要目的是获取人才和能力。

AWS推出AI图像编辑新突破:用说话就能精准移动图片中的物体!

这项由香港中文大学和AWS团队联合开发的研究推出了TALK2MOVE系统,实现了用自然语言精准操作图片中物体的位置、角度和大小。该系统采用强化学习训练方式,通过空间感知奖励机制和智能步骤采样技术,在移动、旋转、缩放三类操作上的准确率显著超越现有方法,同时大幅降低了对昂贵训练数据的依赖,为AI图像编辑领域带来重要突破。

抛弃传统的市场推广手册,迎接AI时代的新策略

在Build Mode节目中,GTMfund合伙人Paul Irving分享了AI时代初创企业市场推广的实用建议。他强调当技术优势变得短暂时,分销渠道成为最后的护城河,每家公司都需要针对特定客户群体制定独特的市场策略。Irving建议专注于一到两个推广渠道,利用AI实现精准客户触达,并通过建立真实关系网络获得成功。

斯坦福大学等联合发布:AI助手在企业政策执行上竟然“偏科“得如此严重

斯坦福大学等知名机构联合研究发现,企业AI助手在执行组织政策时存在严重"偏科"问题:处理允许请求时成功率超95%,但拒绝违规请求时仅13-40%。研究团队开发的COMPASS评估框架通过8个行业5920个测试问题,揭示了AI助手普遍缺乏"拒绝技能"的问题,并提出了针对性训练解决方案。