Mamba再下一城!上海AI Lab提出视频领域新SOTA VideoMamba!

数源AI 最新论文解读系列

论文名:VideoMamba: State Space Model for Efficient Video Understanding

论文链接:https://arxiv.org/pdf/2403.06977.pdf

开源代码:https://github.com/OpenGVLab/VideoMamba

引言

视频理解的核心目标在于掌握时空表示,这本质上存在两个巨大挑战:短视频剪辑中存在的大量时空冗余,以及长上下文中复杂的时空依赖关系。尽管曾经占主导地位的3D卷积神经网络(CNNs)和视频变换器通过利用局 部卷积或长距离注意力有效地解决了其中一个挑战,但它们在同时解决这两 个挑战方面表现不佳。UniFormer试图整合这两种方法的优势,但在建模长 视频方面遇到困难,这已成为近期视频理解(gemini,lwm)和生成(sora, vlogger)研究的主要趋势。

简介

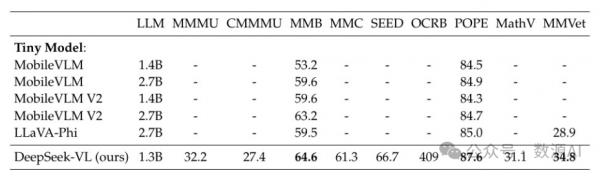

在视频理解中解决局部冗余和全局依赖的双重挑战,本文创新地将 Mamba 调整为视频领域。提出的 VideoMamba 克服了现有 3D 卷 积神经网络和视频变换器的局限性。其线性复杂度运算符实现了高效的长 期建模,这对于高分辨率长视频理解至关重要。广泛的评估揭示了VideoMamba的 四个核心能力:(1) 可扩展性 在视觉领域中无需大量数据集预训练,得益 于一种新颖的自蒸馏技术;(2) 敏感性 即使在细微运动差异下也能识别 短期动作;(3) 优越性 在长期视频理解方面,展示了相对于传统基于特征 的模型的显著进步;和 (4) 兼容性 与其他模态兼容,在多模态环境中展现 了稳健性。通过这些独特优势, VideoMamba 设立了视频理解的新基准, 为全面视频理解提供了可扩展和高效的解决方案。

方法与模型

1

Preliminaries

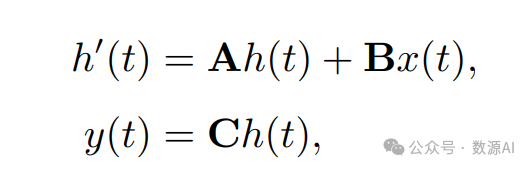

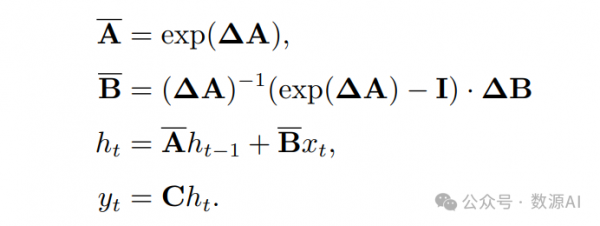

其中,A ∈ R N×N 代表系统的演化矩阵,B ∈ R N×1 , C ∈ R N×1 是投影 矩阵。这个连续的ODE通过现代SSM中的离散化来近似。Mamba [26] 是连续系统的离散版本之一,其中包括一个时间尺度参数 ?,用于将连续参数 A, B 转换为它们的离散对应物 A, B。这种转换通常采用零阶保持(ZOH) 方法定义如下:

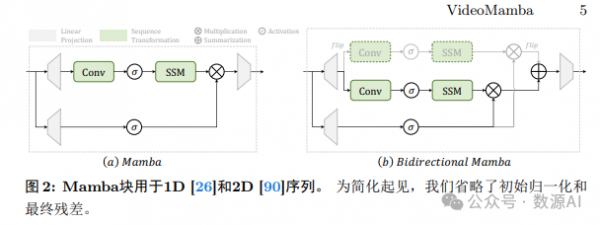

与主要依赖于线性时不变SSM的传统模型相反,Mamba通过实施选择 性扫描机制(S6)作为其核心SSM运算符而脱颖而出。在S6中,参数B ∈ R B×L×N,C ∈ R B×L×N和? ∈ R B×L×D直接从输入数据x ∈ R B×L×D中 导出,表明具有内在的上下文敏感性和自适应权重调节能力。图2a显示 了Mamba块的细节。视觉双向SSM。原始的Mamba块,设计用于1D序列,对于需要空间感知 的视觉任务来说表现不佳。在此基础上,Vision Mamba在图2b中引入了双 向Mamba(B-Mamba)块,为视觉特定应用程序调整双向序列建模。该块 通过同时进行前向和后向SSM处理扁平化的视觉序列,增强了其空间感知 处理能力。在本工作中,我们将B-Mamba块扩展到3D视频理解。

2

VideoMamba

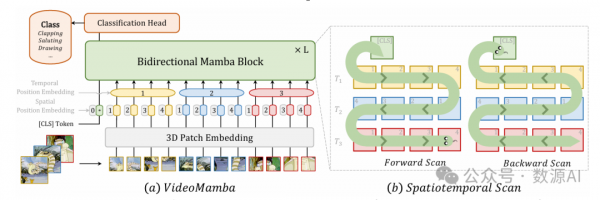

图 3展示了 VideoMamba的整体框架。具体来说,我们首先使用3D卷 积(即,1×16×16)将输入视频 Xv ∈ R 3×T ×H×W 投影到 L 个不重叠的时 空补丁 Xp

其中,Xcls 是一个可学习的分类标记,它被添加到序列的开头。在之前的研 究工作中 [2, 4, 16],我们添加了一个可学习的空间位置嵌入 ps ∈ R (hw+1)×C 和额外的时间位置嵌入 pt ∈ R t×C,以保留时空位置信息,因为 SSM 建模 对标记位置敏感。然后,标记 X 通过 L 个堆叠的 B-Mamba 块,并且最终 层的 [CLS] 标记的表示经过归一化和线性层进行分类处理。

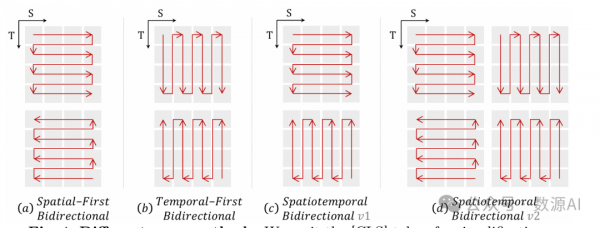

时空扫描。为了将B-Mamba层应用于时空输入,我们将原始的2D扫描扩展 为不同的双向3D扫描,如图4所示:(a) 空间优先,按位置组织空间令牌, 然后逐帧堆叠它们;(b) 时间优先,根据帧排列时间令牌,然后沿空间维度 堆叠;(c) 时空,既包含空间优先又包含时间优先,其中v1执行其中一半, v2执行全部(2×计算)。此外,我们在图7a中的实验表明,空间优先的双向 扫描是最有效且简单的。由于Mamba的线性复杂度,我们的VideoMamba 能够高效处理长时间高分辨率的视频。

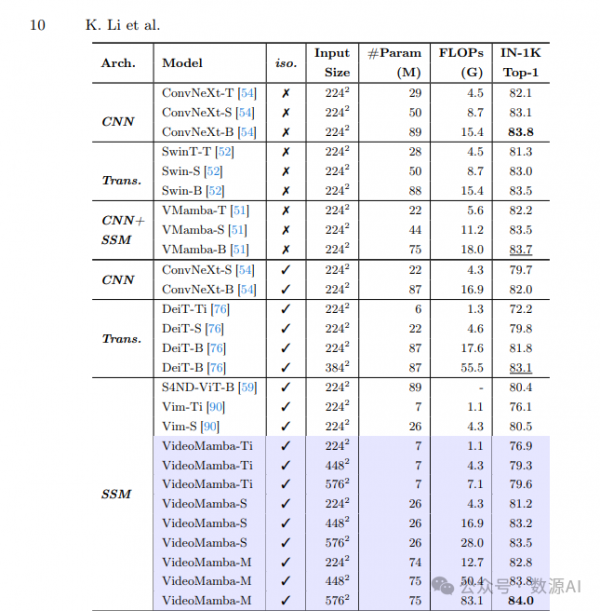

与Vim [90]和VMamba [51]的比较。我们的 VideoMamba 建立在Vim的 基础上,通过省略诸如中间[CLS]标记和旋转位置嵌入(RoPE [69])等功能 来简化其架构,从而在ImageNet-1K上取得了卓越的性能,Vim-Ti和VimS的性能分别提升了+0.8%和+0.7%。与VMamba不同, VideoMamba 严格遵循ViT设计,没有下采样层。为了解决VMamba中观察到的过拟合问 题,我们在第 3.3节中介绍了一种有效的自蒸馏技术,展示了 VideoMamba 在图像和视频任务中的可伸缩性。

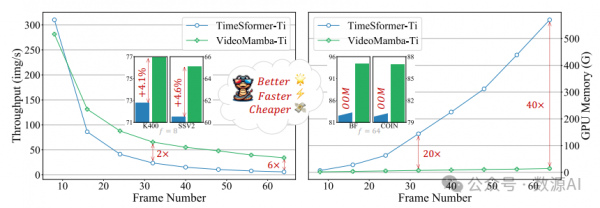

与TimeSformer [4]和ViViT [2]的比较。传统基于注意力的模型如TimeSformer和ViViT通 过采用分割的时空注意力机制来解决自注意力机制的二次复杂度。尽管更 高效,它引入了额外的参数并且在联合注意力方面表现不佳,特别是在涉 及掩码预训练的场景中 [44, 75]。相比之下, VideoMamba 以线性复 杂度处理时空标记,在Kinetics-400上的表现优于TimeSformer +2.6%,并在SthSthV2上取得了显著进展,改善了+5.9%(见表3和4)。此外, VideoMamba 在处理长视频时实现了6×的处理速度提升,并且需要40×更 少的GPU内存,如图1所示,展示了其在处理长视频任务中的高效性和有效性。

3

Architecture

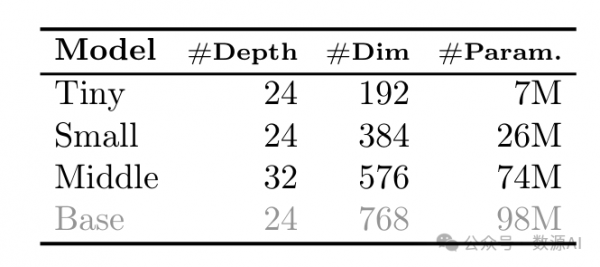

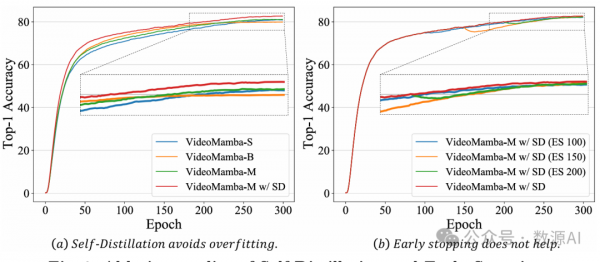

对 于B-Mamba层 中 的SSM, 我 们 采 用 了Mamba [26]中 的 默 认 超 参 数。将 状 态 维 度 和 扩 展 比 设 置 为16和2, 分 别。遵循ViT [16], 我们调整深度和嵌 入 维 度, 以 创 建 表1中 大 小 相 当 的 模 型,包括VideoMamba-Ti、VideoMambaS和VideoMamba-M。然而,我们观察到更 大的VideoMamba 在我们的实验中往往会出现过拟合,导致次优的性能,如 图6a所示。这种过拟合问题并不仅限于我们的模型,也在VMamba [51]中发 现,其中VMamba-B的最佳性能是在总训练轮次的四分之三时达到的。为 了对抗更大的Mamba模型中的过拟合,我们引入了一种有效的自蒸馏策略, 该策略使用一个较小且训练良好的模型作为“教师”,来指导更大的“学 生”模型的训练。图6a中的结果显示,这种策略导致了更好的收敛。

4

Masked Modeling

最近,VideoMAE和ST-MAE [19, 75] 展示了掩码建模在增强模型对细 粒度时间理解能力方面的显著优势。UMT [44] 进一步引入了一种高效的 掩码对齐技术,为单模态和多模态视频任务提供了稳健的结果。为了增 强VideoMamba对时间的敏感性并验证其与文本模态的适应性,我们采用 了受UMT启发的掩码对齐方法。首先,VideoMamba 仅在视频数据上从头 开始训练,将未掩码的标记与来自CLIP-ViT的标记对齐。随后,它与文本 编码器和跨模态解码器(即BERT [15])集成,用于在图像-文本和视频-文 本数据集上进行预训练。

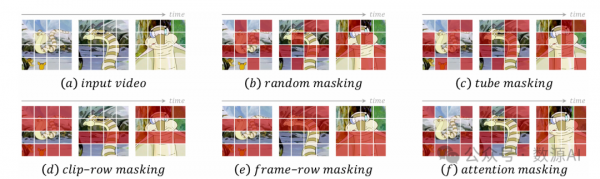

需要注意与UMT的区别,UMT采用了学生和教师模型之间的多层对 齐。相反,由于VideoMamba独特的架构(SSM vs. Transformer),我们仅 对齐最终输出。关于我们的掩码策略,我们提出了不同的行掩码技术,如图 5 所示,以适应B-Mamba块对连续标记的偏好。此外,我们探索了注意力 掩码以保留标记之间的有意义的邻近性,利用B-Mamba块内1D卷积的固有 优势来提高性能。

实验与结果

数据集和设置。我们首先在ImageNet-1K [14]上进行实验,该数据集包 括1.28百万张训练图像和50K张验证图像,涵盖了1,000个类别。为了公平比 较,我们遵循DeiT [76]中提出的大部分训练策略,但对小型模型变体采用了 较弱的数据增强。此外,我们将VideoMamba-Ti/S/M的随机深度比率调整 为0/0.15/0.5。我们的模型使用AdamW优化器与一个在300个时期内的余弦 学习率调度进行训练。最初的5个时期用作线性热身期。学习率、权重衰减 和批量大小的默认设置分别为1e-3、0.05和1024。此外,我们在训练过程中 使用BFloat16精度以增强稳定性,而不依赖EMA。对于VideoMamba-M模 型,我们使用一个预训练的VideoMamba-S模型作为“教师”,通过L2损失 来调整最终特征图以指导训练过程。对于大分辨率(>224)微调,我们 在30个时期内使用降低的学习率(5e-6)和最小的权重衰减(1e-8)。

在ImageNet上与最先进技术的比较

扫描类型、帧率和分辨率的消融研究

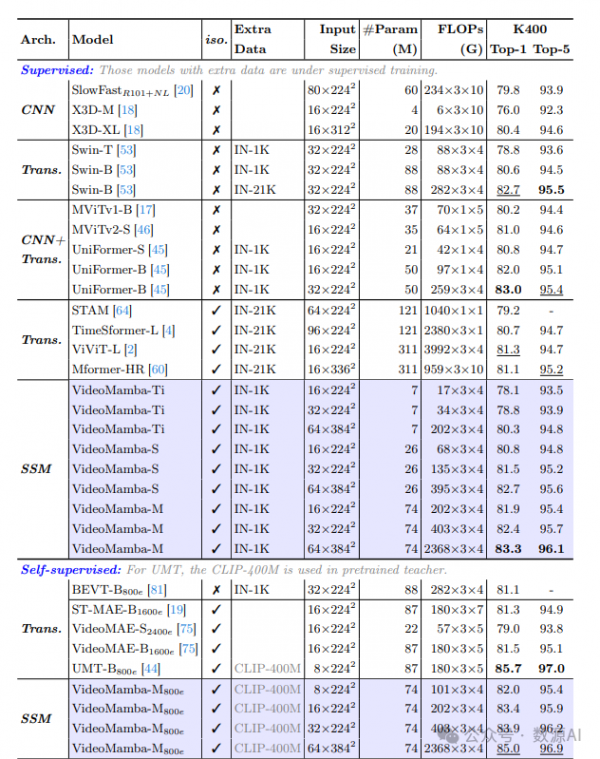

在与与场景相关的Kinetics-400数据集上与最先进方法的比较

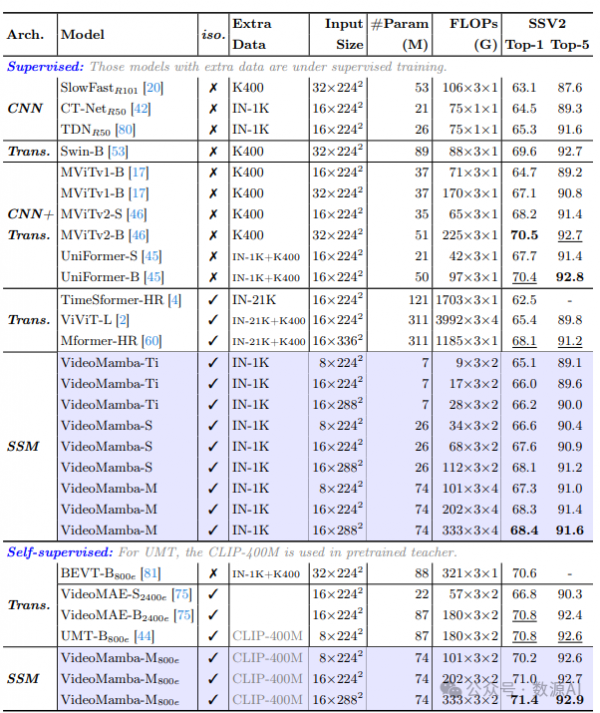

在与时空相关的SthSth V2上与最先进技术的比较

掩码预训练的消融研究

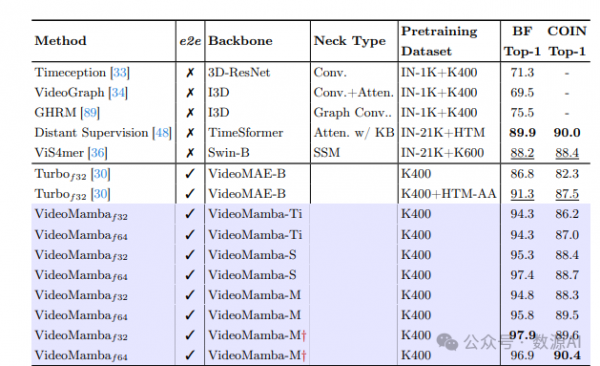

在Breakfast和COIN上与最先进技术的比较

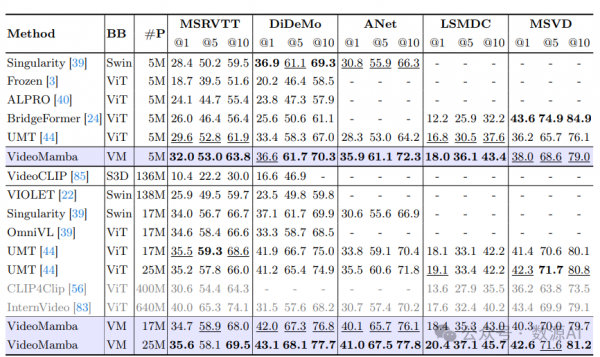

在MSRVTT、DiDeMo、ActivityNet、LSMDC和MSVD上的零样本文本 到视频检索

来源:数源AI

好文章,需要你的鼓励

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

很多人担心被AI取代,陷入无意义感。按照杨元庆的思路,其实无论是模型的打造者,还是模型的使用者,都不该把AI放在人的对立面。

MIT递归语言模型:突破AI上下文限制的新方法

MIT研究团队提出递归语言模型(RLM),通过将长文本存储在外部编程环境中,让AI能够编写代码来探索和分解文本,并递归调用自身处理子任务。该方法成功处理了比传统模型大两个数量级的文本长度,在多项长文本任务上显著优于现有方法,同时保持了相当的成本效率,为AI处理超长文本提供了全新解决方案。

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

谷歌宣布对Gmail进行重大升级,全面集成Gemini AI功能,将其转变为"个人主动式收件箱助手"。新功能包括AI收件箱视图,可按优先级自动分组邮件;"帮我快速了解"功能提供邮件活动摘要;扩展"帮我写邮件"工具至所有用户;支持复杂问题查询如"我的航班何时降落"。部分功能免费提供,高级功能需付费订阅。谷歌强调用户数据安全,邮件内容不会用于训练公共AI模型。

华为研究团队突破代码修复瓶颈,8B模型击败32B巨型对手!

华为研究团队推出SWE-Lego框架,通过混合数据集、改进监督学习和测试时扩展三大创新,让8B参数AI模型在代码自动修复任务上击败32B对手。该系统在SWE-bench Verified测试中达到42.2%成功率,加上扩展技术后提升至49.6%,证明了精巧方法设计胜过简单规模扩展的技术理念。