马斯克打脸OpenAI,全球最大巨无霸模型Grok-1开源!3140亿参数8个MoE,GitHub狂揽6k星

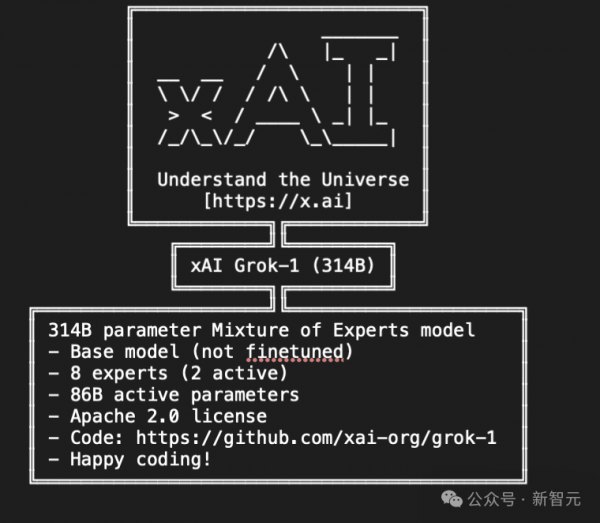

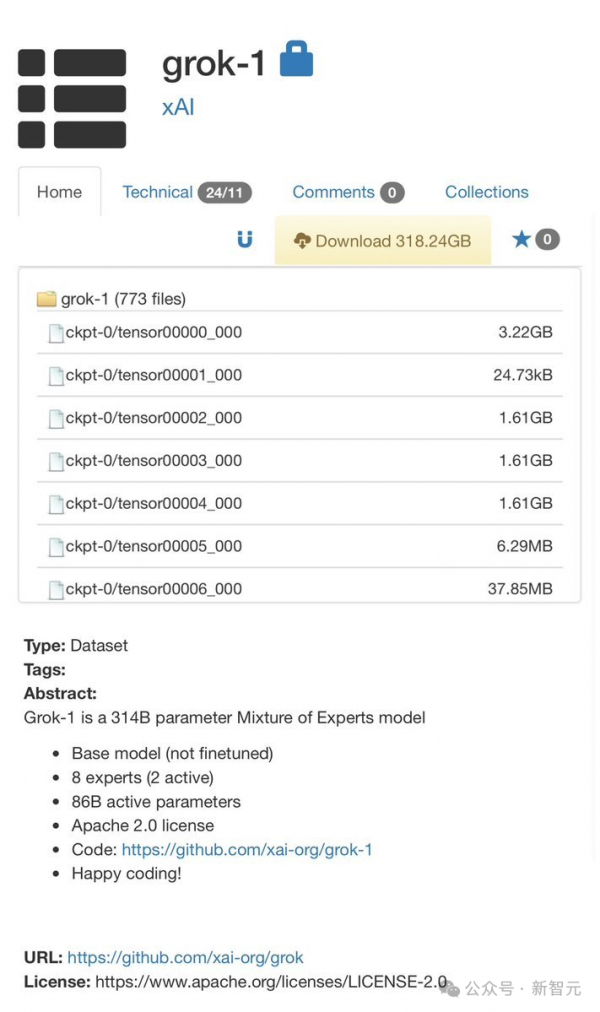

就在刚刚,xAI正式发布3140亿参数混合专家模型Grok-1的权重和架构。

3140亿的参数,让Grok-1成为迄今参数量最大的开源LLM,是Llama 2的4倍。

目前,xAI关于Grok-1没有透露更多信息。

官网放出的信息如下——

- 基础模型在大量文本数据上训练,未针对任何特定任务进行微调。

- 314B参数的MoE,有25%的权重在给定token上处于激活状态。

- 2023年10月,xAI使用JAX和Rust之上的自定义训练堆栈从头开始训练。

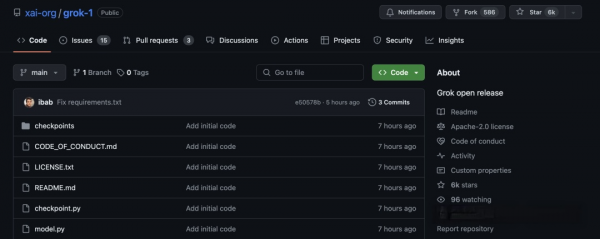

一经上线GitHub,Grok就狂揽了6k星,586个Fork。

项目地址:https://github.com/xai-org/grok-1

马斯克还不忘嘲讽OpenAI一番,「告诉我们更多关于OpenAI的「open」部分...」

纽约时报点评道,开源Gork背后的原始代码,是这个世界上最富有的人控制AI未来战斗的升级。

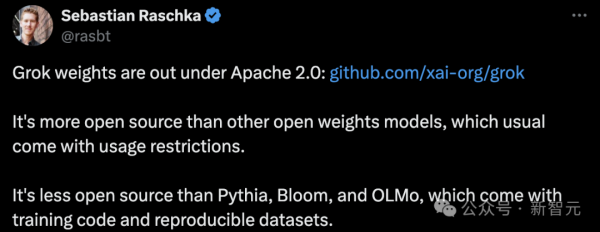

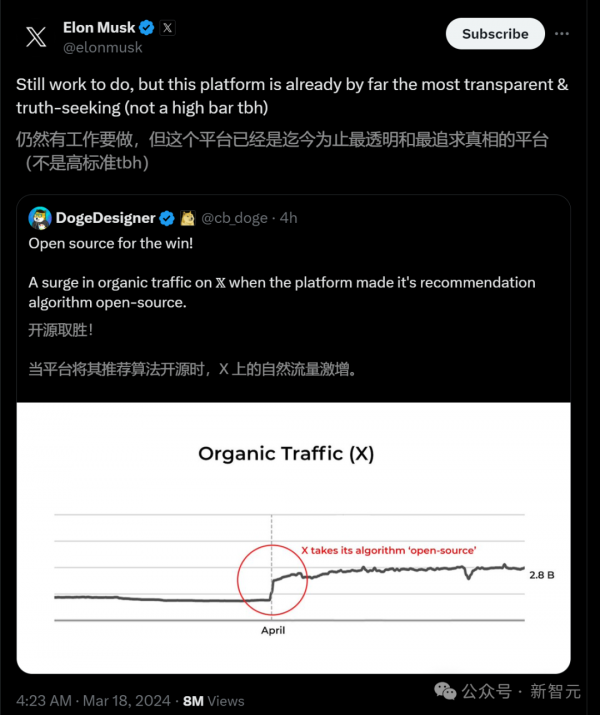

开源究竟会让技术更安全,还是会让它更滥用?

「开源支持者」马斯克,以身作则地卷入了AI界的这场激烈辩论,并用行动给出了答案。

小扎刚刚也对Grok做出了评价,「并没有给人留下真正深刻的印象,3140亿参数太多了,你需要一堆H100,不过我已经买下了」。

一条磁力链,全球首个最大模型开源

pip install -r requirements.txtpython run.py

这个脚本会在测试输入上,加载checkpoint和模型中的样本。

magnet:?xt=urn:btih:5f96d43576e3d386c9ba65b883210a393b68210e&tr=https%3A%2F%2Facademictorrents.com%2Fannounce.php&tr=udp%3A%2F%2Ftracker.coppersurfer.tk%3A6969&tr=udp%3A%2F%2Ftracker.opentrackr.org%3A1337%2Fannounce

更多细节

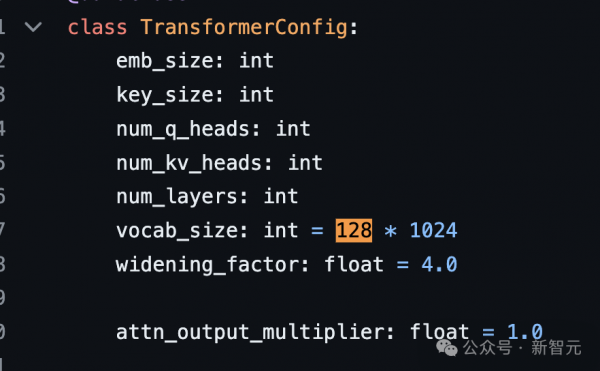

- tokenizer词汇量:131,072(于GPT-4类似)相当于2^17

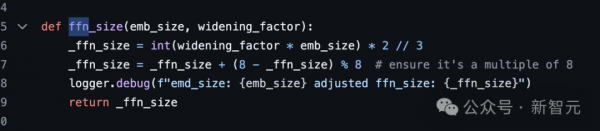

- 嵌入大小:6144(48*128)

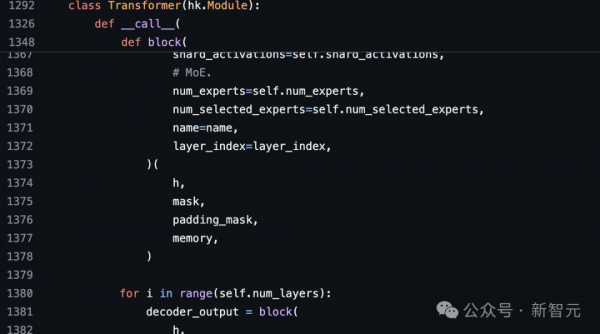

- Transformer层:64(每一层都有一个解码层:多头注意块和密度块)

密集块(密集前馈块):

- 宽度因子(Widening Factor):8

- 上下文长度:8192个token

网友:开源争霸战要来

AI社区已经沸腾了!

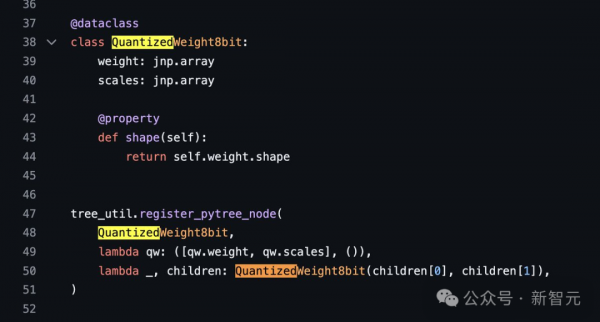

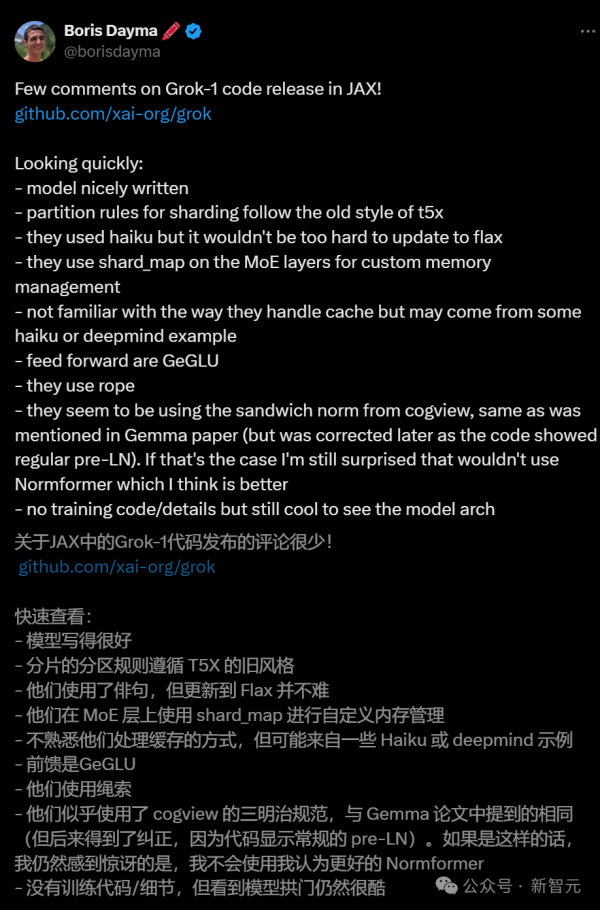

技术界指出,Grok的亮点是在前向反馈层中使用了GeGLU以及归一化方法,并且使用了有趣的三明治范式技术(sandwich norm technique)。

连OpenAI的员工,都表示了自己对Grok的强烈兴趣。

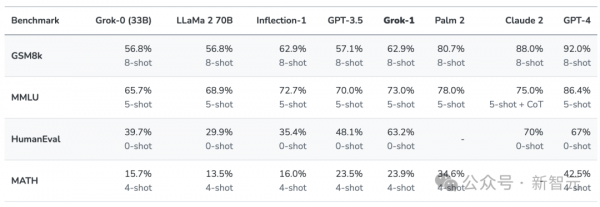

第一代Grok已超越Llama-2-70B

马斯克为何选择开源?

在数次嘲讽OpenAI是「CloseAI」之后,马斯克果真选择了开源自家大模型。

好文章,需要你的鼓励

谷歌智能体开发套件架构深度解析:从核心组件到实践应用

谷歌Agent Development Kit(ADK)革新了AI应用开发模式,采用事件驱动的运行时架构,将代理、工具和持久化状态整合为统一应用。ADK以Runner为核心,通过事件循环处理用户请求、模型调用和外部工具执行。执行逻辑层管理LLM调用和工具回调,服务层提供会话、文件存储等持久化能力。这种架构支持多步推理、实时反馈和状态管理,为构建超越简单聊天界面的生产级AI应用提供了完整框架。

上海AI实验室让机器人“睁眼看世界“:用视觉身份提示技术让机械臂学会多角度观察

上海AI实验室联合团队开发RoboVIP系统,通过视觉身份提示技术解决机器人训练数据稀缺问题。该系统能生成多视角、时间连贯的机器人操作视频,利用夹爪状态信号精确识别交互物体,构建百万级视觉身份数据库。实验显示,RoboVIP显著提升机器人在复杂环境中的操作成功率,为机器人智能化发展提供重要技术突破。

iOS 18新增游戏应用正式上线,专为iPhone游戏体验而生

苹果在iOS 26中推出全新游戏应用,为iPhone、iPad和Mac用户提供个性化的游戏中心。该应用包含五个主要版块:主页展示最近游戏和推荐内容,Arcade专区提供超过200款无广告游戏,好友功能显示Game Center动态并支持游戏挑战,资料库可浏览已安装游戏并提供筛选选项,搜索功能支持按类别浏览。iOS 26.2版本还增加了游戏手柄导航支持,为游戏玩家提供更便捷的操作体验。

英伟达团队突破AI训练瓶颈:让机器人同时学会多种技能不再“顾此失彼“

英伟达研究团队提出GDPO方法,解决AI多目标训练中的"奖励信号坍缩"问题。该方法通过分别评估各技能再综合考量,避免了传统GRPO方法简单相加导致的信息丢失。在工具调用、数学推理、代码编程三大场景测试中,GDPO均显著优于传统方法,准确率提升最高达6.3%,且训练过程更稳定。该技术已开源并支持主流AI框架。