“弱智贴吧”的数据,居然是最强中文语料库

中国科学院、北大、中国科技大学、滑铁卢大学、01.ai等10家机构联合推出了,专用于中文的高质量指令调优数据集——COIG-CQIA。

在大模型领域英语一直是训练数据最重要的语言,但由于中英文的结构和文化差异,直接将英文数据集翻译成中文并不理想。所以,为了填补高质量中文数据集的空白,研究人员开发出了COIG-CQIA数据集。

COIG-CQIA几乎抓取了中文互联网的论坛、网站、百度贴吧、问答社区等高质量数据集。用COIG-CQIA对Yi-6B、Yi-34B进行指令调优,再用GPT4在BELLE-EVAL上评估在各种数据集上训练的大模型性能。

有趣的一幕出现了,“弱智贴吧”的数据质量,居然大幅度超过知乎、豆瓣、是否等知名知识社区,还真是大智若愚啊~

数据集地址:https://huggingface.co/datasets/m-a-p/COIG-CQIA

论文地址:https://arxiv.org/abs/2403.18058

为了验证“弱智贴吧”的数据质量,「AIGC开放社区」特意去实地考察了一下,果然名不虚传有将近300万的“病友”,找几个典型问答给大家鉴赏一下。

-

变形金刚买保险,是买车险还是人险? -

雷公电母放的是,直流电还是交流电? -

秃头的人洗头,用洗头膏还是洗面奶? -

如果猪肾虚,那它的腰子还补吗? -

吃止痛药去打架,算开挂吗? -

鞋子买好了,怎么才能在冰箱里溜冰?

用这样的数据去微调中文大模型,那还不得稳超GPT-4立刻觉醒成为“病友”啊~

COIG-CQIA数据集介绍

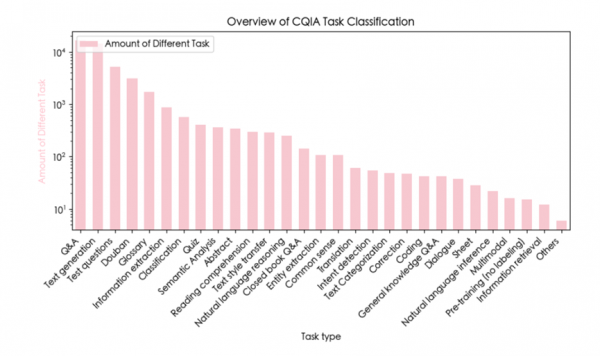

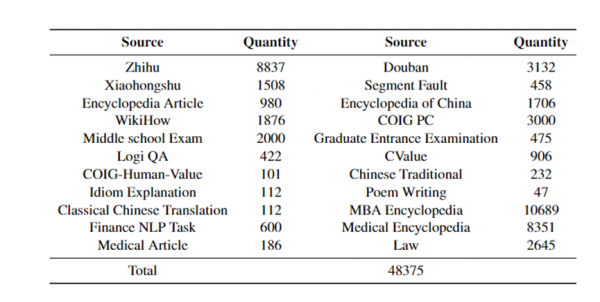

研究人员从中文互联网精心挑选了涵盖通识百科、STEM、人文领域的22个高质量数据源,包括问答社区、百科网站、内容创作平台、考试题库等种类。

社交媒体、论坛数据方面,研究人员从知乎、小红书、豆瓣、是否等热门中文社区精心甄选了高质量问答和长文本内容。

针对不同社区的特点,分别采取了筛选高赞回答、评分过滤、人工审核等方式,确保所保留的数据贴合真实场景。

通识百科方面,从百科、维基解答等知名中文百科网站收集了广泛的概念解释和指导性文章,内容涉及自然科学、人文社科等多个领域。再通过解析HTML并设计多种提示模板,将原始数据得以转化为高质量的指令-输出对。

专业知识部分则从金融、电子、医学、农业等专业垂直网站采集了结构化数据,然后按照人工设计的提示模板构造出专业性指令-输出对。

此外,国内中学生、研究生的历年入学考试真题也被COIG-CQIA纳入在数据集中,可显著提升模型的逻辑推理和知识综合能力。

在完成数据收集和分类整理后,研究人员对每一类数据进行深度清洗、重构和人工审查,以确保数据质量、多样性和对真实人机交互的贴合度。

包括格式规范、答案审查、无关内容删除等。最终,精心构建了一个包含48,375条指令-输出对的高质量中文指令微调数据集。

为了测试数据集性能,用COIG-CQIA对Yi系列、Qwen-72B等国内知名模型进行了微调,结果显示,COIG-CQIA比现有开源中文数据集对大模型的帮助更好。

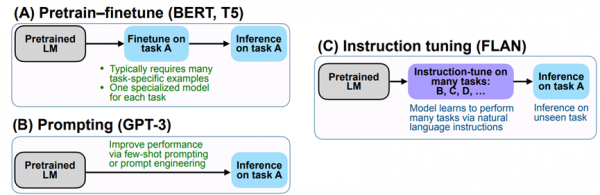

什么是指令微调

指令微调是一种在大模型上进行微调的方法,通过提供指令和输出来指导模型更准确地完成内容输出。

指令微调通过构建专业的指令格式的实例,通常包含任务描述、输入和输出等,然后以有监督的方式对大型语言模型进行精细化微调。

简单来说,指令微调像是一种“妈妈教孩子”的方法,按照特定格式帮助大模型更好地学习、输出拟人化内容。

需要注意的是,指令微调和数据预训练是两回事。预训练是大模型在大规模无监督数据上进行的基础数据训练,其目的只是让大模型学习通用知识,不会针对任何特定领域进行数据微调。

所以,高质量的指令微调数据集对于大模型的拟人化输出、内容的精准性非常重要。

好文章,需要你的鼓励

让AI记住房间每个角落:悉尼大学团队如何让视频生成拥有“空间记忆“

悉尼大学和微软研究院联合团队开发出名为Spatia的创新视频生成系统,通过维护3D点云"空间记忆"解决了AI视频生成中的长期一致性难题。该系统采用动静分离机制,将静态场景保存为持久记忆,同时生成动态内容,支持精确相机控制和交互式3D编辑,在多项基准测试中表现优异。

西班牙病毒如何将谷歌带到马拉加

33年后,贝尔纳多·金特罗决定寻找改变他人生的那个人——创造马拉加病毒的匿名程序员。这个相对无害的病毒激发了金特罗对网络安全的热情,促使他创立了VirusTotal公司,该公司于2012年被谷歌收购。这次收购将谷歌的欧洲网络安全中心带到了马拉加,使这座西班牙城市转变为科技中心。通过深入研究病毒代码和媒体寻人,金特罗最终发现病毒创造者是已故的安东尼奥·恩里克·阿斯托尔加。

马里兰大学突破性发现:AI推理过程终于有了“身体检查“——ThinkARM框架揭开大型语言模型思维奥秘

马里兰大学研究团队开发ThinkARM框架,首次系统分析AI推理过程。通过将思维分解为八种模式,发现AI存在三阶段推理节律,推理型与传统AI思维模式差异显著。研究揭示探索模式与正确性关联,不同效率优化方法对思维结构影响各异。这为AI系统诊断、改进提供新工具。