OpenAI发布全新微调API :ChatGPT支持更详细可视化微调啦!

4月5日凌晨,OpenAI在官网宣布新增6个全新微调API功能,以扩展自定义模型,帮助企业、开发人员更好地构建特定领域、精细化的ChatGPT应用。

这些功能包括:基于Epoch的检查点创建、Playground新功能、第三方集成、全面验证指标、超参数配置和更详细的微调仪表板改进。

新的微调API功能适用于GPT-4/Turbo、GPT-3.5等系列模型。

详细微调API教程:https://platform.opEnai.com/docs/guidEs/finE-tuning

微调API 6个新功能介绍

2023年8月22日,OpEnAI首次推出了基于GPT-3.5 Turbo的微调API功能,使企业、开发人员可以使用自己的数据,结合业务用例构建专属ChatGPT。

经过几个月的时间,全球数千个组织借助OpenAI的微调API功能,训练了数十万个自定义模型实现降本增效。

例如,全球知名招聘平台IndEEd希望新增一项功能,向求职者发送个性化推荐,根据求职者的技能、经验和偏好突出显示相关工作。

IndEEd通过GPT-3.5 Turbo 进行了微调,生成了高质量和更准确的个性化推荐。每月向求职者发送的消息也最初从不到100万条,大幅度增加到大约2000万条。

今天,OpEnAI推出了6个新的微调API功能,以帮助开发人员更好地使用微调。

基于Epoch的检查点创建:在深度学习模型的训练过程中,基于Epoch的检查点创建是一项非常重要的功能。每个Epoch结束时或者在特定的Epoch间隔时,系统会自动保存当前模型的状态,包括模型的参数(权重和偏置)和优化器的状态。

如果训练过程因为意外原因(比如硬件故障、电源中断等)被中断,检查点允许我们从最后保存的状态恢复训练,而不是从头开始。

所以,OpenAI新增的基于 Epoch 的检查点创建功能,可以极大减少模型的重复训练,尤其是在过度拟合的情况下。

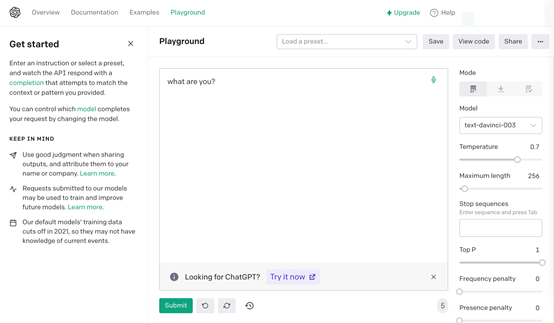

Playground:Playground是OpenAI在2022年发布的一个可视化模型比较平台,提供了一个交互式的在线环境,允许用户输入指令或提示,然后将其发送给多个语言模型查看它们的输出结果。

本次,OpenAI新增一个并排的Playground UI,用于比较不同模型质量和性能,同时允许对多个模型的输出进行人工评估或根据单个提示微调快照。

第三方集成:新的微调支持与第三方平台集成,让开发人员与堆栈的其余部分共享详细的微调数据。

全面验证指标:能够计算整个验证数据集(而不是采样批次)的损失和准确性等指标,从而更好地了解模型质量。

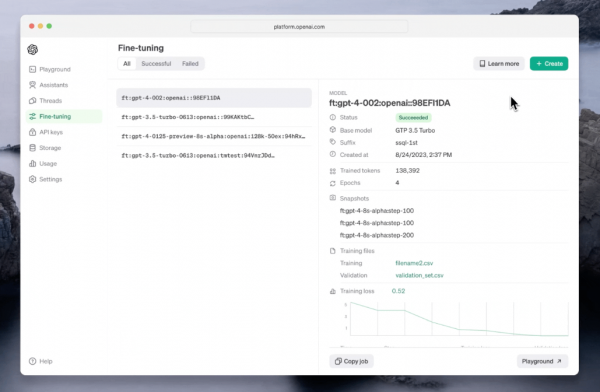

微调仪表板改进:包括配置超参数、查看更详细的训练指标以及从以前的配置重新运行作业等功能。这也就是说,开发人员在微调的过程中可以掌控更详细、直观的微调数据。

超参数配置:可以从仪表板配置可用的超参数,而不仅仅是通过API或SDK。

什么是微调

微调(FinE-tuning)是一种在预训练大模型的基础上,进一步优化和调整模型参数的技术,使模型更好地适应特定业务场景。这个过程中,模型的参数会进行微小的调整。

微调的主要流程包括:初始化,使用预训练语言模型的参数对新模型进行初始化;添加输出层,根据下游任务的目标(文本生成、内容摘要等)在预训练模型的顶层添加相应的输出层;

微调训练,使用带标注的私有数据,以较小的学习率对整个模型进行训练,直至模型在验证集上的指标达到理想效果。

例如,我们希望GPT3.5模型在法律业务上的表现更好、更专业,可以用海量法律数据集对模型进行微调。经过微调,模型学习到如何更好地解读、生成和预测法律问题。

如何进行微调

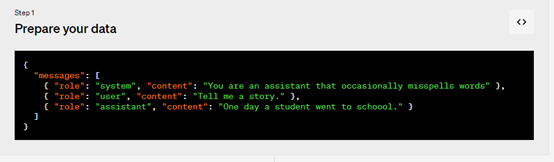

1,准备数据,创建一组多样化的演示对话,类似于要求模型在实际输出中的对话。数据集中的每个示例都应该与OpenAI的聊天完成 API 格式相同的对话,特别是消息列表,其中每条消息都有角色、内容和可选名称。

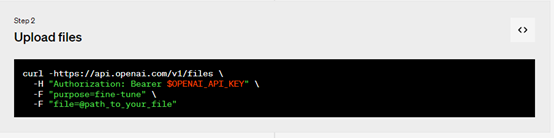

2,上传文件

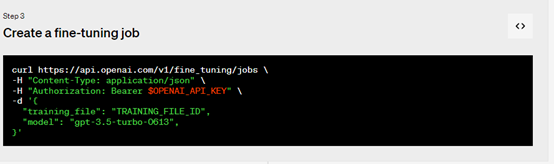

3,创建微调作业,使用 OpenAI SDK开始进行大规模数据训练、微调。训练模型可能需要几分钟或几小时,具体取决于模型和数据集大小。

模型训练完成后,创建微调作业的用户将收到一封确认电子邮件。

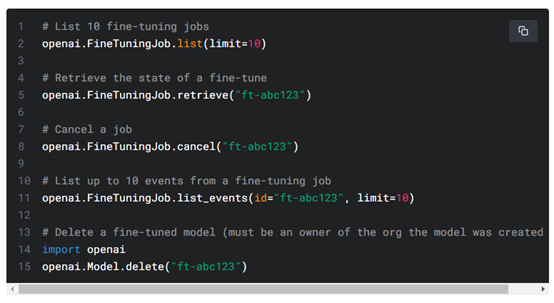

除了创建微调作业外,开发者还可以列出现有作业、检索作业状态或取消作业。

4,使用微调模型,微调作业完成后模型可以投入使用了。

在某些情况下,用户的微调模型可能需要几分钟才能准备好处理请求。如果对模型的请求超时或找不到模型名称,可能是因为模型仍在加载中,可在几分钟后重试。

好文章,需要你的鼓励

据说算力高达1000 TOPS,华硕Ascent GX10深度评测——开箱

当超级计算机被压缩进一个比书本还小的盒子里,这画面有多炸裂?想象一下,你桌面上摆着的不是什么花瓶摆件,而是一台能跑200B参数AI推理的"超算怪兽"——这就是我们今天要聊的主角:华硕Ascent GX10。

Adobe与UCLA联手突破AI模型速度瓶颈:让图像生成快一倍的“稀疏化魔法“

Adobe研究院与UCLA合作开发的Sparse-LaViDa技术通过创新的"稀疏表示"方法,成功将AI图像生成速度提升一倍。该技术巧妙地让AI只处理必要的图像区域,使用特殊"寄存器令牌"管理其余部分,在文本到图像生成、图像编辑和数学推理等任务中实现显著加速,同时完全保持了输出质量。

不用再训练AI模型,香港科技大学团队发明“智能管家“,让AI一眼就知道该抓哪里用哪里

香港科技大学团队开发出A4-Agent智能系统,无需训练即可让AI理解物品的可操作性。该系统通过"想象-思考-定位"三步法模仿人类认知过程,在多个测试中超越了需要专门训练的传统方法。这项技术为智能机器人发展提供了新思路,使其能够像人类一样举一反三地处理未见过的新物品和任务。