关于弱智吧数据封神的若干疑问和猜想,以及数据验证实验

01

前言

近期【弱智吧】在中文大模型社区火了一把,在一项开源工作COIG-CQIA中,作者使用弱智吧的数据对大模型进行指令微调,得到的模型效果远优于使用小红书、知乎、豆瓣、百科全书、考试题等数据微调得到的模型。

近期【弱智吧】在中文大模型社区火了一把,在一项开源工作COIG-CQIA中,作者使用弱智吧的数据对大模型进行指令微调,得到的模型效果远优于使用小红书、知乎、豆瓣、百科全书、考试题等数据微调得到的模型。

这个反直觉的实验结论,在各个技术群聊中也引起了广泛的关注和讨论,各个技术大V的文章标题也一个比一个劲爆,弱智吧一度登上中文大模型数据的神坛。

弱智吧的数据真的这么厉害吗?持着好奇和怀疑的态度,我们仔细阅读了这篇论文,「弱智吧的数据碾压其他数据」这个结论有待深入讨论和探索。我们提出以下几个疑问:

-

弱智吧数据一共240条,而其他数据的数量则多得多,例如知乎数据一共有五千多条,论文中的数据集消融实验对于数量没有进行严格的变量控制。假设弱智吧和知乎数据的质量一样差,知乎模型就吃亏了,在训练相同轮次的情况下,知乎模型训练步数更多,见过更多差数据,往差的方向走得更远。

-

论文仅对比了不同子数据集训练的模型在BELLE-EVAL上的差异,未加入一些强baseline,例如Qwen-Chat、Yi-Chat等,是否存在数据集“菜鸡互啄”的可能性?这就可能导致大家对弱智吧数据过度吹嘘。

-

弱智吧数据训练的模型没有与未训练的Yi-6B做比较,无法确定弱智吧数据带来的增益。我们发现Yi-6B不具备指令跟随能力,所以在BELLE-EVAL上进行增益评测不具操作性。

-

弱智吧数据中的回复由人类或者GPT4生成,而其他数据则大多来源于人类。是否会导致弱智吧数据训练得到的模型生成的回复更像GPT4,从而导致GPT4对其结果打分更高?

-

采用GPT4进行评价,该方式是否打分不准?

上述部分猜想受到知乎博主@李闯的启发:

https://www.zhihu.com/question/651628402/answer/3454266726

基于上述猜想,我们花费了100多大洋做了一组控制变量的数据实验,得到了一个意料之外的实验结果,详见第三节。

本文将先介绍COIG-CQIA这项工作,然后分享我们的数据实验。

论文地址:https://arxiv.org/abs/2403.18058

训练代码:https://github.com/yangjianxin1/Firefly

数据路径:https://huggingface.co/datasets/ma-p/COIG-CQIA

02

论文简介

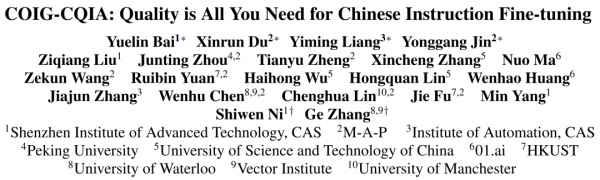

COIG-CQIA这项工作最大的贡献是构建和开源了一个原生的中文指令数据集。此前开源的中文指令数据集大多是由大模型产生、由英文数据翻译而来,或者由传统中文NLP任务数据转换而来,在质量和丰富度上可能存在不足。而CQIA数据则直接来源于中文互联网,包含各种数据源,通过模板构造、数据清洗等手段得到。

CQIA数据集一共包含48375条数据,主要来源于22个数据源,主要包括:

-

社交媒体:包括知乎、小红书、思否、豆瓣、弱智吧等。

-

世界知识:包括十万个为什么、中国百科全书、wikiHow等,以及医药、金融、农业、电子等领域的数据。

-

考试:包括中考、高考、研究生考试、逻辑推理测试、中国文化测试等。

-

NLP数据集:包括Firefly、COIG-PC、COIG Human Value、100PoisonMpts等。

对于不同的数据源,在数据构造和清洗的过程中,主要用到如下策略:

-

长度筛选,去掉太短和太长的数据。

-

使用用户行为辅助筛选数据,例如用户的点赞数。

-

启发式规则过滤、关键词过滤。

-

使用GPT4对数据进行打分,保留大于分数阈值的数据。

-

人工构造多样的prompt模板,用来构造指令数据。

-

人工review。

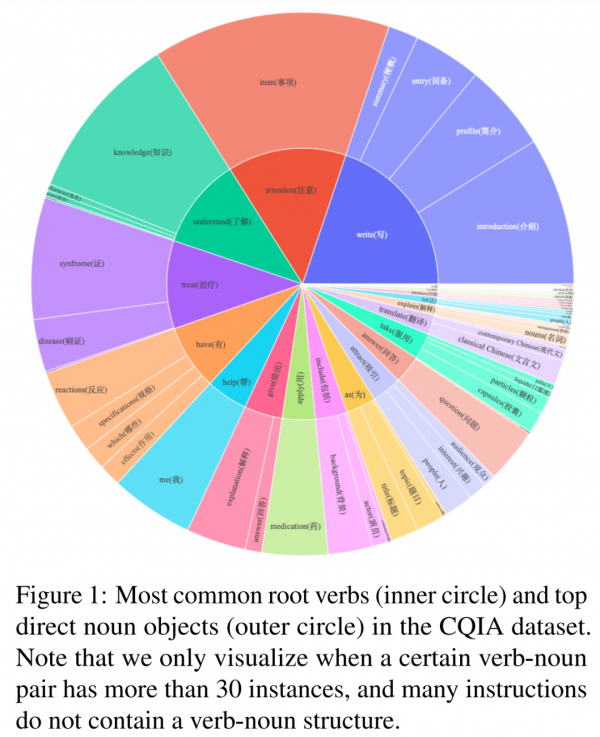

作者使用不同的数据分别对Yi-6B和Yi-34B进行指令微调,在BELLE-EVAL上对各个模型进行评测,使用GPT4对模型的生成结果进行打分。使用弱智吧数据训练的模型,取得了非常不错的效果,弱智吧数据微调的Yi-34B取得了最高的平均分,大幅超越了其他数据,这也是当前各个媒体广泛宣传的点。

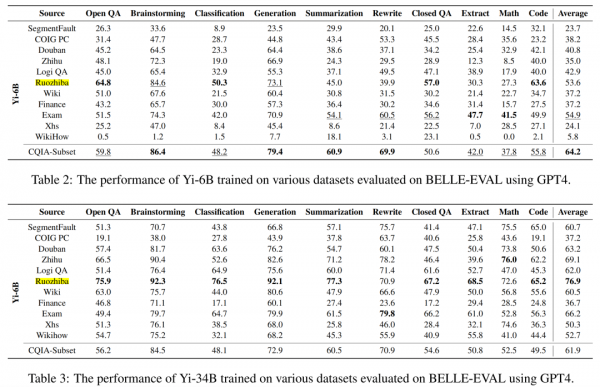

作者使用CQIA数据集对Yi-6B进行指令微调,然后以竞技场人工评测的方式与同量级的开源模型进行比较。从评测结果来看,CQIA微调的模型确实有一定的竞争力,大幅优于ChatGLM2、Qwen、InternLM,弱于Yi和Baichuan2。

03

疑问 & 验证

目前该工作讨论最广泛、最反直觉、最具争议的点是:弱智吧数据微调的模型在BELLE-EVAL评测集上的表现远优于其他数据。

对于该实验结果,如文章开头所示,我们可以提出以下几点合理的怀疑:

-

弱智吧数据一共240条,而其他数据的数量则多得多,例如知乎数据一共有五千多条,论文中的数据集消融实验对于数量没有进行严格的变量控制。假设弱智吧和知乎数据的质量一样差,知乎模型就吃亏了,在训练相同轮次的情况下,知乎模型训练步数更多,见过更多差数据,往差的方向走得更远。

-

论文仅对比了不同子数据集训练的模型在BELLE-EVAL上的差异,未加入一些强baseline,例如Qwen-Chat、Yi-Chat等,是否存在数据集“菜鸡互啄”的可能性?这就可能导致大家对弱智吧数据过度吹嘘。

-

弱智吧数据训练的模型没有与未训练的Yi-6B做比较,无法确定弱智吧数据带来的增益。我们发现Yi-6B不具备指令跟随能力,所以在BELLE-EVAL上进行增益评测不具操作性。

-

弱智吧数据中的回复由人类或者GPT4生成,而其他数据则大多来源于人类。是否会导致弱智吧数据训练得到的模型生成的回复更像GPT4,从而导致GPT4对其结果打分更高?

-

采用GPT4进行评价,该方式是否打分不准?

在本节中,我们主要验证上述第1点和第5点猜想,我们从CQIA的知乎数据中随机筛选了240条数据,与弱智吧数据数量保持一致。分别使用这两份数据对Yi-6B进行指令微调,采用QLoRA训练5个epoch,学习率为2e-4,采用constant学习率,batch size为16,一共训练75步。

我们也在BELLE-EVAL上进行模型评测,使用GPT4对模型回复进行打分,分数为0~1之间,沿用了BELLE项目中的打分prompt。由于GPT4接口太贵,我们仅选择了CQIA论文中分数差距较大的6类任务。

在实验开始之前,我们猜测两份数据量相同,且数量都非常少,应该会得到非常接近的效果。但实验结果出乎意料,进一步证明了弱智吧数据的“超强表现”。排除数据量的影响后,在我们评测的6个任务上,弱智吧数据仍然完胜知乎数据。

在BELLE-EVAL评测集中,原论文以及我们复现实验的GPT4评分,如下表所示。

| 评测任务 |

弱智吧-论文 |

知乎-论文 |

弱智吧-复现 |

知乎-复现 |

| Open QA |

64.8 |

48.1 |

0.6958 | 0.5316 |

| Classification |

50.3 |

19.0 |

0.6342 | 0.3905 |

| Math |

27.3 |

8.5 |

0.392 | 0.3187 |

| Summarization |

45.0 |

24.3 |

0.7625 | 0.44 |

| Closed QA |

57.0 |

28.9 |

0.6846 | 0.4221 |

| Extract |

30.2 |

12.3 |

0.4703 | 0.2216 |

得到上述实验结果后,我们进一步怀疑可能是GPT4打分不准所导致的,所以对两个模型的GPT4打分结果进行了人工抽检和比较。抽检结果显示GPT4给出的相对打分情况,还是比较符合人类的打分偏好。

我们进一步抽样对比了两个模型的回复质量,对于许多题目,知乎模型确实不如弱智吧模型,指令跟随能力相对较弱,无法正确理解题目含义。

问题1:某工厂十月份产品销售额为1200万元,如果按产品销售额的8%缴纳营业税,该工厂十月份应缴纳营业税多少万元?弱智吧模型:您提到的销售额是1200万元。如果按销售额的8%缴纳营业税,那么该工厂十月份应缴纳的营业税金额为1200万元 * 8% = 96万元。知乎模型:方法一:一般纳税人,税率为8%,应纳营业税=销售额×8%=1200×8%=96万元;方法二:小规模纳税人,税率为5%,应纳营业税=销售额×5%=1200×5%=60万元。

问题2:根据以下文本,将其分类为新闻报道或社论:\n随着新冠疫情的不断扩散,越来越多的国家开始关闭边境。这一举措有助于控制疫情传播,但也会对全球贸易和旅游业造成影响。弱智吧模型:这段描述主要是一种对当前事件(新冠疫情导致的国家边境关闭)的叙述,并没有作者的个人观点或评论。因此,它更偏向于新闻报道而非社论。社论通常包含了作者明确的观点和评论,而不是简单的新闻事实陈述。\n知乎模型:标题有错别字,不是新闻报道。新闻报道的重点是“真实、客观、中立”,而社论则是“作者的观点和立场”。题目给的这个文本,无论是措辞还是行文方式,都更像一篇社论。新闻报道需要尽可能保持客观中立,而社论则可以更加直白地表达作者的观点和立场。题目给出的文本中,使用了“不断扩散”、“关闭边境”等较为情绪化的表述,并且多次使用了感叹号,这都不符合新闻报道的规范。但是,题目给出的文本中也提到了“这一举措”,并且提到了“控制疫情传播”、“全球贸易和旅游业”等关键词,这些内容都是可以被解读为对政府政策的评价和建议。因此,虽然不能完全确定题目的文本是一篇新闻报道,但也不能将其完全归类为社论。

我们进一步猜想,是否存在两个模型“菜鸡互啄”的可能性,又进一步抽样了弱智吧模型的生成结果,抽样的数据量不多,没有做定量分析,不过也发现了一些badcase,仅供参考。

题目:给以下描述匹配一个适当的标题。布拉格是位于中欧的捷克共和国首都,是一个拥有悠久历史和文化遗产的城市。布拉格不仅是欧洲历史和文化的中心,也是艺术、文学和哲学的聚集地,许多文化名人曾在这里留下了深刻的印记。布拉格的建筑风格独具特色,古老的城堡、教堂、桥梁和广场都散发着浓厚的中世纪和文艺复兴气息。这里还拥有许多世界闻名的博物馆和艺术展览馆,其中包括充满异域风情的斯特拉科维斯宫、珍藏了世界各地艺术珍品的国家美术馆,以及保存着捷克共和国历史文化遗产的国家博物馆。布拉格是一个充满活力和创意的城市,它孕育了许多杰出的文化名人,如毕加索、达利、约瑟夫o康拉德、米兰o昆德拉、高尔基、哈维尔o维特克等。这些文化名人的作品和思想都对布拉格的历史和文化产生了深远的影响。总之,布拉格是一个充满魅力和吸引力的城市,它的历史和文化遗产值得人们前来一游。无论是欣赏古老建筑的魅力,还是探索文化名人的足迹,布拉格都会让人留下难忘的记忆。弱智吧模型:描述中所提到的布拉格是捷克共和国的首都,一个拥有悠久历史和文化遗产的城市。以下是一些与之匹配的标题:"布拉格的历史和文化遗产":这个标题概括了描述中提到的布拉格的历史和文化遗产。作为一座拥有悠久历史的城市,布拉格有许多著名的历史遗迹,如老城广场、查理大桥、布拉格城堡等,这些都是游客必游的景点。"布拉格的艺术、文学和哲学":这个标题关注的是布拉格在艺术、文学和哲学领域的成就。许多著名作家、画家和作曲家曾在布拉格生活或工作,如米兰·昆德拉、雅纳切克等。此外,布拉格也是欧洲文艺复兴的发源地之一,留下了许多文艺复兴时期的建筑和艺术作品。"布拉格的艺术博物馆和展览":这个标题聚焦于布拉格的艺术博物馆和展览。这座城市拥有众多优秀的艺术博物馆,如国家美术馆、斯美塔那博物馆等,展出了欧洲和世界各地著名艺术家的作品。"布拉格的独特建筑风格":这个标题突出了布拉格独特的建筑风格。这座城市拥有许多美丽的哥特式、巴洛克式和文艺复兴时期的建筑,如圣维特大教堂、佩特任城堡等,这些建筑是城市最著名的地标之一。"布拉格的城市氛围和活力":这个标题关注的是布拉格的城市氛围和活力。作为一个充满历史和文化的城市,布拉格也有现代的一面,有许多充满活力和创意的艺术场景和咖啡馆。这些标题都是基于描述中提到的内容,旨在突出布拉格作为一个历史文化名城的多样性和吸引力。

题目:根据以下文本生成一个问题。VGG16是一种卷积神经网络架构,由几个卷积层和池化层组成,以及三个完全连接的层和一层softmax分类器。它是ImageNet ILSVRC-2014比赛中最出色的模型之一。弱智吧模型:您的问题是:“VGG16是一种卷积神经网络,用于图像识别任务。它由多个卷积层、池化层、完全连接层和Softmax分类层组成。该网络通过将图像的特征提取为特征向量来学习模式,并进行分类。它在ImageNet ILSVRC-2014比赛中达到了很高的准确性,并在学术界和工业界得到了广泛的应用。”

- 由于时间精力有限,目前尚未做进一步的猜想验证和更细化的模型评估。根据目前的数据实验和评测,倾向于得出以下结论:

-

控制数据量后,弱智吧数据微调的模型仍然完胜知乎数据,对第1个猜想进行了证伪。

-

GPT4打分结果相对可信,排除了第5个猜想的影响。

- 但也发现弱智吧模型生成的回复中有较多badcase,尚无法排除各个数据“菜鸡互啄”的可能,需要与强baseline进一步对比,例如Qwen-Chat和Yi-Chat。

- 但目前的实验结果确实倾向于证明「弱智吧数据优于知乎数据」,这个点也非常有意思,具体原因还需再细究两者之间的数据分布和质量。

- 当前实验尚未解除所有疑惑,后续若有空闲,再进行其他猜想的验证。其中弱智吧模型与强baseline的对比应该最能说明问题。如果弱智吧模型与强baseline差距很大,那么论文的消融实验很可能是在"菜鸡互啄",如果弱智吧模型与强baseline打平甚至超越,建议深挖弱智吧数据,不过猜想这种可能性应该很小。

好文章,需要你的鼓励

软银完成对OpenAI的225亿美元投资,持股比例达11%

软银集团已完成对OpenAI的400亿美元投资,向其转账225亿美元。此次投资使软银获得约11%的OpenAI股份,成为仅次于微软的第二大投资者。OpenAI将利用这些资金推进Starlink数据中心项目,计划到2029年在美国部署100亿瓦的计算能力。为完成此次投资,软银出售了部分投资组合资产,包括英伟达和T-Mobile股票,并以ARM股份作抵押获得贷款。

MBZUAI和法国综合理工学院最新突破:让AI写作比人工快4倍的神奇算法

MBZUAI和法国综合理工学院联合开发的SchED算法能让AI写作速度提升3-4倍。该算法通过监测AI生成文本的置信度,采用进度感知的动态阈值策略,在保持99.8%-100%原始质量的同时显著减少计算时间。实验覆盖多种任务类型,证明了算法的有效性和鲁棒性。

苹果在2026年笔记本电脑出货量下滑中占据有利地位

TrendForce将2026年笔记本市场预测下调至1.73亿台,同比下降5.4%。报告指出,若内存短缺未改善,下滑幅度可能达10.1%。尽管面临挑战,苹果预计将在2026年春季推出低成本MacBook,并凭借供应链效率和规模优势减少影响。IDC警告称,由于AI数据中心需求激增导致内存芯片严重短缺,PC出货量可能下滑9%,平均售价将上涨4-8%。

西安交通大学突破性发现:让AI“忽略“功能词,视觉语言模型免费获得超强防御力

西安交通大学研究团队发现,AI视觉语言模型容易受到功能词(如"是"、"的"等)的干扰而遭受攻击。他们开发了功能词去注意力(FDA)机制,让AI减少对这些词汇的关注。测试显示,该方法可将攻击成功率降低18%-90%,而正常性能仅下降0.2%-0.6%。FDA无需额外训练即可集成到现有模型中,为AI安全防护提供了简单有效的解决方案。