SAM+多模态大模型实现开集分割!清华联合美团提出LaSagnA!

数源AI 最新论文解读系列

论文名:LaSagnA: Language-based Segmentation Assistant for Complex Queries

论文链接:https://arxiv.org/pdf/2404.08506.pdf

开源代码:https: //github.com/congvvc/LaSagnA

引言

在大型语言模型(LLMs)快速发展的推动下,用 于视觉的 LLMs (vLLMs) 已经成为一项重大进步 [1-4]。通过引入视觉编码器和相应的模式适配器,可以将预 训练的 LLM 转换为功能强大的 vLLM,能够根据输入 图像生成文本响应。最近的研究 [5-8] 在基于指令和视 觉语境生成详细的感知结果(例如边界框或掩码)方 面取得了进一步进展。这些发展对于复杂的视觉理解、 交互式实体化代理和本地化内容操作等高级应用至关 重要。

简介

最近进展使大型视觉语言模型 (Large Language Models for Vision,vLLMs) 能够生成详细的感知输出,包 括边界框和掩码。然而,限制这些 vLLMs 进一步应 用的两个约束是:每个查询无法处理多个目标,以及 无法识别图像中查询对象不存在。在本研究中,我 们认识到这些问题的主要原因是训练查询的复杂性不足。因此,我们定义了复杂查询的一般序列格式。然后,我们在当前的管道中集成了一个语义分割任 务,以满足训练数据的要求。此外,我们提出了三 种新策略来有效处理直接集成所提出格式带来的挑 战。通过在封闭集和开放集语义分割数据集上与传 统方法获得的可比结果,验证了我们的模型在处理 复杂查询方面的有效性。此外,我们在推理和指代 分割方面超越了一系列 vLLMs,展示了我们的模型 的出色能力。

方法与模型

在本节中,我们在 Sec. 3.1 中提供了基于 vLLM 的 分段助手的概述。然后,我们在 Sec. 3.2 中检查以前方 法中的局限性。接下来,我们重点讨论 Sec. 3.3 中的输 入序列格式。最后,在 Sec. 3.4 中详细介绍了我们提出的训练策略的综合说明。

概述LaSagnA

1

vLLM-based Segmentation Assistants

整体架构。由于本工作的主要重点不是网络架构的 设计,我们根据 LISA[19] 构建了 LaSagnA ,如 Fig. 3 所示。vLLM(vision-language large model,视觉语言 大模型)负责根据指令文本和输入图像生成文本响应。视觉编码器和解码器遵循标准 SAM[16] 架构,它以图 像作为输入,并根据输入的提示生成掩码。在我们的 案例中,提示是指来自 vLLM 的文本特征。

训练目标。由于所有任务都被建模为语言指令,因 此可以使用统一的损失函数对模型进行多任务联合训 练。我们采用自动回归跨熵损失用于下一个令牌预测、 基于每个像素的二元交叉熵损失以及用于掩码监督的 DICE 损失。整体目标由这些损失的加权和构成,并由 λbce 和 λdice 校准:

基于 vLLM 的分段助手的优点。与 UpperNet [45] 和 Mask2Former [8] 等传统分段方法相比,后者仅采用分 类器进行分类,vLLM 能够理解抽象的自然语言指令。因此,vLLM 在一般的引用或推理分段任务中表现良 好,因为它们能够解析查询句子的含义并相应地定位 目标对象/类别。

2

Limitations of vLLM-based Assistants

我 们 认 为 当 前 视 觉 大 语 言 模 型 (visual LLM, vLLM)的亚优表现可以归因于其训练过程中所隐含的 强先验,其中所有训练查询仅由图像中已存在的单个 目标组成。具体来说,训练分割数据集包括引用分割 数据集(refCOCO 系列 [[52]])、推理分割数据集 [[19]] 以及语义分割数据集(ADE20K [[58]] 和 COCO-stuff [[4]])。前两个数据集专门用于在图像中查询单个目 标,而语义数据集也以类似的方式被利用。随机选择 一个现存类别来构建训练查询,并使用相应的二进制 分割掩码作为地面真值来提供掩码损失监督。在这些 设置下,期望模型能有效处理涉及多个目标和不存在 类别的复杂查询是不合理的。

3

Learning with Complex Sequence

我们提出的序列格式:

复杂查询具有多个目标以及图像中不存在的类别 的特征。为了满足这一要求,本能的解决方法是在训 练查询中包含更多类别,并提示模型在响应中返回存 在的类别。因此,我们可以定义以下模板:

USER: 你 能 否 在 这 张 图 中 划 分 出 ?助理:,...,

此 处, 表 示 图 像 补 丁 标 记 的 占 位 符。 表示数据集的类别列表。4是一个新引入的标记,用于根据 LISA 设计解 码正类掩码。表示图像中存在的类别名称。”” 的组合数量与训练图像中存在的类 别数量相匹配。

**结合语义分割任务**。然后,需要相关的训练数据来支持复杂查询。给定一个预定义的类别列表,典型 的语义分割任务涉及识别图像中的类别及其相应的像 素,这自然与我们对多个目标和不存在类别的需求相 一致。因此,为了提高 vLLM 处理复杂查询的能力, 我们选择将语义分割任务纳入训练范式和评估中。

**在语义分割数据集上训练的问题**。尽管当前用于 LaSagnA的训练管道可以将语义分割任务与拟议的序列构建框架无缝集成,但使用此格式直接训练模型会 产生次优性能。如 Fig. 2 所示,这种意外结果源于三个主要问题:不完整的预测、过长的输入序列以及查询和响应之间的类别名称不一致。我们将详细讨论如 下。

1)**不完整的预测**。在实践中,人们发现该模型经常无法预测所有类别,从而对其召回率产生重大 影响。这种缺陷可归因于识别图像中某些类别的不确 定性。此外,纳入不同长度的训练序列进一步增加了 模型优化的复杂性。

2)**过长的输入序列**。输入序列的长度受到 类别数量的强烈影响,因为我们在查询中包括了采样 数据集的所有类别。更长的类别名称列表消耗更多的 标记,从而限制了生成新标记的能力,并影响语义分 割预测的召回率。此外,更长的训练序列需要更多的 GPU 内存并延长训练时间。事实上,许多类别在图像 中不存在,因此没有必要包含过多的类别。

3)**不一致的类别名称**。该模型旨在根据查询 中指定的目标列表生成预测。然而,在开放式分割场 景中,我们观察到该模型经常产生训练数据中的类别 名称,而不是指定的名称。

4

Training Recipe on Complex Queries

为了减轻上述问题,我们提出了一种训练方法,该方法通过提高语义分割数据集上的训练质量来显着 提高分割性能。该方法包含以下三个策略:

序列增强 (Sequence Augmentation) 为了提高不完整预测影响的召回率,一种解决不完整预测的方法是人 为降低采样 EOS 令牌的概率并扩展响应的长度。然而, 该方法通常会导致嘈杂和重复的预测,并可能对其他 任务产生副作用。为了克服这些挑战,我们通过纳入 提供的类列表中的负面类来增强训练序列中的响应。响应中预测的类名与查询中的类名相匹配。模型预测 查询中提到的所有类,用特殊令牌表示正预 测,用表示负预测。这种修改提供了三个主要优势。首先,它鼓励生成包含更多类的更长序列。其 次,它明确指示模型识别负面类。最后但同样重要的是,它将响应标准化为相对固定的长度,方便模型学 习。

随机类列表 (Random Classes List) 为了解决序列过长的问题,我们建议对查询中的类列表进行随机采样。具体来说,我们从完整的类名称列表中随机选择若干 目标,而不考虑它们是否包括图像中存在的所有对象。通过在训练过程中维护一个动态列表,我们的模型能 够熟练地处理推理查询中指定的各种目标,从而实现 开放世界分割。此外,这种方法方便了分块推理,其 中可以将长度较长的目标列表划分为较小的查询,以 并行执行。

目标顺序一致性 (Target Order Consistency) 为了增 强查询和响应之间的类一致性,我们确保响应中目标 类别的顺序与问题中的顺序一致。训练数据集中问题 和答案之间的相似性鼓励模型生成更多依赖于查询上 下文的响应。

根据上述策略,语义分割任务的最终输入格式如 下:

USER: 你能分割图像中的吗?

助手:,, ...,,。

这里, 表示样本类列表,它 由训练数据中随机选择的类组成。新引入的令牌 (token)用于解码正类掩码,而作为 表示负类的令牌。 和 分别用于表示 现有类和不存在类的名称。响应中的总类数对应于查 询中列出的类。在我们的实现中,我们使用了上述格 式构造了各种模板。我们使用的模板将在附录中进一 步详细说明。

实验与结果

**架构。** LaSagnA 由一个视觉大型语言模型(vision Large Language Model, vLLM)和一个通用的分割模型 组成。为了实现高效的训练,我们采用了一个预训练 的 LLaVA-7B[29] 作为视觉大型语言模型。作为独立 的分割模型,我们采用了 SAM[16],并使用了 ViT-H 作为其骨干网络(backbone)。在训练阶段,我们采用 LoRA[13] 来对大型语言模型进行高效的微调。此外, 我们还训练了 SAM 中的掩码解码器(mask decoder), 同时冻结其他所有参数,以保持其原始能力。

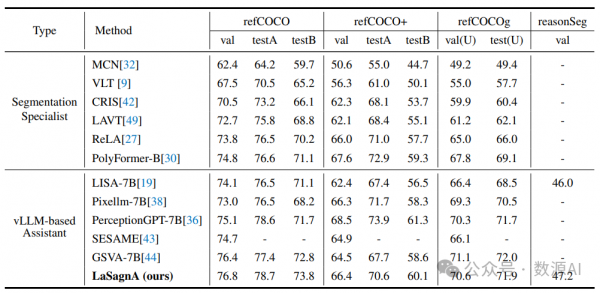

在多个高阶理解任务上的定量结果(cIoU),包括三个传统的指代分割基准(refCOCO 系列)和 LISA[19] 提出的推理分割 数据集。

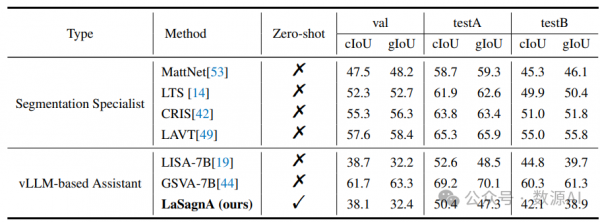

在 gRefCOCO 数据集上的定量结果(cIoU 和 gIoU)。我们的方法也取得了有希望的零样本学习性能,与在训练过程中融 入 gRefCOCO 的 LISA-7B [19] 相当。

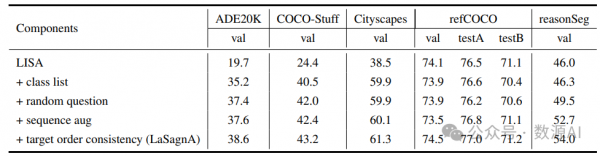

每个拟议组件的 Ablation 研究。我们展示了将不同策略集成到基线中的结果。所有 Ablation 研究都遵循与 LISA[19] 相同 的训练设置。

LaSagnA在复杂查询和单对象场景中的表现的定性结果。

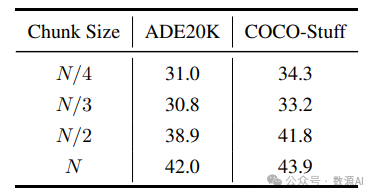

推理块大小的类别影响。N 表示当前数据集上所有类 别的大小。

好文章,需要你的鼓励

超越能源使用:数据中心可持续运营策略

随着AI广泛应用推动数据中心建设热潮,运营商面临可持续发展挑战。2024年底美国已建成或批准1240个数据中心,能耗激增引发争议。除能源问题外,服务器和GPU更新换代产生的电子废物同样严重。通过采用模块化可修复系统、AI驱动资产跟踪、标准化数据清理技术以及与认证ITAD合作伙伴合作,数据中心可实现循环经济模式,在确保数据安全的同时减少环境影响。

剑桥大学突破性研究:如何让AI在对话中学会真正的自信判断

剑桥大学研究团队首次系统探索AI在多轮对话中的信心判断问题。研究发现当前AI系统在评估自己答案可靠性方面存在严重缺陷,容易被对话长度而非信息质量误导。团队提出P(SUFFICIENT)等新方法,但整体问题仍待解决。该研究为AI在医疗、法律等关键领域的安全应用提供重要指导,强调了开发更可信AI系统的紧迫性。

2026年超大规模数据中心运营商发展前瞻:全球最大数据中心运营商的未来走向

超大规模云数据中心是数字经济的支柱,2026年将继续保持核心地位。AWS、微软、谷歌、Meta、甲骨文和阿里巴巴等主要运营商正积极扩张以满足AI和云服务需求激增,预计2026年资本支出将超过6000亿美元。然而增长受到电力供应、设备交付和当地阻力制约。截至2025年末,全球运营中的超大规模数据中心达1297个,总容量预计在12个季度内翻倍。

威斯康星大学研究团队破解洪水监测难题:AI模型终于学会了“眼观六路“

威斯康星大学研究团队开发出Prithvi-CAFE洪水监测系统,通过"双视觉协作"机制解决了AI地理基础模型在洪水识别上的局限性。该系统巧妙融合全局理解和局部细节能力,在国际标准数据集上创造最佳成绩,参数效率提升93%,为全球洪水预警和防灾减灾提供了更准确可靠的技术方案。