Sora强敌来啦!Runway的 Gen-3 Alpha开启测试

6月29日,著名生成式AI平台Runway宣布,其文生视频平台Gen-3 Alpha向部分用户开启测试。

Gen-3 Alpha是Runway在本月17日最新推出的产品,与上一代相比,光影、质量、构图、文本语义还原、物理模拟、动作一致性/连贯性等方面实现大幅度提升,剑指OpenAI的Sora。

下面「AIGC开放社区」精选了10个非常有代表性的视频案例,并为大家解读这些作品好在哪里。

由于平台压缩的原因,展示的内容可能存在部分模糊的情况,但实际上多数都是720、1080P的高清视频。

例如,获得使用权的用户直接用Gen-3制作了一台绚丽的AI走秀。你没看错下面视频中的所有元素都是AI生成的,相比人类玩出不少花活。

踩着平衡车走秀,脑袋顶着大风车,身披火衣,整体视觉效果相当炸裂有创意。

但如果仔细看的话,模特的摆臂还好,部分模特走路存在顺拐和垫脚的情况,两边的观众手臂、人头也存在问题估计模型还没有训练完善。

需要注意的是,Gen-3无法生成背景音乐,这些所有作品的声音都是自己添加的。目前,只有谷歌的VideoFX可以生成带音乐的视频。

也有人用Gen-3制作了一部短视频,主要讲的是赛车、梦想、永不放弃的励志故事。故事框架、运镜、特写都很好,是一个完整的微电影故事。

拍恐怖电影也没问题,一个昏暗无人的恐怖小镇,到处都是假人模特,偶尔会有黑影闪过。这个视频的恐怖氛围感是拉满了,就是运镜太快了,没有留白的空间,要是慢一点点就好了。

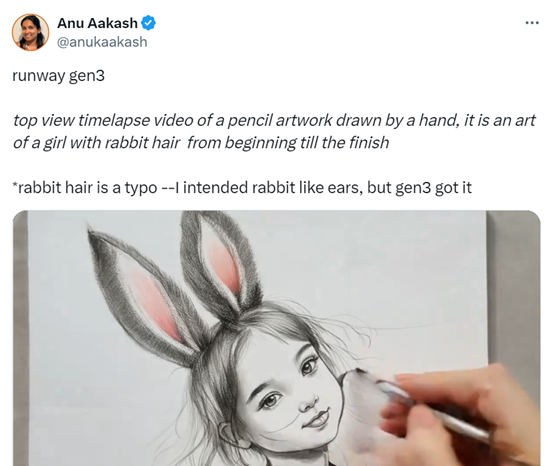

下面这个视频是展示Gen-3强大的文本语义还原能力,该作者表示,她的提示词是“手绘铅笔艺术风格的兔毛女孩”。

这里的兔毛是个错的提示词,应该是“兔子耳朵女孩”,但是Gen-3最后生成的结果还是非常正确的。

一只可怕的怪物从伦敦泰晤士河升起的电影镜头。同样展示了Gen-3强大的文本理解、还原能力。

真实的纪录片拍摄了一只全身覆盖着华丽珠宝、晶洞和珍珠的大蜥蜴走过茂密的植物群的场景。蜥蜴在灯光下闪闪发光。

这个视频主要展示的是Gen-3呈现色彩的能力,看看它背上色彩斑斓的宝石以及反光营造出来的物理效果以及整体光影效果,相当出色几乎不输Sora。

培养皿中生长的黄色霉菌,昏暗的灯光、冷色调、动态运动。这个展示的是物理模拟效果,霉菌的整体生成很细腻,而且是个特写镜头。

一位满脸符文的黑人从水中缓慢地漏出头来,充满神秘感。这个视频主要看人与水的物理效果,看水的波纹与脸发生碰撞后的余波,以及脸颊旁的反射效果,非常出彩。

一群带着赛博朋克眼镜的现代人。这是展示了对人类形象的模拟,尤其是第一个近景的眼睛特写很细腻。

飞越一座爱尔兰的城堡,这座城堡变成了一座摩天大楼的未来赛博朋克城市。这个是展示Gen-3的运镜和场景切换效果,非常丝滑基本实现无缝切换。

看完上面案例是不是有点手痒也想试试啊,自己亲手制作一部微电影。别着急,Runway表示,随着测试的不断推进,很快会向所有人开放使用。

Gen-3地址:https://runwayml.com/blog/introducing-gen-3-alpha/

好文章,需要你的鼓励

埃森哲投资Profitmind,押注AI智能体变革零售业

埃森哲投资AI零售平台Profitmind,该平台通过智能代理自动化定价决策、库存管理和规划。研究显示AI驱动了2025年假日购物季20%的消费,约2620亿美元。部署AI代理的企业假日销售同比增长6.2%,而未部署的仅增长3.9%。Profitmind实时监控竞争对手价格和营销策略,并可创建生成式引擎优化产品文案。

上海AI实验室让机器人“睁眼看世界“:用视觉身份提示技术让机械臂学会多角度观察

上海AI实验室联合团队开发RoboVIP系统,通过视觉身份提示技术解决机器人训练数据稀缺问题。该系统能生成多视角、时间连贯的机器人操作视频,利用夹爪状态信号精确识别交互物体,构建百万级视觉身份数据库。实验显示,RoboVIP显著提升机器人在复杂环境中的操作成功率,为机器人智能化发展提供重要技术突破。

CES 2026:日立与英伟达、谷歌云、Nozomi Networks达成合作协议

日立公司在CES 2026技术展上宣布了重新定义人工智能未来的"里程碑式"战略,将AI直接应用于关键物理基础设施。该公司与英伟达、谷歌云建立重要合作伙伴关系,并扩展其数字资产管理平台HMAX,旨在将AI引入社会基础设施,变革能源、交通和工业基础设施领域。日立强调其独特地位,能够将AI集成到直接影响社会的系统中,解决可持续发展、安全和效率方面的紧迫挑战。

英伟达团队突破AI训练瓶颈:让机器人同时学会多种技能不再“顾此失彼“

英伟达研究团队提出GDPO方法,解决AI多目标训练中的"奖励信号坍缩"问题。该方法通过分别评估各技能再综合考量,避免了传统GRPO方法简单相加导致的信息丢失。在工具调用、数学推理、代码编程三大场景测试中,GDPO均显著优于传统方法,准确率提升最高达6.3%,且训练过程更稳定。该技术已开源并支持主流AI框架。