商汤、清华、复旦等开源百亿级多模态数据集,可训练类GPT-4o模型

商汤科技等机构联合开源了百亿级图文交错数据集OmniCorpus,规模是现有数据集的15倍,包含86亿张图像和16,960亿个文本标记。OmniCorpus数据集在多语言、多类型数据抓取上进行了优化,提高了内容提取的质量和完整性。通过人工反馈和自动过滤规则,确保了数据集的高质量。在VQA和Image Captioning等测试中,基于OmniCorpus预训练的模型表现出色,对训练多模态大模型有重要帮助。

商汤科技、清华大学、上海AI实验室、哈尔滨工业大学、香港中文大学、复旦大学和南京大学的研究人员联合开源了百亿级图文交错数据集——OmniCorpus。

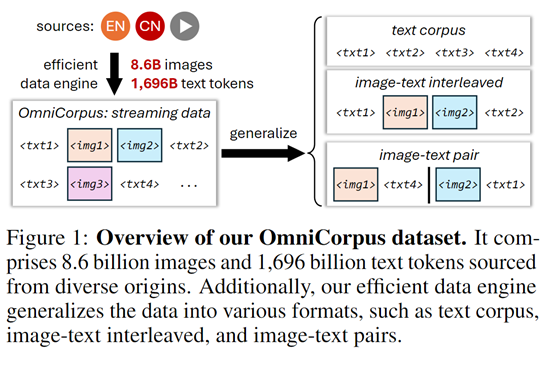

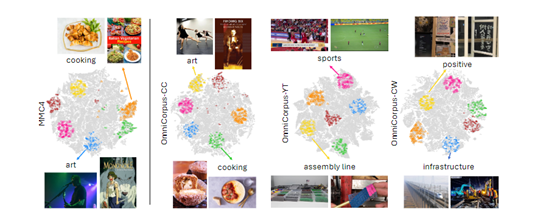

与现有的MMC4、OBELICS等数据集相比,OmniCorpus在规模上扩大了15倍,包含86 亿张图像和16,960亿个文本标记。在数据质量上同样出色,不仅涵盖了英语网站,还包含了非英语网站及视频为中心的平台,确保了内容的广泛性和丰富性。

此外,OmniCorpus还可以从图像文本交织格式轻松降级为纯文本语料库或图像文本对,以满足不同领域研究需求。

开源地址:https://github.com/OpenGVLab/OmniCorpus

论文地址:https://arxiv.org/abs/2406.08418

为了抓取不同语言、类型的数据,研究人员对Trafilatura工具进行了优化,能够更准确地识别和提取HTML文档中的主要内容区域,同时处理更多语言的数据。

还增强了对图像的提取能力,确保了在没有足够文本内容的情况下,能够基于HTML结构的密度来增强部分区域,显著提高了内容提取的质量和完整性。

在提取到主题数据之后进入初步的文本过滤阶段,目的是去除那些质量极低的文档,包含大量数字、文本过长或过短填充文本的文档。

研究人员使用了Gopher和C4策略,并引入了一些启发式规则,例如,去除连续行数过多或单个词频过高的文档等,有效减少了数据集中的冗余。

随后又进行了图像过滤,包括模糊、尺寸、宽高比不合适的图像。根据LAION-5B的指导方针,任何审美分数低于3.7或NSFW分数高于0.8的图像也将被排除,确保了图像数据的质量和相关性。

为了进一步提升OmniCorpus数据集的质量,还引入了人工反馈机制会根据完整性、可理解性、流畅性、相关性和安全性等标准,对文档的子集进行大规模采样。然后手动设计额外的过滤规则,进一步去除低质量文档。

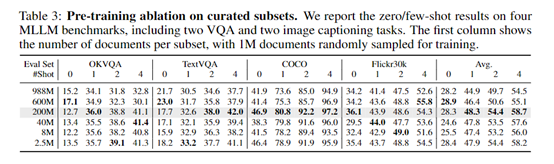

为了评估OmniCorpus数据集的性能,研究人员在VQA、Image Captioning、MLLM等测试平台上进行了综合测试。

在VQA视觉问答的众多子任务中,基于OmniCorpus数据集预训练的模型展现了强大的性能,不仅能够准确识别图像中的对象和场景,还能够理解问题的上下文给出准确的答案。

例如,在VQAv2测试中,模型的平均准确率达到了81.2%,在TextVQA上达到了61.7%,这比之前的训练数据集得分更高。

在Image Captioning测试任务中,OmniCorpus数据集的多样性和丰富性为模型提供了广泛的训练样本,使其能够捕捉到图像中的主要对象和事件,并理解和表达图像中的细节和情感。

在COCO Caption和Flickr30K Caption这两个图像描述基准测试中,基于OmniCorpus数据集预训练的模型生成的描述在质量和准确性上都有显著提升。所以,OmniCorpus数据集对于训练类似GPT-4o、Gemini等多模态大模型有很大的帮助。

0赞

0赞好文章,需要你的鼓励

推荐文章

推荐文章

AI颠覆预计将在2026年持续,推动企业适应不断演进的技术并扩大规模。国际奥委会、Moderna和Sportradar的领导者在纽约路透社峰会上分享了他们的AI策略。讨论焦点包括自建AI与购买第三方资源的选择,AI在内部流程优化和外部产品开发中的应用,以及小型模型在日常应用中的潜力。专家建议,企业应将AI建设融入企业文化,以创新而非成本节约为驱动力。

字节跳动等机构联合发布GAR技术,让AI能同时理解图像的全局和局部信息,实现对多个区域间复杂关系的准确分析。该技术通过RoI对齐特征重放方法,在保持全局视野的同时提取精确细节,在多项测试中表现出色,甚至在某些指标上超越了体积更大的模型,为AI视觉理解能力带来重要突破。

Spotify在新西兰测试推出AI提示播放列表功能,用户可通过文字描述需求让AI根据指令和听歌历史生成个性化播放列表。该功能允许用户设置定期刷新,相当于创建可控制算法的每周发现播放列表。这是Spotify赋予用户更多控制权努力的一部分,此前其AI DJ功能也增加了语音提示选项,反映了各平台让用户更好控制算法推荐的趋势。

Inclusion AI团队推出首个开源万亿参数思维模型Ring-1T,通过IcePop、C3PO++和ASystem三项核心技术突破,解决了超大规模强化学习训练的稳定性和效率难题。该模型在AIME-2025获得93.4分,IMO-2025达到银牌水平,CodeForces获得2088分,展现出卓越的数学推理和编程能力,为AI推理能力发展树立了新的里程碑。