英伟达GPU:聚焦AI超大规模组网

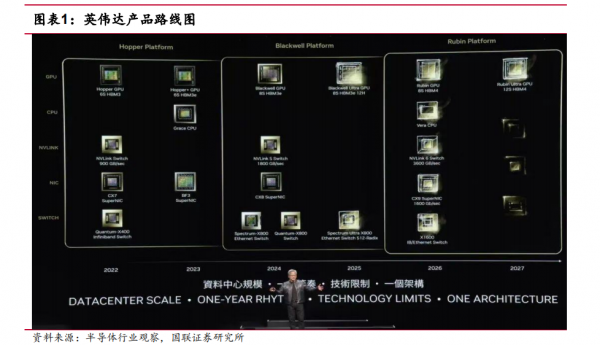

在 2024 年以前,英伟达平均 2 年推出新一代 GPU 架构,目前 Blackwell 芯片已经投产,并预计于 2025 年推出 Blackwell Ultra AI 芯片,2026 年推出下一代 AI 平台“Rubin”,2027 年推出 Rubin Ultra,更新节奏将变为“一年一次”。

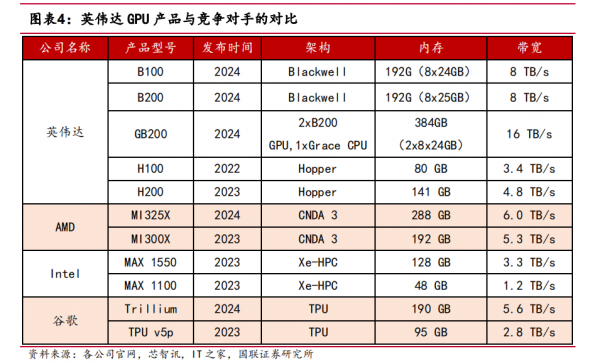

通过加快产品迭代,英伟达保持产品性能优势,且生成单个Token 功耗大幅降低。在各大 GPU 厂商新推出的产品中,英伟达 Blackwell在性能上高于 AMD 的 Instinct MI325X 和谷歌的 Trillium 芯片。

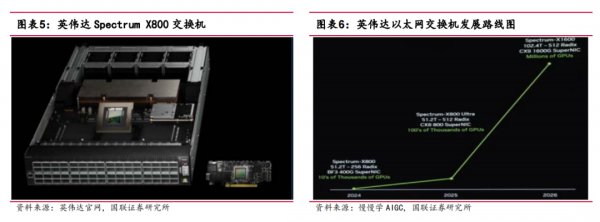

英伟达表达了发力 AI 以太网的决心,其全球首个专为 AI 设计的高性能以太网架构 Spectrum-X,目前正在为多家客户进行量产,公司预计 SpectrumX 将在一年内跃升至数十亿美元的产品线。英伟达推出了适用于以太网的Spectrum X800 交换机。此外,英伟达计划在 2025 年推出 Spectrum X800 Ultra,X800 将支持 10 万卡算力集群互联,而后续的 Spectrum X1600 将支持百万卡算力集群互联。

1 英伟达持续保持 GPU 领先优势

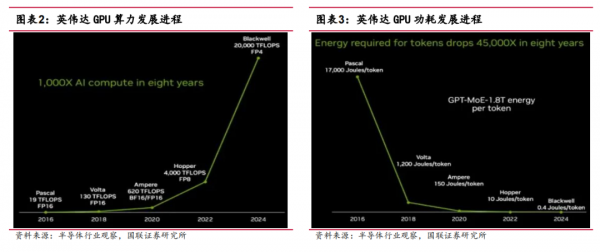

GPU 性能持续提升,生成单个 Token 功耗大幅降低。从“Pascal”P100 GPU 一代到“Blackwell”B100 GPU 一代,8 年间 GPU 的性能提升了 1053 倍,从 19 TFLOPS提升到 20000 TFLOPS。功耗方面,Blackwell 在 Token 生成能耗上大幅降低。在 Pascal时代,每个 Token 消耗的能量高达 1.7 万焦耳,Blackwell 使得生成每个 Token 只需消耗 0.4 焦耳的能量。

通过加快产品迭代,英伟达得以保持明显的产品性能优势。在各大 GPU 厂商 2024年新推出的产品中,英伟达Blackwell系列GPU在性能上高于AMD的Instinct MI325X和谷歌的 Trillium 芯片,叠加 Blackwell 芯片已经量产,英伟达依然维持较大优势。

2 英伟达发力AI以太网,超大规模组网趋势明确

英伟达在财报会上表达了发力 AI 以太网的决心。英伟达推出了适用于以太网的 Spectrum X800 交换机,拥有每秒 51.2 TB 的速度和 256 路径(radix)的支持能力。此外,英伟达计划在 2025 年推出 Spectrum X800Ultra,X800 将支持 10 万卡算力集群互联,而后续的 Spectrum X1600 将支持百万卡算力集群互联,以太网在 AI 集群组网上的应用或将持续增长。

展望 2024 年 H2,英伟达 GPU 芯片的快速迭代,NVLink、InfiniBand、以太网连接方案同步演进。NVIDIA Quantum-X800 是英伟达第一款使用 200Gb/s-per-laneSerDes 方案的交换机设备,通过 72 个 OSPF 1.6T 光模块提供 144 个 800G 端口,明确了 1.6T 光模块需求。

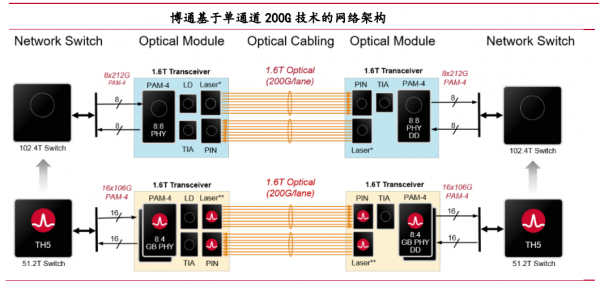

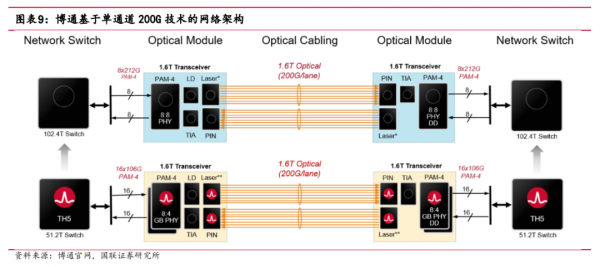

产业链方面,博通在官网给出了基于单通道 200G 光通信技术的网络架构图。根据博通的方案,单通道 200G 光通信技术可以适配 51.2T/102.4T 两个代际的交换机芯片。单通道 200G 光网络包括了 EML、VCSEL、CW 光源、基于单通道 200G 方案的 1.6T光模块、线缆等。

展望 2024H2 至 2025,我们认为 1.6T 光模块的研发和交付能力依然会主导光模块厂商的竞争格局,有利于头部企业强化竞争优势。同时低时延、低成本、低功耗的CPO、LPO、硅光、薄膜铌酸锂方案有望给新的企业带来破局机会。

好文章,需要你的鼓励

印度理工学院突破性发现:大脑学习规律启发的全新AI图像生成技术

印度理工学院研究团队从大脑神经科学的戴尔定律出发,开发了基于几何布朗运动的全新AI图像生成技术。该方法使用乘性更新规则替代传统加性方法,使AI训练过程更符合生物学习原理,权重分布呈现对数正态特征。研究团队创建了乘性分数匹配理论框架,在标准数据集上验证了方法的有效性,为生物学启发的AI技术发展开辟了新方向。

英伟达与诺基亚联手开创AI驱动6G通信平台

英伟达和诺基亚宣布战略合作,将英伟达AI驱动的无线接入网产品集成到诺基亚RAN产品组合中,助力运营商在英伟达平台上部署AI原生5G Advanced和6G网络。双方将推出AI-RAN系统,提升网络性能和效率,为生成式AI和智能体AI应用提供无缝体验。英伟达将投资10亿美元并推出6G就绪的ARC-Pro计算平台,试验预计2026年开始。

Sony AI推出SoundReactor:让AI实时从画面生成身临其境的立体声音效

Sony AI开发出SoundReactor框架,首次实现逐帧在线视频转音频生成,无需预知未来画面即可实时生成高质量立体声音效。该技术采用因果解码器和扩散头设计,在游戏视频测试中表现出色,延迟仅26.3毫秒,为实时内容创作、游戏世界生成和互动应用开辟新可能。