OpenAI将在两周内发布“草莓”模型,推理模式非常特殊!

Theinformation消息,OpenAI将在未来两周内发布最新模型“草莓”( Strawberry) ,会为ChatGPT等产品提供技术支持。

据测试过该模型的人员透露,草莓模型的推理模式非常特殊,可以像人类一样在提供响应之前进行拟人化思考,用10—20秒的时间进行信息搜索、评估,更高效的利用现有AI算力提供更准确的内容。

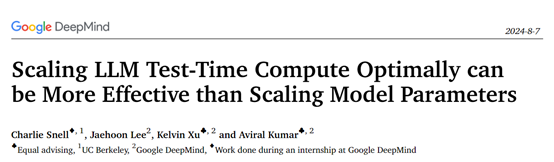

其实,草莓的这种特殊的推理模式,谷歌DeepMind就专门出过一篇论文进行过类似的技术介绍。

目前,多数大模型的性能受限于其预训练阶段所获取的数据集,以及推理过程中的算力资源。研究人员发现,可以通过更多的推理时间、自适应(就是草莓的特殊延迟推理)来提升模型的性能,这种技术称为——测试时计算(Test-time computation)。

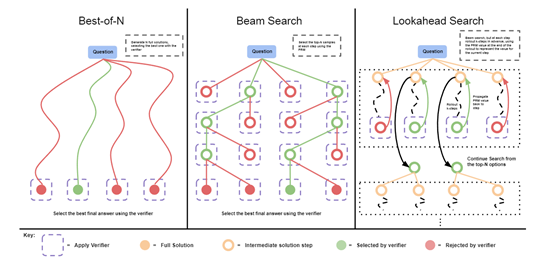

根据提示的难度不同,优化方法主要有两种:一种是基于密集型、流程导向的验证奖励模型进行搜索;另一种是在给定提示下,自适应地更新模型对响应的概率分布。

密集型、流程导向的验证奖励模型搜索主要通过引入一个能够评估模型生成答案步骤正确性的过程导向的验证奖励模型(PRM),来指导搜索过程。

这意味着,模型不仅需要生成最终的答案,还需要生成一个能够证明答案正确性的步骤序列。通过这种方式,验证模型可以针对每一步骤给出反馈,从而引导模型在生成过程中不断修正自己的路径找到最优解。

这种方法很适用于那些需要多步推理和验证的任务,例如,数学问题解决或者是逻辑推理题。在推理的过程中,模型会不断地评估不同的解决方案,并选择那些能够获得更高奖励分数的路径继续探索下去,直到找到最有可能正确的答案为止。

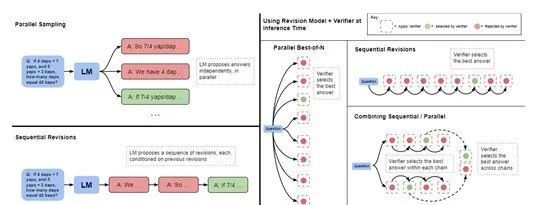

第二种自适应更新模型对响应的概率分布,则是在生成回答时,可以根据先前生成的内容来动态调整后续生成的内容。

例如,当模型接收到一个提示后,它并不会立即给出最终的回答,而是会先生成一系列可能的响应选项。然后,模型会根据这些选项的质量以及它们与原始提示的相关性来更新自己的概率分布,这样在下一轮生成时,模型就会倾向于选择那些更正确的选项。

通过多次迭代,模型能够逐渐优化其生成的回答,直到达到一个满意的程度。这种方法非常适合用于那些初始提示本身可能包含模糊信息的情况,或者当模型首次尝试生成的回答并不完全准确时,通过不断的修订来提高最终输出的质量。

这两种优化机制的使用,在很大程度上取决于问题本身的性质以及所使用的基线大模型的特点。例如,在处理相对简单的问题时,如果基础模型已经有足够的能力生成合理的初步答案,那么允许模型通过预测一系列的修订来迭代地改进其初始答案,可能会比同时生成多个独立的答案更为有效。

相反,对于那些需要考虑多种高级解决方案的问题,或者当模型面临的是特别困难的任务时,采用平行重新采样新答案或运用树状搜索配合过程导向的奖励模型,可能是更高效的方法。

所以,为了更高效的使用这两种优化方法,研究人员提出了“计算最优”的策略,可以根据每个提示的具体情况来选择最适合的测试时计算方法,从而最有效地利用额外的计算资源。

这种方法使得测试时计算的效率提高了超过4倍,相比于传统的最佳N选一的基线策略表现更为出色。

好文章,需要你的鼓励

AI投资有望在2026年获得真正回报的原因解析

尽管全球企业AI投资在2024年达到2523亿美元,但MIT研究显示95%的企业仍未从生成式AI投资中获得回报。专家预测2026年将成为转折点,企业将从试点阶段转向实际部署。关键在于CEO精准识别高影响领域,推进AI代理技术应用,并加强员工AI能力培训。Forrester预测30%大型企业将实施强制AI培训,而Gartner预计到2028年15%日常工作决策将由AI自主完成。

北大学者革新软件诊断方式:让代码问题的“病因“无处遁形

这项由北京大学等机构联合完成的研究,开发了名为GraphLocator的智能软件问题诊断系统,通过构建代码依赖图和因果问题图,能够像医生诊断疾病一样精确定位软件问题的根源。在三个大型数据集的测试中,该系统比现有方法平均提高了19.49%的召回率和11.89%的精确率,特别在处理复杂的跨模块问题时表现优异,为软件维护效率的提升开辟了新路径。

2026年软件定价大洗牌:IT领导者必须知道的关键变化

2026年软件行业将迎来定价模式的根本性变革,从传统按席位收费转向基于结果的付费模式。AI正在重塑整个软件经济学,企业IT预算的12-15%已投入AI领域。这一转变要求建立明确的成功衡量指标,如Zendesk以"自动化解决方案"为标准。未来将出现更精简的工程团队,80%的工程师需要为AI驱动的角色提升技能,同时需要重新设计软件开发和部署流程以适应AI优先的工作流程。

德国达姆施塔特工业大学团队首次揭秘:专家混合模型AI的“安全开关“竟然如此脆弱

这项由德国达姆施塔特工业大学领导的国际研究团队首次发现,当前最先进的专家混合模型AI系统存在严重安全漏洞。通过开发GateBreaker攻击框架,研究人员证明仅需关闭约3%的特定神经元,就能让AI的攻击成功率从7.4%暴增至64.9%。该研究揭示了专家混合模型安全机制过度集中的根本缺陷,为AI安全领域敲响了警钟。