CPU vs. GPU vs. TPU,该如何选择 ?

今天我们继续来聊一下人工智能生态相关技术 - 用于加速构建 AI 核心算力的技术:CPU、GPU 以及 TPU。

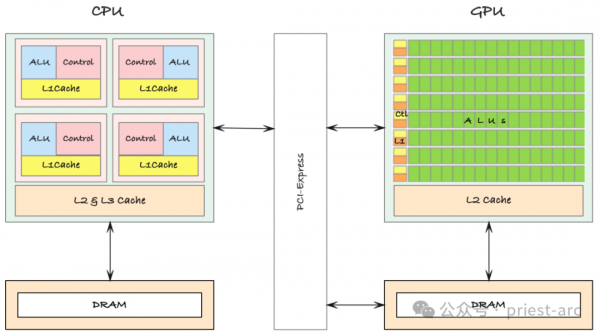

人工智能(AI)和机器学习(ML)技术的飞速发展,正深刻地改变着我们的生活和工作方式。为了满足日益复杂的 AI 应用对计算能力的迫切需求,半导体行业正经历着一场前所未有的变革。传统的 CPU 虽然在通用计算方面表现出色,但在面对大规模并行计算任务时,其性能瓶颈日益凸显。摩尔定律的放缓更是加剧了这一问题,使得单纯依靠提升 CPU 频率来提高计算性能变得越来越困难。

为了突破这一限制,GPU(图形处理器)和 TPU(张量处理器)等专用加速器应运而生。GPU 凭借其强大的并行计算能力,在图形渲染、科学计算和深度学习等领域展现出卓越的性能。而 TPU 作为专门为机器学习任务设计的芯片,其在矩阵运算和卷积神经网络等方面具有无可比拟的优势。通过将 GPU 和 TPU 与 CPU 协同工作,可以显著提升系统的整体计算性能,满足 AI 应用对算力的迫切需求。

— 01 —

TPU、CPU 和 GPU:推动计算革命的三驾马车

在当今以数据为驱动的时代,计算能力的提升已成为各行各业发展的关键驱动力。TPU、CPU 和 GPU 作为三大核心处理器,在各自的领域展现出卓越的性能,并通过协同工作,满足了日益复杂的计算需求。

那么,什么是 TPU、CPU 和 GPU ?首先从 TPU 说起 。。。

TPU(张量处理单元)是谷歌专门为加速机器学习工作负载而开发的高度专业化芯片。TPU 的设计目标是满足深度学习模型在计算方面的高需求,尤其擅长执行大量并行的张量运算。张量运算是神经网络计算的基础操作,因此 TPU 在处理大规模矩阵操作时表现尤为出色,能够显著加速深度学习任务的训练和推理过程。

与 CPU 和 GPU 相比,TPU 的一个关键优势是在提供卓越计算性能的同时,能够保持较低的功耗。这一点在现代计算环境中尤为重要,特别是在需要处理大规模数据集的深度学习应用中,如,图像识别、语音识别、自然语言处理以及推荐系统等。通过并行处理大量数据,TPU 能够大幅缩短这些任务的处理时间,从而实现更高效的计算性能。这使得 TPU 成为处理涉及海量数据和复杂计算的机器学习任务时的理想选择。

TPU 的架构是为特定类型的工作负载量身定制的,尤其是那些依赖于矩阵运算的深度学习任务。然而,尽管 TPU 在这类任务中表现出色,它们的高度专业化也意味着在面对其他通用计算任务时,可能不如 CPU 和 GPU 那样灵活和多功能。CPU 具有广泛的应用范围,可以处理各种类型的计算任务;GPU 则擅长大规模并行运算,不仅在深度学习领域表现出色,还在图形处理、科学计算等任务中占有重要地位。相比之下,TPU 虽然能够在机器学习任务中提供无与伦比的性能,但在应对非深度学习的计算任务时,通常并没有 CPU 和 GPU 那样具备通用性。

此外,充分发挥 TPU 的潜力往往需要对工作负载进行特定的优化和编程。这意味着开发人员在使用 TPU 时,需要对其架构特点有深入了解,才能将其优势最大化。尽管谷歌的云平台已经为 TPU 的使用提供了方便的支持和开发工具,但对一些开发者来说,编写和优化与 TPU 兼容的代码仍然是一个具有挑战性的任务。。

关于 CPU 和 GPU 的解析,可参考之前的文章,具体可参考如下?:

基于上述所述,我们可以看到:CPU 作为通用处理器,在执行各种任务时表现出色。然而,对于机器学习这种计算密集型任务,GPU 和 TPU 凭借其高度并行的架构,往往能带来显著的性能提升。选择合适的处理器是成功部署机器学习模型的关键。

不同类型的机器学习模型对计算资源的需求各异。深度学习模型通常受益于 GPU 和 TPU 的并行计算能力;而传统机器学习算法则更适合在 CPU 上运行。因此,在选择处理器时,需要综合考虑模型类型、数据集大小、以及对实时性的要求。

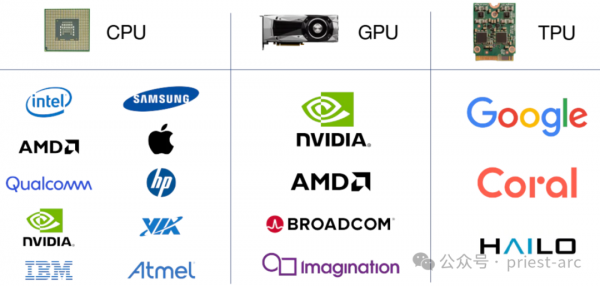

接下来,我们来了解一下 TPU、CPU 和 GPU 3 者作为现代计算系统的核心处理器,各自由不同的公司设计和制造。这些制造商在推动硬件创新和性能提升方面发挥了重要作用,具体可参考如下:

— 02 —

TPU、CPU 以及 GPU 的价值效应

在现代计算系统中,TPU、CPU 以及 GPU 虽然各有其独特的优势与劣势,但它们在特定的场景下往往相互配合协同工作,从而充分发挥各自的计算能力。这种组合方式使得计算系统能够根据任务的具体需求,将不同的处理器优势应用于各类复杂的工作负载,提升整体的性能和效率。

TPU(张量处理单元)作为专为机器学习设计的加速器,特别擅长执行大量的并行矩阵操作,因此在深度学习工作流程中扮演着重要角色。由于深度学习涉及大规模的神经网络训练和海量数据处理,TPU 凭借其专门优化的架构,能够大幅加速训练过程,缩短模型迭代时间。这种计算优势使得 TPU 在深度学习领域中不可替代,特别是在处理需要高效并行计算的任务时,其表现尤为突出。

与此同时,CPU(中央处理单元)作为系统的核心控制中心,负责训练过程的整体编排和管理。CPU 的多功能性使其能够处理各种系统级任务,例如操作系统管理、数据调度、任务分配以及处理各种复杂的指令。尽管 CPU 的并行计算能力不如 GPU 和 TPU,但其通用性和对多种计算需求的兼容性,在大多数计算场景中仍然不可或缺。

在实际应用场景中,GPU(图形处理单元)则展现出强大的并行处理能力。特别是在实时推理和图像处理等任务中,GPU 的优势尤为明显。其并行化的架构允许同时处理大量数据流,尤其适用于需要高吞吐量和低延迟的场景。GPU 不仅在深度学习推理阶段表现出色,还在图形密集型操作、3D 渲染、视频处理等任务中占据核心位置,使其成为游戏、虚拟现实以及加密货币挖掘等应用中的重要计算单元。

在像游戏或虚拟现实这样的应用场景中,GPU 的实时渲染能力至关重要,它能够提供高质量的图形体验,并处理复杂的视觉效果。与此同时,CPU 负责处理物理计算、游戏逻辑、AI 行为等各种复杂的后台任务,保证游戏的流畅运行。在某些涉及机器学习的应用中,如自适应游戏 AI 或实时优化算法,TPU 也能被引入,用于加速特定的深度学习推理任务,从而增强系统的智能响应能力。

将 TPU、CPU 以及 GPU 组合在一个计算系统中,使得开发人员和研究人员能够根据工作负载的特定需求,智能分配任务,最大化利用每个处理单元的优势。这种协作方式创造了一个更加平衡和高效的计算生态系统。例如,在复杂的 AI 模型训练中,深度学习任务的并行计算会被分配给 TPU 处理,而系统管理和任务分发由 CPU 负责,GPU 则可以专注于需要实时处理的推理任务或图像计算。这种高效的任务分工不仅提高了整体系统的响应速度,还在性能优化和能效提升上具有显著效果。

— 03 —

TPU、CPU 以及 GPU 的简要对比解析

在计算领域,三大主要处理单元:TPU(张量处理单元)、CPU(中央处理单元)和GPU(图形处理单元)处理单元都有其独特的设计理念和功能特点,使其在不同任务中展现出显著优势,并被广泛应用于各种计算需求中。

1. TPU(张量处理单元)是专为机器学习任务量身定制的硬件加速器。其核心优势在于高效执行矩阵乘法,这一操作在深度学习和神经网络训练中极为常见。因此,TPU 能够在处理复杂的深度学习模型时,提供极高的性能优势。相较于传统的 CPU,TPU 能够显著提高特定 AI 任务的计算效率,尤其是在涉及大规模数据训练和推理时表现尤为突出。这也使得 TPU 成为推动深度学习技术发展的关键硬件,常用于企业级 AI 平台和云端机器学习服务中。

2. CPU(中央处理单元),作为计算机系统的核心通用处理器,扮演着“多面手”的角色。CPU 以其灵活性著称,能够胜任广泛的计算任务,从运行操作系统、管理硬件资源,到执行复杂的数学计算和算法。CPU 在性能和功耗之间实现了较好的平衡,这种设计使其能够高效地应对多种场景。尽管 CPU 的单线程性能较强,但在处理大规模并行任务时的表现不如 GPU 和 TPU 那么优越,因此在处理深度学习等大规模并行计算任务时,效率相对有限。

3. GPU(图形处理单元)最初是为了加速图形渲染而设计的,然而,随着技术的演进,GPU 的并行计算能力得到了广泛认可,逐渐从单一的图形渲染工具发展成为强大的通用计算加速器。它能够同时处理成千上万的数据流,因而非常适合并行计算密集型任务,如视频编辑、3D 渲染、科学计算、加密货币挖掘以及人工智能训练。特别是在处理需要大量数据并行计算的场景下,GPU 表现出了卓越的效率和处理能力,远远超过了传统 CPU 的能力。

因此,总的来说,TPU、CPU 和 GPU 各自有着不同的优势和应用场景。TPU 专注于机器学习加速,CPU 提供广泛的通用计算能力,而 GPU 则在并行处理任务中表现出色。根据不同的工作负载和计算需求,合理选择和组合这些处理单元,能够显著提升系统的整体性能和效率。

Reference :

[1] https://serverguy.com/cpu-vs-gpu-vs-tpu/

[2] https://byte-man.com/cpu-vs-gpu-vs-tpu/

[3] https://www.backblaze.com/blog/ai-101-gpu-vs-tpu-vs-npu/

好文章,需要你的鼓励

埃森哲投资Profitmind,押注AI智能体变革零售业

埃森哲投资AI零售平台Profitmind,该平台通过智能代理自动化定价决策、库存管理和规划。研究显示AI驱动了2025年假日购物季20%的消费,约2620亿美元。部署AI代理的企业假日销售同比增长6.2%,而未部署的仅增长3.9%。Profitmind实时监控竞争对手价格和营销策略,并可创建生成式引擎优化产品文案。

上海AI实验室让机器人“睁眼看世界“:用视觉身份提示技术让机械臂学会多角度观察

上海AI实验室联合团队开发RoboVIP系统,通过视觉身份提示技术解决机器人训练数据稀缺问题。该系统能生成多视角、时间连贯的机器人操作视频,利用夹爪状态信号精确识别交互物体,构建百万级视觉身份数据库。实验显示,RoboVIP显著提升机器人在复杂环境中的操作成功率,为机器人智能化发展提供重要技术突破。

CES 2026:日立与英伟达、谷歌云、Nozomi Networks达成合作协议

日立公司在CES 2026技术展上宣布了重新定义人工智能未来的"里程碑式"战略,将AI直接应用于关键物理基础设施。该公司与英伟达、谷歌云建立重要合作伙伴关系,并扩展其数字资产管理平台HMAX,旨在将AI引入社会基础设施,变革能源、交通和工业基础设施领域。日立强调其独特地位,能够将AI集成到直接影响社会的系统中,解决可持续发展、安全和效率方面的紧迫挑战。

英伟达团队突破AI训练瓶颈:让机器人同时学会多种技能不再“顾此失彼“

英伟达研究团队提出GDPO方法,解决AI多目标训练中的"奖励信号坍缩"问题。该方法通过分别评估各技能再综合考量,避免了传统GRPO方法简单相加导致的信息丢失。在工具调用、数学推理、代码编程三大场景测试中,GDPO均显著优于传统方法,准确率提升最高达6.3%,且训练过程更稳定。该技术已开源并支持主流AI框架。