2024年AI服务器和AI PC趋势

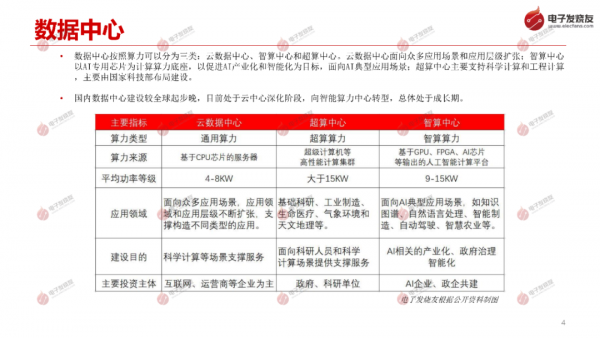

数据中心按照算力可以分为三类:云数据中心、智算中心和超算中心。云数据中心面向众多应用场景和应用层级扩张;智算中心 以AI专用芯片为计算算力底座,以促进AI产业化和智能化为目标,面向AI典型应用场景;超算中心主要支持科学计算和工程计算 ,主要由国家科技部布局建设。

国内数据中心建设较全球起步晚,目前处于云中心深化阶段,向智能算力中心转型,总体处于成长期。

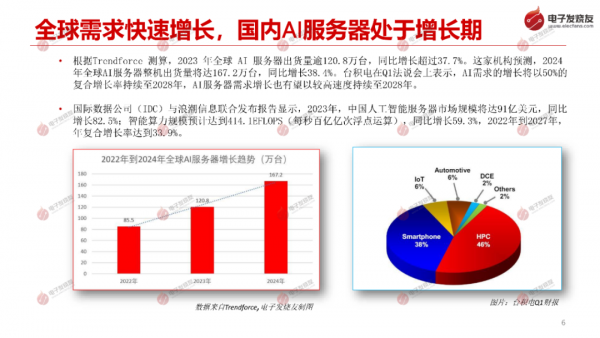

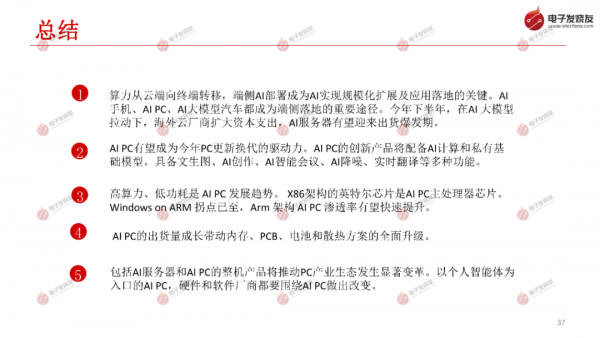

根据Trendforce 测算, 2023 年全球 AI 服务器出货量逾120.8万台,同比增长超过37.7%。这家机构预测, 2024 年全球AI服务器整机出货量将达167.2万台,同比增长38.4%。台积电在Q1法说会上表示,AI需求的增长将以50%的 复合增长率持续至2028年,AI服务器需求增长也有望以较高速度持续至2028年。

2023年,中国人工智能服务器市场规模将达91亿美元, 同比 增长82.5%;智能算力规模预计达到414.1EFLOPS (每秒百亿亿次浮点运算),同比增长59.3%,2022年到2027年, 年复合增长率达到33.9%。

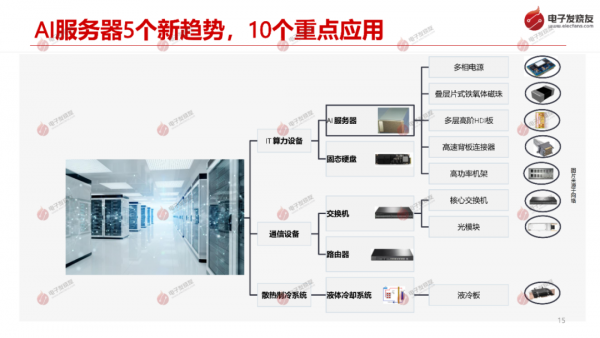

按照用途区分, AI服务器分为训练和推理两大类别。训练用服务器对存储空间、带宽和算力的要求较高, 主要采用8-GPU 设计;推理用服务器对算力、存储和带宽的要求相对较低,取决于业务场景, 可以采用 GPU、NPU、CPU 等不 同芯片承担推理任务,可以采用PCLe接口的AI加速器实现推理任务。

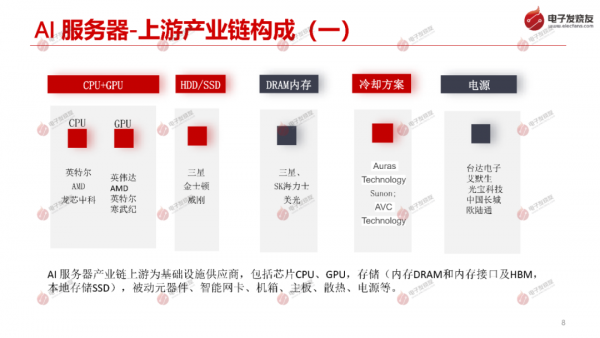

服务器随场景需求经历通用服务器-云服务器-边缘服务器-AI服务器四种模式,AI服务器采用GPU增强其并行计算能力。CPU+GPU是AI服务器的核心部件。机柜级解决方案有望成为未来 AI 服务器出货主流形式之一。

1、半导体行业系列专题:刻蚀—半导体制造核心设备,国产化典范

2、半导体行业系列专题:碳化硅—衬底产能持续扩充,加速国产化机会 3、半导体行业系列专题:直写光刻篇,行业技术升级加速应用渗透 4、半导体行业系列专题:先进封装—先进封装大有可为,上下游产业链受益

好文章,需要你的鼓励

AI基础设施投资热潮的冷静思考

科技泡沫并非世界末日,从经济角度看,泡沫是押注过大导致供过于求。AI泡沫问题复杂在于AI软件开发节奏与数据中心建设周期的时间错配。甲骨文关联数据中心获180亿美元信贷,Meta承诺三年内投入6000亿美元基础设施。麦肯锡调查显示企业虽广泛使用AI但规模有限,多数仍持观望态度。微软CEO表示更担心数据中心空间不足而非芯片短缺,电力需求成为新瓶颈。

Salesforce AI团队首次构建70万页真实文档的RAG评测体系:揭示多模态检索增强生成的真实性能

Salesforce AI研究团队构建了首个大规模多模态文档RAG评测基准UniDoc-Bench,包含7万页真实PDF文档和1600个问答对,覆盖8个领域。研究发现文本图像融合检索策略显著优于单一模态和联合多模态方法,为未来AI文档理解系统提供了"分工合作"的设计思路。

AI研究发现神经网络记忆与推理功能完全分离

Goodfire.ai研究人员首次发现AI语言模型中记忆和推理功能通过完全独立的神经通路运作。研究显示,移除记忆通路后,模型丧失97%的训练数据复述能力,但逻辑推理能力几乎完全保留。令人意外的是,算术运算与记忆共享神经通路而非推理通路,这可能解释了AI模型在数学方面的困难。该技术未来有望用于移除版权内容或敏感信息而不损害模型核心功能。

腾讯团队破解AI推理“探索枯竭“难题:低概率“推理火花“原来是关键

腾讯研究团队发现AI训练中"推理火花"现象,揭示低概率词汇如"等等"、"不过"等在维持AI探索能力中的关键作用。团队开发的低概率正则化方法通过精准保护有价值的低概率词汇,在数学推理任务中实现60.17%准确率,比传统方法提升2.66%,为AI创造性思维研究开辟新路径。