服务器基础知识全解(终极版)

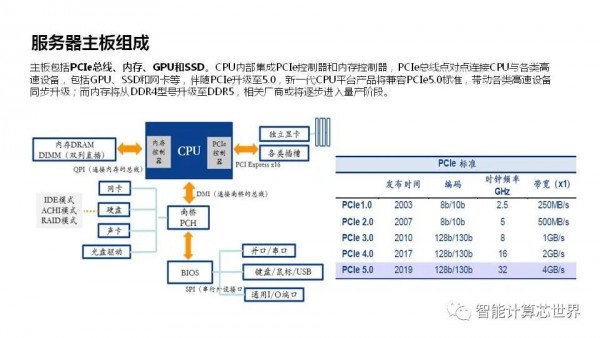

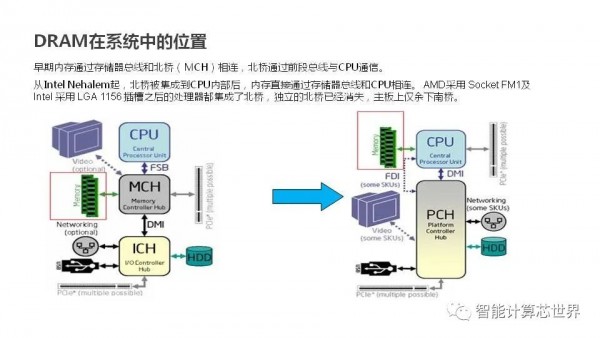

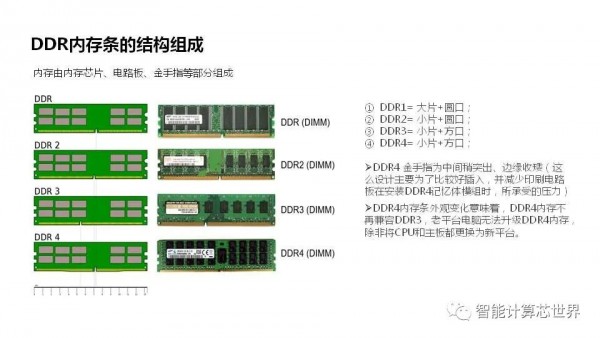

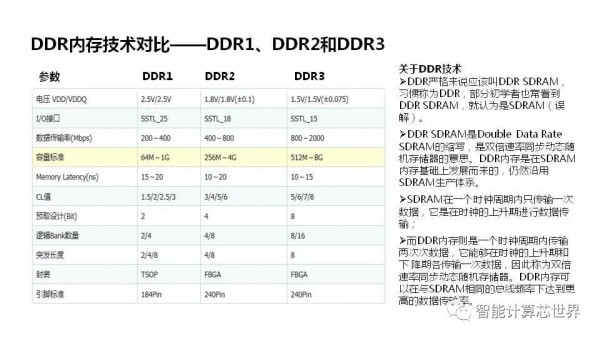

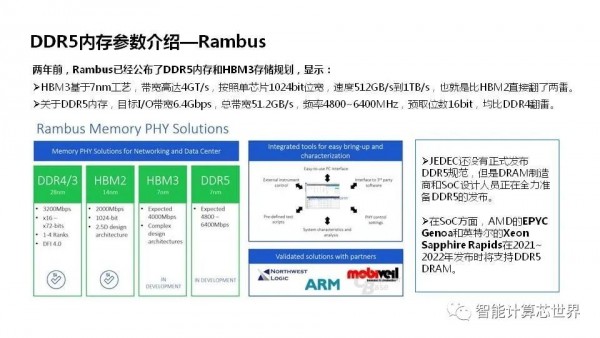

服务器主板包括PCIe总线、内存、GPU和SSD。CPU内部集成PCIe控制器和内存控制器,PCIe总线点对点连接CPU与各类高速设备,包括GPU、SSD和网卡等,伴随PCIe升级至5.0,新一代CPU平台产品将兼容PCIe5.0标准,带动各类高速设备同步升级;而内存将从DDR4型号升级至DDR5,相关厂商或将逐步进入量产阶段。

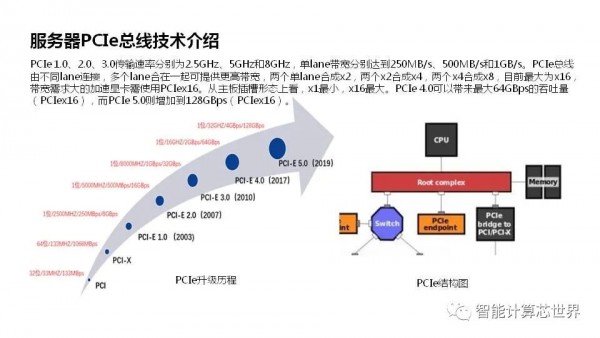

PCIe 1.0、2.0、3.0传输速率分别为2.5GHz、5GHz和8GHz,单lane带宽分别达到250MB/s、500MB/s和1GB/s。PCIe总线由不同lane连接,多个lane合在一起可提供更高带宽,两个单lane合成x2,两个x2合成x4,两个x4合成x8,目前最大为x16,带宽需求大的加速显卡需使用PCIex16。从主板插槽形态上看,x1最小,x16最大。PCIe 4.0可以带来最大64GBps的吞吐量(PCIex16),而PCIe 5.0则增加到128GBps(PCIe x16)。

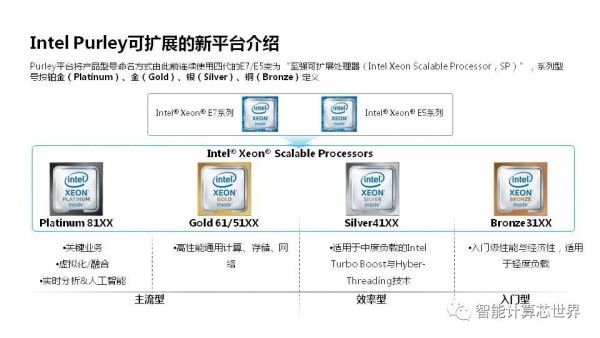

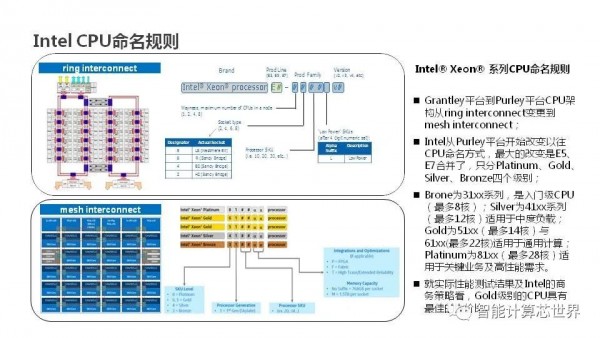

2017年7月份,Purley的新一代服务器平台,Purley平台将产品型号命名方式由此前连续使用四代的E7/E5变为至强可扩展处理器(Intel Xeon Scalable Processor,SP),系列型号按铂金(Platinum)、金(Gold)、银(Silver)、铜(Bronze)定义。

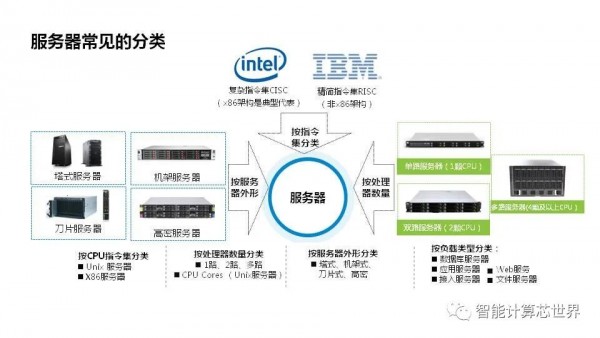

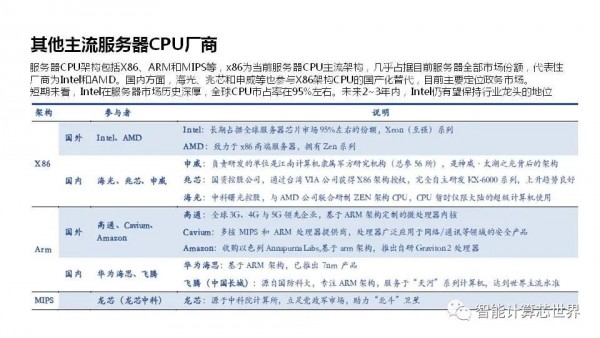

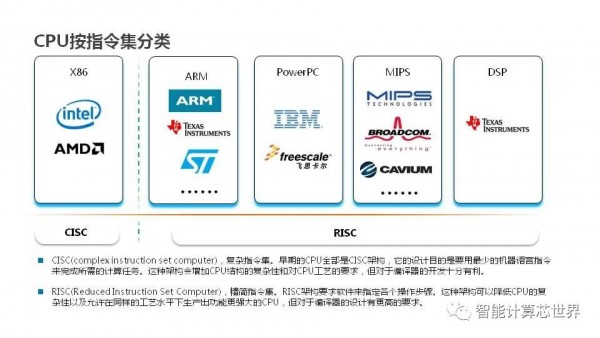

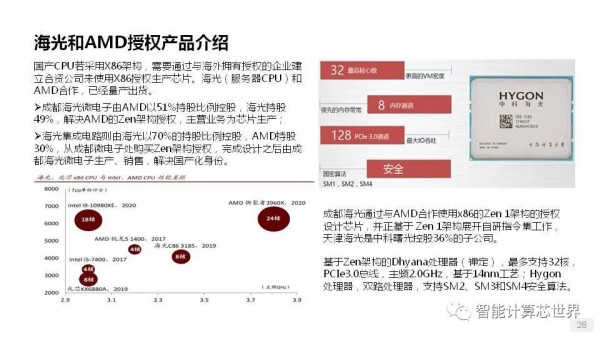

服务器CPU架构包括X86、ARM和MIPS等,x86为当前服务器CPU主流架构,几乎占据目前服务器全部市场份额,代表性厂商为Intel和AMD。国内方面,海光、兆芯和申威等也参与X86架构CPU的国产化替代,目前主要定位政务市场。

短期来看,Intel在服务器市场历史深厚,全球CPU市占率在95%左右。未来2~3年内,Intel仍有望保持行业龙头的地位

好文章,需要你的鼓励

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

很多人担心被AI取代,陷入无意义感。按照杨元庆的思路,其实无论是模型的打造者,还是模型的使用者,都不该把AI放在人的对立面。

MIT递归语言模型:突破AI上下文限制的新方法

MIT研究团队提出递归语言模型(RLM),通过将长文本存储在外部编程环境中,让AI能够编写代码来探索和分解文本,并递归调用自身处理子任务。该方法成功处理了比传统模型大两个数量级的文本长度,在多项长文本任务上显著优于现有方法,同时保持了相当的成本效率,为AI处理超长文本提供了全新解决方案。

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

谷歌宣布对Gmail进行重大升级,全面集成Gemini AI功能,将其转变为"个人主动式收件箱助手"。新功能包括AI收件箱视图,可按优先级自动分组邮件;"帮我快速了解"功能提供邮件活动摘要;扩展"帮我写邮件"工具至所有用户;支持复杂问题查询如"我的航班何时降落"。部分功能免费提供,高级功能需付费订阅。谷歌强调用户数据安全,邮件内容不会用于训练公共AI模型。

华为研究团队突破代码修复瓶颈,8B模型击败32B巨型对手!

华为研究团队推出SWE-Lego框架,通过混合数据集、改进监督学习和测试时扩展三大创新,让8B参数AI模型在代码自动修复任务上击败32B对手。该系统在SWE-bench Verified测试中达到42.2%成功率,加上扩展技术后提升至49.6%,证明了精巧方法设计胜过简单规模扩展的技术理念。