世界最好小参数开源大模型!超谷歌、Meta,手机、平板轻松运行

法国著名大模型平台Mistral.AI开源了最新小参数模型——Ministraux。

Ministraux一共有Ministral 3B和8B两个版本,是专为手机、平板、笔记本等移动设备设计,在文本生成、推理、函数调用和效率方面非常强悍,大幅度超过了Meta的Llama-3.2和谷歌的Gemma-2,重新定义100亿参数以下小模型的性能。

所以,Mistral.AI在发布时也挺直接,这是目前世界最好的开源小参数模型。

开源地址:https://huggingface.co/mistralai/Ministral-8B-Instruct-2410

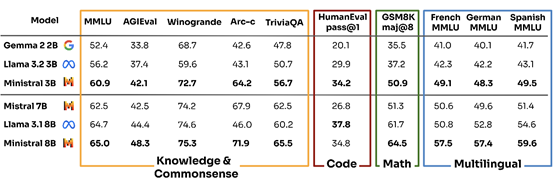

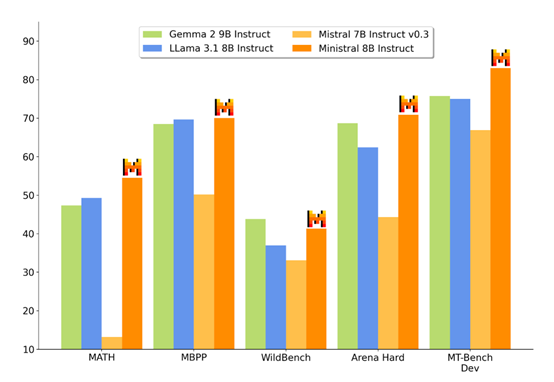

从Mistral.AI公布的测试数据来看,Ministraux的性能确实不错。以最小参数的3B为例,在MMLU、AGIEval、Winogrande、Arc-c、TriviaQA等主流基准测试平台中,分别达到了60.9、42.1、72.7、64.2、56.7的超高分数。

比谷歌的Gemma-2-2B、Meta的Llama-3.2-3B性能高出一大截,甚至超过了70亿参数的模型性能。

而8B版本与Meta、谷歌开源的同类模型相比,在主流测试基准中同样大幅度超越。

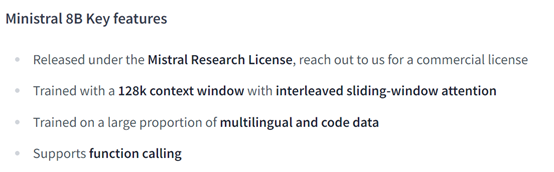

Ministral 3B和8B支持128k上下文长度,能够处理超长文本序列,这对于打造AI翻译、离线AI助手、本地数据分析AI助手等非常有帮助。

此外,如果你想开发一个更复杂的AI助手,也可以将Ministraux与Mistral Large等参数较大的模型混合使用,可以充当多流程的智能代理,处理输入解析、任务路由,并根据用户意图在极低延迟和成本下调用多个上下文的API。

架构方面,Ministral 8B版本使用了特殊的交错滑动窗口注意力机制,极大提升了推理效率、内存利用率以及用户响应,这也是能在移动端使用离线大模型的主要原因之一。

传统的Transformer自注意力机制需要对序列中的每个位置计算与其他所有位置的相似度,这会导致计算量和内存需求呈现二次方增长。

而滑动窗口注意力机制通过限制注意力计算的范围,仅在固定大小的窗口内进行计算,只计算窗口内的位置之间的相似度,并将注意分数归一化得到权重。这可以大幅度减少AI算力,并保持局部依赖性。

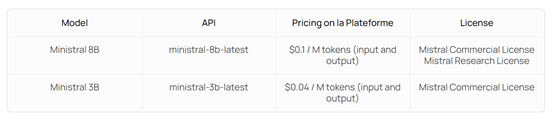

价格方面,如果不是本地部署也可以使用Mistral.AI服务,Ministral 8B 的API定价为每百万输入和输出token0.1美元,而Ministral 3B 的定价为每百万输入和输出token 0.04美元。

Mistral.AI表示,新发布的Ministraux只是他们对小参数模型的尝试,效果却非常好超过了一年前发布的Ministral 7B。

未来会继续开源更多高性能、小参数的模型,让更多的开发者可以轻松在本地部署使用。

好文章,需要你的鼓励

奥运级别的努力:首席信息官为2026年AI颠覆做准备

AI颠覆预计将在2026年持续,推动企业适应不断演进的技术并扩大规模。国际奥委会、Moderna和Sportradar的领导者在纽约路透社峰会上分享了他们的AI策略。讨论焦点包括自建AI与购买第三方资源的选择,AI在内部流程优化和外部产品开发中的应用,以及小型模型在日常应用中的潜力。专家建议,企业应将AI建设融入企业文化,以创新而非成本节约为驱动力。

字节跳动发布GAR:让AI能像人类一样精准理解图像任何区域的突破性技术

字节跳动等机构联合发布GAR技术,让AI能同时理解图像的全局和局部信息,实现对多个区域间复杂关系的准确分析。该技术通过RoI对齐特征重放方法,在保持全局视野的同时提取精确细节,在多项测试中表现出色,甚至在某些指标上超越了体积更大的模型,为AI视觉理解能力带来重要突破。

Spotify推出AI播放列表功能让用户掌控推荐算法

Spotify在新西兰测试推出AI提示播放列表功能,用户可通过文字描述需求让AI根据指令和听歌历史生成个性化播放列表。该功能允许用户设置定期刷新,相当于创建可控制算法的每周发现播放列表。这是Spotify赋予用户更多控制权努力的一部分,此前其AI DJ功能也增加了语音提示选项,反映了各平台让用户更好控制算法推荐的趋势。

Inclusion AI推出万亿参数思维模型Ring-1T:首个开源的超大规模推理引擎如何重塑AI思考边界

Inclusion AI团队推出首个开源万亿参数思维模型Ring-1T,通过IcePop、C3PO++和ASystem三项核心技术突破,解决了超大规模强化学习训练的稳定性和效率难题。该模型在AIME-2025获得93.4分,IMO-2025达到银牌水平,CodeForces获得2088分,展现出卓越的数学推理和编程能力,为AI推理能力发展树立了新的里程碑。