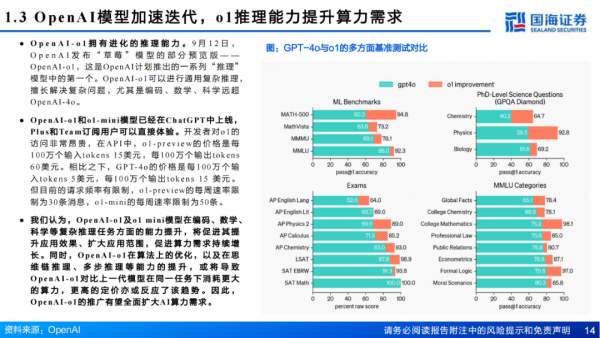

Blackwell GB200:英伟达GPU重塑AI服务器

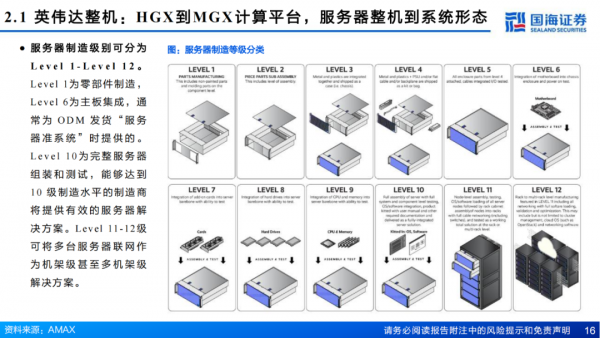

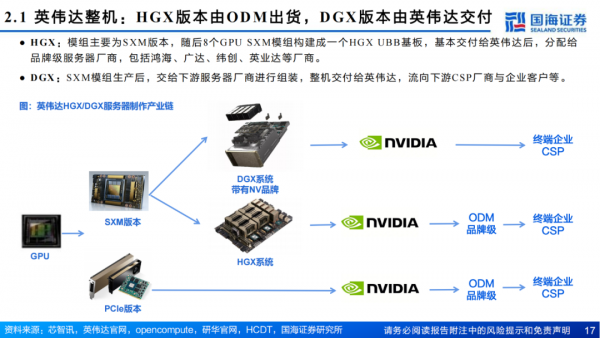

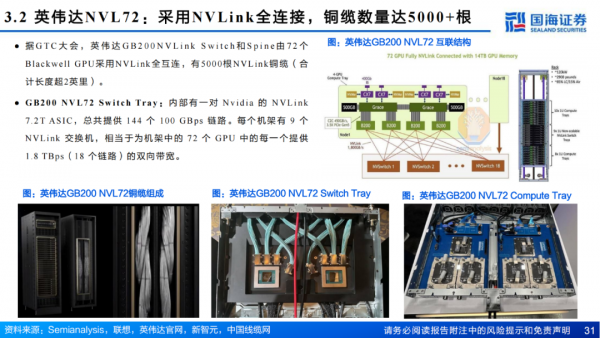

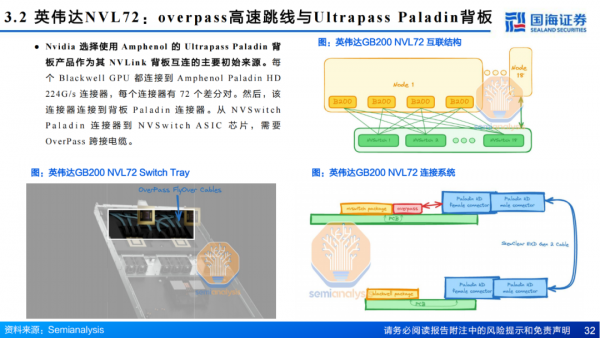

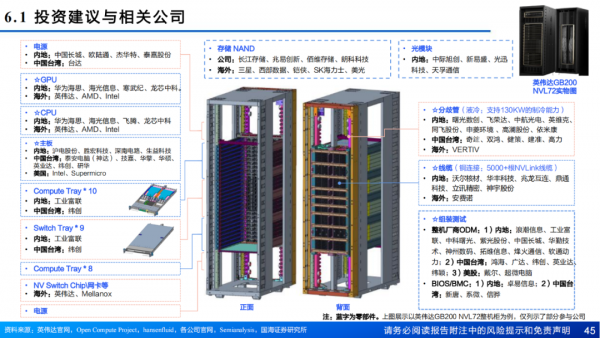

GB200主板从HGX模式变为MGX,HGX是NVIDIA推出的高性能服务器,通常包含8个或4个GPU,MGX是一个开放模块化服务器设计规范和加速计算的设计,在Blackwell系列大范围使用。MGX模式下,GB200 Switch tray主要为工业富联生产,Compute Tray为纬创与工业富联共同生产,交付给英伟达。据Semianalysis,有望带来机柜集成、HBM、铜连接、液冷等四个市场价值量2-10倍提升。

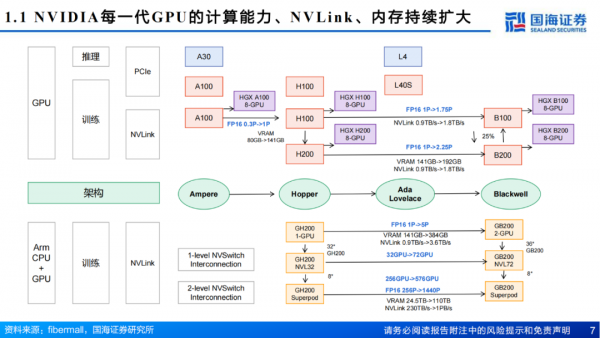

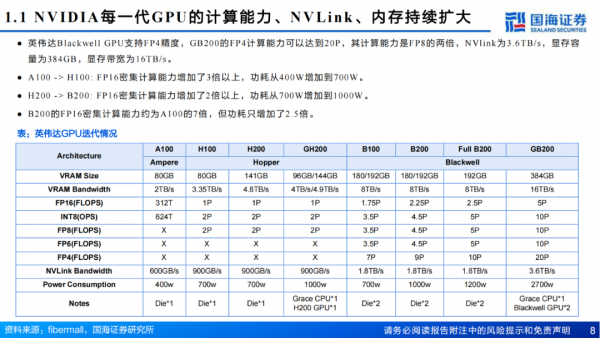

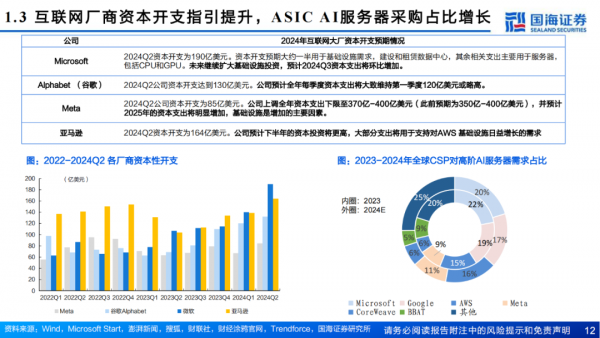

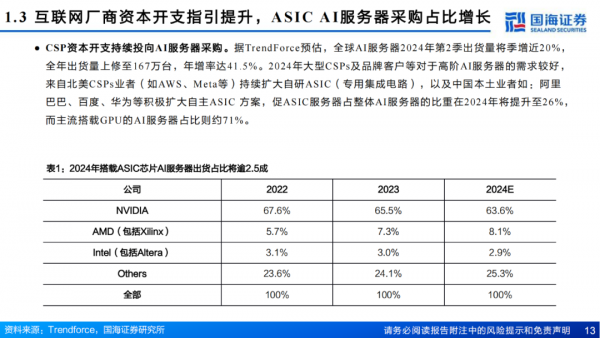

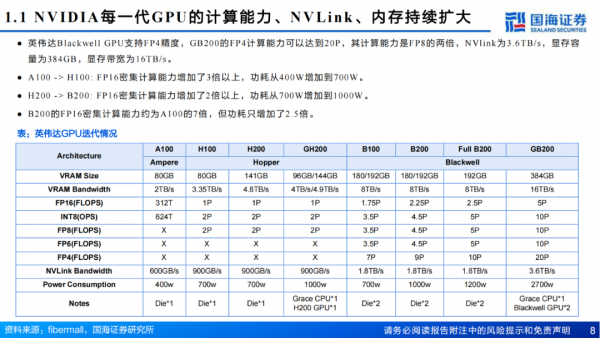

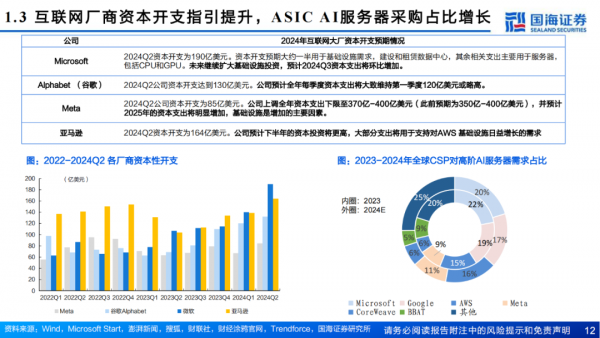

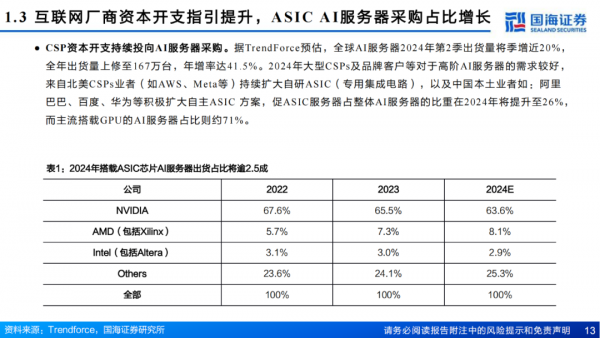

一、Blackwell系列:GB200计算能力远超H100,CSP厂商资本开支提升

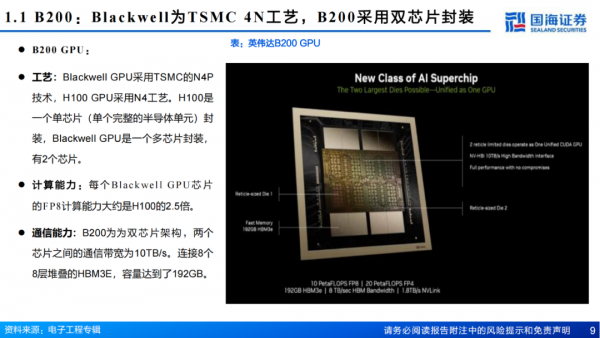

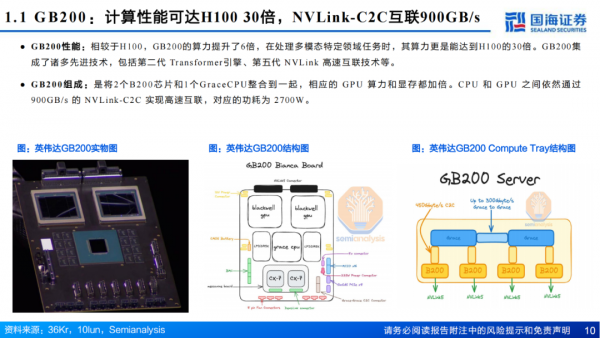

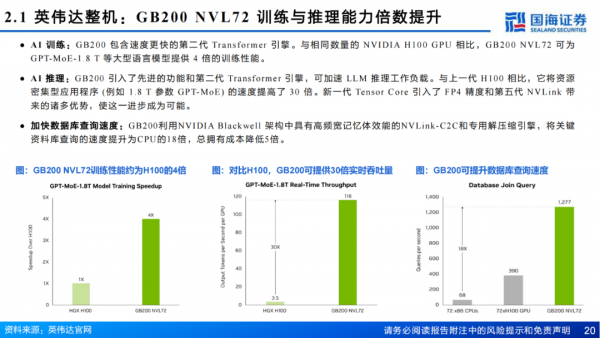

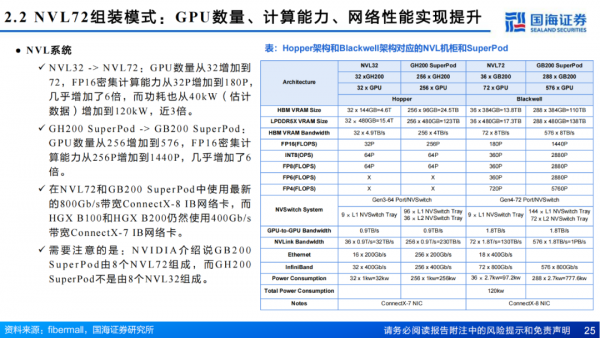

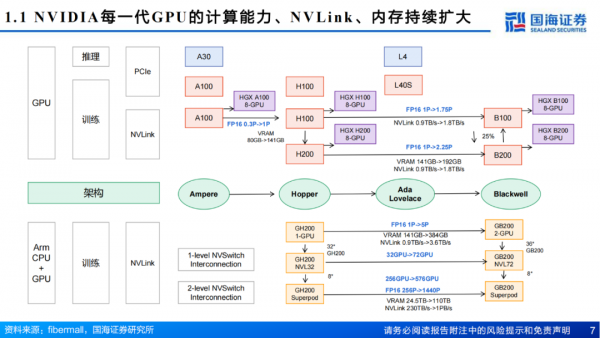

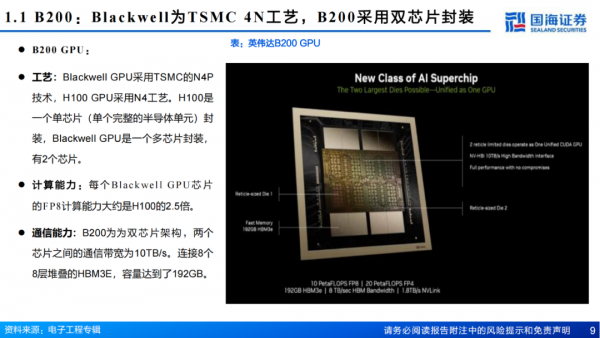

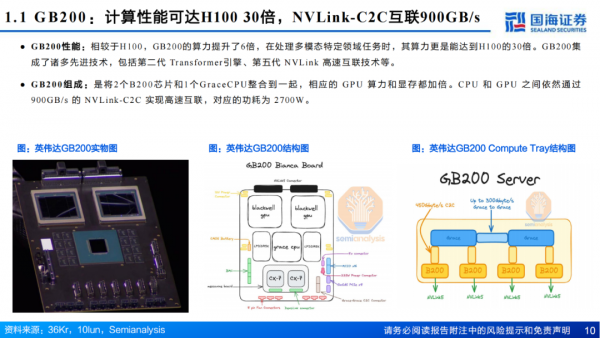

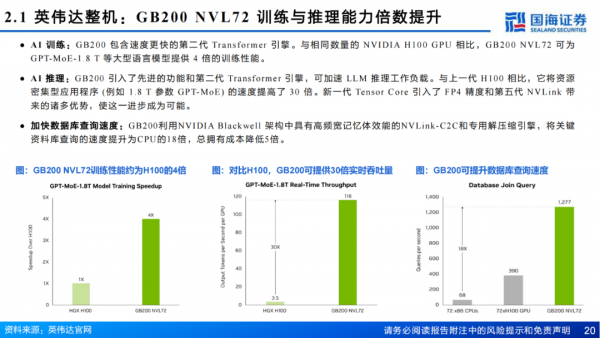

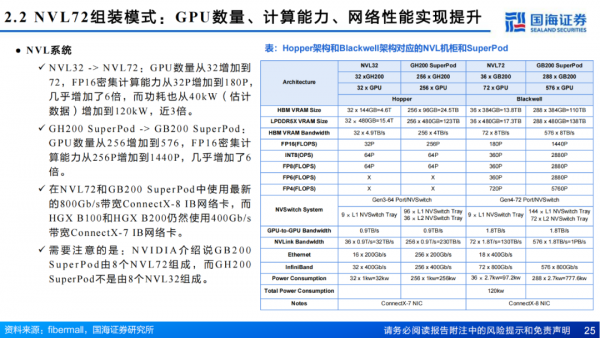

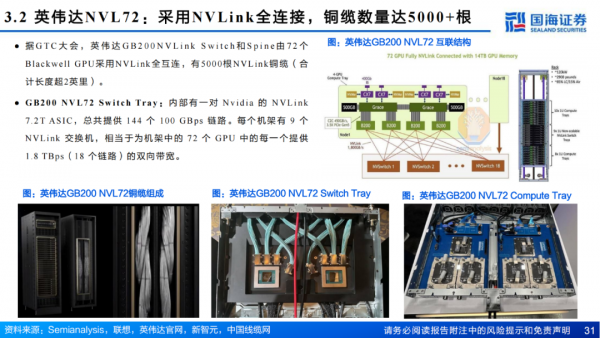

B200集成2080亿个晶体管,采用台积电N4P制程,为双芯片架构,192GB HBM3E,AI算力达20petaFLOPS(FP4),是Hopper的5倍。GB200机架提供4种不同主要外形尺寸,每种尺寸均可定制。与H100 相比,GB200 NVL72将训练速度(如 1.8 T 参数 GPT-MoE) 提高了 30 倍。

二、服务器细节拆分:主板从HGX到MGX,GB200 NVL72价值量提升

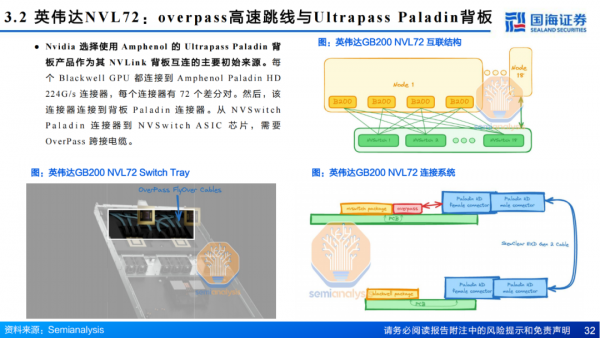

GB200主板从HGX模式变为MGX,HGX是NVIDIA推出的高性能服务器,通常包含8个或4个GPU,MGX是一个开放模块化服务器设计规范和加速计算的设计,在Blackwell系列大范围使用。MGX模式下,GB200 Switch tray主要为工业富联生产,Compute Tray为纬创与工业富联共同生产,交付给英伟达。据Semianalysis,有望带来机柜集成、HBM、铜连接、液冷等四个市场价值量2-10倍提升。

三、铜连接:DACs市场较快增长,GB200 NVL72需求较大

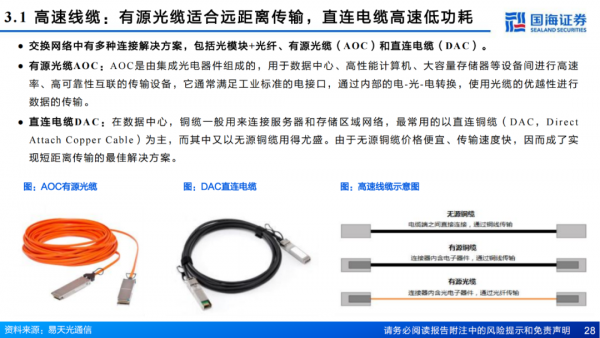

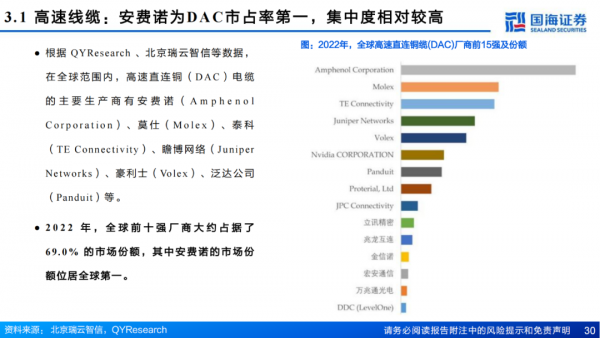

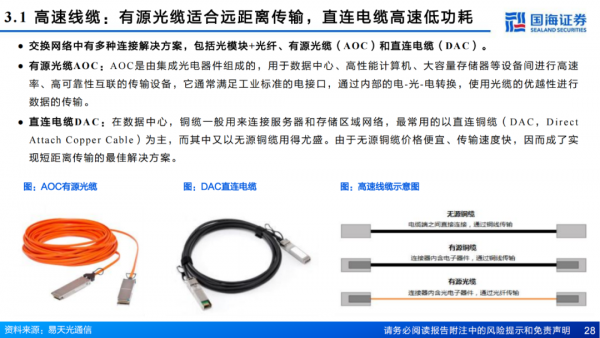

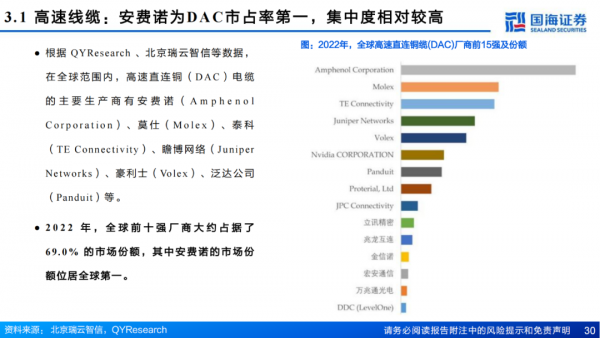

高速线缆中,有源光缆适合远距离传输,直连电缆高速低功耗。据LightCounting,高速线缆规模预期28年达28亿美元,DACs保持较快增长,Nvidia的策略是尽可能多地部署DACs。

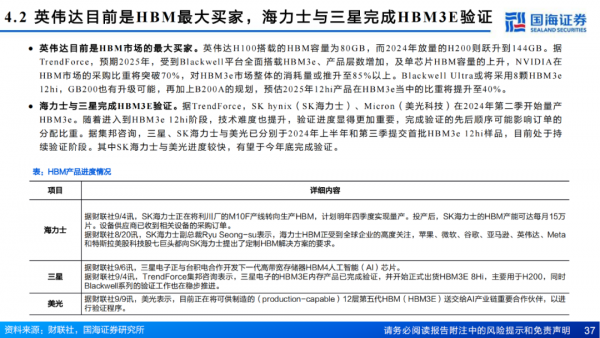

四、HBM:HBM3E将于下半年出货,英伟达为主要买家

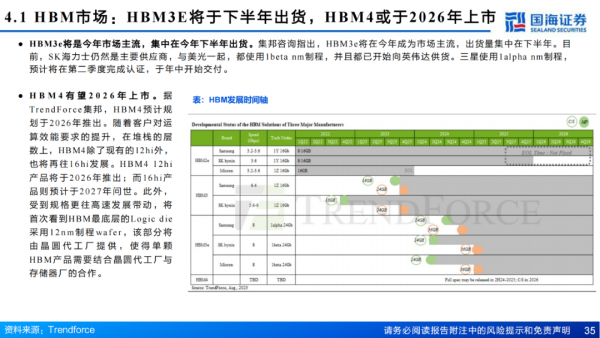

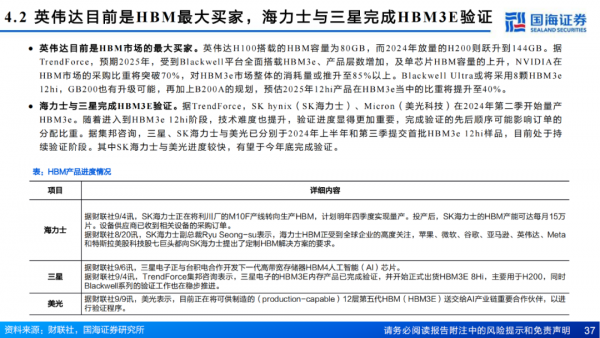

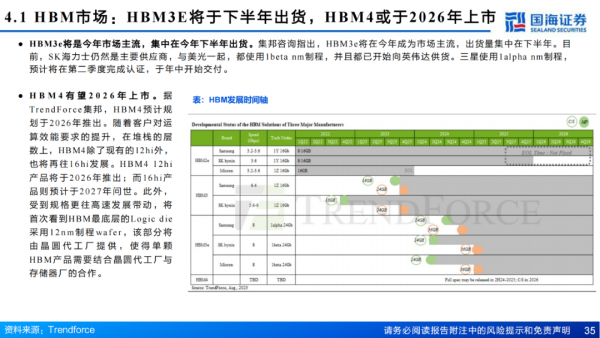

HBM 目前已经量产的共有HBM、HBM2、HBM2E、HBM3、HBM3E 五个子代标准。其中HBM3E将于下半年出货,HBM4或于2026年上市。

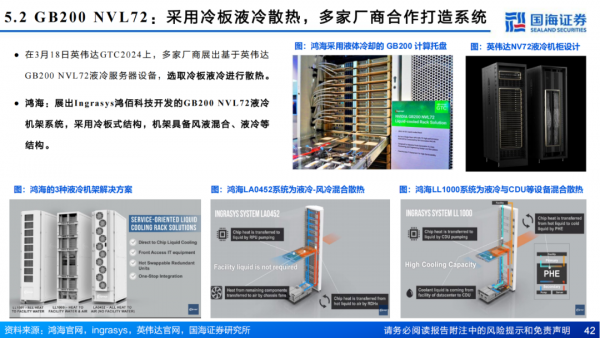

五、冷板式液冷较为成熟,GB200 NVL72采用液冷方案

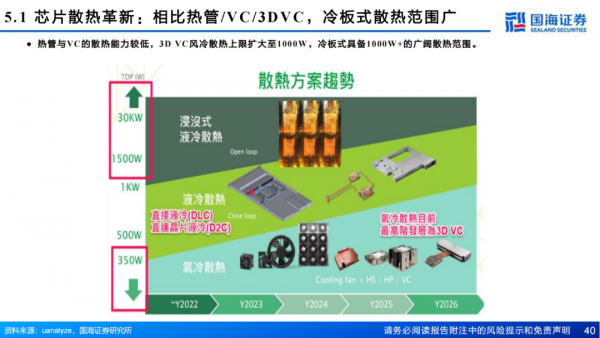

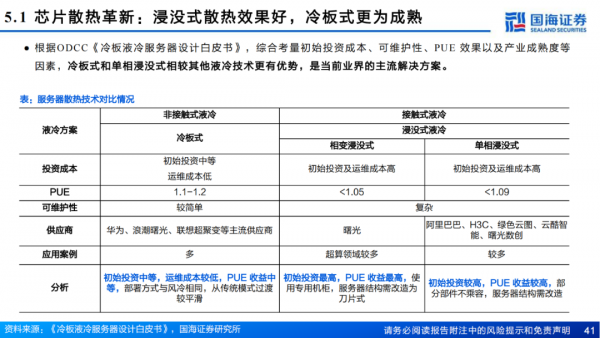

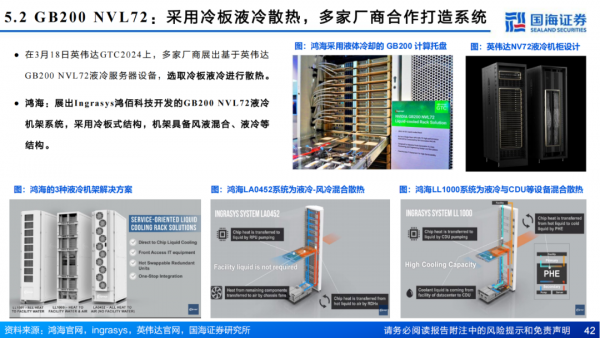

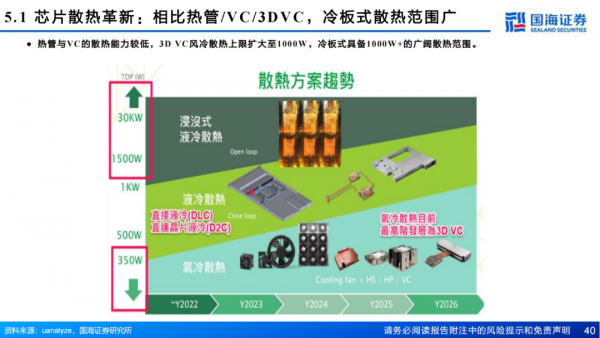

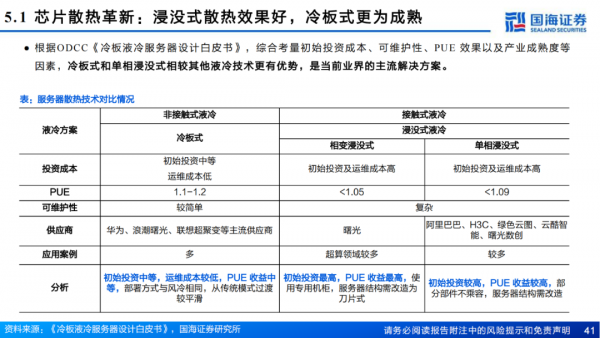

AI大模型训推对芯片算力提出更高要求,提升单芯片功耗,英伟达B200功耗超1000W、接近风冷散热上限。液冷技术具备更高散热效率,包括冷板式与浸没式两类,其中冷板式为间接冷却,初始投资中等,运维成本较低,相对成熟,英伟达GB200 NVL72采用冷板式液冷解决方案。

1、AI算力“卖水人”系列(1):2024年互联网AI开支持续提升 2、AI算力“卖水人”系列(2):芯片散热从风冷到液冷,AI驱动产业革新

3、AI算力“卖水人”系列(3):NVIDIA GB200:重塑服务器、铜缆、液冷、HBM分析

1、中伦互联网数据中心全解读 2、中国第三方数据中心服务商分析报告 3、面向AI 智算数据中心网络架构与连接技术的发展路线展望 4、新一代智算数据中心基础设施技术白皮书 5、中国数据中心产业发展白皮书

1、大语言模型在计算机视觉领域的应用 2、大模型的异构计算和加速 3、大模型辅助需求代码开发 4、大模型在华为推荐场景中的探索和应用 5、大模型在推荐系统中的落地实践 6、大语言模型的幻觉检测 7、大语言模型在法律领域的应用探索

0赞

0赞好文章,需要你的鼓励

推荐文章

推荐文章

很多人担心被AI取代,陷入无意义感。按照杨元庆的思路,其实无论是模型的打造者,还是模型的使用者,都不该把AI放在人的对立面。

MIT研究团队提出递归语言模型(RLM),通过将长文本存储在外部编程环境中,让AI能够编写代码来探索和分解文本,并递归调用自身处理子任务。该方法成功处理了比传统模型大两个数量级的文本长度,在多项长文本任务上显著优于现有方法,同时保持了相当的成本效率,为AI处理超长文本提供了全新解决方案。

谷歌宣布对Gmail进行重大升级,全面集成Gemini AI功能,将其转变为"个人主动式收件箱助手"。新功能包括AI收件箱视图,可按优先级自动分组邮件;"帮我快速了解"功能提供邮件活动摘要;扩展"帮我写邮件"工具至所有用户;支持复杂问题查询如"我的航班何时降落"。部分功能免费提供,高级功能需付费订阅。谷歌强调用户数据安全,邮件内容不会用于训练公共AI模型。

华为研究团队推出SWE-Lego框架,通过混合数据集、改进监督学习和测试时扩展三大创新,让8B参数AI模型在代码自动修复任务上击败32B对手。该系统在SWE-bench Verified测试中达到42.2%成功率,加上扩展技术后提升至49.6%,证明了精巧方法设计胜过简单规模扩展的技术理念。