Meta开源首个量化模型Llama 3.2:减少40%内存,效率提升2倍以上

全球社交巨头Meta开源了首个轻量级量化版模型Llama 3.2,一共有10亿和30亿两种参数。

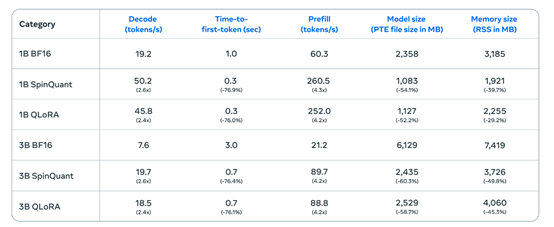

为了使该模型能在手机、平板、笔记本等移动设备上部署使用,Meta使用了带有LoRA适配器的量化感知训练和SpinQuant进行了大幅度性能优化,平均减少了41%的内存使用、减少56%的模型规模,但推理效率却提升了2—4倍。

例如,在一加12手机上,Llama 3.2的解码延迟平均提高了2.5倍,预填充延迟平均提高了4.2倍,而在三星的S24+、S22两款手机同样获得了类似的数据。

开源地址:https://huggingface.co/collections/meta-llama/llama-32-66f448ffc8c32f949b04c8cf

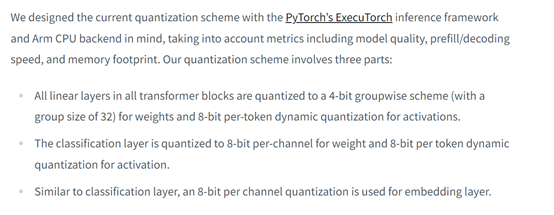

在架构方面,Llama 3.2 1B和3B采用了标准的Transformer结构。但对所有变压器块中的线性层进行了特定的量化处理,采用4位组方式量化权重,并对激活进行8位每标记动态量化。

分类层则量化为8位每通道的权重和8位每标记的动态激活量化,同时使用了8位每通道量化用于嵌入。

模型优化方面,使用了LoRA适配器量化感知训练和SpinQuant两种重要技术。LoRA适配器量化在初始化 QAT 时,会使用经过有监督微调后获得的BF16 Llama 3.2模型检查点,进行额外一轮带有 QAT 的有监督微调训练。

然后冻结 QAT 模型的主干,再使用低秩自适应的 LoRA 适配器对变压器块内所有层进行另一轮有监督微调,并且LoRA 适配器的权重和激活保持在 BF16,最后通过直接偏好优化进行微调得到高能效模型。

而SpinQuant是目前最先进的后训练量化技术之一,通过使用WikiText数据集来学习旋转矩阵,这些矩阵有助于平滑数据中的异常值,促进更有效的量化。在确定了旋转矩阵之后,应用了包括范围设置和生成性后训练量化在内的最佳量化效果。

该方法虽不如 QAT + LoRA 准确,但具有很灵活的可移植性,且无需访问通常是私有的训练数据集。这对于数据可用性或计算资源有限的应用来说,是一个非常好的解决方法。

开发者还可以使用此方法对自己微调后的 Llama 模型进行量化,以适应不同的硬件目标和用例,其开源库与 ExecuTorch和 Llama Stack 完美兼容扩展性很强。

虽然Llama 3.2 1B和3B的参数很小,但都支持128k tokens 的上下文长度,这对于移动端来说非常重要,可轻松处理长文本的总结、复杂指令的理解等场,例如,在处理长篇小说的内容总结、学术论文的要点提取等任务时,可以更好地理解文本的整体逻辑和语义,从而提供更准确的结果。

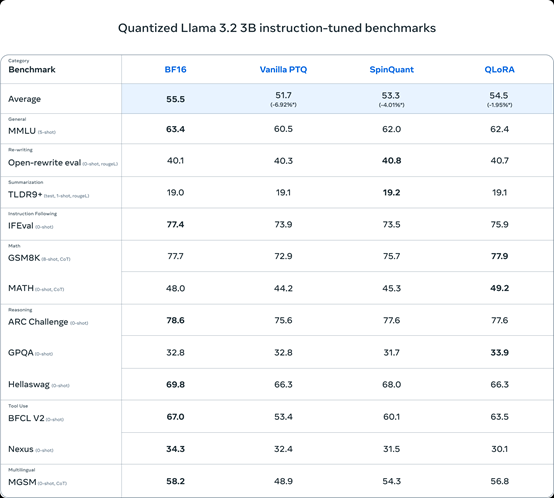

根据Meta公布的测试数据显示,在MMLU、GSM8K、MATH、MGSM等主流基准测试中,量化后的Llama 3.2不仅性能没有减少,还能与Llama 3 8B的性能媲美,充分证明了其高性能低消耗的特点。

好文章,需要你的鼓励

CES上杨元庆首谈AGI,碾压人类的叙事不会让AI更聪明

很多人担心被AI取代,陷入无意义感。按照杨元庆的思路,其实无论是模型的打造者,还是模型的使用者,都不该把AI放在人的对立面。

MIT递归语言模型:突破AI上下文限制的新方法

MIT研究团队提出递归语言模型(RLM),通过将长文本存储在外部编程环境中,让AI能够编写代码来探索和分解文本,并递归调用自身处理子任务。该方法成功处理了比传统模型大两个数量级的文本长度,在多项长文本任务上显著优于现有方法,同时保持了相当的成本效率,为AI处理超长文本提供了全新解决方案。

Gmail新增Gemini驱动AI功能,智能优先级和摘要来袭

谷歌宣布对Gmail进行重大升级,全面集成Gemini AI功能,将其转变为"个人主动式收件箱助手"。新功能包括AI收件箱视图,可按优先级自动分组邮件;"帮我快速了解"功能提供邮件活动摘要;扩展"帮我写邮件"工具至所有用户;支持复杂问题查询如"我的航班何时降落"。部分功能免费提供,高级功能需付费订阅。谷歌强调用户数据安全,邮件内容不会用于训练公共AI模型。

华为研究团队突破代码修复瓶颈,8B模型击败32B巨型对手!

华为研究团队推出SWE-Lego框架,通过混合数据集、改进监督学习和测试时扩展三大创新,让8B参数AI模型在代码自动修复任务上击败32B对手。该系统在SWE-bench Verified测试中达到42.2%成功率,加上扩展技术后提升至49.6%,证明了精巧方法设计胜过简单规模扩展的技术理念。