阿里提出LLaVA-MoD架构!利用MOE技术让小模型也能大显身手!

数源AI 最新论文解读系列

论文名:LLAVA-MOD: MAKING LLAVA TINY VIA MOEKNOWLEDGE DISTILLATION

论文链接:https://arxiv.org/pdf/2408.15881.pdf

开源代码:https://github.com/shufangxun/LLaVA-MoD

引言

多模态大型语言模型(MLLM)通过在大型语言模型(LLM)中集成视觉编码器,在多模态任务中取得了有希望的结果。然而,大型模型的大小和广泛的训练数据带来了显著的计算挑战。例如,LLaVA-NeXT的最大版本使用了Qwen-1.5-110B,并且使用128个H800 GPU训练了18小时。此外,大量的参数需要高级硬件,导致推理速度缓慢,这增加了现实世界的部署难度,特别是在移动设备上。因此,探索一种平衡性能和效率的小规模MLLM(s-MLLM)是一个关键话题。

简介

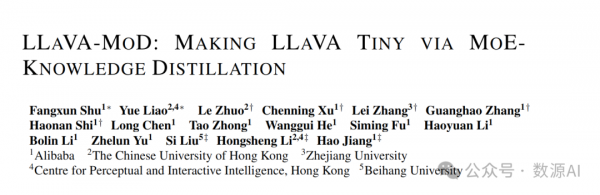

我们介绍LLAVA-MoD,这是一个新颖的框架,旨在实现小规模多模态语言模型(s-MLLM)从大规模多模态语言模型(l-MLLM)中提炼出知识的高效训练。我们的方法解决了LL-MM蒸馏的两个基本挑战。首先,我们通过将稀疏混合专家(MoE)架构集成到语言模型中,优化了s-MLLM的网络结构,在计算效率和模型表达性之间取得了平衡。其次,我们提出了一个渐进式知识转移策略,以实现全面的知识转移。这种策略始于模仿蒸馏,我们最小化输出分布之间的Kullback-Leibler(KL)散度,使s-MLLM能够模仿l-MLLM的理解。接下来,我们通过偏好优化(PO)引入偏好蒸馏,关键在于将l-MLLM视为参考模型。在此阶段,s-MLLM在区分优劣示例方面的能力显著增强,超越了l-MLLM,特别是在幻觉基准测试中。广泛的实验表明,LLaVA-MoD在保持最小激活参数和低计算成本的同时,超越了现有工作在各个基准测试上的表现。值得注意的是,LLaVA-MoD-2B在使用仅0.3%的训练数据和23%可训练参数的情况下,平均增益达到了8.8%,超过了Qwen-VL-Chat-7B。这些结果突显了LLaVA-MoD从其教师模型中有效提炼出丰富知识的能力,为开发高效的MLLM铺平了道路。

方法与模型

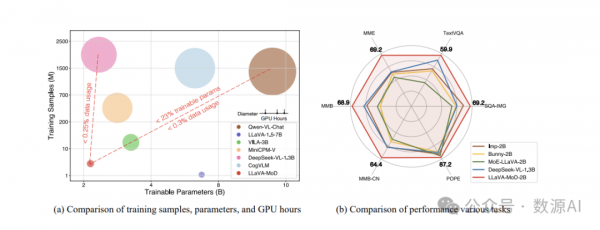

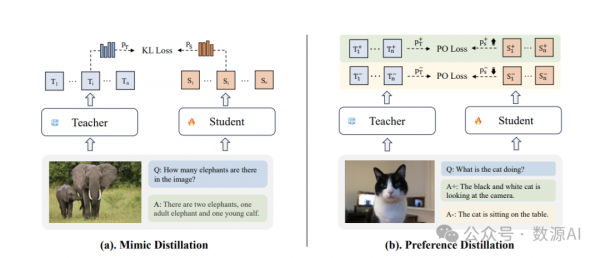

我们引入了LLaVA-MoD,这是一个用于构建高效s-MLLM的新框架,该框架结合了专家混合(MoE)和知识蒸馏。我们的框架由两个主要组成部分组成:(a)s-MLLM的架构设计:如图所示。3,我们设计了一个带有MoE的稀疏s-MLLM,增强了获取专业专家知识的能力,同时保持了训练和推理效率。(b)。蒸馏机制:我们设计了一个如图2所示的渐进式蒸馏机制,以从l-MLLM转移到稀疏s-MLLM。这个过程包括两个阶段:模仿蒸馏和偏好蒸馏。

1、稀疏s-MLLM的架构设计

s-MLLM的基本架构由三个主要组件组成:一个视觉编码器、一个大语言模型(LLM)和一个视觉-语言(VL)适配器。给定一个多模态指令对话(x, y)(x,y),我们定义我们的s-MLLM如下处理响应y:

稀疏化s-MLLM。构建我们的s-MLLM的原则是在保持视觉编码器和视觉-语言适配器不变的同时缩小LLM。为了实现这一缩小目标,我们通过引入MoE架构来稀疏化密集的s-MLLM。具体来说,图3展示了这个过程,我们应用稀疏上采样技术(Komatsuzaki等人,2022)来复制N个前馈网络(FFNs)作为专家模块。此外,我们引入了一个线性层作为路由器,它通过预测专家对齐的概率动态激活适当的专家。给定序列中的每个令牌x,w我们首先计算N个专家的路由值:

2、渐进式蒸馏

我们的渐进式蒸馏包括两个不同的阶段,即模仿蒸馏(图2(a))和偏好蒸馏(图2(b))。在模仿蒸馏阶段,s-MLLM πS 模仿来自l-MLLM πT 的通用和特定知识。在偏好蒸馏阶段,πS 获得 πT 的偏好知识以进一步细化其输出并减少幻觉。πS 和 πT 都来自同一LLM家族。这确保了一个一致的词汇空间,这对于准确的模仿至关重要。

(1)初始化

在蒸馏之前,我们首先通过一个可学习的适配器将视觉编码器与LLM对齐,旨在获得一个初始化良好的 πS 密集版本。LLMφ 和 ViTχ 保持冻结状态,因为它们的预训练参数已经捕获了丰富的视觉和语言知识。只有Projω 被优化来弥合视觉和语言领域之间的差距。对于初始化,我们利用广泛使用且经过精心策划的数据集中的常见图像-标题对,这些数据集涵盖了多样化的主题和视觉实体。训练目标是使生成的标记的交叉熵最小化。

(2)模仿蒸馏

我们将 πT 中的综合知识分解为一般和特定方面,以应对它们结构差异带来的挑战,这可能会使同时学习变得复杂。随后,我们进行从一般到特定的模仿蒸馏,包括两个步骤:密集到密集(D2D)和密集到稀疏(D2S)蒸馏,以将知识转移到 πS 中。这种两步方法通过逐步蒸馏平衡了一般和特定知识的转移,从而提高了整体性能。如图 3 所示,我们在 D2D 期间利用πS 的密集结构来获取一般知识,并在 D2S 期间将其转换为稀疏结构以获取复杂的特定知识。在整个过程中,πT 保持不变。

(3)偏好蒸馏

在这个阶段,我们的目标是从l-MLLM中蒸馏出偏好知识,以指导s-MLLM生成不仅准确而且合理的响应,这在减少幻觉方面至关重要。在训练过程中,我们有效地使用偏好数据,包括对相同提示x精心配对的正面响应y+和负面响应y–。我们的偏好蒸馏策略受到最近在偏好优化(PO)方面的进展的启发,它通过直接在离线偏好数据集上训练来绕过训练奖励模型的需求。我们的关键见解是将l-MLLM视为参考模型,以提供关于什么是“好”的和“坏”的洞察,从而为s-MLLM建立了一个基本参考。

实验与结果

实验细节

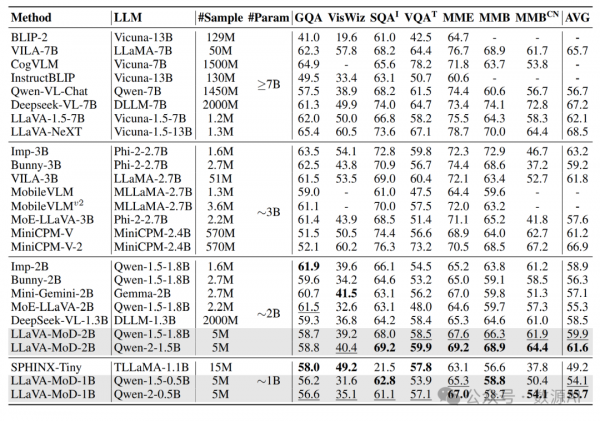

我们采用"ViT-MLP-LLM"架构来展示 LLaVA-MoD 的有效性。使用预训练的 CLIP-ViT-L/14 作为视觉编码器,以及一个两层 MLP 作为适配器。使用不同大小的 Qwen-1.5/2 作为 l-MLLM 和 s-MLLM 的 LLM。具体来说,l-MLLM 配置了 7B 参数,而 s-MLLM 配置了 1.8B 和 0.5B 参数。l-MLLM 在多模态基准测试上的性能在表 1 中展示。我们对蒸馏使用相同的 LLM 系列,即使用 Qwen-1.5 7B 来蒸馏 Qwen-1.5 1.8B 和 Qwen-1.5 0.5B。

定量对比结果

以理解为导向的基准测试。如表所示,LLaVA-MoD在1B和2B大小的模型中实现了理解为导向基准测试的平均最佳成绩。2B大小的LLaVA-MoD比Mini-Gemini-2B高出8.1%,同时使用了较低的图像分辨率(336对比768)。1B大小的LLaVA-MoD比SPHINX-Tiny高出13%。2%,使用的数据样本较少(500万对比1500万)。此外,LLaVA-MoD-2B匹配甚至超过了大规模MLLM的性能。2B大小的LLaVA-MoD比Qwen-VL-Chat-7B高出8.8%,并且与VILA-3B(林等人,2024b)和MiniCPM-V的性能相匹配。这些结果突显了我们的方法通过从大规模MLLM中蒸馏稀疏MoE架构,有效地训练小规模MLLM。

好文章,需要你的鼓励

AI投资有望在2026年获得真正回报的原因解析

尽管全球企业AI投资在2024年达到2523亿美元,但MIT研究显示95%的企业仍未从生成式AI投资中获得回报。专家预测2026年将成为转折点,企业将从试点阶段转向实际部署。关键在于CEO精准识别高影响领域,推进AI代理技术应用,并加强员工AI能力培训。Forrester预测30%大型企业将实施强制AI培训,而Gartner预计到2028年15%日常工作决策将由AI自主完成。

北大学者革新软件诊断方式:让代码问题的“病因“无处遁形

这项由北京大学等机构联合完成的研究,开发了名为GraphLocator的智能软件问题诊断系统,通过构建代码依赖图和因果问题图,能够像医生诊断疾病一样精确定位软件问题的根源。在三个大型数据集的测试中,该系统比现有方法平均提高了19.49%的召回率和11.89%的精确率,特别在处理复杂的跨模块问题时表现优异,为软件维护效率的提升开辟了新路径。

2026年软件定价大洗牌:IT领导者必须知道的关键变化

2026年软件行业将迎来定价模式的根本性变革,从传统按席位收费转向基于结果的付费模式。AI正在重塑整个软件经济学,企业IT预算的12-15%已投入AI领域。这一转变要求建立明确的成功衡量指标,如Zendesk以"自动化解决方案"为标准。未来将出现更精简的工程团队,80%的工程师需要为AI驱动的角色提升技能,同时需要重新设计软件开发和部署流程以适应AI优先的工作流程。

德国达姆施塔特工业大学团队首次揭秘:专家混合模型AI的“安全开关“竟然如此脆弱

这项由德国达姆施塔特工业大学领导的国际研究团队首次发现,当前最先进的专家混合模型AI系统存在严重安全漏洞。通过开发GateBreaker攻击框架,研究人员证明仅需关闭约3%的特定神经元,就能让AI的攻击成功率从7.4%暴增至64.9%。该研究揭示了专家混合模型安全机制过度集中的根本缺陷,为AI安全领域敲响了警钟。