数据中心运营中的节能降碳措施综述与应用

1、数据中心能耗情况分析

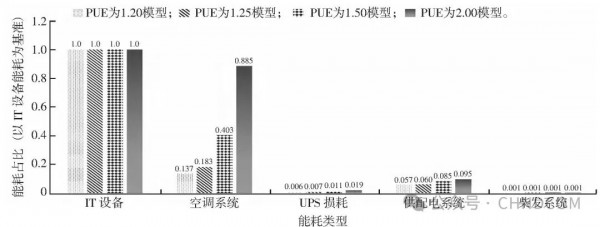

图1 数据中心能耗分布柱状图

注:PUE为电源使用效率,UPS为不间断电源。

1)在数据中心建设初期一定要遵照相关法律法规政策,如《高耗能落后机电设备(产品)淘汰目录》,确保未选用落后淘汰设备。

2)在满足工艺要求的情况下,数据中心应选用性能稳定、操作可靠、维修简单、能耗低的新技术和先进设备。

3)在总图布置及机房楼、变电站等关键设施的布置上,需确保紧凑合理,减少线路和变压器的损耗。

5)注意密封机机架内部的空隙、机架与机架之间的空隙、机架底部的空隙,以防热风灌入。

1)根据工程的总图布置规划,合理配置配电室以减小电缆长度,同时,优化配电线路,降低供电系统线损,提高平均负荷与最大负荷之比,选用低耗能、高功率的电气设备,减少配电环节电能消耗。

2)选用新型、节能的各类产品。车间供电应将线路长度降到最小,将电力损失降到最低;增加动力,减少无功损失。

3)产品选用高效节能的绿色环保型照明灯具,该灯具可自动开闭照明器,利用智能声光控制技术减少电力损失。根据各场所使用功能的不同,采用与之相符的光源和灯具。

1)机房楼管道和所有热力设备的保温均采用轻质高效保温外墙和屋面隔热材料等新型保温材料,以减弱热传导效应。

3)建筑充分考虑自然采光与通风,应尽量减少人工照明与机械通风。冬季最大限度地利用自然热进行加热,发热更多,减少损耗;夏季最大限度地利用天然能量降温,节约能源,降低消耗。

4)根据GB/T7107—2002《建筑外窗气密性能分级及检测方法》,建筑物外窗气密性能分级不应低于6级,采用传热性和遮阳性符合要求的塑钢窗、中空玻璃等。

1)由于数据中心大多数选址于工业开发区或偏远僻静的地方,距离人员聚集的城市或建筑设施较远,余热的供出无法满足城镇用热需求,仅为数据中心内部的运维楼、办公楼、生活楼等区域供暖,周边单位未实现有效供应。

2)关于数据中心余热的回收与利用,中国并没有出台相关标准和政策,国内也没有指导性的依据来支持数据中心开展余热回收项目。

3)国内数据中心余热回收能量利用存在效率相对较低、热交换效率不高、管线损耗高等问题,且中国目前设备制造能力和余热工艺方案的技术先进性与国外数据中心有着较大的差距。

4)考虑到目前的经济形势,数据中心余热回收利用项目的落地对于企业来说是一笔不小的投资,并且由于回收效果差、用热单元稀少等,项目投资回收期较长。

3、结束语

作者:穆建军

参考文献:

[1]石云鹏.“双碳”背景下数据中心能耗现状与节能技术研究[J].中国新通信,2022,24(8):119-121.

[2]张忠斌,邵小桐,宋平,等.数据中心能效影响因素及评价指标[J].暖通空调,2022,52(3):148-156.

[3]杨春梅,黎晓彬,杨昉,等.基于咨询案例的数据中心绿色发展研究[J].节能,2023,42(7):66-68.

[4]李德明,朴春爱,陈磊.大型数据中心制冷系统设计探讨[J].信息工程,2017(9):30.

[5]马妍,刘小林.以零碳数据中心为生产力提质增新[J].中国电信业,2024(3):24-28.

-END-

未经授权,禁止转载。公众号:数据中心基础设施运营管理

【版权声明】

凡本公众平台注明来源或转自的文章,版权归原作者及原出处所有,仅供大家学习参考之用,若来源标注错误或侵犯到您的权利,烦请告知,我们将立即删除。

【免责声明】

本公众平台对转载、分享的内容、陈述、观点判断保持中立,不对所包含内容的准确性、可靠性或完善性提供任何明示或暗示的保证,仅供读者参考。

好文章,需要你的鼓励

更高负载、更快建设:2026年数据中心六大趋势

随着人工智能和高性能计算持续推动需求增长,数据中心设计正以同样惊人的速度演进。曾经的高密度机架已成为标准配置,冷却系统在数月而非数年内完成重新设计,项目在各地区的规模和复杂性不断提升。全球工程设计咨询公司Black & White Engineering指出,液冷成为标准配置、极端机架密度管理、工业化规模交付、电网约束下的电力创新、AI驱动运营设计以及可持续性成为核心设计原则,将成为2026年塑造数据中心设计、建设和运营的六大关键趋势。

让任何视频都能“讲述“自己的故事:ByteDance研究团队如何用轨迹场重新定义4D视频理解

这项由ByteDance Seed、香港科技大学等机构联合完成的研究提出了"轨迹场"这一创新的4D视频表示方法。研究团队开发的Trace Anything系统能够在单次前向传递中为视频中的每个像素预测连续的三维轨迹,无需光流估计或迭代优化。通过构建大规模合成数据平台和精心设计的训练方案,该方法在轨迹估计基准上实现了最先进性能,同时推理速度比竞争方法快10倍以上,并展现了运动预测、时空融合等多种涌现能力。

Snowflake数据库更新引发全球大规模服务中断

Snowflake本周推送的一次更新导致全球范围内的"重大故障",用户长达13小时无法查询数据、文件导入失败并收到错误信息。初步调查显示,最新版本引入了不向后兼容的数据库架构更新,导致版本不匹配错误。此次故障影响了全球23个区域中的10个,包括美国、欧洲和亚洲多个数据中心。这是Snowflake一周内第二次发生事故。

伊斯法罕大学研究团队揭秘:AI教育应用如何在数字化教学时代赢得用户青睐

伊斯法罕大学研究团队通过分析Google Play商店21款AI教育应用的用户评论,发现作业辅导类应用获得超80%正面评价,而语言学习和管理系统类应用表现较差。用户赞赏AI工具的快速响应和个性化指导,但抱怨收费过高、准确性不稳定等问题。研究建议开发者关注自适应个性化,政策制定者建立相关规范,未来发展方向为混合AI-人类模型。