刚刚,OpenAI开源SimpleQA!轻松检测、校准大模型能力

今天凌晨,OpenAI开源了最新基准测试集SimpleQA,可以帮助开发者轻松检测、校准大模型的真实性能力。

目前,很多大模型会出现一本正经胡说八道的问题,例如,你提问NBA历史上得分最多的是谁,它回答是迈克尔乔丹,实际上是勒布朗詹姆斯。包括OpenAI自己发布的GPT-4o、o1-preview、o1mini等前沿模型都有这些“幻觉”难题。

所以,SimpleQA对于开发者来说,可以精准测试大模型能否输出正确的答案,并对模型的说谎能力进行校准然后进行大幅度优化完善模型能力。

开源地址:https://github.com/openai/simple-evals

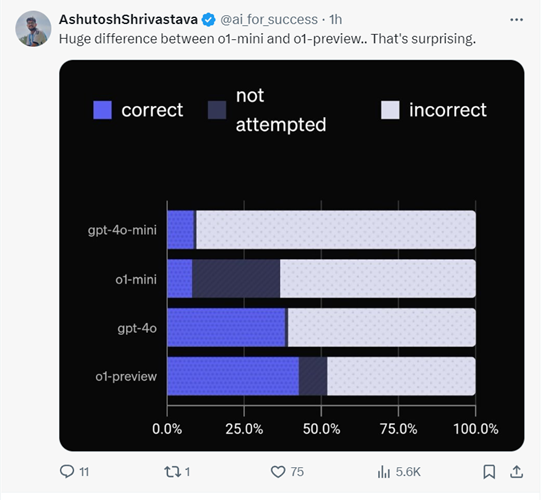

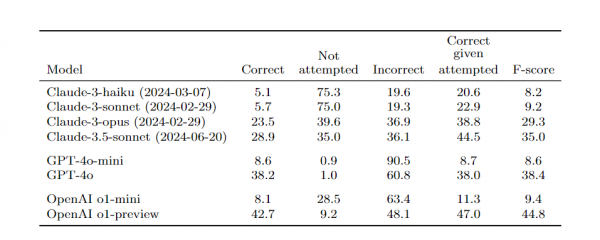

有网友表示,看了SimpleQA的测试数据才发现,o1-mini和o1-preview的性能差距这么大,o1-mini连GPT-4o都打不过。

令人惊讶的是,SimpleQA 被有意设计用来挑战像 GPT-4 这样的高级模型,其中只包括至少有一次模型尝试失败的问题。这种对抗性的基准测试方法感觉像是一种大胆的转变,旨在揭示模型的局限性并推动模型的发展。

多整开源这是好事。别忘了你名字的初衷啊~

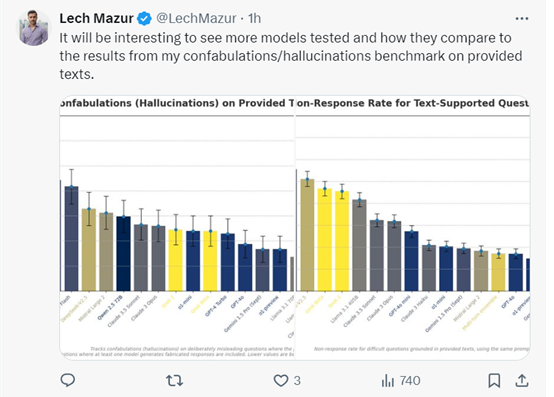

这很有趣,会看到更多的模型被测试,以及它们与我在提供的文本上进行的虚构/幻觉基准测试结果的比较。

很想看看o1模型的完整版测试。

完全同意事实性在人工智能中的重要性。SimpleQA 的引入可以显著提升我们对语言模型在这一领域表现的理解。这是一项及时的举措,准确的数据对于信任人工智能系统至关重要。期待看到这个基准测试的影响。

这很重要,因为确保大模型的事实性对于防止错误信息的传播至关重要,而 SimpleQA 提供了一种标准化的方法来评估和改进模型可靠性的这一关键方面。

很棒,重要的更新!

SimpleQA简单介绍

在数据收集阶段,SimpleQA的问题参考答案由两名独立的 AI 训练员确定,并且训练员在创建问题时被要求提供支持答案的网页链接,以确保答案有可靠的依据。

例如,对于 “谁是苹果公司的创始人之一” 这样常识性问题,训练员会根据历史资料和官方信息确定答案为 史蒂夫乔布斯等,并附上如苹果公司官方网站等相关链接作为证据。

同时,问题的设计使得预测答案易于评估,只允许有一个明确且无可争议的答案,避免了模糊性和歧义性。比如 “哪一年 iPhone 首次发布”,答案明确为“2007 年”,而不是一个范围或模糊的表述。

SimpleQA的评估问题和答案都非常简短,这使得运行速度快且操作简单。在评估模型回答时,通过 OpenAI API进行评分也十分迅速。数据集中包含4326个问题,能够在一定程度上降低不同次运行之间的方差,使评估结果更加稳定可靠。

例如,在对多个模型进行测试时,不会因为数据集本身的不稳定性而导致结果出现较大波动,从而能够更准确地比较模型之间的性能差异。

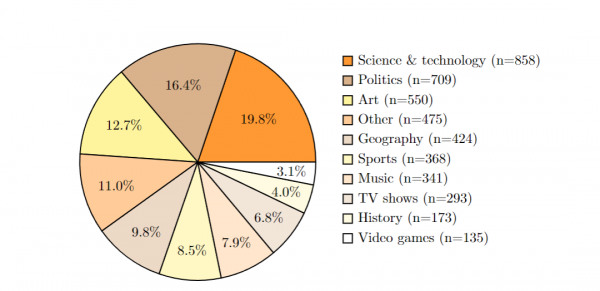

SimpleQA的评估集非常多元化。涵盖历史、科学技术、艺术、地理、电视节目等多个领域。这种多样性使得评估结果更具普遍性和代表性,能够全面地检验模型在不同知识领域的事实性回答能力。

另一个好处是它的校准测量功能。通过询问模型对其答案的信心,研究者可以了解模型是否知道它们知道什么,这是一个很重要的校准现象。如果一个模型能够准确地评估自己的信心水平,那么它就是一个校准良好的模型。

OpenAI通过SimpleQA对GPT-4o、o1-preview、o1mini、Claude-3-haiku、Claude-3-sonnet等前沿模型进行了综合测试。结果显示,较大模型通常具有更高的性能,但即使是前沿模型在SimpleQA 上的表现也并非完美。

例如,GPT - 4o 在回答一些问题时能够给出较高比例的正确答案,但仍有部分错误回答和未尝试回答的情况。同时,通过测量模型的校准情况,发现模型虽然有一定的信心概念,但普遍存在高估自己信心的问题,模型的信心水平与实际回答的准确性之间存在差距。

好文章,需要你的鼓励

苹果注重隐私的年龄验证方案可解决两大难题

美国多州和部分国家要求特定应用进行年龄验证,澳大利亚已禁止16岁以下用户使用社交媒体。新提案《应用商店问责法案》建议由苹果和谷歌负责统一验证用户年龄,而非各开发者单独验证。这将提升用户体验,用户只需向苹果或谷歌验证一次身份。凭借苹果在隐私保护方面的优势,该方案可扩展至Safari浏览器,为需要年龄验证的网站提供确认信息,而无需透露用户个人数据。

Meta AI团队首次破解多模态奖励模型评估难题,让AI既能看懂图片又能准确判断好坏

Meta AI首次发布多模态奖励评估基准MMRB2,专门评价AI同时处理文字和图像的能力。该基准包含四大任务类型共4000个专家标注样本,测试23个先进模型。结果显示最佳模型Gemini 3 Pro达75-80%准确率,仍低于人类90%水平。研究揭示AI评价存在视觉偏见等问题,为多模态AI发展提供重要参考标准。

Cursor通过收购Graphite继续扩张之路

AI编程助手Cursor背后的公司Anysphere宣布收购AI代码审查工具初创公司Graphite。据报道收购价远超Graphite今年早些时候B轮融资时2.9亿美元的估值。此次收购具有战略意义,将AI代码生成与AI代码审查工具相结合,可大幅提升从编写到交付的整体效率。Anysphere估值已达290亿美元,近期频繁收购,上月收购技术招聘公司,今年7月还收购AI客户关系管理初创公司Koala的团队。

快手推出Kling-Omni:一个AI模型搞定所有视频制作需求

快手推出的Kling-Omni是首个真正统一的AI视频制作系统,能够理解文字、图像、视频等多种输入方式,不仅可以生成视频,还能进行复杂编辑和推理。该系统通过三个核心模块的协作,实现了从创意理解到最终输出的全流程自动化,让普通用户也能制作专业水准的视频内容,代表了AI视频技术的重要突破。