AI数据中心(AIDC)和IDC概念、指标等对比分析

AIDC(Artifcial Intelligence Data Center),即人工智能数据中心(2024全球AIGC产业全景洞察),是指集成了高性能计算能力、c处理能力、人工智能算法和云计算服务的综合信息处理中心(内容参考自“AI数据中心(AIDC)建设白皮书合集”)。

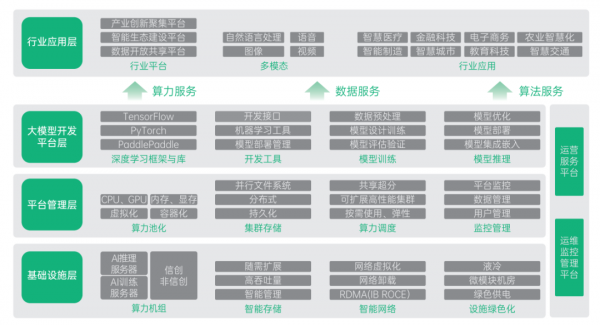

AIDC基本架构

AIDC的基本架构可以划分为多个层次和组成部分。在总体架构上,AIDC可以被划分为基础设施层、平台管理层、大模型开发平台层,以及行业应用层,如图所示。

基础设施层包括AI训推服务器、智能存储、智能网络、模块化机房。为整个AIDC提供高效的存储服务,智算资源和存储资源则通过网络系统进行互联,形成一个整体的智算资源池,并辅以模块化机房形成IDC基础设施层。

平台管理层包括是构建高效、灵活且可扩展的AI计算平台的重要组成部分。在这一层,通过虚拟化技术(如KVM、Docker等)、容器编排调度系统(如Kubernetes)、分布式存储和计算框架(如Hadoop、Spark)等技术手段,将底层的物理资源抽象化、池化并进行高效的管理和调度,从而构建出可弹性伸缩、易于管理的AI计算资源池。

大模型开发平台层,主要是提供一系列大模型开发的工具和服务。这些工具和服务可能包括模型训练框架、数据集管理、模型调优算法、模型评估指标等,以支持从数据准备到模型部署的全流程。

AIDC架构中的行业应用层是人工智能产业的核心部分,它不仅是技术与应用之间的桥梁,更是推动产业智能化升级、提升产业效率、满足个性化需求的关键所在。

综上所述,AIDC的基本架构是一个融合了硬件、软件、网络、应用等多个层面的复杂系统,它的设计旨在提供高效、灵活的人工智能计算服务,推动AI产业化、产业AI化及政府治理智能化的目标实现。

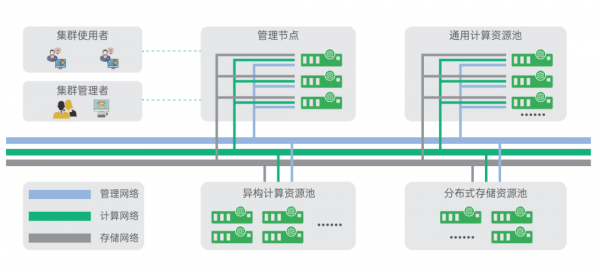

AIDC逻辑拓扑

AIDC的逻辑拓扑,如图所示,通常包括通用计算资源池、异构计算资源池、分布式存储资源池、数据传输网以及运维管理中心等核心区域。这些区域协同工作,共同构成AIDC的基础架构。

其中,计算资源是AIDC的核心部分,负责执行复杂的计算任务。它通常包括通用计算资源池和异构计算资源池,其中通用计算资源池主要用于传统HPC业务,异构计算资源池则用于进行AI训练推理等相关业务。异构计算节点采用的异构加速芯片多种多样,主要包括GPU、FPGA、ASIC等,主流的厂商有NVDIA、AMD、Intel,国内的加速芯片厂商主要有昇腾、天数、昆仑芯、寒武纪等。

分布式存储资源池负责存储和管理大量的数据资源,为智算任务提供必要的数据支持。数据传输网是AIDC中各个组件之间数据传输的通道,它确保数据在AIDC内的快速、准确传输,通常使用RoCE技术或者IB网络来实现低延时、无丢包的高性能网络通信。

此外,AIDC的逻辑拓扑还可能包括其他辅助组件,如安全管理模块、网络管理模块等,这些模块共同提升AIDC的安全性和可靠性。

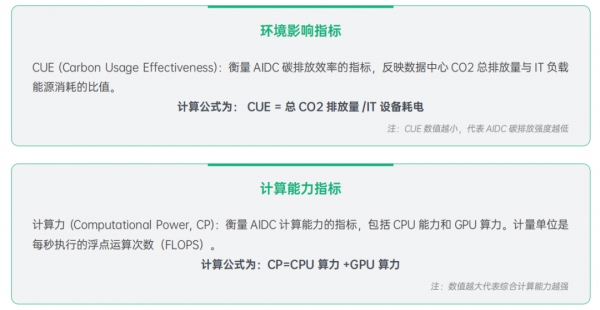

AIDC评价指标

AIDC评价指标是衡量AIDC性能、效率和绿色化程度的一系列标准,对于AIDC的规划、建设和运营至关重要。AIDC评价指标可以根据其衡量的内容分为以下几个类别:

这些指标共同构成了一个全面的评估框架,用于评价 AIDC 在能源利用、环境影响、计算力、运载力和存储力以及综合服务能力等方面的性能。通过这些指标,可以对 AIDC 的设计、建设和运营进行优化,以实现更高的效率和更好的性能。

AIDC与IDC对比分析

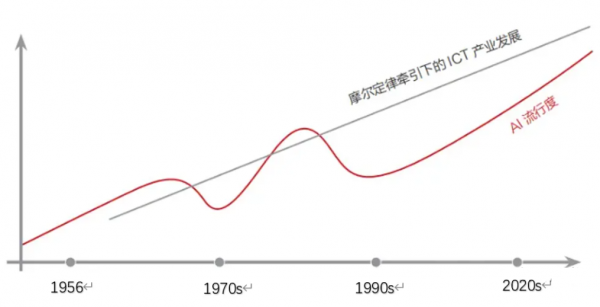

未来10年是AIGC爆发的10年,也是机会遍地的10年。

在全球人工智能迅猛发展的背景下,传统的互联网数据中心(IDC)正在经历一场史诗级的变革,向人工智能数据中心(AIDC)进化。就像《变形金刚》里的汽车人一样,传统数据中心正逐步升级为超级智能的AIDC,成为各行业智能化升级的“加速器”。

一、技术层面差异

1、承载业务层面的差异

IDC(互联网数据中心Internet Data Center简):主要承载企业级应用和数据存储,如Web服务、数据库管理和文件存储等常规信息处理任务,涉及AI训练、推理类的应用很少。

AIDC(自动识别和数据提取Automatic Identification and Data Capture简称):为人工智能和大数据应用提供算力、存储和相关服务的数据中心。通过在数据中心中增设智能计算资源,提供AI模型训练、推理、数据存储和处理等服务。

2、算力类型差异

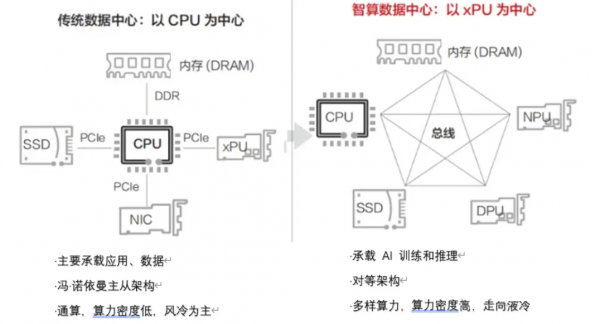

IDC:以CPU为中心,适用于一般性的计算需求。

AIDC:以GPU类芯片为中心,提供并行计算,处理 AI模型训练所需的大量矩阵运算。

3、技术架构差异

IDC:采用冯·诺依曼的主从架构,其中CPU 扮演指挥官的角色,负责分配任务给其他部件。这种架构在面对大规模并行计算任务时存在“计算墙”“内存墙”和“I/0 墙”等问题,限制了性能的进一步提升。

AIDC:通常采用更加先进的全互联对等架构,允许处理器之间,以及处理器到内存、网卡等直接通信,减少了中心化控制带来的延迟,突破主从架构的算力瓶颈,实现了高效的分布式并行计算。

4、散热模式差异

IDC:单机柜功率密度通常在 4~8千瓦之间,可装载的服务器设备数量有限,算力密度相对较低,一般采用传统的风冷散热。

AIDC:单机柜功率密度通常在 20~100 千瓦之间,主要采用液冷或风液混合的散热技术。液冷能够更有效地带走热量,保证高性能计算设备的稳定运行。

二、商业模式差异

传统IDC:被视为成本中心,客户关注的是如何在有限的空间内塞入更多的服务器。

新型AIDC:在AIDC时代,数据中心转变为价值创造的前沿。即,以GPU为代表的Token计算本身便可产生价值。用Token调用次数锚定产品价值,这在目前的文生文、文生视频等生成式AI产品中司空见惯。AIDC的规模和能力的提升也将直接与盈利能力形成正比关系。

新型AIDC市场增量十分巨大,我们或将迎接未来十年100万倍增长的加速计算时代。除此之外,数据也将被快速地被训练和推理,信息的传输将变得更加实时化和无线化。数据的处理需求将不由人本身发起。想象一下,一辆新能源智能汽车在电能即将耗尽时,自动寻找充电桩的动作会产生多少计算?而在未来,这种场景将会充斥在硬件和系统之中。

好文章,需要你的鼓励

CIO总结2025年人工智能实用化的十大关键启示

2025年人工智能在企业中实现突破性应用,从实验阶段转向实用阶段。八位代表性CIO分享核心经验:AI工具快速进化、需保持快节奏实验思维、重视工作流程而非组织架构、数据质量成为新挑战、采用前瞻性指标管理项目、无需等待完美时机、AI既是技术也是社会文化现象、需严格项目管理、变革重在人员而非技术、多智能体架构成未来趋势。

NVIDIA突破数学推理极限:7500万条超长推理链让AI数学能力飙升至100%满分

NVIDIA研究团队构建了迄今最大的数学推理数据集Nemotron-Math,包含7500万条推理轨迹,通过多模式推理和工具集成让AI在数学竞赛中达到100%满分。该研究还提出了创新的分桶训练策略,将超长文本训练效率提升2-3倍,为AI数学推理能力的突破和实际应用奠定了重要基础。

软银竭力筹措225亿美元资金支持OpenAI

日本科技投资巨头软银需要在年底前筹集225亿美元,以履行对AI合作伙伴OpenAI的资金承诺。软银是OpenAI价值5000亿美元Stargate数据中心计划的主要资助者之一。为筹集资金,软银CEO孙正义可能动用多种手段,包括利用其持有的英国芯片设计公司Arm股份作为抵押贷款。软银已清仓英伟达股份为该项目提供资金,目前可通过Arm股份借贷115亿美元,还持有价值110亿美元的T-Mobile股份及270亿美元现金储备。

清华大学研究团队颠覆传统:用最简单的方法让小AI模型在数学推理上大放异彩

清华大学研究团队提出JustRL方法,用单阶段训练和固定参数的简单强化学习配方训练15亿参数AI模型,在九个数学基准测试中达到54.9%和64.3%的平均准确率,性能匹配或超越复杂多阶段方法,同时计算资源减半。研究挑战了AI训练中的复杂化趋势,证明简单方法的有效性。