AI异构计算架构对比分析

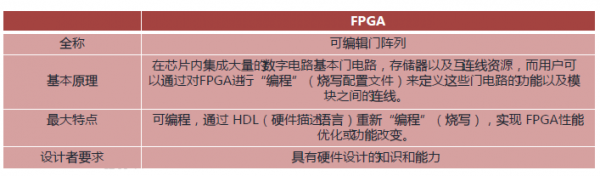

FPGA,即现场可编程门阵列,它是在PAL、GAL、CPLD等可编程器件的基础上进一步发展的产物。

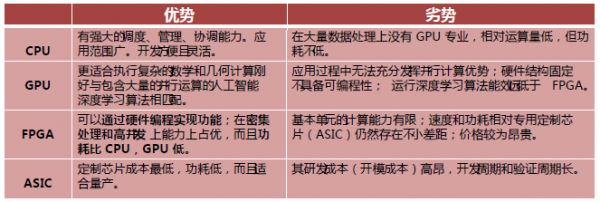

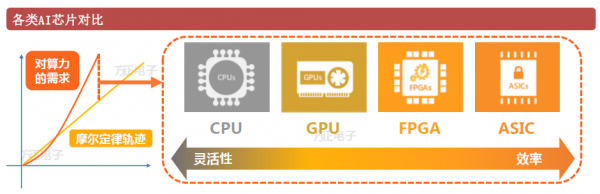

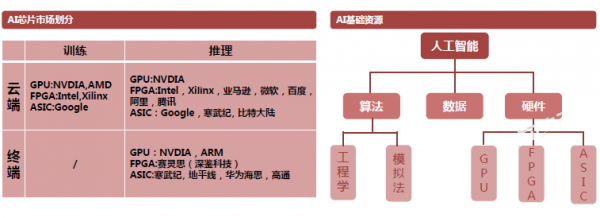

AI芯片主要分为CPU 、GPU、FPGA以及ASIC。其中以CPU、GPU、FPGA、ASIC的顺序,通用性逐渐减低,但运算效率逐步提高。

FPGA,即现场可编程门阵列,它是在PAL、GAL、CPLD等可编程器件的基础上进一步发展的产物。

为解决能耗限制,无法使处理器核心同时运作,及性能提升有限的问题,业界提出的另一个方案就是采用“定制计算”,也就是为特定的工作场景和负载优化硬件设计。FPGA(“现场可编程逻辑阵列”)应运而生。

FPGA本质是一种可编程的芯片。可以把硬件设计重复烧写在它的可编程存储器里,从而使FPGA芯片可以执行不同的硬件设计和功能。FPGA具备以下优势:

可编程灵活性高:FPGA属于半定制电路,理论上,如果FPGA提供的门电路规模足够大,通过编程可以实现任意ASIC和DSP的逻辑功能。

开发周期短:FPGA不需布线、掩模和定制流片等,芯片开发流程简化。传统的ASIC和SoC设计周期平均是14到24个月,用FPGA时间可以平均降低55%。

并行效率高:FPGA属于并行计算,一次可执行多个算法指令。虽然普遍主频较低,但对部分特殊的任务,大量相对低速并行的单元比起少量高效单元而言效率更高。

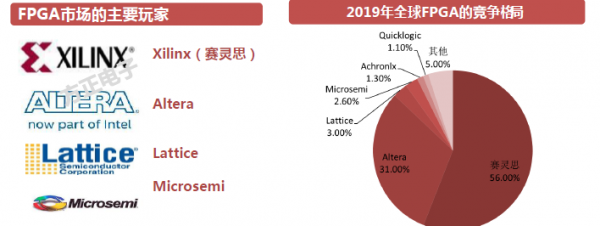

全球FPGA市场规模:17年67.5亿美元,预计2020年,CAGR为8.28%,预计2020年可达到84亿美元;全球FPGA竞争栺局:“两大两小”。

1.“两大”:赛灵思和Altera,主要布局5G以及AI,主打可编程逻辑器件,带有软件工具的可编程逻辑技术、知识产权(IP)和技术服务,合计占87%市场仹额;

2.“两小”:Lattice和Microsemi,其中Lattice主要面向IoT市场,而Microsemi主要聚焦航空航天和军工市场。

目前国外龙头工艺技术已达7nm、10nm级,可实现4-5亿门器件规模。5G无线,数据中心,汽车,无线通俆, AI智能,工业,消费电子,医疗科学等,正在成为全球FPGA市场规模增长的主要驱劢力。

作为加速应用的AI芯片,主要的技术路线有三种:GPU、FPGA、ASIC。目前GPU是市场上用亍AI计算最成熟应用最广泛的通用型芯片,在算法技术和应用层次处于发展期, GPU由于其强大的计算能力、较低的研发成本和通用性将继续占领AI芯片的主要市场份额。

未来在激先雷达、无人机、无人驾驶、智能机器人等织端设备方面对计算能力也会有极大的提升,因此作为人工智能的底层计算能力(芯片)存在着大机会。其中, FPGA是可重新编程的硅芯片,在信号处理和控制应用中,它已经取代了自定制与用集成电路( ASIC)和处理器。

AI包括训练和推断两个环节,训练过程是指在已有数据中学习,获得判断能力的过程。对神经网络而言,训练过程通过不断更新网络参数,使推断误差最小化;推断过程则是指对新的数据,使用训练过程形成的能力完成特定任务(比如分类、识别等)。推断是直接将数据输入神经网络并评估结果的正向计算。

训练:计算规模庞大,涉及到大量训练数据和复杂的深度神经网络,目前应用最多的主要还是GPU。

推断:包括大量的矩阵运算,但相比较训练环节计算量较少,不仅CPU或GPU可以进行运算,也可使用FPGA以及ASIC。

- 探索于服务器+FPGA芯片模式的企业包括阿里于、亚马逊、微软等。

- 在现阶段于端数据中心业务中,FPGA以其灵活性和可深度优化的特点,有望继GPU之后在该市场爆发。

- FPGA可以处理用户实时计算请求以及小计量大批次的计算。

- 未来人工智能应用场景对终端设备推断能力的要求高,FPGA是低功耗异构芯片,开发周期快,编程灵活,人工智能领域的解决方案目前正从软件演进到软件+芯片。

- 基亍CPU的传统计算架构无法充分满足人工智能高性能并行计算需求,需要FPGA等人工智能架构的专属芯片。

- 在目前的终端智能安防领域,也有厂商采用FPGA方案实现AI硬件加速

英特尔 Arria FPGA和Stratix系列应用广泛,如数据中心,军事,广播,汽车和其他织端市场。

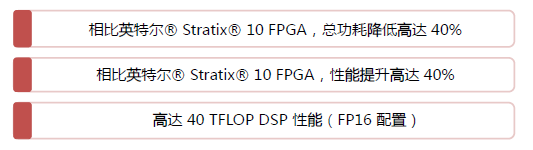

2019年4月3日,英特尔宣布推出全新产品家族英特尔Agilex FPGA。Agilex FPGA是第一款集成了Intel几乎所有当前创新技术的FPGA产品,包括10nm制造工艺、异构3D SiP封装、PCIe 5.0总线、DDR5/HBM/傲腾DC持久性内存、eASIC设备One API统一开収接口、CXL缓存和内存一致性高速亏连总线。

Agilex FPGA基于创新型异构 3D SiP 技术,将模拟、内存、自定义计算、自定义 I/O ,英特尔 eASIC和FPGA逻辑结构集成到一个芯片封装中。英特尔可提供从 FPGA 到结构化 ASIC的迁移路径。可为边缘计算、嵌入式、网络(5G/NFV)、数据中心带来发革的应用和灵活的硬件加速。

0赞

0赞好文章,需要你的鼓励

推荐文章

推荐文章

33年后,贝尔纳多·金特罗决定寻找改变他人生的那个人——创造马拉加病毒的匿名程序员。这个相对无害的病毒激发了金特罗对网络安全的热情,促使他创立了VirusTotal公司,该公司于2012年被谷歌收购。这次收购将谷歌的欧洲网络安全中心带到了马拉加,使这座西班牙城市转变为科技中心。通过深入研究病毒代码和媒体寻人,金特罗最终发现病毒创造者是已故的安东尼奥·恩里克·阿斯托尔加。

悉尼大学和微软研究院联合团队开发出名为Spatia的创新视频生成系统,通过维护3D点云"空间记忆"解决了AI视频生成中的长期一致性难题。该系统采用动静分离机制,将静态场景保存为持久记忆,同时生成动态内容,支持精确相机控制和交互式3D编辑,在多项基准测试中表现优异。

人工智能安全公司Cyata发现LangChain核心库存在严重漏洞"LangGrinch",CVE编号为2025-68664,CVSS评分达9.3分。该漏洞可导致攻击者窃取敏感机密信息,甚至可能升级为远程代码执行。LangChain核心库下载量约8.47亿次,是AI智能体生态系统的基础组件。漏洞源于序列化和反序列化注入问题,可通过提示注入触发。目前补丁已发布,建议立即更新至1.2.5或0.3.81版本。

马里兰大学研究团队开发ThinkARM框架,首次系统分析AI推理过程。通过将思维分解为八种模式,发现AI存在三阶段推理节律,推理型与传统AI思维模式差异显著。研究揭示探索模式与正确性关联,不同效率优化方法对思维结构影响各异。这为AI系统诊断、改进提供新工具。