微软发布Phi-4,最强小模型!参数极小、超GPT-4o

微软研究院发布了最强小参数模型——Phi-4。

Phi系列模型自今已经发布了5代,Phi-4也延续了之前的小参数模式只有140亿。

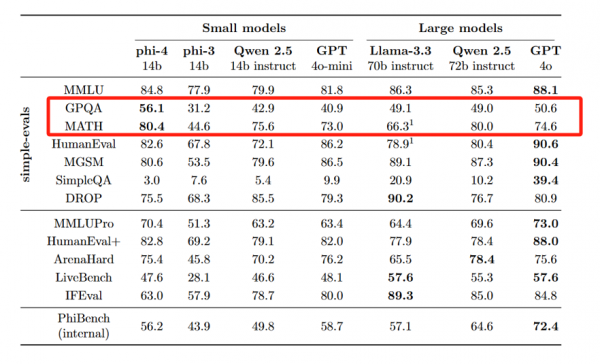

但在GPQA研究生水平、MATH数学基准中,分别达到了56.1和80.4超过了GPT-4o,同时也超过了同类型的开源模型Qwen 2.5 -14B和Llama-3.3-70B。

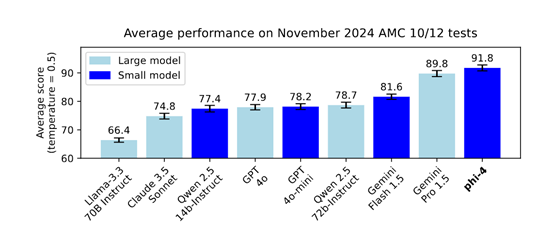

而在美国数学竞赛AMC的测试中,Phi-4达到了惊人的91.8分,再次超过了GeminiPro 1.5、GPT-4o、Claude 3.5 Sonnet、Qwen 2.5等知名开闭源模型,甚至整体性能可以与4050亿参数的Llama-3.1相媲美。

这也就是说,只要使用了高质量数据和创新训练方法,小参数模型同样可以战胜大参数,但在部署、应用和推理方面极大减少了对AI算力和环境的要求。

使用高质量合成数据

Phi-4能以如此小的参数获得巨大性能,使用高质量合成训练数据是关键环节之一。

传统的大模型通常依赖于从网络抓取或公开数据库获取的真实世界文本作为训练数据,这种方法虽然能够提供丰富的信息来源,但也容易受到噪声干扰和偏见影响。

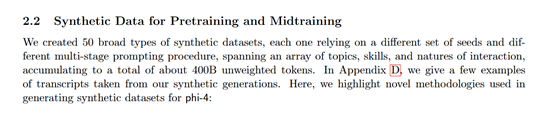

Phi-4则使用了种子策划、多Agent提示、自我修订工作流、重写和增强以及指令反转等多种合成方法,有效解决了传统无监督数据集的缺点。

种子策划是合成数据生成的起点。Phi-4从多个领域提取高质量的数据种子,为合成数据生成打下坚实基础,使得能够创建针对模型训练目标的练习、讨论和推理任务。

策划的种子包括从网页、书籍和代码库中提取的文段和代码片段,这些内容展示了高复杂性、深度推理和教育价值。为了确保质量,采用了两阶段过滤过程:首先是识别具有强教育潜力的页面,然后是将选定的页面分割成段落,对每个段落进行事实和推理内容的评分。

此外,多Agent提示允许不同智能体之间进行交互对话,从而创造出更加多样化且贴近真实应用场景的交流场景;而自我修订工作流则鼓励模型参与到自身的编辑过程中,以此提高输出内容的质量和一致性。

通过改变任务描述的方式,指令反转可以增加模型处理不同类型问题的能力,进一步增强了其灵活性和适应性。

总体上,一共生成了50 种不同类型的合成数据集,涵盖广泛的主题和技能,总计约 400B未加权的高质量token数据。

创新训练方法

为了确保phi-4能在广泛的任务类型上表现出色,研究人员使用了一系列针对性创新训练方法,并根据实际需求调整各类数据的比例。尤其是针对长上下文理解能力的需求,phi-4增加了rope位置编码的基础频率至25万次,并相应地降低了最大学习率,以更好地适应更长的文本序列。

这种做法有效提升了模型对于复杂结构化信息的理解力,使其在面对需要综合分析多个段落甚至整篇文章的问题时也能游刃有余。phi-4还特别注重了不同类型数据之间的平衡,避免某类数据过多导致其他方面性能下降的情况发生。

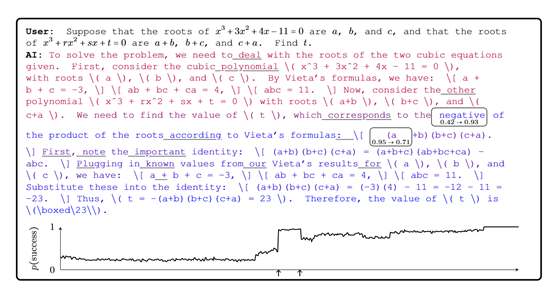

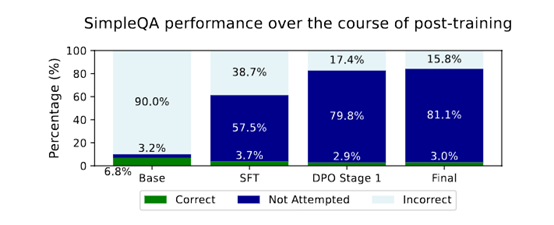

而在 phi-4 的后训练过程中,研究团队采用了两种形式的 DPO 数据对模型进行了强化训练。第一种是基于人工标注的 SFT数据,即由专家精心挑选并标记好的问答对;

第二种则是自动构建的 DPO 对,这种方法通过搜索重要的转折点,将原始对话片段拆分成多个选项,并让模型从中选择最优解。通过结合这两种方式,phi-4 不仅学会了如何产生更符合预期的回答,还能够在不同情境下灵活调整语气和风格,从而提供更加个性化的交互体验。

此外,phi-4还引入了一些创新性的后训练方法,以增强其在特定领域内的表现。例如,在 STEM领域问题解答方面,phi-4 利用了一个名为Math-Shepherd 的工具来进行验证和强化学习。Math-Shepherd 可以自动检查模型生成的答案是否正确,并且在必要时提供额外指导,帮助模型逐步掌握正确的解题思路。

这种方法有效地解决了传统无监督数据集中常见的逻辑不严密等问题,使得 phi-4 在数学竞赛类题目上的准确率达到了惊人的80.4%,远超其他同类产品。

此外,针对编程代码评估任务,Phi-4 也采取了类似的方法,通过对大量开源项目中的代码片段进行分析和总结,提升了其在该领域的执行效率和准确性。

值得一提的是,微软AI副总裁、phi系列模型的灵魂人物之一Sébastien Bubeck已经离开了微软加入了OpenAI。

好文章,需要你的鼓励

KAIST团队重磅发现:AI绘图背后的“偏见密码“

KAIST研究团队首次系统性研究了新一代AI绘图工具中的社会偏见问题,发现使用大型视觉语言模型的智能绘图工具比传统工具产生更严重的性别、年龄和种族偏见。研究确定了系统提示词是偏见的主要来源,并开发出FAIRPRO解决方案,通过让AI进行自我审查来生成更公平的绘图指南,成功减少了偏见同时保持了图像质量。

Empromptu获200万美元融资,助力企业构建AI应用

前CodeSee创始人Sheena Leven与AI研究员Sean Robinson联合创立Empromptu,为企业提供AI应用构建服务。该平台允许非技术背景的用户通过与AI聊天机器人对话来构建HTML或JavaScript应用。平台还提供LLM工具供用户微调结果,并支持为现有代码库添加AI功能。公司已获得由Precursor Ventures领投的200万美元种子前融资,资金将用于招聘和技术开发。

康奈尔大学让普通物体投影变身艺术杰作:ShadowDraw让影子和线条画完美融合

康奈尔大学开发的ShadowDraw系统能将任意三维物体转化为影子画艺术作品。该系统通过智能优化光照和物体摆放参数,寻找最佳影子效果,然后生成与影子完美配合的线条画。实验表明该技术在多种物体上都能创造出引人入胜的艺术作品,且可轻松在现实环境中部署,为计算艺术和创意表达开辟了新领域。