国产开源之光:DeepSeek-V3划重点

DeepSeek-V3 采用了 671B 参数 MoE 架构,配备约 37B 激活单元,训练使用14.8T Token数据。

一路走来,从一个低调、但能引起行业普遍降价的选手,到现在的国产+开源之光引发全球瞩目。最近刚刚其最新的DeepSeek-V3发布后,海内外一片刷屏。本篇就划几处重点:

一句话介绍:DeepSeek-V3 采用了 671B 参数 MoE 架构,配备约 37B 激活单元,训练使用14.8T Token数据。

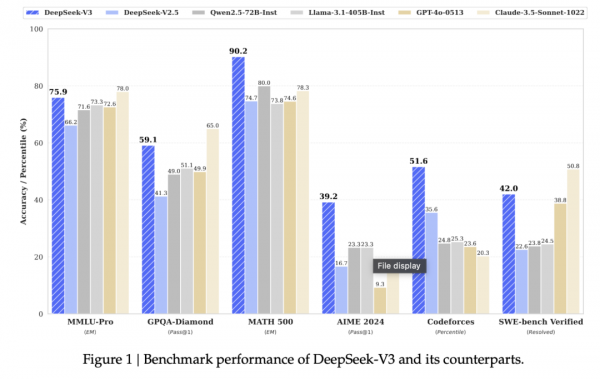

数学能力 / MATH 500、AIME 2024 等测试:显著优于 Claude 3.5 Sonnet 和 GPT-4o;

代码能力 / Codeforces: 同样优于其他主流大模型,刷新了SOTA。

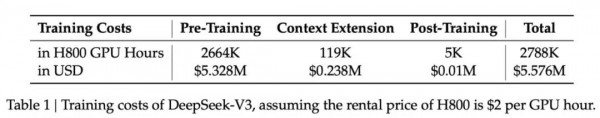

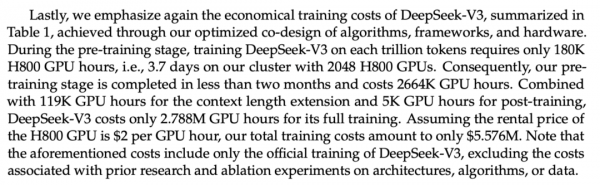

3、极佳训练成本优势:总计消耗了 278.8 万 GPU 小时。按照 NVIDIA H800 每小时 2 美元的租赁价格计算,训练成本约为 560 万美元。(相比之下,Llama 3模型的计算消耗了3930万H100小时...)

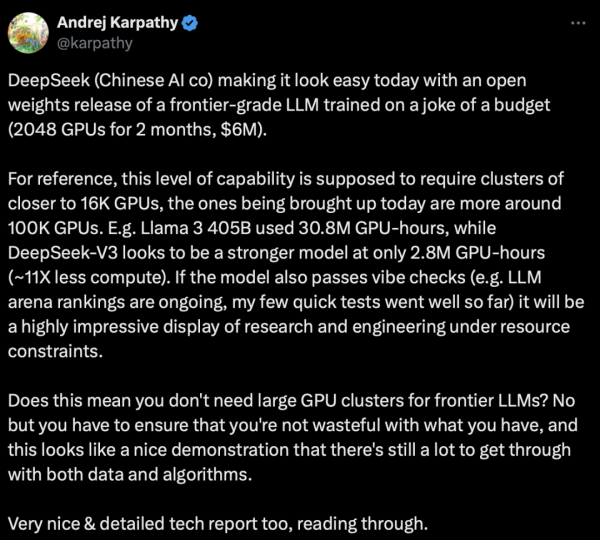

低训练成本可能是本次DeepSeek-V3在海外产生的最大反响的一点:

DeepSeek-V3的训练仅使用了2048张H800 (然而,H800 的互连带宽较低:300 GB/s,对比 H100 的 900 GB/s,这在训练过程中可能成为性能瓶颈,因为节点间的通信效率会受到影响,为此DeepSeek提出了多种优化方案,例如自主研发通信内核而非依赖张量并行,以及采用混合精度(FP8)训练等技术来提升效率。)

(搬运官方信息)通过算法和工程上的创新,DeepSeek-V3 的生成吐字速度从 20 TPS 大幅提高至 60 TPS,相比 V2.5 模型实现了 3 倍的提升,为用户带来更加迅速流畅的使用体验。

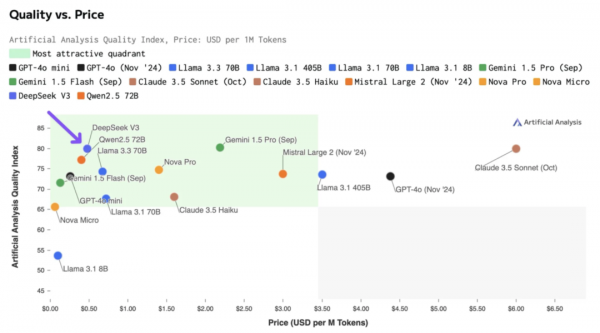

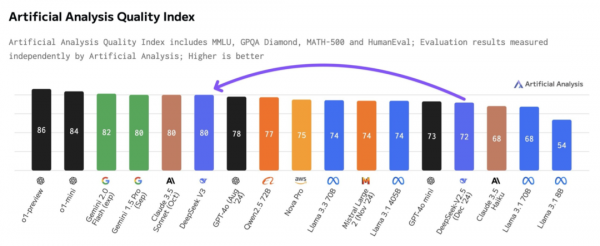

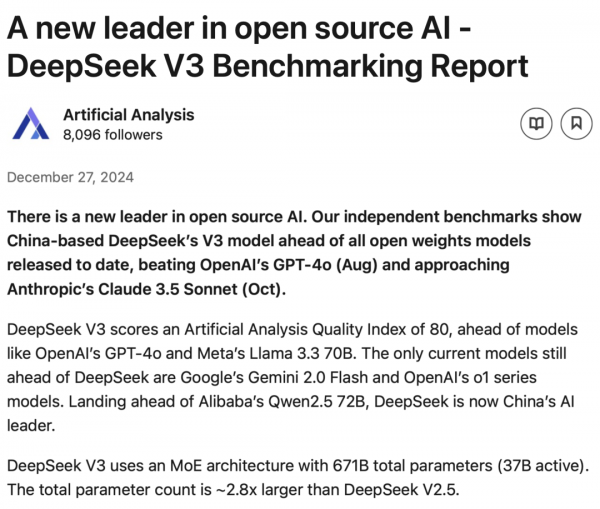

最后,根据Artifical Analysis的独立测评报告“A new leader in open source AI”:

DeepSeek-V3在其Quality Index榜单上超过GPT-4o,仅次于o1和Gemini 2.0 Flash,与Claude 3.5 Sonnet持平。

在此前DeepSeek-V2的文章中曾经提到过其核心技术创新MLA(可见开源模型社区又一位重量级选手掀桌子),这些技术在V2得到验证后,现在也成为了V3的技术核心。此外互联网上,包括大神Andrej Karpathy也给予了极高评价:

应该表示祝贺!Congratulations to DeepSeek,也祝那些真正走在星辰大海路上的选手创造更多佳绩!

0赞

0赞好文章,需要你的鼓励

推荐文章

推荐文章

新加坡人工智能机构与阿里云发布全新大语言模型Qwen-Sea-Lion-v4,专门针对东南亚语言和文化特色进行优化。该模型结合阿里云Qwen3-32B基础模型和大量东南亚地区数据集,在东南亚语言模型评估榜单中位居开源模型首位。模型支持119种语言,能在32GB内存的消费级笔记本上运行,采用字节对编码技术更好处理非拉丁文字,并具备3.2万词元上下文长度,可执行文档级推理和摘要任务。

中科大联合快手等机构推出VR-Thinker技术,首次实现AI视频评判员的"边看边想"能力。该系统通过主动选择关键画面、智能记忆管理和三阶段训练,在视频质量评估准确率上达到75%-82%,特别擅长处理长视频场景,为AI视频生成的质量控制提供了突破性解决方案。

AI智能体是下一代业务自动化工具,不仅能对话交流,还能执行复杂任务。与ChatGPT聊天机器人不同,它们可在最少人工干预下规划并完成工作。文章介绍了五个高影响力应用:自动化客户服务解决方案、销售CRM管理、合规自动化、招聘筛选与排程、市场情报报告。这些应用都具有重复性工作流程、依赖结构化数据、遵循可预测规则等特点,能够释放员工宝贵时间用于更有价值的工作。

微软研究院发布BitDistill技术,通过三阶段优化将大型语言模型压缩至1.58位精度,在保持性能的同时实现10倍内存节省和2.65倍速度提升。该技术包括模型结构稳定化、持续预训练适应和知识蒸馏传承三个关键步骤,解决了模型量化中的性能衰减和规模化问题,为AI模型在资源受限设备上的高效部署提供了新方案。